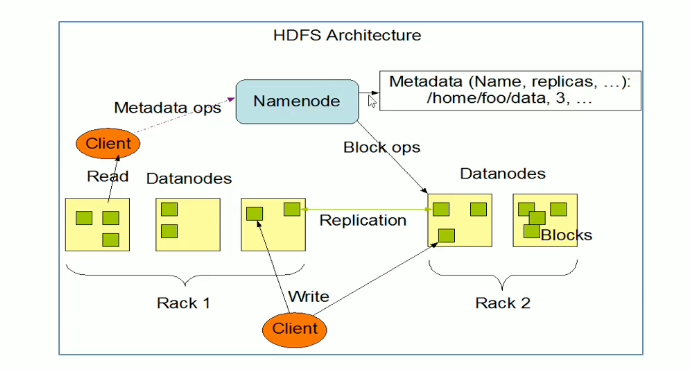

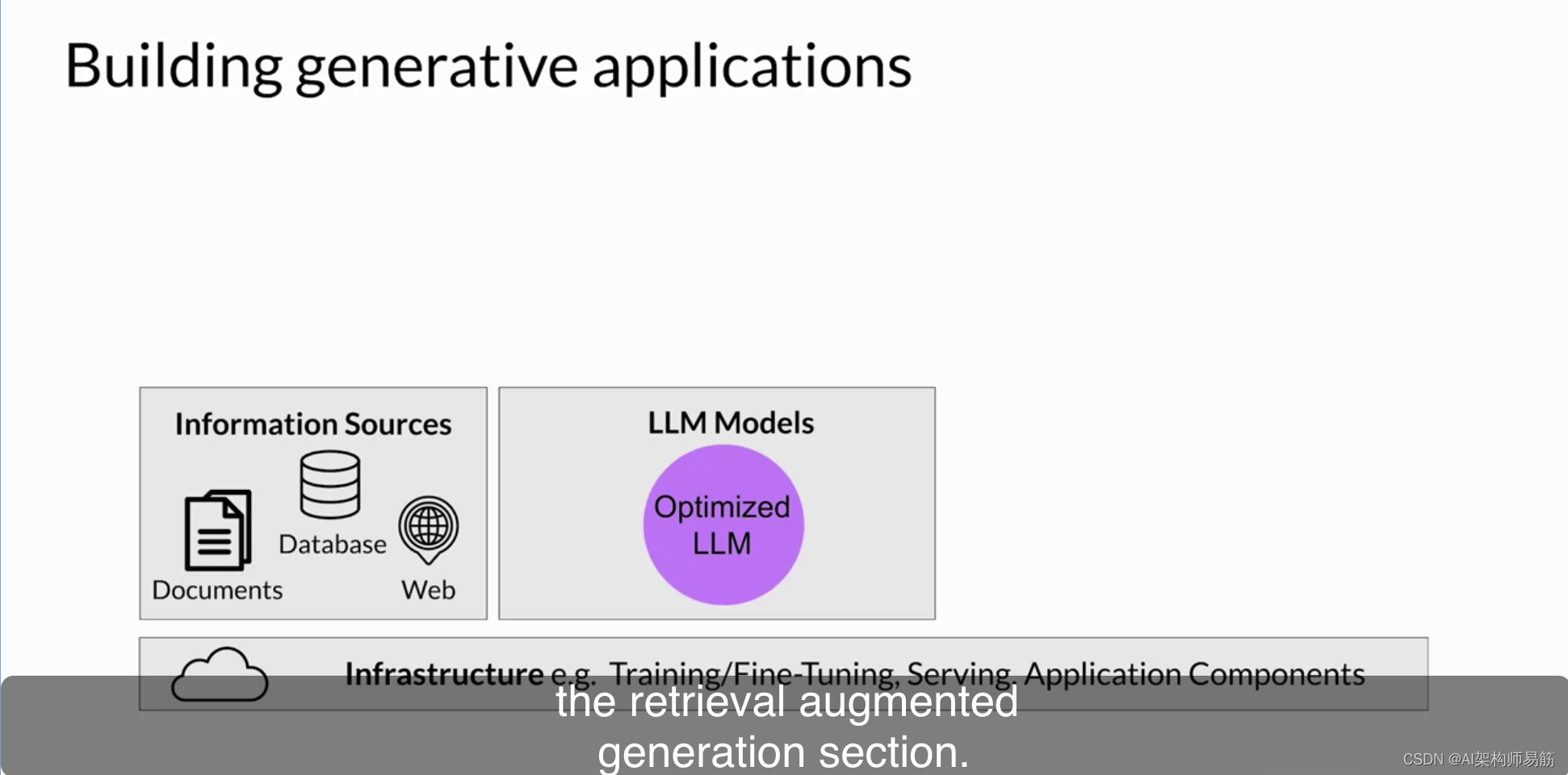

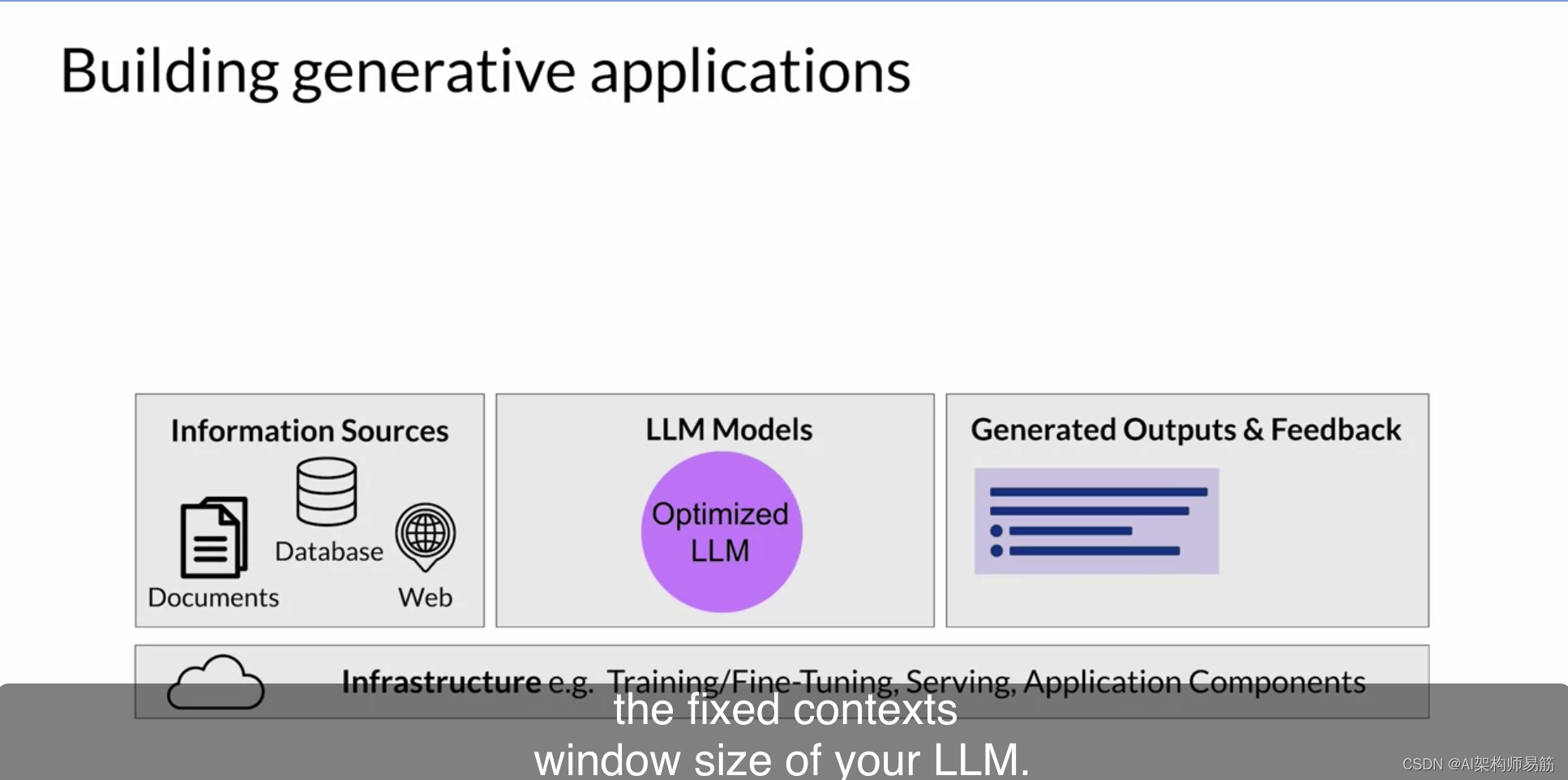

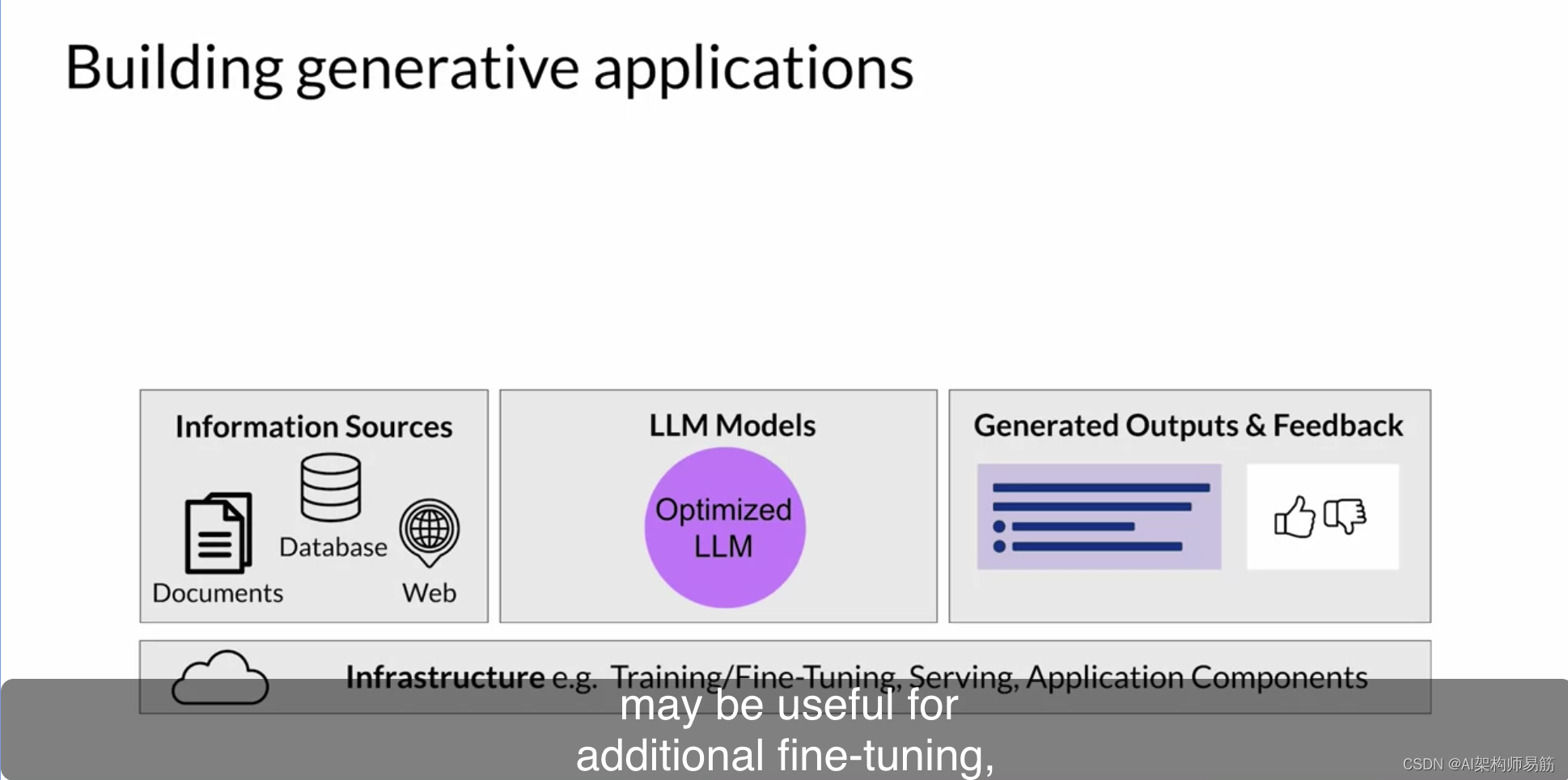

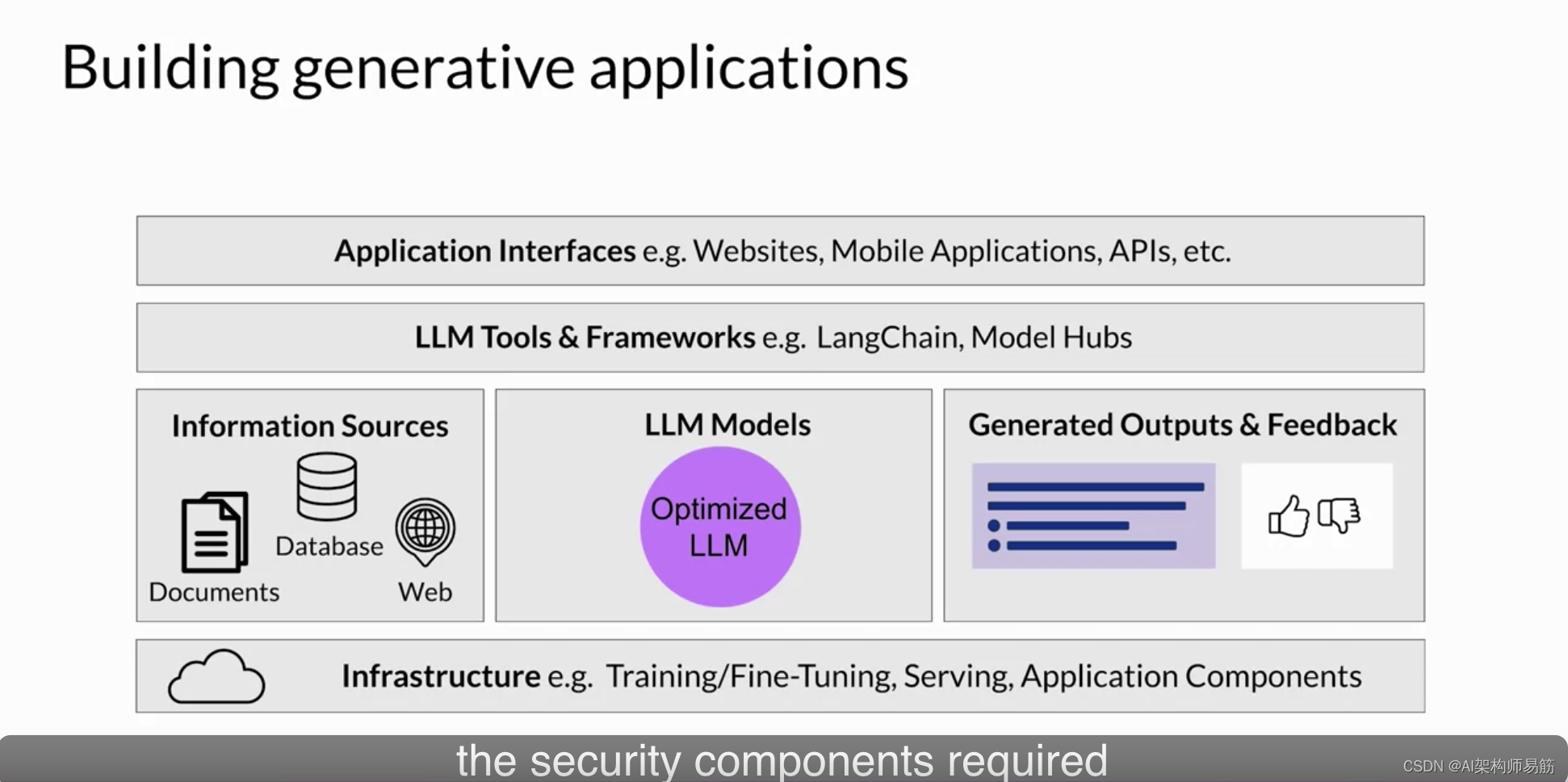

在本课程的最后一部分,您将探讨构建基于LLM的应用程序的一些额外考虑因素。首先,让我们把迄今为止在本课程中所见的一切汇总起来,看看创建LLM驱动应用程序的基本组成部分。您需要几个关键组件来创建端到端的应用程序解决方案,从基础设施层开始。该层提供了计算、存储和网络,以提供LLMs,并托管应用程序组件。您可以利用您的本地基础设施,或者通过按需和按使用量计费的云服务提供此基础设施。

接下来,您将包括您希望在应用程序中使用的大型语言模型。这些可能包括基础模型,以及您根据特定任务进行了自定义的模型。这些模型部署在适合您推理需求的基础设施上。考虑到您是否需要与模型进行实时或准实时交互。

您还可能需要从外部来源检索信息,例如在检索增强生成部分讨论的那些。

您的应用程序将从大型语言模型返回完成内容给用户或消费应用程序。根据您的用例,您可能需要实现一种机制来捕获和存储输出。例如,您可以构建在会话期间存储用户完成内容以增加LLM的固定上下文窗口大小的容量。

您还可以从用户那里收集反馈,这可能对进一步的微调、调整或评估在应用程序成熟时很有用。

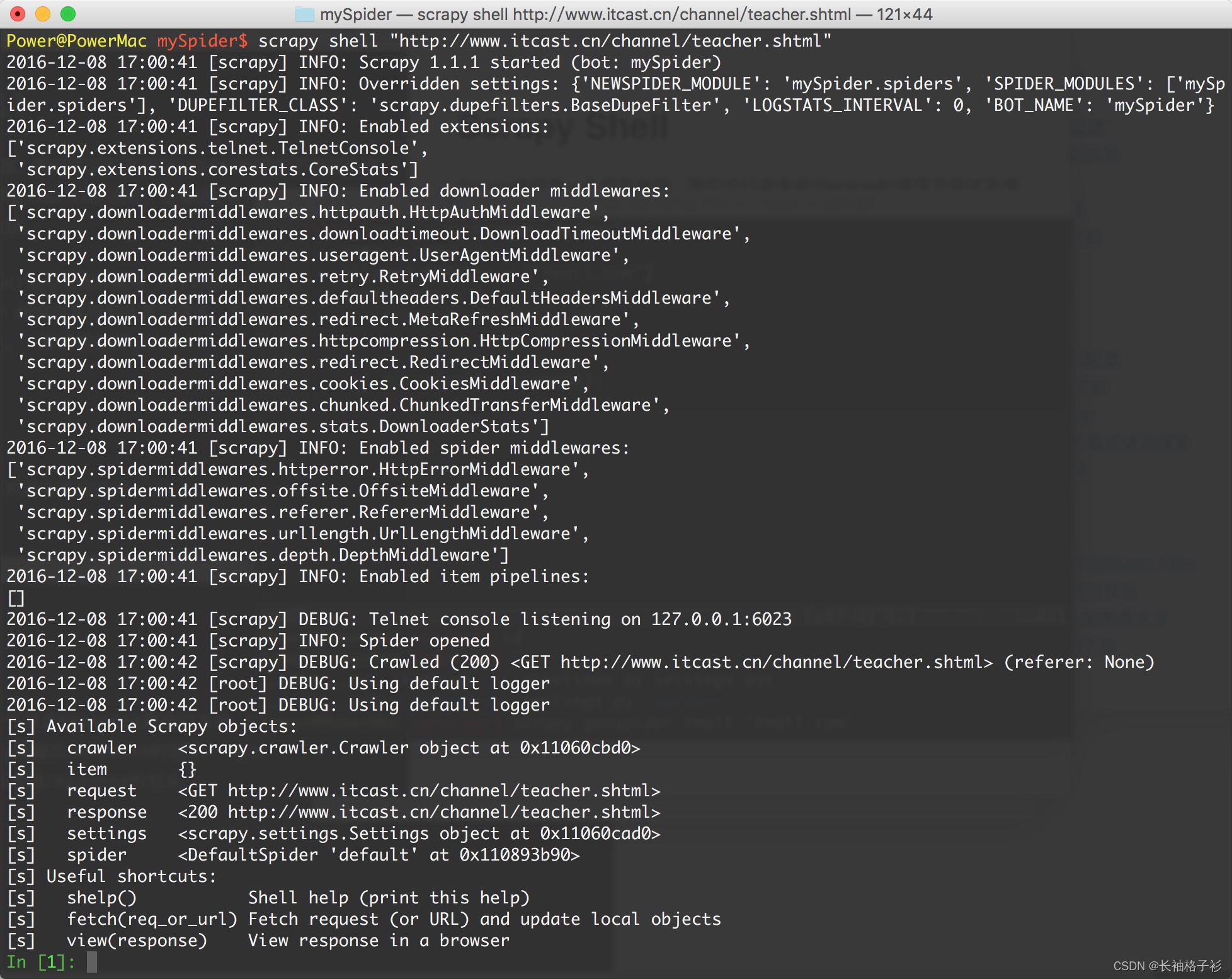

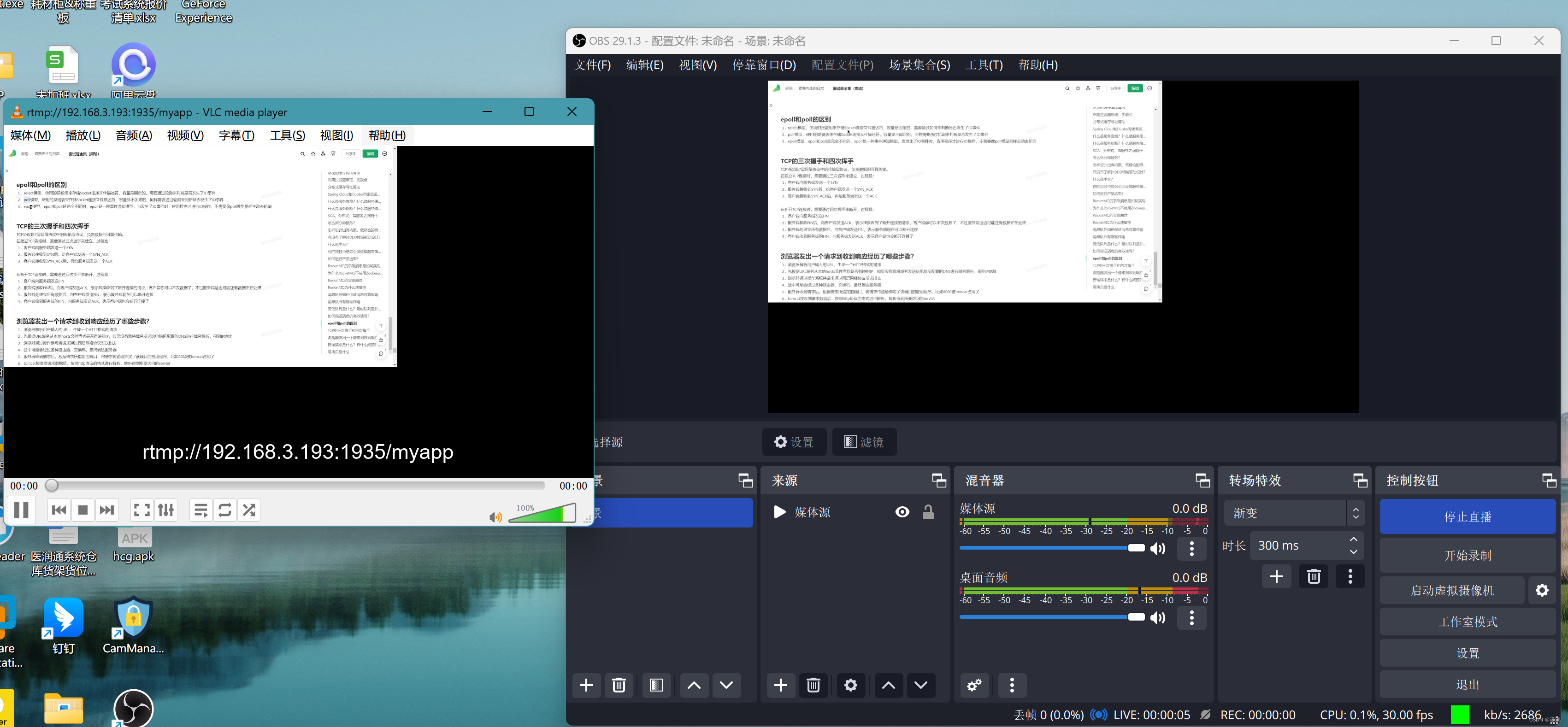

接下来,您可能需要使用大型语言模型的其他工具和框架,以帮助您轻松实施本课程中讨论的某些技术。例如,您可以使用Len Chains内置库来实施PowReact或思维链提示等技术。您还可以利用模型中心来集中管理和共享模型,以供应用程序使用。

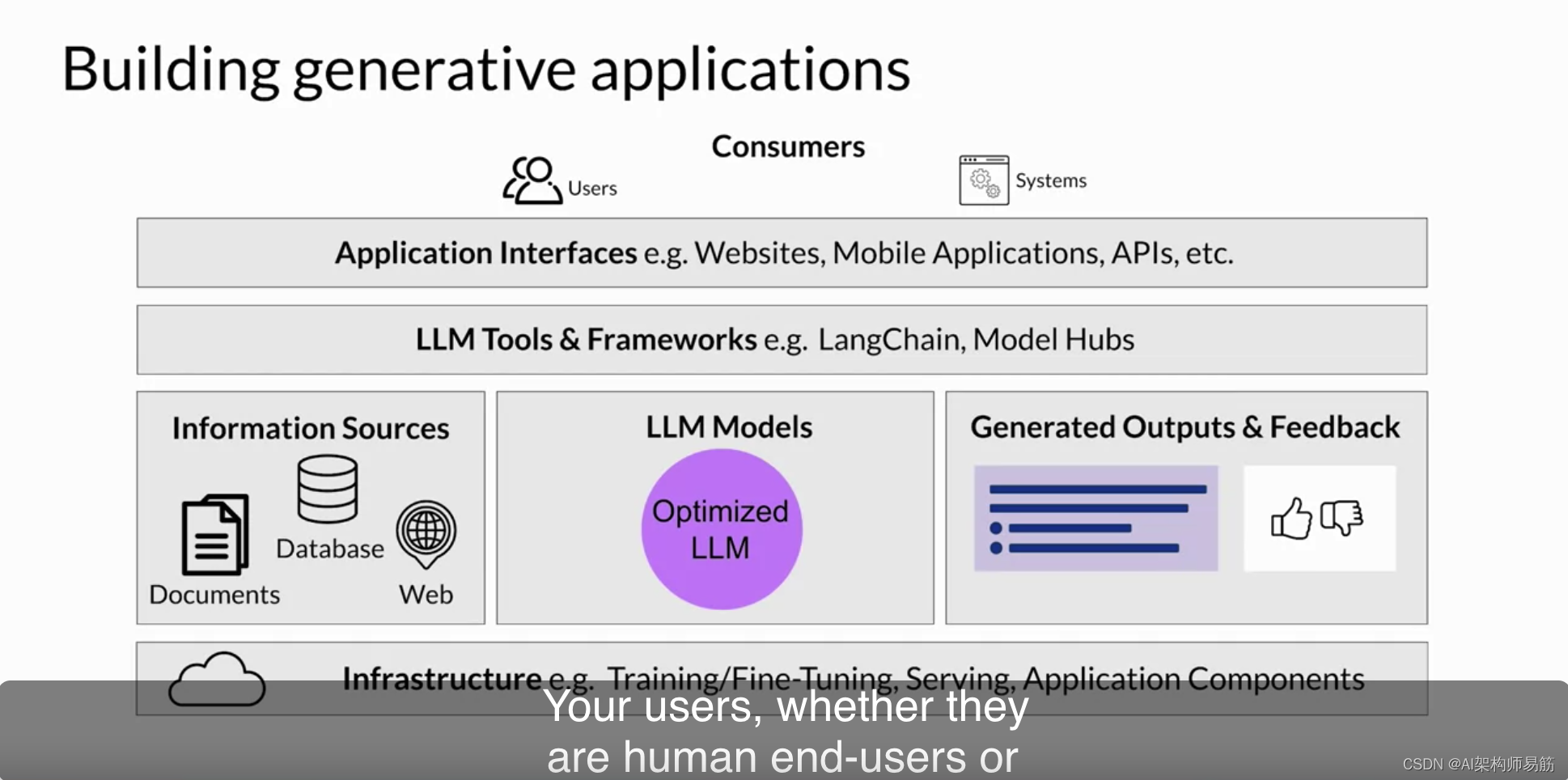

在最后一层,通常会有某种用户界面,应用程序将通过该界面进行访问,例如网站或REST API。这一层还包括与应用程序交互所需的安全组件。

从高层次来看,这个架构堆栈代表了构建生成式AI应用程序的各种组成部分。无论是人类最终用户还是通过其API访问您的应用程序的其他系统,您的用户都将与整个堆栈进行交互。正如您所看到的,模型通常只是构建端到端生成式AI应用程序的一部分。

恭喜您完成了完整的生成式AI项目生命周期。希望您感到已经形成了一些关于在构建LLM应用程序时需要考虑的重要问题的直觉。

- 本周,您了解了如何通过使用一种名为“强化学习与人类反馈”的技术,或简称RLHF,微调模型,以使其与人类偏好(如帮助、无害和诚实)保持一致。

- 鉴于RLHF的流行,存在许多现有的RL奖励模型和人类对齐数据集,使您能够快速开始对模型进行对齐。在实践中,RLHF是一种非常有效的机制,可用于改善模型的对齐性,降低其响应的毒性,并让您更安全地将模型用于生产。

- 您还学会了通过压缩、量化或修剪模型来优化模型以用于推理的重要技术。这可以减小为在生产环境中提供LLMs所需的硬件资源的数量。

- 最后,您还探讨了通过结构化提示和与外部数据源和应用程序的连接来帮助模型在部署中表现更好的方法。

LLMs可以在应用程序中充当理性引擎的精彩角色,充分利用它们的智能来支持令人兴奋和实用的应用程序。像Lang Chain这样的框架正在使快速构建、部署和测试LLM驱动的应用程序成为可能,对于开发人员来说是一个非常令人兴奋的时刻。

在TEA的课程结尾,我们将探讨一些正在积极研究的领域,这些领域可能会在未来几个月和年份中塑造该领域的发展轨迹。

Reference

https://www.coursera.org/learn/generative-ai-with-llms/lecture/LLhcT/llm-application-architectures