前言

本文是该专栏的第31篇,后面会持续分享python的各种干货知识,值得关注。

在工作上,尤其是在处理爬虫项目中,会遇到这样的需求。访问某个网页或者在采集某个页面的时候,正文部分含有docx,或pdf,或xls,或doc,或wps等链接。需要你使用python自动将页面上含有的这些信息链接下载并保存到指定文件夹。

遇到这种情况需要怎么做呢?别担心,跟着笔者直接往下看正文的详细解决方法。(附完整代码)

正文

1. doc下载

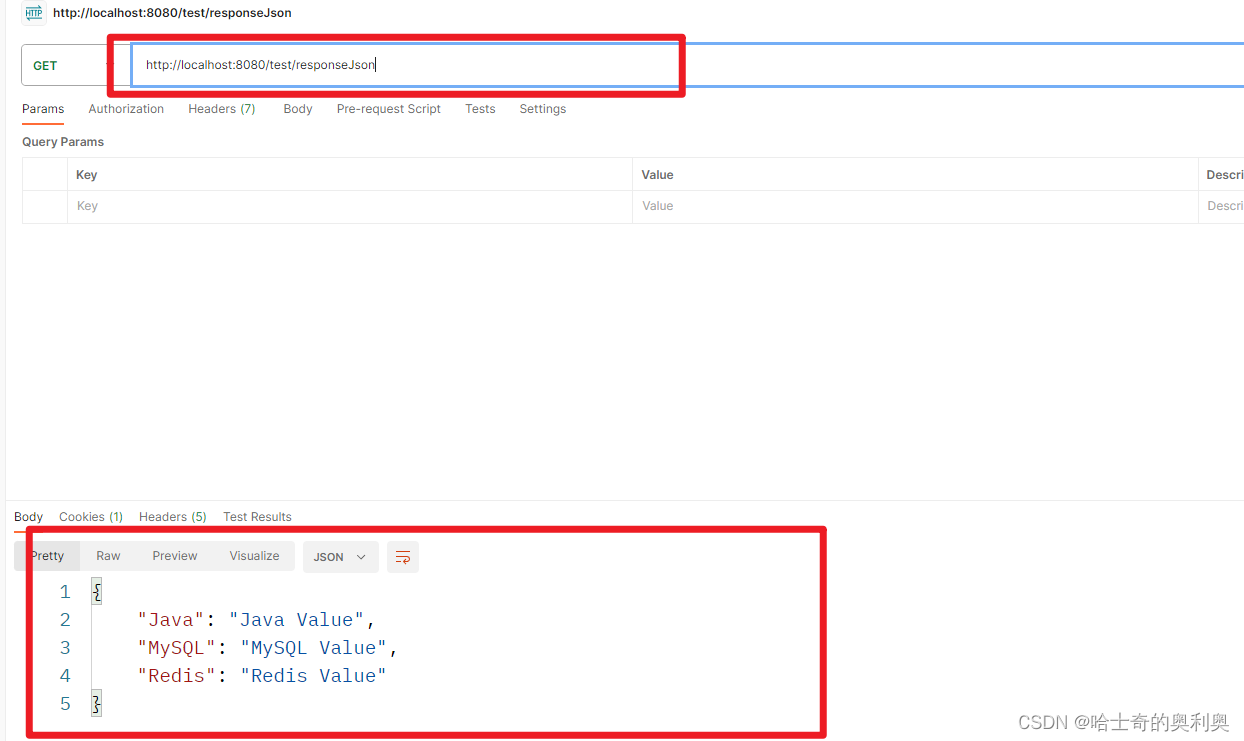

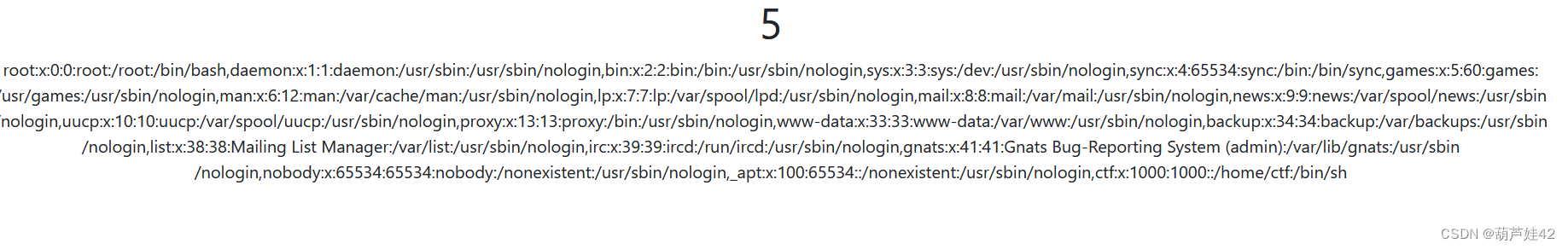

在有些网页的正文中,有时会有如下图中的doc链接。比如爬虫在采集正文数据的时候,像标题,正文内容,作者,发布时间等等信息都可以直接通过数据解析抓取并保存到本地。而下图中的doc一般在网页中,我们只需要通过鼠标点击就可自动下载并保存到本地目录文件里。而通过程序代码要怎样让它自动下载并保存到本地呢。实现方法如下:

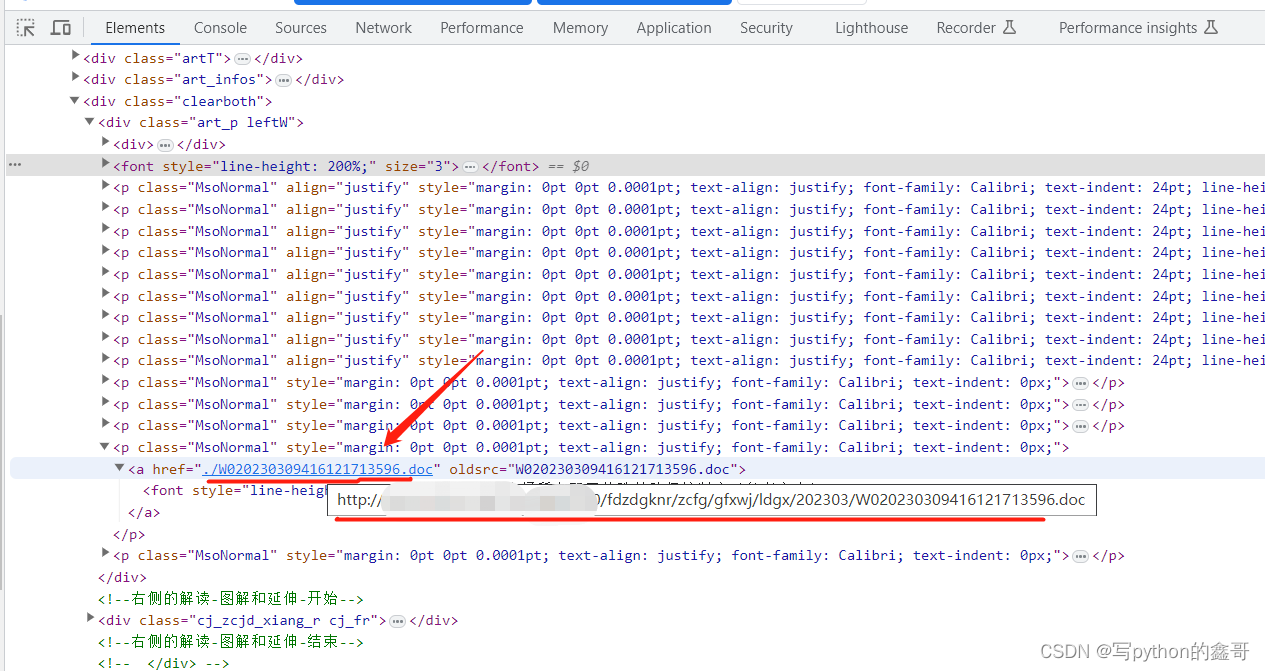

以上图中的doc为例,我们可以通过xpath或者正则,bs4等解析方法将其doc链接地址提取出来,然后使用如下方法保存到本地即可: