1 迁移学习概述

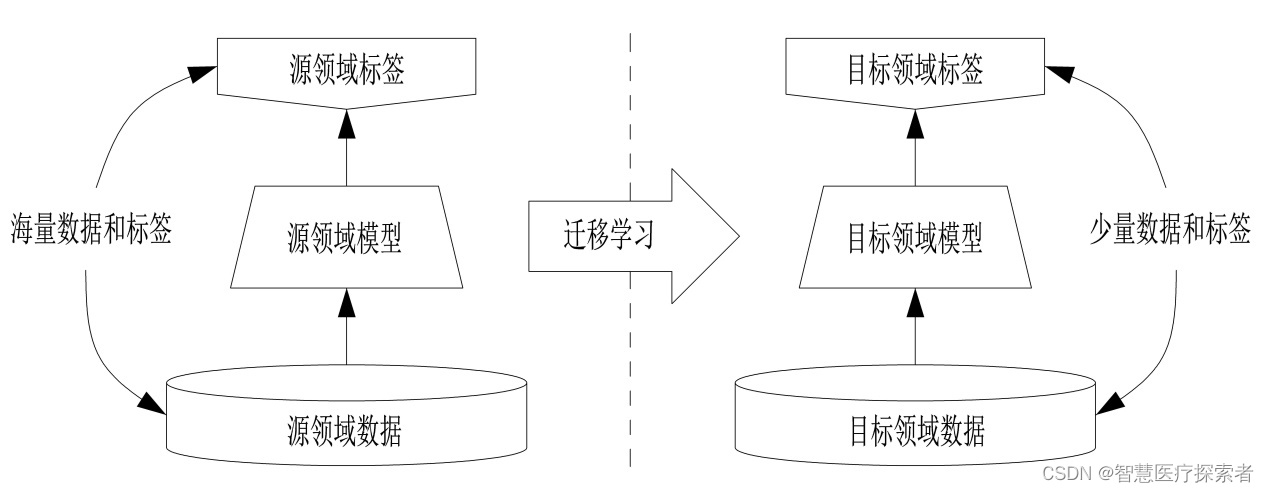

迁移学习(Transfer Learning)是机器学习中的一种方法,它允许模型将从一个任务中学到的知识应用到另一个相关的任务中。这种方法在数据稀缺的情况下尤为有用,因为它减少了对大量标记数据的需求。迁移学习已成为深度学习和人工智能领域的一个热门话题。

1.1 迁移学习的基本原理

迁移学习的核心思想是:在一个任务上训练得到的模型包含的知识可以部分或全部地转移到另一个任务上。这通常涉及以下两个主要步骤:

-

源任务学习: 在源任务上训练模型,这个任务通常有大量的数据可用。

-

知识迁移: 将从源任务学到的知识(如网络参数、特征表示等)应用到目标任务上。

1.2 迁移学习的类型

-

基于模型的迁移学习: 直接使用源任务的预训练模型作为目标任务的起点。

-

基于特征的迁移学习: 从源任务中提取特征表示,然后在这些特征上训练目标任务的模型。

-

基于关系的迁移学习: 从源任务中学习数据间的关系,然后将这种关系应用到目标任务中。

2 迁移学习的典型算法

迁移学习是一种在机器学习领域中越来越流行的方法,旨在利用在一个任务上学到的知识来提高在另一个相关任务上的学习效果。以下是一些迁移学习领域中的典型算法和方法:

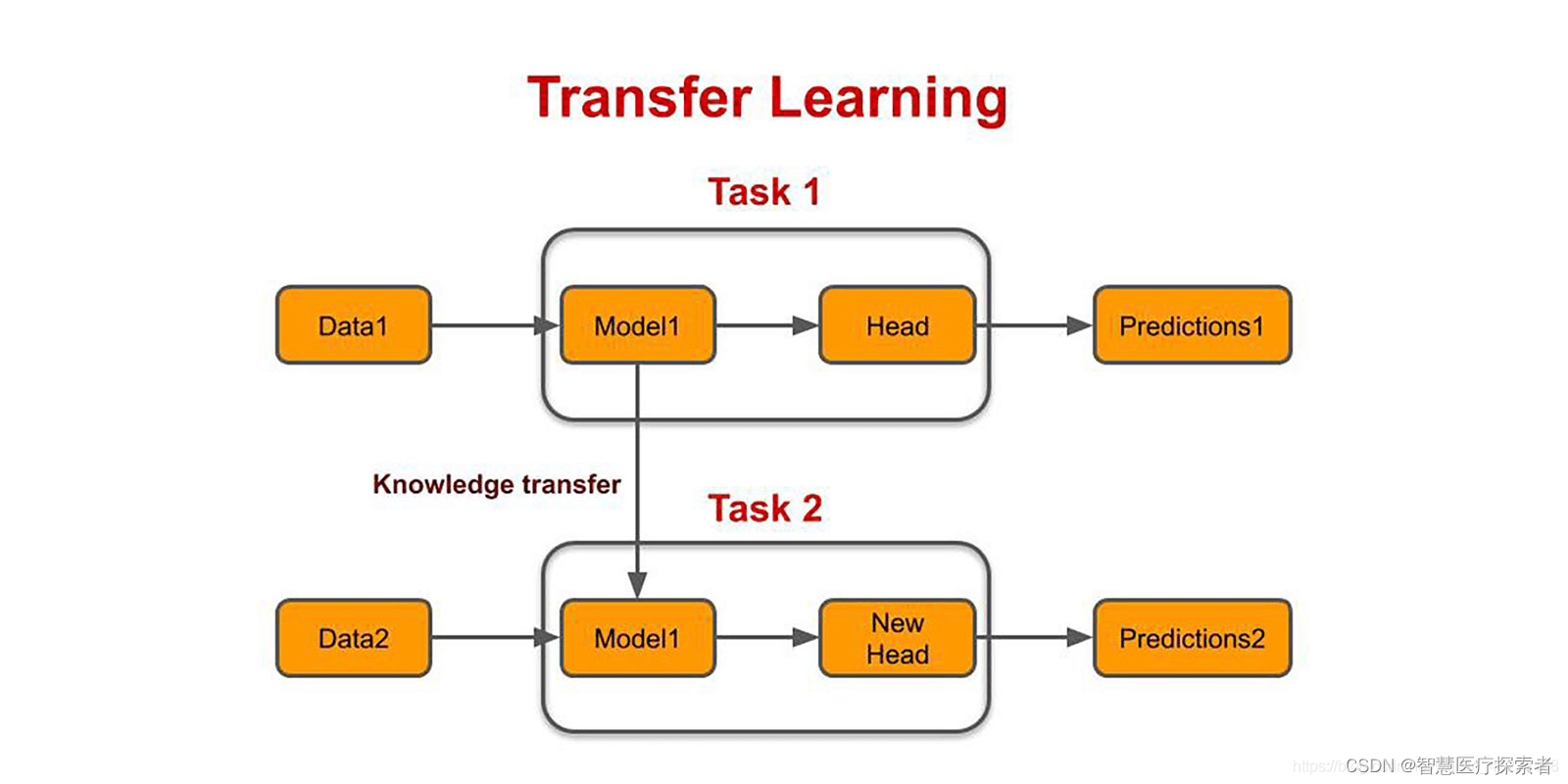

2.1 微调(Fine-tuning)

-

基本概念: 微调是一种常见的迁移学习策略,涉及对预训练模型的最后几层进行重新训练以适应新任务。

-

典型应用: 在深度学习中,比如使用在大型数据集(如ImageNet)上预训练的卷积神经网络(CNN)模型,然后对其进行微调以适应特定的图像分类任务。

2.2 特征提取(Feature Extraction)

-

基本概念: 特征提取涉及使用预训练模型的一部分(通常是除了最后的分类层之外的所有层)来作为新任务的特征提取器。

-

典型应用: 在图像处理或自然语言处理任务中,提取通用特征后,可以在这些特征的基础上训练一个新的分类器或回归器。

2.3 多任务学习(Multi-task Learning)

-

基本概念: 在多任务学习中,模型被同时训练以执行多个相关任务,目的是通过这种联合学习提高所有任务的性能。

-

典型应用: 在自然语言处理中,一个模型可能同时学习语言模型任务、文本分类任务和命名实体识别任务。

2.4 域自适应(Domain Adaptation)

-

基本概念: 域自适应关注于调整模型以便在源域学到的知识能适用于与之分布不同的目标域。

-

典型应用: 将在一个领域(如在线评论)训练的情感分析模型调整到另一个领域(如微博)。

2.5 零样本学习(Zero-shot Learning)

-

基本概念: 零样本学习是指训练模型以识别在训练过程中未出现过的类别。

-

典型应用: 在图像识别任务中,模型可以识别它在训练集中从未见过的物体类别。

2.6 对抗性训练(Adversarial Training)

-

基本概念: 利用对抗性网络来训练模型,使其在源域和目标域上都有良好的表现。

-

典型应用: 用于图像风格转换或在不同数据集上的图像分类。

2.7 学习表示迁移(Representation Transfer)

-

基本概念: 侧重于将从源任务中学到的表示(如权重、特征图等)迁移到目标任务。

-

典型应用: 在深度学习模型中迁移学习不同层的权重。

2.8 元学习(Meta-learning)

-

基本概念: 也被称为“学会学习”,元学习旨在通过学习多种任务来发展快速适应新任务的能力。

-

典型应用: 快速适应新的分类任务,如小样本图像识别。

3 迁移学习的优势和挑战

3.1 优势

-

数据效率: 减少了对大量标记数据的需求,特别是在目标任务的数据稀缺时。

-

提高性能: 预训练模型可以提高模型在特定任务上的性能。

-

节省时间: 减少了从头开始训练模型的时间。

3.2 挑战

-

负迁移: 如果源任务和目标任务不够相关,迁移学习可能导致性能下降。

-

领域适应: 需要有效的方法来处理源任务和目标任务之间的领域差异。

-

模型选择: 如何选择合适的源任务和模型结构仍然是一个开放的问题。

4 迁移学习的应用与未来

4.1 应用

迁移学习作为一种强大的机器学习策略,通过利用在一个任务上获得的知识来加速和改进另一个任务的学习过程,为处理数据稀缺、提升模型性能、加速研发进程等问题提供了有效解决方案。已被广泛应用于多个领域,提高了学习效率,减少了对大量标注数据的依赖。以下是迁移学习的一些主要应用领域:

-

计算机视觉

图像分类: 使用在大规模数据集(如ImageNet)上预训练的模型来提高小型数据集上的图像分类性能。

物体检测: 迁移学习用于训练能够在不同背景下识别特定物体的模型。

图像分割: 在复杂的图像分割任务中,迁移学习能提高模型对新环境的适应性。

-

自然语言处理(NLP)

情感分析: 将在大型文本数据集上训练的模型应用于特定领域的情感分析任务。

机器翻译: 使用迁移学习在有限的平行语料上提高翻译质量。

文本分类: 在预训练的语言模型上进行微调,用于特定类型文本的分类。

-

医学影像分析

疾病诊断: 利用迁移学习提高在医学图像(如X射线、MRI)上的疾病诊断准确率。

影像分割: 应用于识别和分割医学影像中的特定结构或区域。

-

语音识别

语音到文本: 在不同语言或口音的语音识别任务中应用迁移学习。

语音助手: 提高语音助手在不同环境下的理解和响应能力。

-

强化学习

游戏玩法: 在一种游戏中训练的模型迁移到另一种类似游戏的学习中。

仿真到现实: 将在仿真环境中训练的模型迁移到现实世界应用。

4.2 未来方向

迁移学习作为一种高效的机器学习方法,在近年来已经取得了显著的进展。迁移学习的未来发展方向将集中在提高其泛化能力、自适应性、无监督学习能力,以及与元学习、其他学习范式的结合上。随着技术的不断发展,它的未来方向可能包括以下几个关键领域:

-

更好的泛化能力

任务和领域泛化: 迁移学习将致力于更好地泛化到各种任务和领域,这意味着在一个领域学到的知识可以更有效地应用到其他领域。

跨模态学习: 开发能够跨越不同数据模态(如文本、图像、声音)的迁移学习模型。

-

自适应迁移学习

动态迁移: 未来的迁移学习方法可能会更加动态和自适应,能够根据目标任务的特定需求自动调整迁移策略。

环境感知: 模型能够意识到环境变化并相应地调整迁移策略。

-

无监督和半监督迁移学习

减少标注数据依赖: 无监督和半监督的迁移学习方法将减少对大量标注数据的依赖,使得模型能在少量或无标签数据的情况下进行有效学习。

利用未标记数据: 开发新的算法来更有效地利用未标记数据。

-

元学习(Meta-Learning)

“学会学习”: 元学习,或学会学习的方法,将成为迁移学习的一个重要方向。这种方法使得模型能够快速适应新任务。

快速适应新任务: 开发能够在极少样本学习情况下快速适应新任务的模型。

-

解释性和可信赖性

可解释的迁移学习: 提高迁移学习模型的解释性,使用户能够理解模型的决策过程。

提高可信赖性: 确保迁移学习在各种应用中的可靠性和鲁棒性。

-

跨界集成

与其他学习范式结合: 将迁移学习与强化学习、联邦学习等其他学习范式结合,发挥各自的优势。

多学科融合: 结合认知科学、心理学等学科的理论和方法,以启发迁移学习的新策略。

-

应用拓展

新领域应用: 将迁移学习应用于更广泛的领域,如生物信息学、天体物理学等。

实际问题解决: 解决更多实际问题,如气候变化预测、精准医疗等。

5 总结

迁移学习是解决数据稀缺、提高模型性能和加快训练进程的有效方法。随着机器学习和人工智能的不断发展,迁移学习在许多领域都显示出巨大的潜力。然而,如何有效地实施迁移学习、选择合适的源任务和处理领域差异仍然是该领域的研究热点。随着技术的进步,预计迁移学习将在未来的人工智能应用中扮演更加重要的角色。