更多Python学习内容:ipengtao.com

大家好,我是彭涛,今天为大家分享 Python实现高频关键词筛选与共现次数计算,全文3300字,阅读大约10分钟。

在文本分析和自然语言处理中,关键词的提取和关键词共现分析是常见的任务。本文将详细介绍如何使用Python进行高频关键词的筛选以及计算关键词的共现次数,通过详实的示例代码帮助大家更好地理解和应用这些技术。

文本预处理

首先,需要对文本进行预处理,包括去除停用词、分词等步骤。使用常见的NLP库如NLTK或spaCy可以方便地实现这些功能。

import nltk

from nltk.corpus import stopwords

from nltk.tokenize import word_tokenizenltk.download('stopwords')

nltk.download('punkt')def preprocess_text(text):stop_words = set(stopwords.words('english'))words = word_tokenize(text.lower())filtered_words = [word for word in words if word.isalnum() and word not in stop_words]return filtered_words

高频关键词筛选

使用词频统计的方法,可以筛选出文本中的高频关键词。这里以一个简单的示例为例:

from collections import Counterdef extract_keywords(text, top_n=5):words = preprocess_text(text)word_freq = Counter(words)top_keywords = word_freq.most_common(top_n)return [keyword[0] for keyword in top_keywords]

关键词共现计算

计算关键词的共现次数有助于理解它们之间的关联性。以下是一个简单的共现计算示例:

def co_occurrence_matrix(texts, keywords):co_matrix = {keyword: {k: 0 for k in keywords} for keyword in keywords}for text in texts:words = preprocess_text(text)for i, keyword in enumerate(keywords):if keyword in words:for j in range(i + 1, len(keywords)):if keywords[j] in words:co_matrix[keyword][keywords[j]] += 1co_matrix[keywords[j]][keyword] += 1return co_matrix

示例与应用

下面使用一些示例文本来演示如何应用上述方法:

texts = ["Python is a powerful programming language.","Data science involves analyzing and interpreting complex data sets.","Machine learning is a subset of artificial intelligence.","Python libraries such as pandas and numpy are widely used in data analysis."

]top_keywords = extract_keywords(' '.join(texts))

print("Top Keywords:", top_keywords)co_matrix = co_occurrence_matrix(texts, top_keywords)

print("Co-Occurrence Matrix:")

for keyword, co_keywords in co_matrix.items():print(f"{keyword}: {co_keywords}")

可视化

最后,可以使用可视化工具如matplotlib或seaborn对关键词共现进行可视化展示,更直观地理解它们之间的关系。

import seaborn as sns

import matplotlib.pyplot as pltco_matrix_df = pd.DataFrame(co_matrix)

sns.heatmap(co_matrix_df, annot=True, cmap="YlGnBu")

plt.title("Keyword Co-Occurrence Matrix")

plt.show()

进一步优化与应用

1 TF-IDF权重

为了更准确地衡量关键词的重要性,可以使用TF-IDF(Term Frequency-Inverse Document Frequency)权重,它考虑了关键词在整个语料库中的重要性。

from sklearn.feature_extraction.text import TfidfVectorizerdef extract_keywords_tfidf(texts, top_n=5):vectorizer = TfidfVectorizer(stop_words='english')tfidf_matrix = vectorizer.fit_transform(texts)feature_names = vectorizer.get_feature_names_out()tfidf_sum = tfidf_matrix.sum(axis=0)tfidf_scores = [(feature_names[i], tfidf_sum[0, i]) for i in range(len(feature_names))]tfidf_scores = sorted(tfidf_scores, key=lambda x: x[1], reverse=True)return [keyword[0] for keyword in tfidf_scores[:top_n]]

2 关键词共现网络图

使用网络图可以更形象地展示关键词之间的关系。可以使用NetworkX库来创建关键词共现网络图。

import networkx as nx

import matplotlib.pyplot as pltdef plot_co_occurrence_network(co_matrix):G = nx.Graph()for keyword, co_keywords in co_matrix.items():for co_keyword, weight in co_keywords.items():G.add_edge(keyword, co_keyword, weight=weight)pos = nx.spring_layout(G)labels = {node: node for node in G.nodes}nx.draw(G, pos, labels=labels, with_labels=True, font_size=8, font_color='black', node_size=800, node_color='skyblue', edge_color='gray', font_family='sans-serif', alpha=0.8, linewidths=0.5)plt.title("Keyword Co-Occurrence Network")plt.show()

通过这两个进一步的优化,我们可以得到更精确的关键词提取和更具可视化效果的关键词共现网络图。

总结

通过本文的详细示例代码,我们学习了如何使用Python进行高频关键词的筛选和计算关键词共现次数。从基本的文本预处理到TF-IDF权重的应用,再到关键词共现网络图的可视化,我们覆盖了多个关键步骤。同时,我们介绍了一些进阶的技术和扩展思路,帮助大家更好地应用这些方法于实际项目中。

在实际应用中,根据具体需求不断调整和优化算法参数,结合大规模语料库处理、实时数据处理和深度学习方法,可以使关键词提取和共现分析更为灵活、高效。

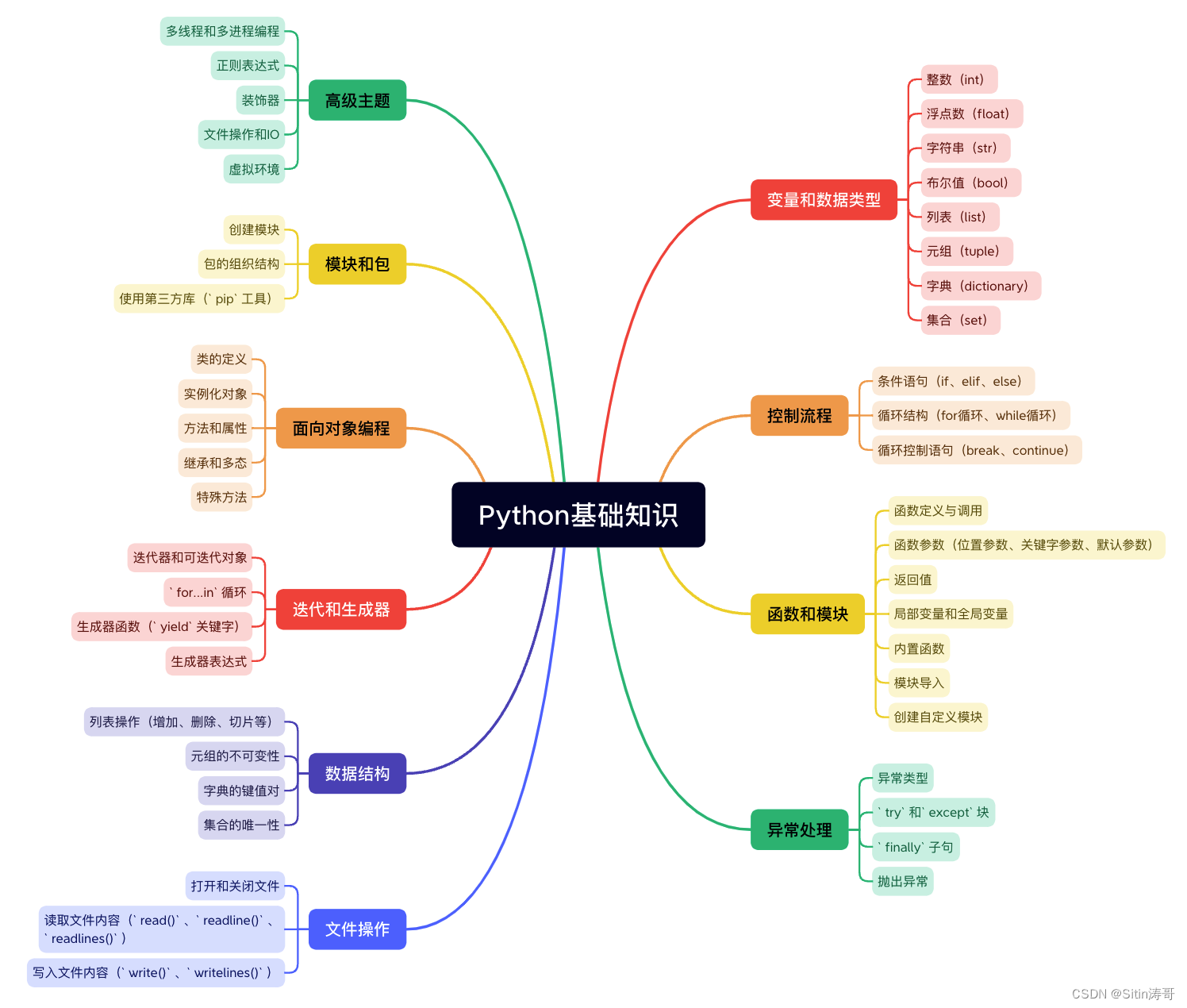

Python学习路线

更多资料获取

📚 个人网站:ipengtao.com

如果还想要领取更多更丰富的资料,可以点击文章下方名片,回复【优质资料】,即可获取 全方位学习资料包。

点击文章下方链接卡片,回复【优质资料】,可直接领取资料大礼包。