多维时序 | MATLAB实现TSOA-TCN-Multihead-Attention多头注意力机制多变量时间序列预测

目录

- 多维时序 | MATLAB实现TSOA-TCN-Multihead-Attention多头注意力机制多变量时间序列预测

- 预测效果

- 基本介绍

- 模型描述

- 程序设计

- 参考资料

预测效果

基本介绍

MATLAB实现TSOA-TCN-Multihead-Attention多头注意力机制多变量时间序列预测。

模型描述

MATLAB实现TSOA-TCN-Multihead-Attention凌日优化时间卷积神经网络融合多头自注意力机制的多变量时间序列预测,用于处理时间序列数据;适用平台:Matlab 2023及以上

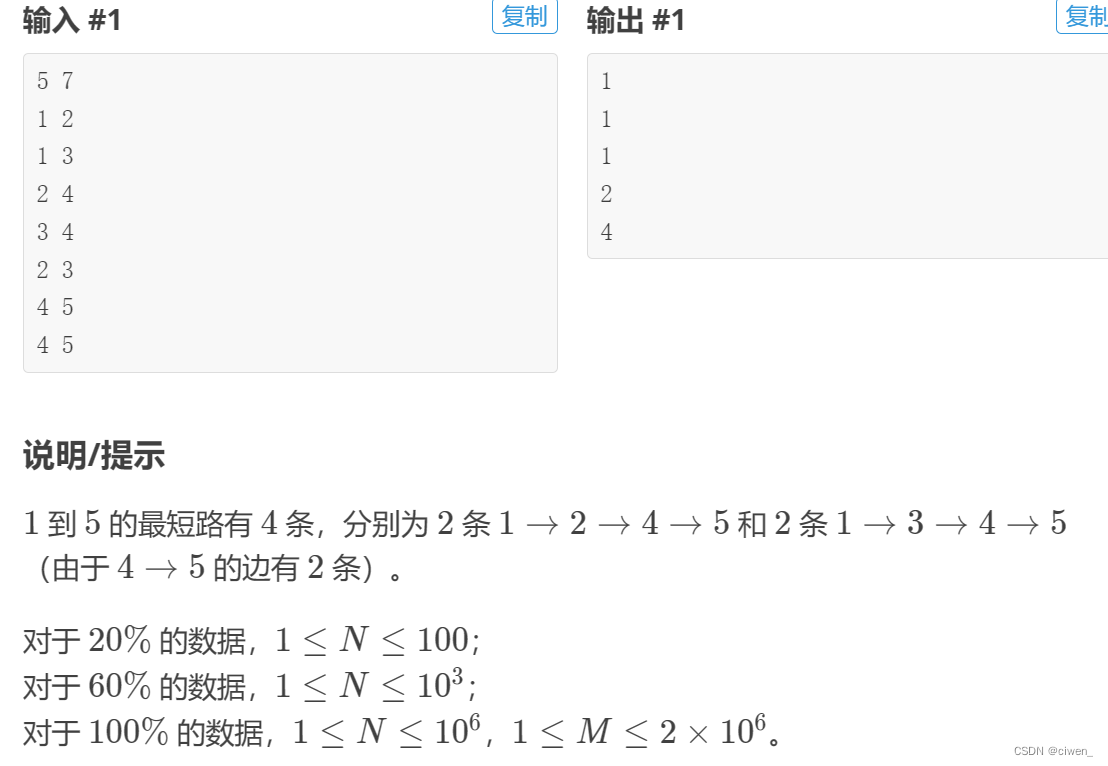

1.data为数据集,格式为excel,4个输入特征,1个输出特征,考虑历史特征的影响,多变量时间序列预测;

2.主程序文件,运行即可;

3.命令窗口输出R2、MAE、MAPE、MSE和MBE,可在下载区获取数据和程序内容;

注意程序和数据放在一个文件夹,运行环境为Matlab2023b及以上。

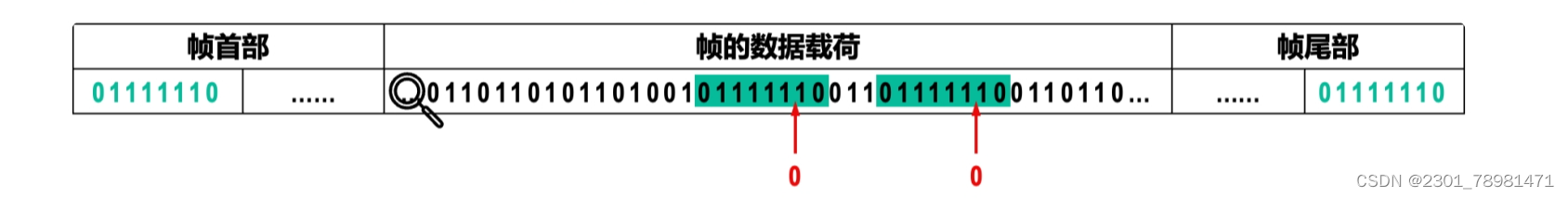

TCN-Multihead SelfAttention模型的创新性在于将两种不同的神经网络结构进行了组合,即Temporal Convolutional Networks (TCN)和Multihead SelfAttention。下面我将介绍这两种结构的创新点和如何组合它们的创新之处。

- Temporal Convolutional Networks (TCN)的创新性:

- TCN是一种卷积神经网络结构,专门用于处理时间序列数据。与传统的循环神经网络(RNN)相比,TCN具有更短的训练时间和更好的并行计算性能。

- TCN通过使用一维卷积层和残差连接来捕捉时间序列数据中的长期依赖关系。这种结构可以有效地学习序列中的局部和全局模式,并且在许多时间序列任务中取得了良好的性能。

- Multihead SelfAttention的创新性:

- SelfAttention是一种注意力机制,它通过计算输入序列中每个元素与其他元素之间的关联性权重,从而捕捉序列中的重要信息。

- Multihead SelfAttention扩展了传统的SelfAttention机制,通过将注意力计算应用于多个子空间(称为头),并将不同头的注意力结果进行拼接或加权平均,进一步增强了模型的表达能力。

- TCN-Multihead SelfAttention的创新之处:

- 将TCN和Multihead SelfAttention结合起来,可以充分发挥它们各自的优势。TCN可以捕捉时间序列数据中的局部和全局模式,而Multihead SelfAttention可以捕捉元素之间的关联性和重要性。

- 这种组合能够同时捕捉时间序列数据的局部和全局信息,从而提高模型对时间序列中重要特征的提取能力。它可以更好地处理长期依赖关系和序列中的重要事件。

- 此外,TCN-Multihead SelfAttention模型还可以通过多个头的注意力计算来并行化处理,从而提高了模型的计算效率。

TCN-Multihead SelfAttention模型的创新性在于将TCN和Multihead SelfAttention这两种不同的神经网络结构组合在一起,充分发挥它们的优势,提高了时间序列数据建模和处理的能力,并且具有较好的计算效率。这种组合有望在各种时间序列任务中取得更好的性能和效果。Transit Search Optimization Algorithm 代码是从一种新颖的天体物理学启发的元启发式优化算法中提取出来的,该算法基于著名的系外行星探索方法,即凌日搜索(TS)。在凌日算法中,通过研究在一定间隔内从恒星接收到的光,检查亮度的变化,如果观察到接收到的光量减少,则表明行星从恒星锋面经过。

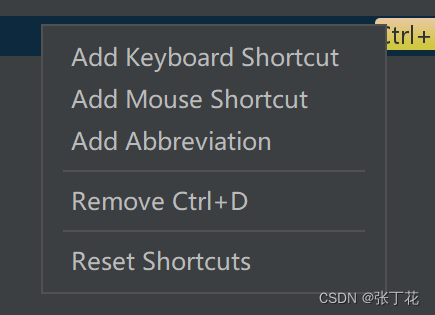

程序设计

- 完整程序和数据获取方式1:同等价值程序兑换;

- 完整程序和数据获取方式2:私信博主回复MATLAB实现TSOA-TCN-Multihead-Attention多头注意力机制多变量时间序列预测获取。

%---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

%% 数据集分析

outdim = 1; % 最后一列为输出

num_size = 0.7; % 训练集占数据集比例

num_train_s = round(num_size * num_samples); % 训练集样本个数

f_ = size(res, 2) - outdim; % 输入特征维度

%---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

%% 划分训练集和测试集

P_train = res(1: num_train_s, 1: f_)';

T_train = res(1: num_train_s, f_ + 1: end)';

M = size(P_train, 2);

%---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

P_test = res(num_train_s + 1: end, 1: f_)';

T_test = res(num_train_s + 1: end, f_ + 1: end)';

N = size(P_test, 2);

————————————————

版权声明:本文为CSDN博主「机器学习之心」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/kjm13182345320/article/details/130471154参考资料

[1] http://t.csdn.cn/pCWSp

[2] https://download.csdn.net/download/kjm13182345320/87568090?spm=1001.2014.3001.5501

[3] https://blog.csdn.net/kjm13182345320/article/details/129433463?spm=1001.2014.3001.5501