Prompt Expansion for Adaptive Text-to-Image Generation

公众:EDPJ(添加 VX:CV_EDPJ 或直接进 Q 交流群:922230617 获取资料)

目录

0. 摘要

3. 提示扩展数据集

3.1 图像审美数据集

3.2 图像到文本反演

3.3 查询/提示提取

4. 提示扩展模型

4.1 基础模型

4.2 重新微调

5. 可控生成

5.1 用于受控提示扩展的前缀

5.2 通用 Prompt Expansion 的前缀丢弃

5.3 多步提示扩展

7. 结果和讨论

S. 总结

S.1 主要贡献

S.2 方法

0. 摘要

文本到图像生成模型功能强大但难以使用。用户制定具体提示以获得更好的图像,但图像可能会重复。本文提出了一个提示扩展框架,帮助用户以更少的努力生成高质量、多样化的图像。提示扩展(Prompt Expansion,PE)模型将文本查询作为输入,并输出一组经过优化的扩展文本提示,当传递给文本到图像模型时,可生成更多种类的吸引人图像。我们进行了人类评估研究,结果显示通过提示扩展生成的图像在审美和多样性方面优于基线方法生成的图像。总体而言,本文提出了一种改进文本到图像生成体验的新颖有效方法。

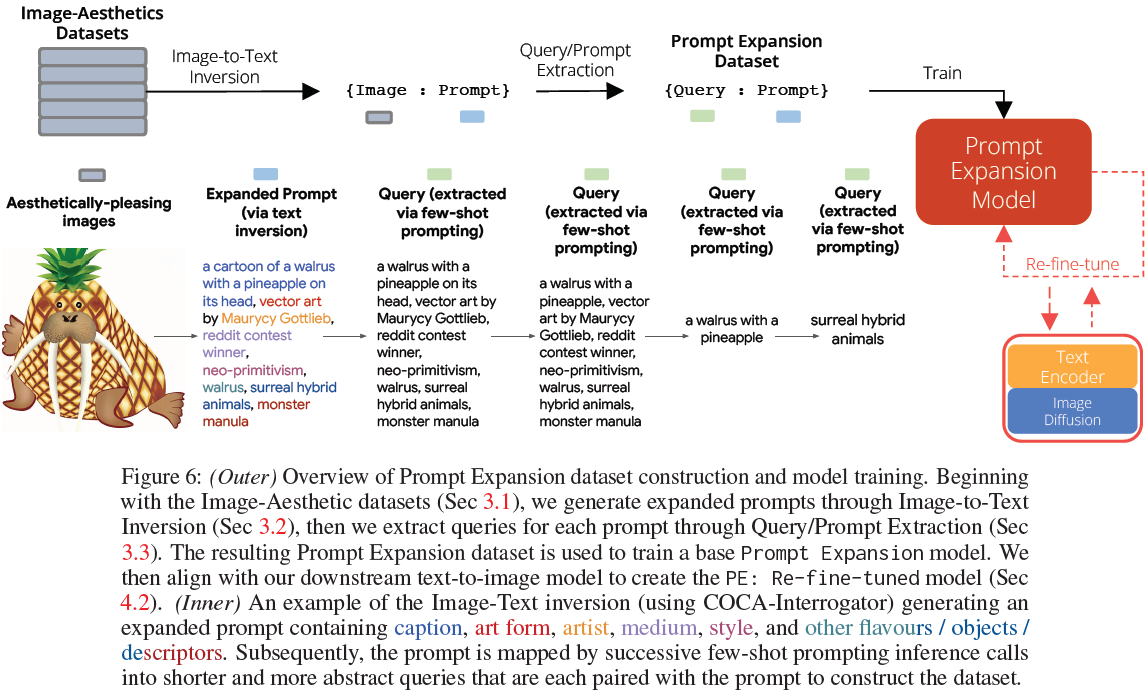

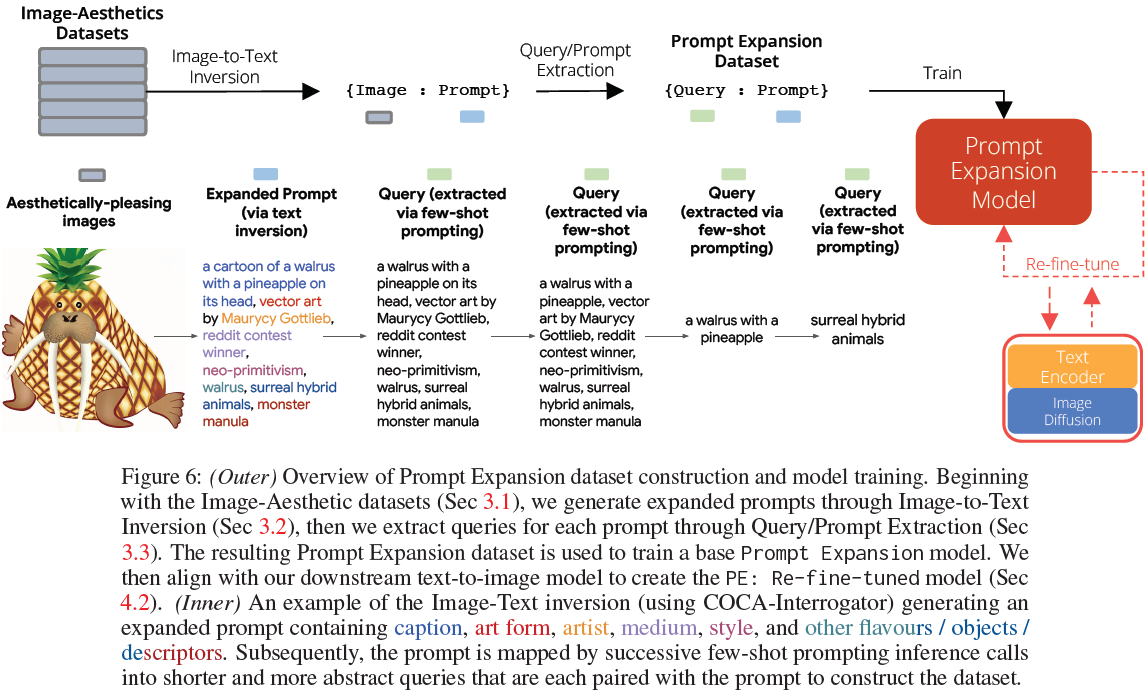

3. 提示扩展数据集

提示扩展(PE)框架需要一个模型,以用户的文本查询作为输入,并返回 N 个文本提示作为输出,使得通过文本到图像生成的 N 个文本提示将返回一组与查询对齐的 N 个多样化、美观的图像。为了训练 PE 模型,我们需要一个将查询映射到提示的数据集,我们以反演的方式构建它。首先,我们收集审美质量高的图像,包括模型生成的图像和自然图像(参见第 3.1 节)。其次,我们将图像反演为与之密切对应的提示,其中包括 alt-text 术语(我们称之为 flavors,参见第 3.2 节)。最后,我们将反演的文本映射到一系列与用户输入更密切对应的高级查询(参见第 3.3节)。这些查询与第二步的提示配对,形成 {查询:提示} 数据集。

3.1 图像审美数据集

我们策划了两个图像数据集。第一个是Webli-Align,由来自Webli(Chen等人,2023)和Align(Jia等人,2021)数据集的图像组成,经过过滤,仅保留具有高 MUSIQ(Ke等人,2021)审美分数的图像。第二个是 CrowdSourced,通过众包(crowd-sourcing)文本到图像模型的输出获得。我们提供了一个类似于 Gradio 的文本到图像生成界面,允许大型组织的用户输入生成图像的提示。用户还可以选择点赞他们喜欢的图像。我们使用这个信号仅保留最吸引人的图像。我们保留了 80k Webli-Align(自然)和 40k CrowdSourced(生成)图像。

3.2 图像到文本反演

第二步是将图像在图像审美数据集中反转为提示文本。虽然用户查询是用户提供的输入,但提示是生成特定图像的文本。我们使用 Interrogator(CLIP-Interrogator)方法进行图像到文本反转。计算得到的提示文本是通过连接一个标题和一组 ‘flavors’ 生成的。标题是对图像内容的描述(例如,谁、什么、在哪里、什么时候)。为了生成标题,我们使用为标题任务微调过的 COCA(Yu等人,2022a)。"flavor" 是指一个描述性词/短语,可以改变图像的风格,而不会添加/更改图像的内容,例如 "印象派" 或 "dslr"。我们从大量生成图像的收集的提示中生成 flavors 列表(详见第 J 节)。

3.3 查询/提示提取

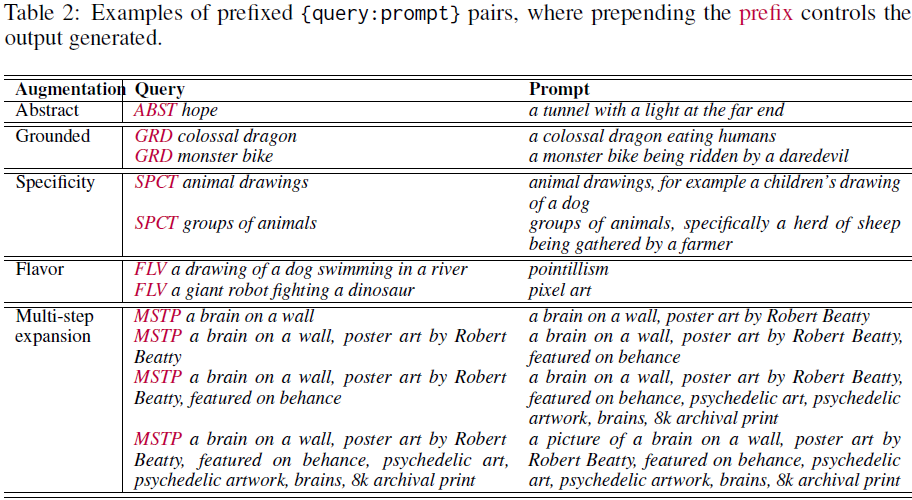

数据集准备的最后一步是计算一系列适合映射到反演文本(提示)的潜在用户查询。我们使用FLAN-PaLMChilla 62B(Chung等人,2022)进行 few-shot 提示,以生成逐渐缩短的查询和更长的提示。该模型接收将长提示映射到短查询的 few-shot 提示集作为示例。few-shot 提示的格式为{提示:查询},这些配对的示例可以在图 6 和表 2 中看到。对于图像到文本反演的每个提示,few-shot 提示示例都被前置为上下文,然后由文本到文本模型生成相应的查询。

我们提取了一系列可以映射到扩展提示的不同查询,并使用 few-sho t提示生成抽象的、具体的、短、中、长长度的查询。附录 A 中详细说明了查询类型的生成方式(例如,基于事实的查询,引出具体性)。这导致一个包含 600k {查询:提示} 对的 Prompt Expansion 数据集。我们执行 70-20-10 的训练-验证-测试拆分,并将训练集拆分为基础和重新精调的的 50-50 比例。

4. 提示扩展模型

我们描述了训练 Prompt Expansion 模型的两个阶段:(i)我们在 Prompt Expansion 数据集上训练基础 Prompt Expansion 模型;然后(ii)我们针对下游文本到图像模型重新微调基础模型。

4.1 基础模型

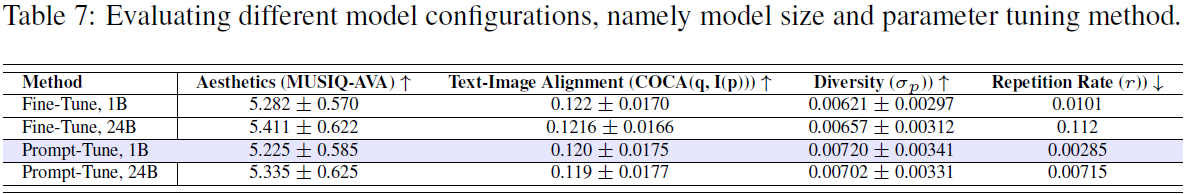

我们的 Prompt Expansion 模型是一个文本生成模型,经过训练,可使用基于 PaLM 2 语言模型家族(Anil等人,2023年)的架构将查询文本映射到扩展的提示文本。PaLM 2 是一个仅解码器的基于 Transformer 的架构,采用 UL2 目标(Tay等人,2023年)进行训练。在评估不同的模型配置后,我们使用 Prompt-tuning(Lester等人,2021年),训练了一个包含 10 亿参数的 PaLM 2 模型,如表 7 所述。我们选择了这个相对较小的基础架构,因为它需要作为复杂的高延迟文本到图像模型(例如 Imagen(Saharia等人,2022a))的前端,因此需要低资源/延迟以使整个流水线可用。对于基础数据集,我们使用 Prompt Expansion 数据集的 50% 拆分,该数据集在第 3 节中有描述,包含 30 万个 {查询:提示} 示例。

4.2 重新微调

在训练基础模型后,我们观察到它可能生成无法使文本到图像模型生成良好图像的提示。造成这种情况的主要原因是基础 Prompt Expansion 模型生成的扩展提示是基于 COCA 图像到文本反演模型偏爱的文本和图像之间的对齐。因此,我们提出了一种通用的重新微调过程:给定模型的目标行为,重新微调以过滤基础模型生成的与目标行为相符的扩展提示。为了与文本到图像模型对齐,我们构建了一个数据集,其中扩展的提示更接近下游文本到图像模型的行为。

对于 Prompt Expansion 数据集剩余的 50% 拆分中的查询,我们从基础模型生成扩展的提示,然后将其输入到下游文本到图像模型(在我们的实验中是 Imagen(Saharia等人,2022a))。我们使用查询-图像嵌入距离和提示-图像嵌入距离的加权平均(有关详细信息,请参见附录D)对这些图像进行评分,并过滤出得分低于固定阈值的 {查询:提示} 对。然后,我们仅使用这些被过滤的 {查询:提示} 对从基础模型检查点继续重新微调,从而产生 PE:重新微调模型,它经过优化以返回使文本到图像模型能够生成高质量图像的查询和 flavors。

5. 可控生成

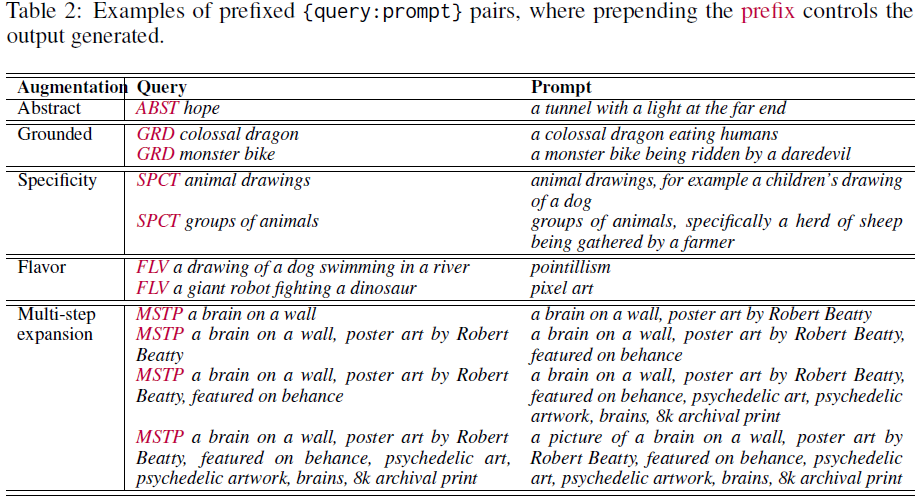

5.1 用于受控提示扩展的前缀

到目前为止,我们已经介绍了构建通用 Prompt Expansion 模型的方法。然而,通常情况下,用户或应用程序设计人员希望控制 Prompt Expansion 策略的方向,例如添加更多 flavor 或添加特定类型的多样化细节。为了支持这些用例,我们实现了我们的 Prompt Expansion 模型的可控版本,可以通过在查询前添加 8 个支持的前缀之一来指导生成特定类型的扩展。例如,我们可以使用 FLV 前缀指导模型仅生成 flavor,或者使用 MSTP 前缀在交互式多步提示扩展场景中迭代扩展原始查询。控制生成的几个示例显示在表 2 中,支持的所有 flavor 的完整列表在表 1 中。为了训练 PE: Multi-Prefix 模型,我们从第 3 节的 Prompt Expansion 数据集开始。每个 {查询:提示} 对都分配了一个适当的前缀。在 few-shot 提示期间,一些查询/提示被格式化为抽象或详细,因此这些前缀是已知的(例如,ABST,DTL)。一些前缀(例如,RFT,MSTP)也是已知的,因为它们的 {查询:提示} 对是合成的。需要对一些 {查询:提示} 对进行前缀分类,例如将 HAST 前缀分配给返回良好美学效果的提示。前缀分配导致了 Prompt Expansion 数据集的一个新版本,其中每个查询都以一个前缀开头;这用于微调和训练 PE: Multi-Prefix 模型。

5.2 通用 Prompt Expansion 的前缀丢弃

有了 Multi-Prefix 数据集,我们探索了使用可控生成提示来改善通用 Prompt Expansion 任务性能的可能性。其思想是使用可控生成初始化模型的训练,然后在训练过程中逐渐改变其行为,猜测给定查询的适当前缀并生成匹配的扩展。例如,对于高度抽象的查询,如 "Undying Love",模型的行为应该与 ABST 前缀相匹配(见表 2)。通过一种我们称之为前缀丢弃(Prefix Dropout)的新颖学习技术来实现这一点。我们从上述前缀注释的数据集开始,但在训练过程中,逐渐增加前缀在查询中被随机移除或丢弃的例子的百分比,从 0.4 的丢弃率逐渐增加到 1.0。这产生了 PE: Prefix Dropout 模型,可以与我们的基础和重新微调的模型进行比较,作为通用 Prompt Expansion 的候选模型。

5.3 多步提示扩展

探索可能是一个多步骤的过程。在用户的查询返回一组扩展提示之后,用户可以在提示中进行选择,并将此提示反馈到 Prompt Expansion 模型中。这使用户能够在不需要手动设计文本提示的情况下迭代扩展提示。使用 PE: Re-fine-tuned,我们在留出的查询上生成扩展提示,并在上一步的提示上迭代生成提示。这导致了从扩展提示到下一步扩展提示的多步训练数据。我们使用 MSTP 前缀在 Prompt Expansion 模型上对多步数据进行重新微调。

7. 结果和讨论

在美学、图文对齐和多样性方面,相比于基线,提示扩展(Prompt Expansion,PE) 表现良好。

在美学方面,基于 PE 生成的图像更符合人类的审美。在图文对齐方面,人们认为,PE 与基线性能相当。

S. 总结

S.1 主要贡献

用户制定具体提示以生成更好的图像,但图像可能会重复。本文提出提示扩展(Prompt Expansion,PE),将文本查询作为输入,并输出一组经过优化的扩展文本提示,当传递给文本到图像模型时,可生成更多种类的吸引人图像。

S.2 方法

提示扩展数据集的构建和模型的训练如图 6 所示。

提示扩展数据集的构建。

- 基于用户输入查询,收集审美质量高的图像,包括模型生成的图像和自然图像

- 使用 Interrogator(CLIP-Interrogator)将图像反演为与之密切对应的提示

- 将反演的文本映射到一系列与用户输入更密切对应的高级查询。这些高级查询与第二步的提示配对,形成 {查询:提示} 数据集。

提示扩展模型的训练包含两个阶段:

- 在提示扩展数据集上训练基础提示扩展模型:使用基于 PaLM 2 语言模型的架构将查询文本映射到扩展的提示文本

- 针对下游文本到图像模型重新微调基础模型:从基础模型生成扩展的提示,然后将其输入到下游文本到图像模型。

- 然后,计算查询-图像嵌入距离和提示-图像嵌入距离的加权平均,并过滤结果低于固定阈值的 {查询:提示} 对。

- 然后,仅使用这些被过滤的 {查询:提示} 对从基础模型检查点继续重新微调,从而产生 PE:重新微调模型,它经过优化以返回使文本到图像模型能够生成高质量图像的查询。

PE: Multi-Prefix 模型:

- 在查询前添加 8 个支持的前缀之一来指导生成特定类型的扩展。

- 为训练 PE: Multi-Prefix 模型,从 Prompt Expansion 数据集开始,为每个 {查询:提示} 对都分配了一个适当的前缀。

- 在 few-shot 提示期间,一些查询/提示被格式化为抽象(ABSTract)或详细(DeTaiLed),因此这些前缀是已知的(例如,ABST,DTL)。

- 一些前缀(例如,RFT,MSTP)也是已知的,因为它们的 {查询:提示} 对是合成的(Re-Fine-Tuned,MultiSTeP)。

- 需要对一些 {查询:提示} 对进行前缀分类,例如将 HAST 前缀分配给返回良好美学(HighAeSThetics)效果的提示。

PE: Prefix Dropout 模型:从 PE: Multi-Prefix 的前缀注释数据集开始,在训练过程中,逐渐增加前缀在查询中被随机移除或丢弃的例子的百分比,从 0.4 的丢弃率逐渐增加到 1.0。

PE: Re-fine-tuned 模型:在用户的查询返回一组扩展提示之后,用户可以在提示中进行选择,并将此提示反馈到 Prompt Expansion 模型中。这使用户能够在不需要手动设计文本提示的情况下迭代扩展提示。实验结果表明,该模型具有最突出的性能。