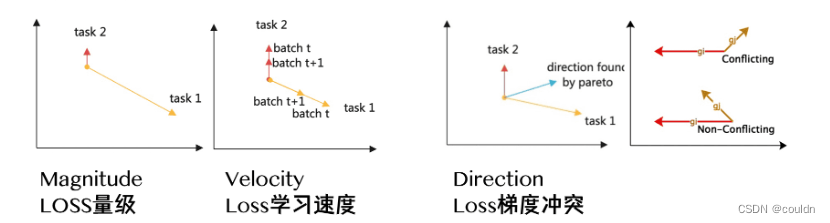

多目标loss平衡:

优化方法更多的考虑的是在已有结构下,更好地结合任务进行训练和参数优化,它从Loss与梯度的维度去思考不同任务之间的关系。在优化过程中缓解梯度冲突,参数撕扯,尽量达到多任务的平衡优化。

-

GradNorm 尝试将不同任务的梯度调节到相似的量级来控制多任务网络的训练,以鼓励网络以尽可能相同的速度学习所有任务。

-

DWA 它也通过考虑每个任务的损失改变,去学习平均不同训练轮数下各任务的权重。

多目标融合推理

为了建模用户的满意度,我们会对多个隐式、显式目标进行预估,如点击率、有效播放率、播放时长、点赞率、关注率等。最终用统一的融合公式将预估值合成一个排序分。

-

线性加权 score=\sum_{i=1}^n\alpha_i*ctr_i

-

指数加权 score=\prod_{i=1}^n ctr_i^{\alpha_{i}}

-

带权指数加法 score=\sum_{i=1}^n(\alpha_i+ctr_i)^{\beta_i}

-

带权指数乘法 score=\prod_{i=1}^n(\alpha_i+ctr_i)^{\beta_i}

-

强化搜参:把线上流量分成一些小的流量池,通过一些线上当前的参数,去生成一些新的参数,去看用户对这些参数的反应,收集反馈进行迭代。

![【SkyWant.[2304]】路由器操作系统,移动【Netkeeper】使用教程校园网](https://img-blog.csdnimg.cn/direct/6b124790fda54609a3c303d72e1b967b.jpeg)