目录

- 写在开头

- 1. AB测试基础知识

- 1.1 AB测试概述

- 1.2 原理和流程

- 1.3 广告领域中的AB测试应用

- 2. 评价广告投放中的AB测试

- 2.1 关键指标选择与解释

- 2.2 统计学方法应用

- 3. AB测试分析中的常见问题与解决方案

- 3.1 样本偏差

- 3.2 季节性影响

- 3.3 测试时长选择

- 3.4 结果误解与分析失误

- 4. 优化广告投放的AB测试策略

- 4.1 定期复盘与学习

- 4.2 多因素测试的价值

- 4.3 持续性优化的重要性

- 5. 案例研究

- 5.1 具体广告投放案例分析

- 5.2 更多案例

- 写在最后

写在开头

在当今数字化的商业环境中,广告投放是企业获取客户和推动销售的重要手段。然而,随着市场竞争的加剧,制定有效的广告策略变得愈发复杂。在这个背景下,AB测试成为了广告主们不可或缺的工具之一。本文将深入探讨广告投放中的AB测试,着重于评价指标的选择、统计学方法的应用以及优化策略的制定,通过具体的案例研究为读者呈现AB测试的科学性和实用性。

1. AB测试基础知识

1.1 AB测试概述

AB测试,又称为分组测试或对照测试,是一种通过在两个或多个变体间进行比较来确定哪种变体在给定目标方面执行得更好的方法。在广告投放领域,AB测试通常用于比较不同广告创意、定向策略或者落地页设计的效果。

1.2 原理和流程

AB测试的基本原理是将目标受众随机分为两个(或多个)群体,其中一组暴露于A版本(控制组),另一组暴露于B版本(实验组)。通过比较两组的表现,可以得出对于特定指标的影响。

1.3 广告领域中的AB测试应用

在广告投放中,AB测试的应用广泛涉及广告点击率(CTR)、转化率、平均订单价(AOV)等关键指标。通过AB测试,广告主能够更科学地优化广告投放策略,提升广告效果。

2. 评价广告投放中的AB测试

2.1 关键指标选择与解释

在广告投放中,选择合适的关键指标至关重要。以下是一些常用指标的解释及其在AB测试中的应用:

-

点击率(CTR): 衡量广告被点击的比例,是衡量广告吸引力的重要指标。AB测试中,可以通过比较不同广告版本的CTR来判断哪个版本更具吸引力。

例如,A版本广告点击次数为1000次,展示次数为50,000次,CTR为(1000 / 50,000)* 100% = 2%。而B版本的CTR为1.5%。通过计算,我们可以清晰地了解哪个版本的广告在吸引用户点击方面更为成功。

-

转化率: 衡量用户完成预期动作的比例,如购买、注册等。通过AB测试,可以确定哪种广告策略更有效地促使用户完成转化。

举例来说,如果A版本广告导致100次点击,其中有10次转化,转化率为10%。而B版本只有5次转化,转化率为5%。通过这些数据,我们可以清楚地了解不同版本广告在转化率上的差异。

-

平均订单价(AOV): 衡量每个订单的平均价值。AB测试可以帮助广告主确定哪种策略对提升平均订单价更为有效。

以A版本为例,总销售额为10,000元,订单数为100,平均订单价为100元。而B版本总销售额为15,000元,订单数为120,平均订单价为125元。通过对比两个版本的平均订单价,我们可以判断B版本更有利于提高订单价值。

-

用户留存率: 衡量用户在一定时间内继续使用产品或服务的比例。AB测试可以帮助确定广告策略对用户留存的影响。

举例,A版本在投放后第一个月的用户留存率为30%,而B版本的留存率为25%。通过这些数据,我们可以判断A版本广告更成功地保留用户。

2.2 统计学方法应用

在进行AB测试时,统计学方法的正确应用至关重要,确保结果的可靠性和显著性:

-

显著性水平: 设置合理的显著性水平,通常选择0.05,以控制犯错误的概率。

举例,如果我们设置显著性水平为0.05,而通过AB测试得出的p值为0.03,小于显著性水平,我们可以拒绝零假设,即两个版本的差异是显著的。

-

置信区间: 使用置信区间来确定效果的范围,而不仅仅是关注点估计值。

例如,计算A版本平均订单价的95%置信区间为95元到105元。这意味着我们对A版本平均订单价的估计在这个范围内,有95%的置信度。

3. AB测试分析中的常见问题与解决方案

3.1 样本偏差

在进行AB测试时,样本偏差可能会导致测试结果的不准确性。样本偏差意味着样本群体不够代表整体目标群体,从而影响了结果的可靠性。

解决方案:

-

随机分组: 确保在进行AB测试时,受众能够被随机分为不同的组,以确保各组之间的特征分布均匀。

-

样本大小: 在设计实验时,需要确保样本容量足够大,以降低随机误差,并提高实验的稳定性。

-

样本分层: 如果可能,进行样本分层,确保在每个层次中都有足够数量的样本,以减小样本偏差的可能性。

3.2 季节性影响

广告投放的效果可能会受到季节性因素的影响,而忽视这些因素可能导致不准确的AB测试结果。

解决方案:

-

季节性调整: 在进行AB测试时,需要考虑到不同季节对广告效果的可能影响。根据具体情况,可以进行季节性调整,以便更准确地评估广告效果。

-

季节性分析: 在分析AB测试结果时,可以针对不同季节进行分析,以了解季节性因素对测试结果的影响。

3.3 测试时长选择

测试时长的选择直接影响到测试结果的可靠性。过短的测试时长可能无法反映真实的效果,从而导致错误的结论。

解决方案:

-

先期小范围测试: 在正式的AB测试之前,进行一些小范围的测试,以初步评估广告效果。根据初步结果,确定合适的测试时长。

-

监控趋势: 在进行AB测试的过程中,随时监控测试结果的趋势。如果趋势明显,可以及时调整测试时长,确保测试的有效性。

3.4 结果误解与分析失误

对AB测试结果的误解和分析失误可能导致错误的决策。过度关注某一个指标,或者忽视多维度分析,都可能导致对结果的不准确理解。

解决方案:

-

多维度分析: 在分析AB测试结果时,不仅要关注单一的指标,还需要进行多维度的分析。综合考虑多个指标,以更全面地了解测试效果。

-

科学解释: 避免主观臆断,进行科学解释。在得出结论之前,确保对结果的每一个方面都进行了充分的考虑和分析。

-

交叉验证: 在测试结果得出结论之前,可以进行交叉验证,使用不同的统计方法或工具,以确保结果的一致性和可靠性。

4. 优化广告投放的AB测试策略

4.1 定期复盘与学习

定期复盘AB测试结果是保持广告投放策略持续优化的关键。通过定期的复盘,广告主能够深入了解每次测试的效果,并从中吸取经验教训。

具体步骤:

- 设定复盘周期: 确定复盘的时间周期,通常建议每月进行一次复盘。

- 汇总数据: 收集并整理AB测试的数据,包括点击率、转化率、平均订单价等关键指标。

- 对比不同版本: 比较不同版本的广告效果,特别注意哪些变化对于指标有显著的影响。

- 总结经验: 总结每次测试的经验,包括成功的因素和失败的原因。

- 调整优化策略: 根据复盘的结果,调整广告投放策略,优化下一轮的测试。

案例:

在上个月的AB测试中,我们尝试了不同的广告文案,发现B版本的点击率较高,但A版本的转化率更优。通过复盘,我们发现A版本的文案更符合目标用户的购买意愿。因此,下个月的广告投放中,我们将保留A版本的文案,并加以优化。

4.2 多因素测试的价值

多因素测试是为了更全面地了解不同因素对广告效果的影响。广告主可以通过同时测试多个因素,发现各因素之间的交互作用,为更复杂的决策提供更全面的依据。

具体步骤:

- 确定测试因素: 选择多个影响广告效果的因素,如广告创意、投放时段、定向策略等。

- 设计实验组合: 将不同因素的各个水平进行组合,形成多个实验组合。

- 进行测试: 将不同实验组合应用于AB测试,收集并分析数据。

- 分析交互效应: 了解不同因素之间的交互效应,找出最优组合。

- 调整策略: 根据多因素测试的结果,调整广告投放策略。

案例:

我们进行了一个多因素测试,同时考虑了广告创意、投放时段和地域定向的影响。结果显示,在特定地域,特定时段,某些创意的效果更好。这个发现帮助我们更精准地定向广告,提高整体广告效果。

4.3 持续性优化的重要性

广告投放的环境和用户需求随时都可能发生变化,因此持续性优化是确保广告策略保持高效的关键。定期进行新一轮的测试和优化,是保持广告投放策略与市场同步的有效方式。

具体步骤:

- 设定优化周期: 确定新一轮的优化周期,通常建议每季度进行一次全面的优化。

- 收集反馈: 收集市场反馈和用户意见,了解市场变化和用户需求的变化。

- 设定新的测试目标: 根据市场反馈,设定新一轮测试的具体目标和重点。

- 实施新一轮测试: 设计并实施新一轮的AB测试,收集数据。

- 分析结果: 分析新一轮测试的结果,发现新的优化方向。

案例:

根据最新的市场趋势和用户反馈,我们设定了新的广告投放目标,着重关注社交媒体平台的广告效果。通过新一轮测试,我们发现在社交媒体平台投放的广告点击率较高,因此在未来的广告投放中,我们将加大在社交媒体平台的投放力度。

通过这些优化策略,广告主可以不断提升广告投放的效果,确保广告策略始终保持高效,适应市场的变化和用户需求的变化。这种持续性的优化过程是广告投放成功的关键之一。

5. 案例研究

5.1 具体广告投放案例分析

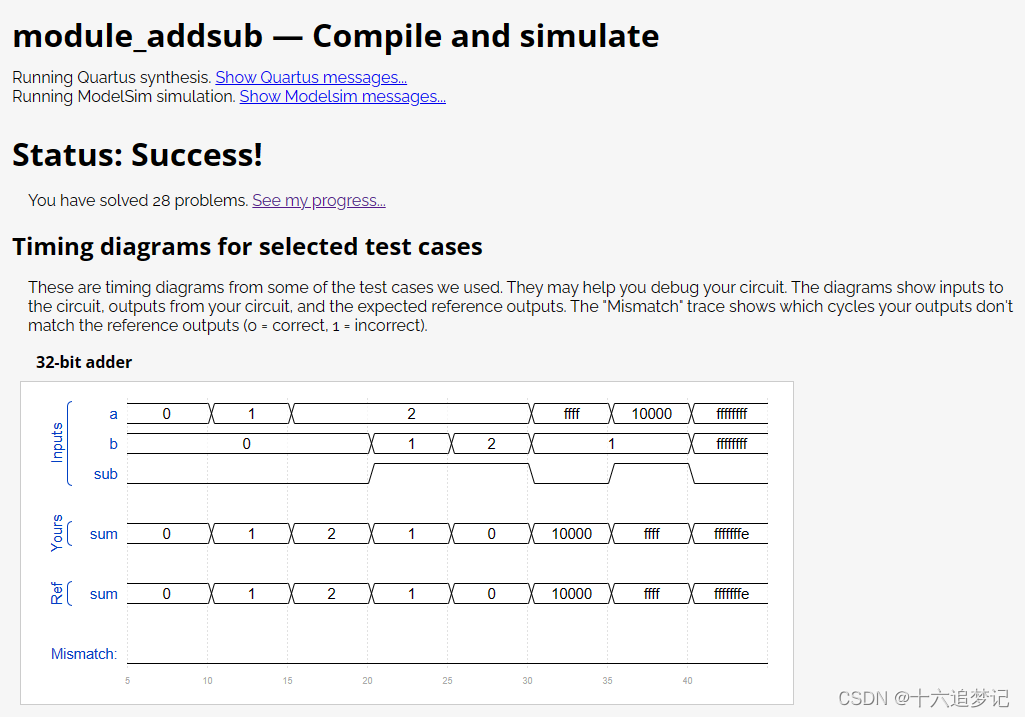

案例:A/B测试不同广告创意对点击率的影响

在这个案例中,我们将通过A/B测试不同广告创意对点击率的影响展示AB测试在广告投放中的应用。

实验设计:

- A版本创意: 色彩鲜明,突出产品特色

- B版本创意: 情感营销,强调用户体验

收集数据并进行分析:

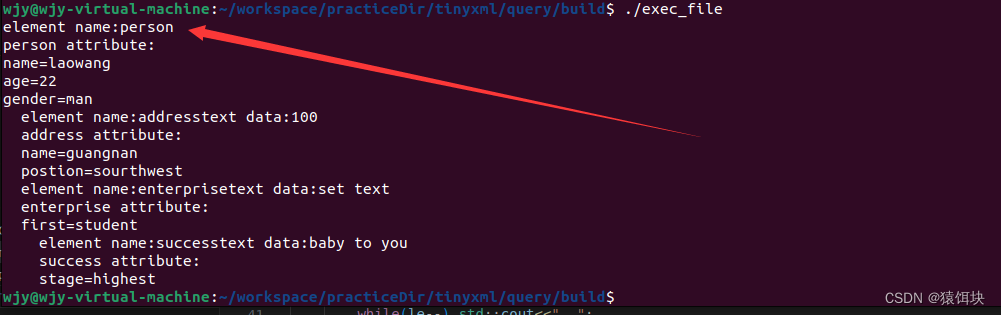

import numpy as np

import pandas as pd

from scipy.stats import ttest_ind# 构建点击数据

np.random.seed(12)# A组广告点击数据,点击次数和曝光次数

clicks_A = np.random.randint(100, 1000, size=1000)

exposures_A = np.random.randint(500, 1500, size=1000)# B组广告点击数据,点击次数和曝光次数

clicks_B = np.random.randint(80, 900, size=1000)

exposures_B = np.random.randint(500, 1500, size=1000)# 将数据整理成DataFrame

data = pd.DataFrame({'Group': ['A'] * 1000 + ['B'] * 1000,'Clicks': np.concatenate([clicks_A, clicks_B]),'Exposures': np.concatenate([exposures_A, exposures_B])

})# 计算点击率

data['Click-through Rate'] = data['Clicks'] / data['Exposures']# 计算相对提升

relative_lift = ((group_stats['A'] - group_stats['B']) / group_stats['B']) * 100# 分组统计

group_stats = data.groupby('Group')['Click-through Rate'].mean()# 执行t检验

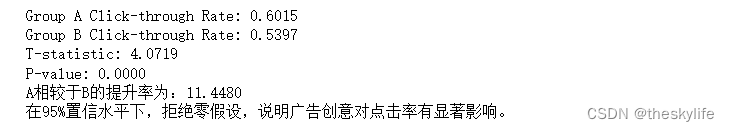

t_stat, p_value = ttest_ind(data.loc[data['Group'] == 'A','Click-through Rate'],data.loc[data['Group'] == 'B','Click-through Rate'])# 打印结果

print(f"Group A Click-through Rate: {group_stats['A']:.4f}")

print(f"Group B Click-through Rate: {group_stats['B']:.4f}")

print(f"T-statistic: {t_stat:.4f}")

print(f"P-value: {p_value:.4f}")

print(f"A相较于B的提升率为:{relative_lift:.4f}")# 判断显著性

alpha = 0.05

if p_value < alpha:print("在95%置信水平下,拒绝零假设,说明广告创意对点击率有显著影响。")

else:print("在95%置信水平下,接受零假设,认为广告创意对点击率没有显著影响。")通过运行上述代码,我们可以得到以下的输出:

通过计算两组数据的点击率和执行的t检验,我们发现A版本的点击率相对于B版本有11.45%的提升,并且p值为0.0000,小于显著性水平0.05,说明差异是显著的。因此,我们可以拒绝零假设,即A版本的广告创意相对于B版本更有效。

应用

根据这一实验结果,广告主可以考虑在实际广告投放中更多地采用A版本的广告创意,以提高点击率。然而,还需要综合考虑其他因素,如转化率、用户留存等,以确保整体广告效果的提升。

5.2 更多案例

在5.1中,我们举例不同的创意,然后在实际过程中,我们还可以进行以下方面的ABtest分析:

-

标题和副标题: 测试不同广告标题和副标题,以确定哪种组合更吸引用户点击。

-

呈现方式: 对比不同呈现方式,如轮播广告、静态广告或动态广告,以找到用户反应最强烈的方式。

-

广告尺寸: 测试不同广告尺寸对用户互动的影响,特别是在不同的广告展示平台上。

-

社交证明: 比较使用社交证明(如用户评论、社交分享、评级等)和不使用社交证明的广告效果。

-

多媒体元素: 测试图像、视频或动画等多媒体元素在广告中的效果,以找到最能吸引用户的媒体类型。

-

字体和排版: 对比不同字体和排版风格对广告可读性和用户吸引力的影响。

-

品牌元素: 测试广告中品牌元素(如标志、品牌色彩等)的不同展示方式,以找到最符合品牌形象的设计。

-

定向设置: 对比不同定向设置,包括兴趣、年龄、性别、地理位置等,以确定最适合目标受众的定向策略。

-

广告频率: 测试不同广告频率对用户感知和互动的影响,以找到适当的广告投放频次。

-

季节性内容: 比较不同季节或节日主题的广告,以确定在特定时期最能吸引用户的内容。

写在最后

通过以上案例研究,我们深入了解了AB测试在广告投放中的应用。从不同创意和投放时段的优化实验中,我们得出了有关点击率提升的关键指标和成功优化策略。