文章目录

- 前言

- agent modelling

- 一、Fictitious Play(虚拟博弈)

- 二、JAL with agent modelling

前言

基于JAL的算法需要对智能体的行为做出假设以便应用博弈知识求解策略,带来很多限制,根据其他智能体观察到的行为对其它智能体进行建模,预测其行为是agent modelling方法

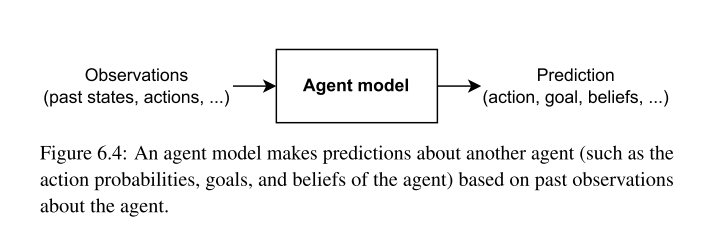

agent modelling

agent model 能够构建其他智能体的模型,这些模型能够对它们的行为做出有效的预测,一般的智能体模型如图所示,在部分可观测的环境当中,agent model能够推断出所建模智能体对环境状态的信念

最常用的方法称为策略重构,目的是根据其他智能体的观测到过去的行为学习策略模型,学习策略模型的过程是有监督学习,数据采用所建模智能体的动作状态对 { ( s τ , a j τ ) } τ = 1 t \{(s^{\tau},a_{j}^{\tau})\}_{\tau=1}^{t} {(sτ,ajτ)}τ=1t,通过训练得到一系列策略的表示,建模智能体针对其他智能体选择最佳反应策略,以下将采用策略重构与最佳反应学习最优策略

一、Fictitious Play(虚拟博弈)

在虚拟博弈当中,智能体i构建关于j的概率分布模型,该模型是基于智能体j在过去采取的动作的数量决定的,公式如下

π ^ j ( a j ) = C ( a j ) ∑ a j ′ C ( a j ′ ) . \hat{\pi}_j(a_j)=\frac{C(a_j)}{\sum_{a_j^{\prime}}C(a_j^{\prime})}. π^j(aj)=∑aj′C(aj′)C(aj).

在每个episode中,智能体i根据智能体j的策略模型选择最佳反应,具体公式如下

B R i ( π ^ − i ) = arg max a i ∈ A i ∑ a − i ∈ A − i R i ( ⟨ a i , a − i ⟩ ) ∏ j ≠ i π ^ j ( a j ) \mathrm{BR}_i(\hat{\pi}_{-i})=\arg\max_{a_i\in A_i}\sum_{a_{-i}\in A_{-i}}\mathcal{R}_i(\langle a_i,a_{-i}\rangle)\prod_{j\neq i}\hat{\pi}_j(a_j) BRi(π^−i)=argmaxai∈Ai∑a−i∈A−iRi(⟨ai,a−i⟩)∏j=iπ^j(aj)

需要注意:虚拟博弈中最佳反应给出最佳动作而不是最佳策略,因此虚拟博弈并不能解决一些随机的均衡

二、JAL with agent modelling

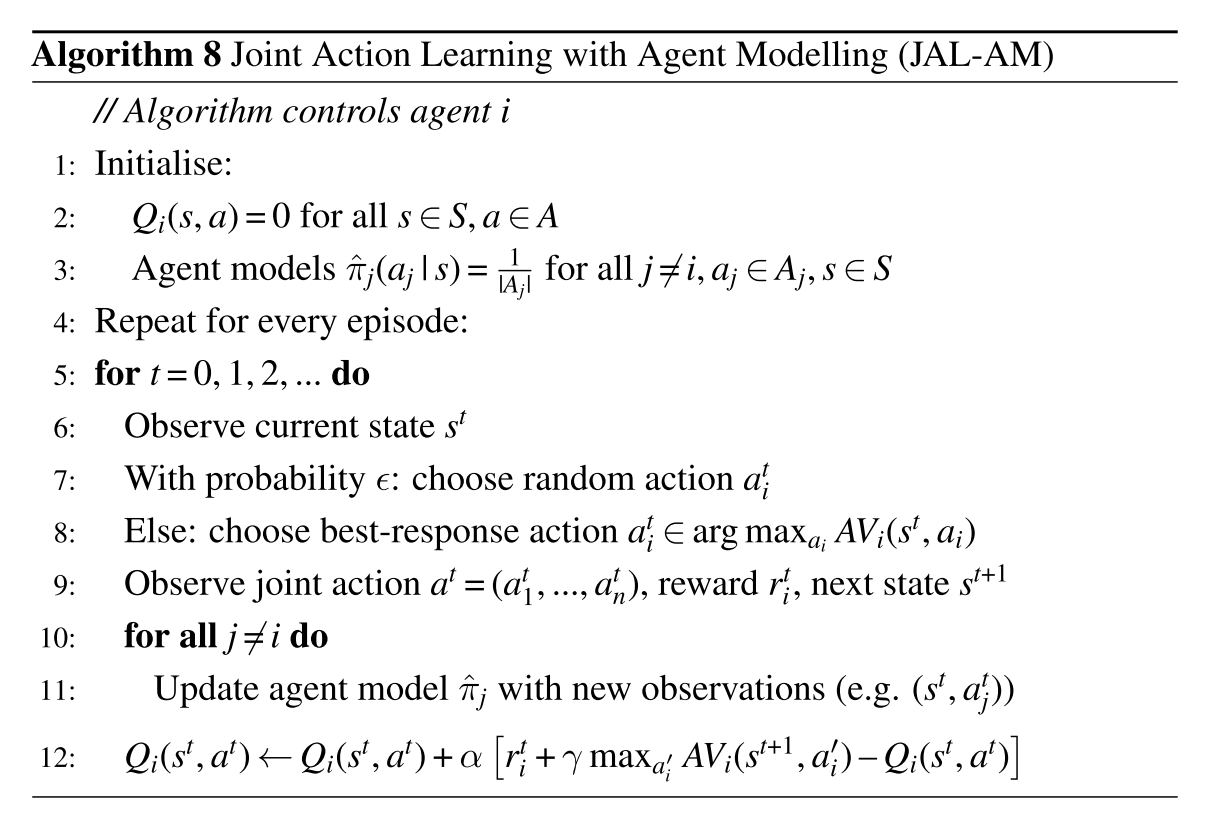

结合联合动作价值函数与智能体模型与最佳反应得到智能体的概率分布,根据概率分布选择最佳动作,得到观测数据更新概率模型与Q值

![Cocos2dx-lua ScrollView[一]基础篇](https://img-blog.csdnimg.cn/direct/8d35bd370b854f478e54a7fd86f165b8.png)