文章目录

- 10.1 区块链技术的发展方向

- 10.1.1 基础知识

- 10.1.2 重点案例:构建一个简单的智能合约

- 步骤1: 创建智能合约

- 步骤2: 部署智能合约

- 步骤3: 使用Python与智能合约交互

- 结语

- 10.1.3 拓展案例 1:探索 DeFi 应用

- 准备工作

- 实现步骤

- 步骤1: 获取Compound市场数据

- 步骤2: 分析借贷市场数据

- 步骤3: 可视化市场数据

- 结语

- 10.1.4 拓展案例 2:NFTs 市场分析

- 准备工作

- 实现步骤

- 步骤1: 获取OpenSea市场数据

- 步骤2: 分析NFT交易数据

- 步骤3: 可视化NFT市场数据

- 结语

- 10.2 数据分析技术的新趋势

- 10.2.1 基础知识

- 10.2.2 重点案例:使用 AutoML 进行数据预测

- 准备工作

- 示例案例:预测心脏病发作的可能性

- 步骤1: 加载和准备数据

- 步骤2: 使用`auto-sklearn`训练模型

- 步骤3: 分析模型结果

- 结语

- 10.2.3 拓展案例 1:情感分析

- 准备工作

- 示例案例:社交媒体帖子的情感分析

- 步骤1: 准备数据

- 步骤2: 进行情感分析

- 步骤3: 汇总和解释结果

- 结语

- 10.2.4 拓展案例 2:图数据分析

- 准备工作

- 示例案例:社交网络中的中心性分析

- 步骤1: 构建图

- 步骤2: 中心性分析

- 步骤3: 解释结果

- 结语

- 10.3 应对未来挑战的策略

- 10.3.1 基础知识

- 10.3.2 重点案例:利用 Python 进行持续学习

- 准备工作

- 示例案例:探索数据集

- 步骤1: 加载数据集

- 步骤2: 数据可视化

- 步骤3: 探索性数据分析(EDA)

- 结语

- 10.3.3 拓展案例 1:在线合作项目

- 准备工作

- 步骤1: 找到感兴趣的项目

- 步骤2: 理解项目和准备贡献

- 示例:为Python项目贡献文档

- 结语

- 10.3.4 拓展案例 2:适应新技术趋势

- 自然语言处理(NLP)

- 示例:使用Transformers库进行文本情感分析

- 区块链技术

- 示例:使用Web3.py与以太坊智能合约交云

- 结语

10.1 区块链技术的发展方向

随着区块链技术的不断成熟和普及,其发展方向也在不断拓展和深化。从最初的加密货币交易到现在的智能合约、去中心化金融(DeFi)、非同质化代币(NFTs),以及跨链技术,区块链正在逐步渗透到我们生活的方方面面。

10.1.1 基础知识

- 智能合约:运行在区块链上的自执行合约,其条款是以代码形式写成。它们使自动化、去中心化的应用程序成为可能。

- DeFi(去中心化金融):通过去中心化的网络提供金融服务,如借贷、交易和保险,无需传统金融中介。

- NFTs(非同质化代币):代表独一无二的资产,如艺术品或收藏品的区块链技术,使数字所有权和稀缺性成为可能。

- 跨链技术:允许不同区块链网络之间的互操作性,使资产和数据能够跨链传输。

10.1.2 重点案例:构建一个简单的智能合约

在这个重点案例中,我们将通过创建一个简单的智能合约来深入探索区块链技术的应用。接着,我们将使用Python和web3.py库与这个合约进行交互,展示如何从外部读取和修改智能合约中的数据。

步骤1: 创建智能合约

首先,我们需要创建一个简单的智能合约。在这个例子中,我们将编写一个合约,该合约允许存储和检索一个数字。

// SPDX-License-Identifier: MIT

pragma solidity ^0.8.0;contract SimpleStorage {uint256 private storedNumber;function setNumber(uint256 _number) public {storedNumber = _number;}function getNumber() public view returns (uint256) {return storedNumber;}

}

步骤2: 部署智能合约

使用Remix IDE,将上面的代码粘贴进去,编译并部署到以太坊测试网络(例如Ropsten)。部署合约时,Remix将提供一个合约地址,这个地址在与合约交互时会用到。

步骤3: 使用Python与智能合约交互

确保已经安装了web3.py库。如果尚未安装,可以通过以下命令安装:

pip install web3

接下来,我们将编写Python脚本,连接到以太坊网络,然后与我们的智能合约进行交互。

from web3 import Web3# 连接到以太坊测试网络

infura_url = "https://ropsten.infura.io/v3/YOUR_INFURA_PROJECT_ID"

web3 = Web3(Web3.HTTPProvider(infura_url))# 确认连接成功

if web3.isConnected():print("Connected to Ethereum network")

else:print("Failed to connect")# 智能合约地址和ABI

contract_address = "YOUR_CONTRACT_ADDRESS"

contract_abi = json.loads('YOUR_CONTRACT_ABI')# 创建智能合约实例

contract = web3.eth.contract(address=contract_address, abi=contract_abi)# 读取合约中存储的数字

stored_number = contract.functions.getNumber().call()

print(f"Stored number: {stored_number}")# 更新存储的数字(这需要签名交易,因此你需要有一个带有足够ETH的账户)

# account = "YOUR_ACCOUNT_ADDRESS"

# private_key = "YOUR_ACCOUNT_PRIVATE_KEY"

# nonce = web3.eth.getTransactionCount(account)

# txn = contract.functions.setNumber(42).buildTransaction({

# 'chainId': 3, # Ropsten

# 'gas': 2000000,

# 'gasPrice': web3.toWei('50', 'gwei'),

# 'nonce': nonce,

# })

# signed_txn = web3.eth.account.signTransaction(txn, private_key=private_key)

# txn_hash = web3.eth.sendRawTransaction(signed_txn.rawTransaction)

# print(f"Transaction hash: {txn_hash.hex()}")

这个示例展示了如何从Python读取和更新智能合约中的数据。请注意,执行setNumber函数需要进行签名交易,这在真实环境中涉及到费用(Gas)。

结语

通过这个案例,你可以看到智能合约如何使得在区块链上存储和检索数据变得可能,并且学会了如何使用Python与智能合约进行交互。这只是智能合约潜力的冰山一角。随着你对Solidity和区块链技术的进一步学习,你将能够开发更复杂、功能更丰富的去中心化应用。

10.1.3 拓展案例 1:探索 DeFi 应用

探索去中心化金融(DeFi)应用是理解当前区块链创新和金融变革的重要方面。通过DeFi,用户可以访问没有中介机构的金融服务,如借贷、交易和保险等。以下是一个使用Python来探索DeFi应用的案例,我们将重点关注获取和分析DeFi平台上的借贷市场数据。

准备工作

在开始之前,你需要选择一个提供数据API的DeFi平台。许多DeFi项目如Compound、Aave和Uniswap等都提供了公共API接口或是允许直接通过智能合约访问数据。本示例将使用Compound的公共API作为示例。

实现步骤

步骤1: 获取Compound市场数据

首先,我们使用Python的requests库来获取Compound平台的市场数据。这些数据包括了不同加密货币的借贷利率、供应量和需求量等信息。

import requests

import pandas as pd# 获取Compound的市场数据

url = "https://api.compound.finance/api/v2/markets"

response = requests.get(url)

data = response.json()# 解析数据

markets_data = data['markets']

df = pd.DataFrame(markets_data)# 选择我们感兴趣的列

columns_of_interest = ['name', 'supply_rate', 'borrow_rate', 'total_supply', 'total_borrows']

df = df[columns_of_interest]# 将利率从小数转换为百分比

df['supply_rate'] = pd.to_numeric(df['supply_rate']) * 100

df['borrow_rate'] = pd.to_numeric(df['borrow_rate']) * 100print(df.head())

步骤2: 分析借贷市场数据

接下来,我们可以分析这些数据来识别哪些加密货币有最高的供应利率或借贷利率,以及市场上最活跃的借贷对。

# 找出供应利率最高的加密货币

highest_supply_rate = df.loc[df['supply_rate'].idxmax()]

print("Highest supply rate:")

print(highest_supply_rate)# 找出借贷利率最高的加密货币

highest_borrow_rate = df.loc[df['borrow_rate'].idxmax()]

print("\nHighest borrow rate:")

print(highest_borrow_rate)

步骤3: 可视化市场数据

使用matplotlib和seaborn库来可视化这些市场数据,比如绘制各加密货币的供应利率和借贷利率。

import seaborn as sns

import matplotlib.pyplot as pltplt.figure(figsize=(10, 6))

sns.barplot(x='name', y='supply_rate', data=df)

plt.title('Supply Rates across Different Cryptocurrencies in Compound')

plt.xticks(rotation=45)

plt.ylabel('Supply Rate (%)')

plt.show()plt.figure(figsize=(10, 6))

sns.barplot(x='name', y='borrow_rate', data=df)

plt.title('Borrow Rates across Different Cryptocurrencies in Compound')

plt.xticks(rotation=45)

plt.ylabel('Borrow Rate (%)')

plt.show()

结语

通过这个案例,你可以看到如何使用Python来获取和分析DeFi平台上的借贷市场数据。这种数据分析能力对于投资者来说是非常有价值的,因为它可以帮助他们做出更加明智的投资决策。此外,开发者也可以利用这些数据来构建更复杂的金融产品和服务。随着DeFi生态系统的不断成熟和发展,能够理解和分析这些市场将变得越来越重要。

10.1.4 拓展案例 2:NFTs 市场分析

非同质化代币(NFTs)市场的爆炸性增长引起了广泛的关注,从艺术品和收藏品到游戏道具和数字身份,NFTs正在重塑数字所有权的概念。进行NFT市场分析可以帮助我们理解哪些类型的NFTs最受欢迎、市场动态以及价格趋势。以下是一个使用Python来分析NFT市场的案例,重点关注从OpenSea(一个流行的NFT市场)获取数据并分析它。

准备工作

在开始之前,确保安装了requests库来发起HTTP请求,以及pandas和matplotlib进行数据处理和可视化。

pip install requests pandas matplotlib

实现步骤

步骤1: 获取OpenSea市场数据

首先,我们将使用OpenSea提供的API来获取市场上的NFT交易数据。注意,这里使用的API和参数可能随OpenSea的更新而变化,请参考OpenSea documentation进行相应的调整。

import requests

import pandas as pd# OpenSea提供的API示例

url = "https://api.opensea.io/api/v1/assets"

query = {"order_direction": "desc","offset": 0,"limit": 50 # 获取的项目数量

}

response = requests.request("GET", url, params=query)

data = response.json()['assets']# 解析数据,这里仅提取我们感兴趣的几个字段

nft_data = []

for item in data:nft_info = {"name": item['name'],"collection": item['collection']['name'],"num_sales": item['num_sales'],"last_sale_price": float(item['last_sale']['total_price']) / (10 ** 18) if item['last_sale'] else None # 转换为ETH}nft_data.append(nft_info)df = pd.DataFrame(nft_data)

步骤2: 分析NFT交易数据

接下来,我们可以分析这些NFT数据,比如计算不同集合中NFT的平均销售价格。

# 计算每个集合NFT的平均销售价格

average_prices = df.groupby('collection')['last_sale_price'].mean()print("Average sale price per collection:")

print(average_prices.sort_values(ascending=False)) # 降序排列

步骤3: 可视化NFT市场数据

最后,我们将使用matplotlib库将NFT的平均销售价格可视化,以直观地展示不同集合的市场表现。

import matplotlib.pyplot as plt# 为了美观,这里仅展示前10个集合

top_collections = average_prices.sort_values(ascending=False).head(10)top_collections.plot(kind='bar', figsize=(12, 6))

plt.title('Average NFT Sale Price per Collection')

plt.xlabel('Collection')

plt.ylabel('Average Sale Price (ETH)')

plt.xticks(rotation=45)

plt.show()

结语

通过这个案例,你可以看到如何使用Python来获取和分析NFT市场的数据。NFT市场分析不仅可以帮助艺术家、收藏家和投资者做出更明智的决策,还能为开发者提供洞察,帮助他们设计和开发更受欢迎的NFT产品。随着NFT生态系统的不断发展,对这个市场的深入分析将变得越来越重要。

10.2 数据分析技术的新趋势

随着数据科学和机器学习技术的快速发展,数据分析领域正在经历前所未有的变革。这些新趋势不仅为我们提供了更深入的数据洞察,还大大扩展了数据分析的应用范围。下面,我们将探讨一些在数据分析技术中出现的新趋势,并通过Python实现示例来深入了解这些趋势。

10.2.1 基础知识

- 自动化机器学习(AutoML):旨在自动化机器学习模型的选择和调参过程,使数据科学家和开发者能够更高效地构建和部署模型。

- 自然语言处理(NLP):借助于深度学习技术的进步,NLP正在实现从文本生成、情感分析到语言翻译等一系列复杂任务。

- 图数据分析:随着复杂网络和社交网络数据的普及,图数据分析技术正在成为提供洞察力的关键工具。

10.2.2 重点案例:使用 AutoML 进行数据预测

自动化机器学习(AutoML)极大地简化了机器学习模型的选择、配置和优化过程,使得即使是没有深厚机器学习背景的人也能有效地利用机器学习技术。这里,我们将通过一个具体的Python示例,展示如何使用AutoML框架auto-sklearn进行数据预测。

准备工作

首先,确保安装了auto-sklearn库。由于auto-sklearn依赖于一系列的系统库,根据你的操作系统,可能需要额外的安装步骤。详细的安装指南可以在auto-sklearn的官方文档中找到。

pip install auto-sklearn

示例案例:预测心脏病发作的可能性

我们将使用auto-sklearn来训练一个模型,根据患者的医疗记录预测心脏病发作的可能性。

步骤1: 加载和准备数据

我们使用sklearn库中的fetch_openml函数加载公开的心脏病数据集。

from sklearn.datasets import fetch_openml

from sklearn.model_selection import train_test_split# 加载心脏病数据集

X, y = fetch_openml("heart", version=1, as_frame=True, return_X_y=True)# 将目标变量转换为二进制分类任务

y = (y == 'present').astype(int)# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

步骤2: 使用auto-sklearn训练模型

接下来,我们使用auto-sklearn自动训练一个分类模型。

import autosklearn.classification as autosklearn_cls# 创建一个auto-sklearn分类器

automl_classifier = autosklearn_cls.AutoSklearnClassifier(time_left_for_this_task=120, # 给自动化机器学习过程分配的总时间(秒)per_run_time_limit=30, # 每次模型训练的时间限制(秒)ensemble_size=1, # 使用单一模型而不是模型集成initial_configurations_via_metalearning=0, # 禁用基于元学习的初始配置

)# 训练模型

automl_classifier.fit(X_train, y_train)# 评估模型

accuracy = automl_classifier.score(X_test, y_test)

print(f"Model accuracy: {accuracy:.4f}")

步骤3: 分析模型结果

auto-sklearn提供了模型结果的详细分析功能,让我们能够理解哪些模型和配置被尝试过,以及它们的性能如何。

# 打印最佳模型的详细配置

print(automl_classifier.show_models())# 获取模型选择和训练过程的统计信息

print(automl_classifier.sprint_statistics())

结语

使用auto-sklearn进行自动化机器学习,我们能够快速地尝试多种模型和参数配置,从而找到最适合特定数据集的解决方案。这种方法不仅节省了大量的手动调参时间,而且还可以帮助我们发现意想不到的高效模型。随着AutoML技术的发展,将机器学习技术应用到实际问题中变得越来越容易,为更广泛的用户和场景打开了大门。

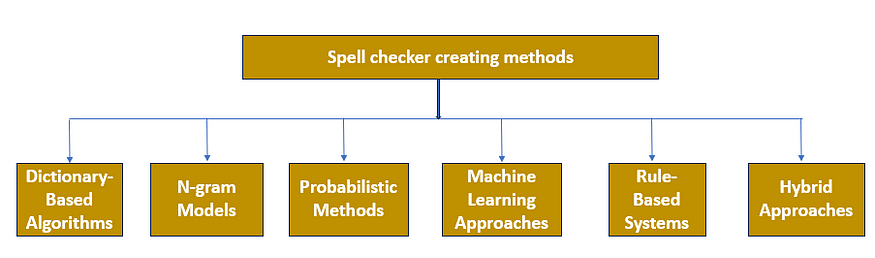

10.2.3 拓展案例 1:情感分析

情感分析是自然语言处理(NLP)的一个分支,它涉及到识别和分类文本数据中的情绪倾向,如正面、负面或中立。情感分析在社交媒体监控、品牌监测、客户服务等领域有广泛的应用。以下是一个使用Python进行情感分析的示例,我们将使用TextBlob库来分析特定文本的情绪倾向。

准备工作

在开始之前,请确保安装了textblob库。如果尚未安装,可以通过以下命令安装:

pip install textblob

python -m textblob.download_corpora

textblob库是基于NLTK库构建的,提供了简单易用的API进行文本处理,包括情感分析。

示例案例:社交媒体帖子的情感分析

假设我们从社交媒体平台上收集了一些用户对某个产品的评论,我们想要分析这些评论的整体情绪倾向。

步骤1: 准备数据

首先,我们模拟一些社交媒体上的用户评论。

comments = ["I absolutely love this product! It has changed my life.","This is the worst thing I have ever bought. Totally useless.","Meh, it was okay, nothing special though.","OMG! This is amazing, would definitely recommend to my friends!","Not bad, but I think it's a bit overpriced for what you get."

]

步骤2: 进行情感分析

接下来,我们使用TextBlob对这些评论进行情感分析。TextBlob的情感分析方法返回两个属性:极性(polarity)和主观性(subjectivity)。极性范围从-1(非常负面)到1(非常正面),主观性范围从0(非常客观)到1(非常主观)。

from textblob import TextBlob# 分析每条评论的情感

for comment in comments:blob = TextBlob(comment)sentiment = blob.sentimentprint(f"Comment: {comment}")print(f"Sentiment: Polarity={sentiment.polarity:.2f}, Subjectivity={sentiment.subjectivity:.2f}\n")

步骤3: 汇总和解释结果

最后,我们基于分析结果对评论的整体情绪倾向进行总结。

# 计算平均极性

average_polarity = sum([TextBlob(comment).sentiment.polarity for comment in comments]) / len(comments)

overall_sentiment = "positive" if average_polarity > 0 else "negative" if average_polarity < 0 else "neutral"

print(f"Overall sentiment is {overall_sentiment} with an average polarity of {average_polarity:.2f}")

结语

通过这个简单的情感分析示例,我们可以看到如何快速地对文本数据进行情绪倾向的分析。虽然TextBlob提供的情感分析功能是基于预训练模型的,并且相对基础,但它对于快速原型开发或初步数据探索非常有用。对于需要更精细或定制化情感分析的场景,可能需要使用更高级的NLP工具和技术,例如基于深度学习的模型。

10.2.4 拓展案例 2:图数据分析

图数据分析是一种强大的工具,用于探索和理解复杂的关系网络。它在社交网络分析、推荐系统、生物信息学等领域有广泛的应用。以下是一个使用Python和NetworkX库进行图数据分析的示例,我们将构建一个简单的社交网络图,并分析网络中的关键节点(即中心性分析)。

准备工作

在开始之前,请确保安装了networkx和matplotlib库来进行图的创建和可视化。如果尚未安装,可以通过以下命令安装:

pip install networkx matplotlib

示例案例:社交网络中的中心性分析

假设我们有一个小型社交网络,我们想要找出网络中最具影响力的个体。

步骤1: 构建图

首先,我们使用NetworkX构建社交网络图。在这个网络中,节点代表个体,边代表个体之间的关系。

import networkx as nx# 创建一个无向图

G = nx.Graph()# 添加节点

G.add_nodes_from(["Alice", "Bob", "Claire", "Dennis", "Eva", "Frank"])# 添加边

G.add_edges_from([("Alice", "Bob"),("Alice", "Claire"),("Bob", "Dennis"),("Claire", "Dennis"),("Claire", "Eva"),("Dennis", "Eva"),("Dennis", "Frank"),("Eva", "Frank")

])# 可视化图

import matplotlib.pyplot as pltplt.figure(figsize=(8, 5))

nx.draw(G, with_labels=True, node_color='skyblue', node_size=700, font_size=20, font_weight='bold')

plt.title("Social Network")

plt.show()

步骤2: 中心性分析

中心性分析帮助我们理解哪些节点在网络中占据核心地位。我们将计算两种常见的中心性指标:度中心性(Degree Centrality)和接近中心性(Closeness Centrality)。

# 度中心性

degree_centrality = nx.degree_centrality(G)

print("Degree Centrality:")

for node, centrality in degree_centrality.items():print(f"{node}: {centrality:.2f}")# 接近中心性

closeness_centrality = nx.closeness_centrality(G)

print("\nCloseness Centrality:")

for node, centrality in closeness_centrality.items():print(f"{node}: {centrality:.2f}")

步骤3: 解释结果

- 度中心性度量了一个节点与其他节点之间直接连接的程度。在社交网络中,拥有更多直接联系的个体可能具有更高的影响力。

- 接近中心性反映了一个节点到网络中所有其他节点的平均距离。在社交网络中,能够更快地与其他成员联系的个体可能更具影响力。

结语

通过这个图数据分析的简单示例,我们可以看到如何使用NetworkX库来构建和分析社交网络图。中心性分析帮助我们识别出网络中的关键节点,这对于理解社交动态、优化信息传播等方面非常有用。随着网络的增大和复杂度的提升,我们可以进一步探索其他图分析技术,如社区检测、路径分析等,以获得更深入的洞察。

10.3 应对未来挑战的策略

随着技术的快速发展,我们面临着越来越多的挑战,从数据隐私和安全问题到技术的快速迭代和人才短缺。然而,通过采取一些策略,我们可以更好地准备自己来应对这些挑战,并充分利用新技术带来的机遇。

10.3.1 基础知识

- 持续学习:技术领域的知识和技能迅速变化,持续学习是保持竞争力的关键。

- 合作与共享:通过与他人合作和分享知识,我们可以共同克服挑战,加速解决问题的过程。

- 灵活适应:在不断变化的技术环境中,保持开放和灵活的心态,适应新技术和新趋势。

10.3.2 重点案例:利用 Python 进行持续学习

持续学习是适应快速发展的技术领域的关键。Python,作为一个功能强大且社区支持丰富的编程语言,为我们提供了无限的学习资源。这里,我们将通过一个实际的Python示例,展示如何使用在线资源来学习Python编程和数据科学的基础。

准备工作

确保你的环境中已经安装了Python。接下来,我们将利用Jupyter Notebook,这是一个开源的Web应用程序,允许你创建和共享包含实时代码、方程、可视化以及文本的文档。

安装Jupyter Notebook:

pip install notebook

运行Jupyter Notebook:

jupyter notebook

示例案例:探索数据集

我们将使用Python的pandas库来探索一个数据集。pandas是一个强大的数据分析和操作库,非常适合于数据清洗、分析和可视化。

步骤1: 加载数据集

假设我们关注的是著名的鸢尾花数据集,这个数据集经常被用来入门机器学习。我们将使用pandas来加载和查看这个数据集。

import pandas as pd

from sklearn.datasets import load_iris# 加载鸢尾花数据集

iris = load_iris()

iris_df = pd.DataFrame(data=iris.data, columns=iris.feature_names)# 显示前五行数据

print(iris_df.head())

步骤2: 数据可视化

接下来,我们利用matplotlib和seaborn库对数据集进行可视化,以便更好地理解数据分布。

import seaborn as sns

import matplotlib.pyplot as plt# 将目标变量添加到DataFrame中

iris_df['species'] = iris.target# 数据可视化:鸢尾花种类的花瓣长度和宽度分布

sns.scatterplot(data=iris_df, x="petal length (cm)", y="petal width (cm)", hue="species", style="species", palette="deep")

plt.title("Iris Species by Petal Size")

plt.show()

步骤3: 探索性数据分析(EDA)

我们将进行一些基本的探索性数据分析,以便更深入地了解数据集的特征。

# 基本统计数据

print(iris_df.describe())# 检查种类分布

print(iris_df['species'].value_counts())

结语

通过这个简单的示例,你可以看到如何使用Python和几个强大的库来开始数据科学之旅。Jupyter Notebook提供了一个互动环境,可以边学习边实践,从而更好地理解概念。而pandas、matplotlib和seaborn等库是数据分析不可或缺的工具。持续学习不仅仅是关于掌握新技术,更是一个不断探索、实验和增长的过程。通过利用Python丰富的学习资源,你可以不断地提升自己的技能,并保持与技术发展的同步。

10.3.3 拓展案例 1:在线合作项目

在线合作项目,尤其是参与开源项目,是提升技术技能、学习新工具和框架、以及与全球社区互动的绝佳方式。通过贡献代码、文档、或解决问题,你不仅能帮助项目成长,还能加深对技术的理解。以下是如何参与GitHub上的开源项目的步骤,虽然这个过程中不会直接使用Python代码,但我们将讨论如何使用Python技能来贡献开源项目。

准备工作

确保你有一个GitHub账户,并安装了Git。如果你打算贡献代码,熟悉基本的Git操作(如克隆仓库、创建分支、提交更改和推送分支)是必要的。

步骤1: 找到感兴趣的项目

GitHub是世界上最大的开源社区,你可以在这里找到数以万计的项目,涵盖各种技术栈和领域。

- 使用GitHub搜索:你可以使用GitHub的搜索功能,根据你的兴趣和技术栈来查找项目。

- 探索“Trending”页面:GitHub的Trending页面展示了当前热门的项目,是发现新和有趣项目的好地方。

- 参与Hacktoberfest:Hacktoberfest是DigitalOcean每年举办的一个月度开源贡献活动,参与活动的项目通常欢迎新手贡献。

步骤2: 理解项目和准备贡献

在你决定贡献某个项目之前,仔细阅读项目的README、贡献指南和代码行为准则。

- 克隆仓库:将项目克隆到本地,这样你就可以开始在本地进行工作。

- 创建一个分支:基于最新的主分支创建一个新分支进行你的工作。

- 了解项目需求:查看项目的Issues列表,找到你可以帮助解决的问题。许多项目会有“good first issue”标签来标识适合新贡献者的问题。

示例:为Python项目贡献文档

假设你找到了一个Python库,该库缺乏足够的使用示例或文档,而你恰好对此有所了解,可以贡献自己的知识来帮助改进项目。

- 克隆仓库:

git clone <repository-url>

- 创建新分支:

git checkout -b add-documentation

- 添加或改进文档:在适当的位置,添加使用示例或对现有文档进行改进。

- 提交更改:

git add .

git commit -m "Add documentation for <feature>"

- 推送分支并创建Pull Request:将你的分支推送到GitHub,并在项目页面上创建一个Pull Request(PR),等待项目维护者的审查。

结语

参与在线合作项目,特别是开源项目,不仅能提升你的技术能力,还能帮助你建立一个强大的职业网络。通过为开源社区贡献代码或文档,你将加深对技术的理解,并为自己的职业生涯增添宝贵的经验。记住,每一次贡献,无论大小,都是对开源社区宝贵的贡献。

10.3.4 拓展案例 2:适应新技术趋势

随着技术的快速发展,适应新技术趋势对于保持个人或组织的竞争力至关重要。Python,作为一种广泛应用于数据科学、机器学习、网络开发和自动化的语言,提供了一个极好的平台来学习和适应新兴技术。以下是如何使用Python来探索和适应两个新技术趋势:自然语言处理(NLP)和区块链技术。

自然语言处理(NLP)

自然语言处理(NLP)技术的进步使得机器能够理解、解释和生成人类语言,为聊天机器人、情感分析、自动翻译等应用提供了基础。

示例:使用Transformers库进行文本情感分析

transformers库是Hugging Face团队开发的一个Python库,提供了预训练的模型来处理文本任务,如分类、翻译、生成等。

- 安装

transformers库:

pip install transformers

- 使用预训练的BERT模型进行文本情感分析:

from transformers import pipeline# 初始化情感分析管道

sentiment_pipeline = pipeline('sentiment-analysis')# 分析文本情感

results = sentiment_pipeline(["I love coding in Python. It's awesome!","I hate bugs in my code."])for result in results:print(f"Text: {result['label']} with confidence {result['score']:.4f}")

区块链技术

区块链技术通过提供去中心化的数据存储解决方案,为加密货币、智能合约、去中心化应用(DApps)等开辟了新天地。

示例:使用Web3.py与以太坊智能合约交云

web3.py是一个Python库,允许你与以太坊区块链交云,包括读取账户余额、发送交易和与智能合约交云。

- 安装

web3.py库:

pip install web3

- 与以太坊智能合约交云:

from web3 import Web3# 连接到以太坊节点

w3 = Web3(Web3.HTTPProvider('https://mainnet.infura.io/v3/your_project_id'))# 检查连接

if w3.isConnected():print("Connected to Ethereum blockchain")

else:print("Failed to connect")# 读取账户余额

account = "0xYourEthereumAddress"

balance = w3.eth.get_balance(account)

print(f"Balance: {w3.fromWei(balance, 'ether')} ETH")

结语

通过学习和实践新兴技术,你不仅能够增强自己的技能集,还能为未来的职业发展打下坚实的基础。Python作为一种功能强大、社区支持丰富的语言,为适应新技术趋势提供了无数的资源和机会。无论是自然语言处理还是区块链技术,通过不断的学习和实践,你将能够掌握这些技术,并在未来的技术浪潮中保持领先。