原文地址:ActiveRAG — Active Learning

2024 年 2 月 26 日

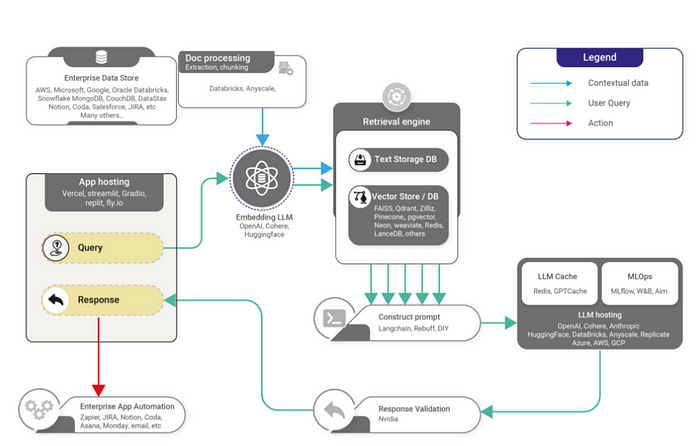

大型语言模型(LLM)的出现开创了对话式人工智能的新时代。这些模型可以生成非常类似人类的文本,并且比以往更好地进行对话。然而,他们仍然面临着仅仅依靠预先训练的知识的局限性。为了提高推理能力和准确性,LLMs需要具备整合外部知识的能力。

检索增强生成(RAG)已成为一种利用外部资源知识增强LLMs的解决方案。RAG 将提取相关知识段落的检索器模块与神经生成器结合起来,根据检索到的上下文生成答案。这允许将事实、概念和关系纳入LLMs固有知识之外。尽管做出了这样的承诺,RAG 仍面临着影响整体答案质量的挑战。

ActiveRAG,它是 RAG 框架的增强版,旨在应对这些挑战。我们将讨论 ActiveRAG 的动机、方法和结果。通过积极构建知识并将其紧密集成到LLMs自身的认知中,与标准 RAG 相比,ActiveRAG 实现了卓越的准确性和解释连贯性。

主动知识构建的必要性

标准 RAG 的一个关键限制是其集成外部知识的被动方法。检索器模块提取潜在相关的段落,这些段落与输入查询连接起来。然后,这种上下文混合会影响LLMs生成答案。

然而,仅仅提供额外的背景并不能确保与LLMs内在知识的紧密结合。该模型将检索到的段落视为松散的事实参考,而不是主动理解和缝合在一起的知识。这体现在几个方面:

- 知识噪声:检索到的段落经常包含对于回答特定查询无用的无关事实或关系。这提高了LLMs的信噪比,而嘈杂的不相关知识会损害答案质量。

- 知识脱节:即使与查询相关的上下文也常常缺乏与LLMs现有知识和认知的连贯联系。如果没有明确的联系,整合就会感觉脱节,而不是统一的解释流程。

- 被动持有:由于对检索到的知识的理解最少,LLMs被动地持有上下文,没有更全面的评估或与自己的知识库进行协调。结果是支离破碎的,而不是混合的理解。

此外,RAG 的被动方法忽视了建构主义的关键原则,建构主义是一种学习理论,认为知识是由学习者主动构建的,而不是被动接受的。人类通过将新信息与现有结构联系起来、建立新的心智模型、通过矛盾进行推理以及调和冲突来构建知识。RAG 放弃了这些对于深度理解至关重要的结构。

ActiveRAG 简介

为了弥补这些差距,ActiveRAG 是对 RAG 的增强,将主动知识构建融入其中。主要原则是:

- 知识是主动积累的,而不是被动持有的

- 将外部知识紧密整合到LLMs的内在认知中

- 通过评估周期协调和完善知识

基于这些原则,ActiveRAG 实现了一个三阶段管道,包括检索、知识构建和答案生成。

知识检索

与 RAG 一样,第一阶段使用密集向量相似度检索查询的潜在相关段落。关键区别在于检索较小的知识“块”(1-3 个句子)而不是较长的段落。这可以过滤噪音并增强检索到的上下文的相关性。

知识建构

第二阶段使用检索到的块主动构建知识。四个子组件制定了独特的建构主义功能:

- 语义关联——根据语义相关性将检索到的知识块与现有知识结构连接起来。这会在现有的认知框架内吸收新信息。

- 认知锚定——如果检索到的信息与现有知识的语义相关性较低,则建立新的知识参考框架。这扩大了认知边界。

- 逻辑推理——通过从检索到的内容中得出结论来推断新知识。这构建了解决问题的逻辑链。

- 认知一致性——识别检索到的块与现有知识之间的冲突。然后它执行解析以加深理解。这可以调和矛盾。

这些组成部分共同模仿了人类的建构主义:将新知识与旧知识联系起来,形成新的心理模型,通过问题进行逻辑推理,并协调冲突的信息。

认知关系

最后阶段将构建的知识整合回LLMs的内在认知中。首先,LLMs根据现有知识生成查询的初始思维流程。接下来,构建的外部知识被动态地注入到这个思维流中以完善理解。

我们将其称为“认知联系”——外部来源的建构知识与LLMs的固有认知的交集。标准 RAG 中不存在这种紧密集成,其知识脱节。

结果

与基线 RAG 相比,在一系列问答任务上评估了 ActiveRAG。一些关键结果:

- ActiveRAG 通过减少知识噪声和增强推理,将答案准确性比 RAG 提高了约 5%。

- ActiveRAG 的解释连贯性评级较高,表明检索到的知识与内在认知之间的集成更加紧密。

- 由于额外的知识构建,延迟增加了约 15%,但抵消了更高的准确性增益。

在LLMs的认知过程中积极构建和吸收知识可以带来更精确的答案和统一的解释流程。

局限性和未来的工作

虽然 ActiveRAG 前景广阔,但在未来的工作中仍存在一些需要解决的局限性:

- 多级管道增加了延迟,因为知识构建比标准 RAG 增加了 2-3 倍的计算量。这可以通过模型蒸馏和优化来缓解。

- 构建知识需要多次查询 LLM,从而增加了成本。缓存构建的知识有助于最大限度地减少冗余生成。

- 在模仿人类的知识构建方面仍然存在差距,例如类比、从示例中学习以及分层构建知识。

未来的工作可以增强ActiveRAG的建构功能,以进一步缩小与人类认知的差距。此外,构建组件和核心LLMs之间更紧密的耦合可以增强流动性。

ActiveRAG 以其主动的方法证明,仅仅检索知识是不够的。在LLMs的内在认知中构建、协调和积极整合知识可以带来更准确和连贯的结果。虽然要达到人类水平的理解力还有很多工作要做,但 ActiveRAG 为解锁隐藏在外部知识资源中的宝藏迈出了宝贵的一步。

结论

最后,标准 RAG 为利用外部知识增强LLMs提供了一个有用但不完整的解决方案。它的被动方式导致了理解的碎片化。ActiveRAG 引入主动知识构建和集成来解决这些差距。通过将构建的知识与内在认知紧密联系起来,ActiveRAG 实现了卓越的准确性和解释连贯性。

在神经网络中模拟人类建构主义学习仍有待探索的前沿。但ActiveRAG 提供了一个前进的学习蓝图——它不把知识视为静态的外部资产,而是将其视为一种有生命力的力量,可以被构建、塑造和编织成理解系统。有了这种积极的精神,人类知识中的宝藏不仅变得更容易获得,而且成为触及认知本身本质的丰富源泉。