【LangChain学习之旅】—(12) 代理(上):ReAct框架,推理与行动的协同

- 代理的作用

- ReAct 框架

- 通过代理实现 ReAct 框架

- 总结时刻

之前介绍的思维链(CoT)展示了 LLMs 执行推理轨迹的能力。在给出答案之前,大模型通过中间推理步骤(尤其是与少样本提示相结合)能够实现复杂的推理,获得更好的结果,以完成更具挑战的任务。

然而,仅仅应用思维链推理并不能解决大模型的固有问题:无法主动更新自己的知识,导致出现事实幻觉。也就是说,因为缺乏和外部世界的接触,大模型只拥有训练时见过的知识,以及提示信息中作为上下文提供的附加知识。如果你问的问题超出它的知识范围,要么大模型向你坦白:“我的训练时间截至 XXXX 年 XX 月 XX 日”,要么它就会开始一本正经地胡说。

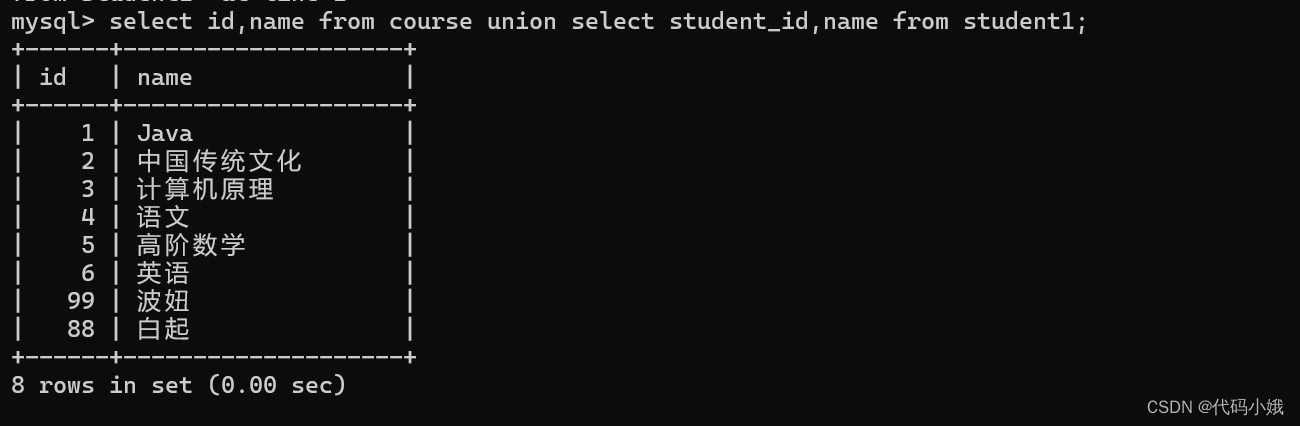

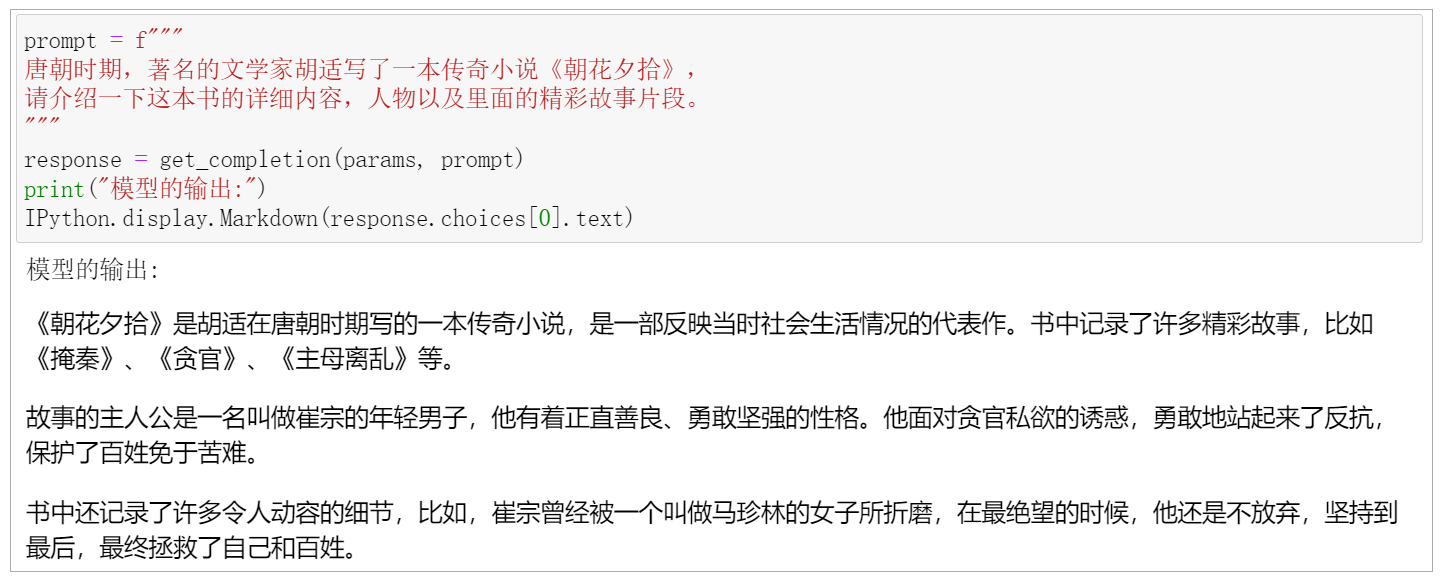

下面这张图就属于第二种情况,我制作的一个 Prompt 骗过了大模型,它会误以为我引述的很多虚构的东西是事实,而且它还会顺着这个思路继续胡编乱造。

这个问题如何解决呢?