目录

ELK Kiabana 部署(在 Node1 节点上操作)

1.安装 Kiabana

2.设置 Kibana 的主配置文件

3.启动 Kibana 服务

4.验证 Kibana

5.将 Apache 服务器的日志(访问的、错误的)

添加Elasticsearch 并通过 Kibana 显示

Filebeat+ELK 部署

在 filebeat 节点上操作

2.设置 filebeat 的主配置文件

#启动 filebeat

4.在 Logstash 组件所在节点上新建一个 Logstash 配置文件

ELK Kiabana 部署(在 Node1 节点上操作)

1.安装 Kiabana

#上传软件包 kibana-5.5.1-x86_64.rpm 到/opt目录

[root@node1 ~]# cd /opt/

[root@node1 opt]# rpm -ivh kibana-5.5.1-x86_64.rpm2.设置 Kibana 的主配置文件

vim /etc/kibana/kibana.yml

--2--取消注释,Kiabana 服务的默认监听端口为5601

server.port: 5601

--7--取消注释,设置 Kiabana 的监听地址,0.0.0.0代表所有地址

server.host: "0.0.0.0"

--21--取消注释,设置和 Elasticsearch 建立连接的地址和端口

elasticsearch.url: "http://192.168.10.13:9200"

--30--取消注释,设置在 elasticsearch 中添加.kibana索引

kibana.index: ".kibana"3.启动 Kibana 服务

systemctl start kibana.service

systemctl enable kibana.service[root@node1 opt]# netstat -natp | grep 5601

tcp 0 0 0.0.0.0:5601 0.0.0.0:* LISTEN 100617/node

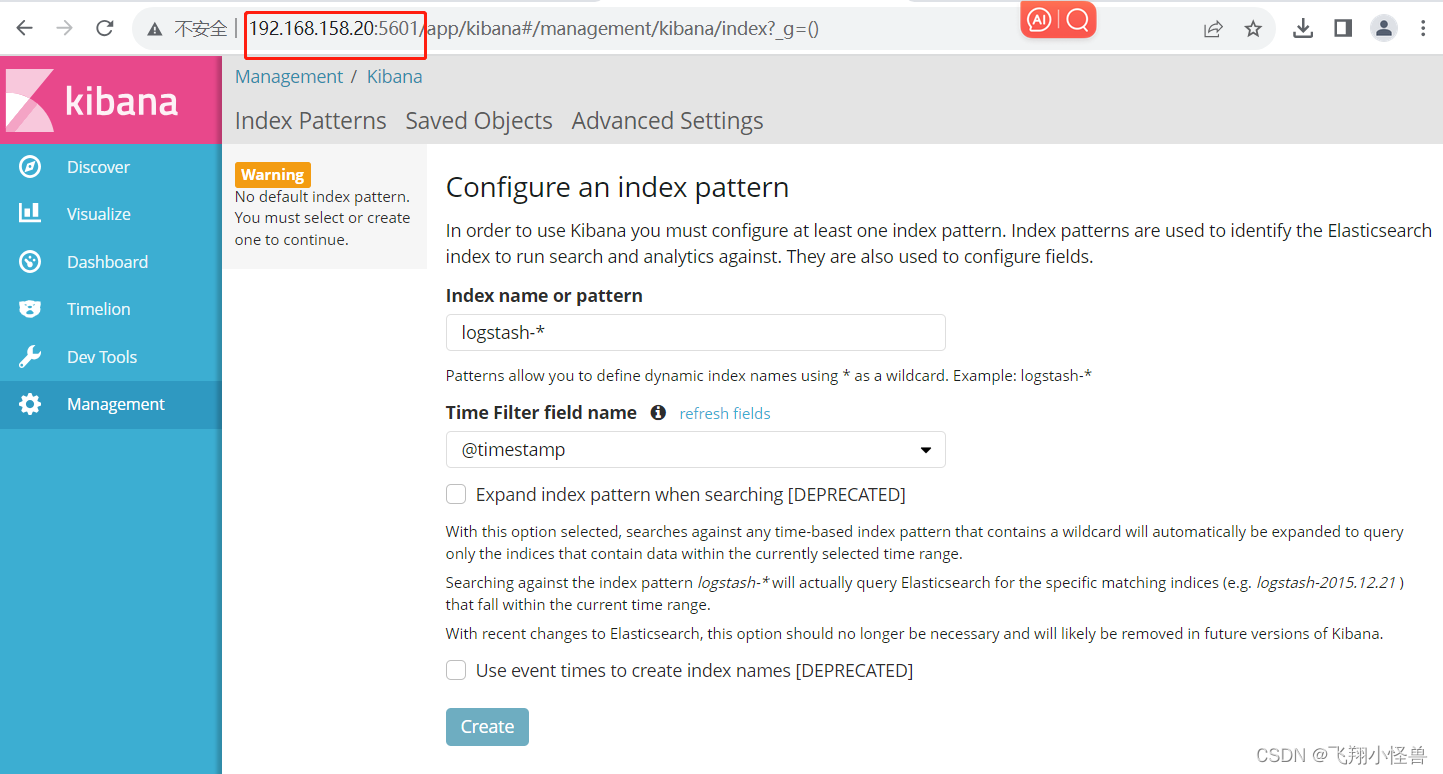

4.验证 Kibana

浏览器访问 http://192.168.158.20:5601

第一次登录需要添加一个 Elasticsearch 索引:

Index name or pattern

//输入:system-* #在索引名中输入之前配置的 Output 前缀“system”单击 “create” 按钮创建,单击 “Discover” 按钮可查看图表信息及日志信息。

数据展示可以分类显示,在“Available Fields”中的“host”,然后单击 “add”按钮,可以看到按照“host”筛选后的结果

5.将 Apache 服务器的日志(访问的、错误的)

添加Elasticsearch 并通过 Kibana 显示

[root@apache ~]# vim /etc/logstash/conf.d/apache_log.conf

input {file{path => "/etc/httpd/logs/access_log"type => "access"start_position => "beginning"}file{path => "/etc/httpd/logs/error_log"type => "error"start_position => "beginning"}

}

output {if [type] == "access" {elasticsearch {hosts => ["192.168.158.20:9200"]index => "apache_access-%{+YYYY.MM.dd}"}}if [type] == "error" {elasticsearch {hosts => ["192.168.158.20:9200"]index => "apache_error-%{+YYYY.MM.dd}"}}

}[root@apache ~]# cd /etc/logstash/conf.d/#启动文件

[root@apache conf.d]# }/usr/share/logstash/bin/logstash -f apache_log.conf浏览器访问 http://192.168.158.20:9100 查看索引是否创建

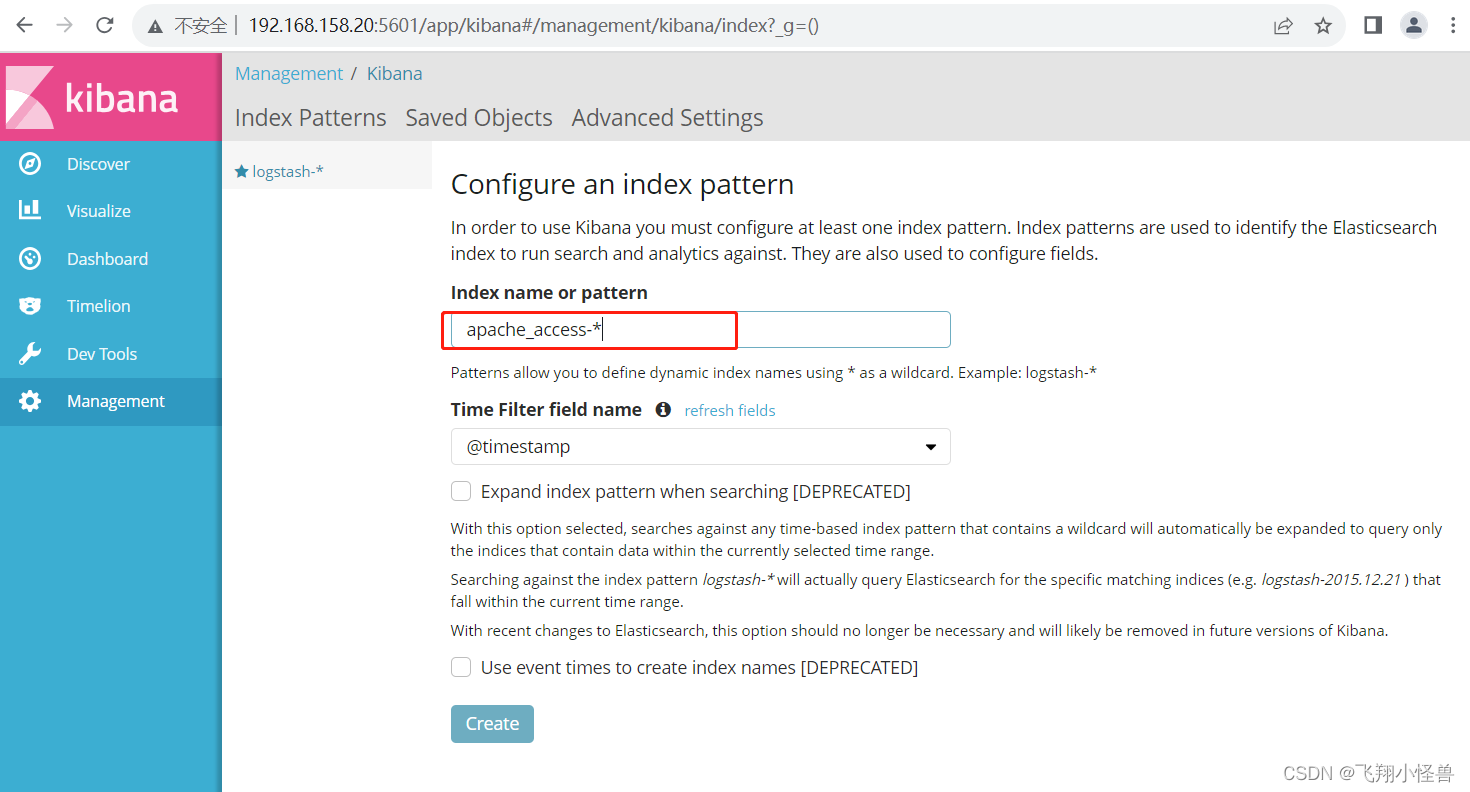

浏览器访问 http://192.168.158.20:5601 登录 Kibana,单击“Create Index Pattern”按钮添加索引, 在索引名中输入之前配置的 Output 前缀 apache_access-*,并单击“Create”按钮。在用相同的方法添加 apache_error-*索引。

选择“Discover”选项卡,在中间下拉列表中选择刚添加的 apache_access-* 、apache_error-* 索引, 可以查看相应的图表及日志信息。

Filebeat+ELK 部署

Node1节点(2C/4G):node1/192.168.158.20 Elasticsearch Kibana

Node2节点(2C/4G):node2/192.168.158.21 Elasticsearch

Apache节点:apache/192.168.158.22 Logstash Apache

Filebeat节点:filebeat/192.168.158.23 Filebeat

[root@node4 ~]# systemctl stop firewalld #关闭防火墙

[root@node4 ~]# setenforce 0

[root@node4 ~]# hostnamectl set-hostname filebeat #改名

[root@node4 ~]# bash在 filebeat 节点上操作

1.安装 Filebeat

#上传软件包 filebeat-6.2.4-linux-x86_64.tar.gz 到/opt目录

[root@filebeat opt]# tar zxvf filebeat-6.2.4-linux-x86_64.tar.gz

[root@filebeat opt]# mv filebeat-6.2.4-linux-x86_64/ /usr/local/filebeat

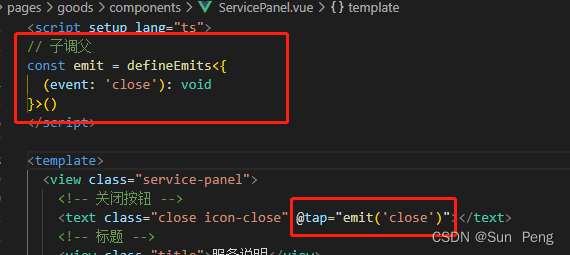

2.设置 filebeat 的主配置文件

[root@filebeat opt]# cd /usr/local/filebeat/vim filebeat.yml

filebeat.prospectors:

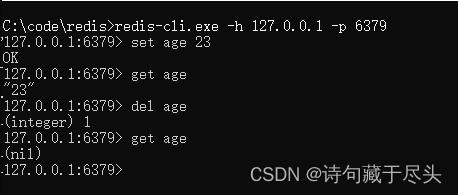

- type: log #指定 log 类型,从日志文件中读取消息enabled: truepaths:- /var/log/messages #指定监控的日志文件- /var/log/*.logfields: #可以使用 fields 配置选项设置一些参数字段添加到 output 中service_name: filebeatlog_type: logservice_id: 192.168.10.16--------------Elasticsearch output-------------------

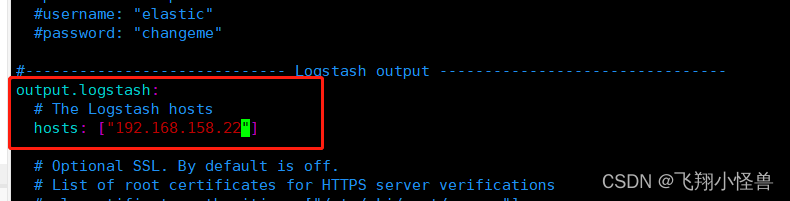

(全部注释掉)----------------Logstash output---------------------

output.logstash:hosts: ["192.168.10.15:5044"] #指定 logstash 的 IP 和端口#启动 filebeat

./filebeat -e -c filebeat.yml

#启动 filebeat

[root@filebeat filebeat]# ./filebeat -e -c filebeat.yml

4.在 Logstash 组件所在节点上新建一个 Logstash 配置文件

[root@apache conf.d]# vim logstash.confddvim logstash.conf

input {beats {port => "5044"}

}

output {elasticsearch {hosts => ["192.168.158.20:9200"]index => "%{[fields][service_name]}-%{+YYYY.MM.dd}"}stdout {codec => rubydebug}

}#启动 logstash

logstash -f logstash.conf

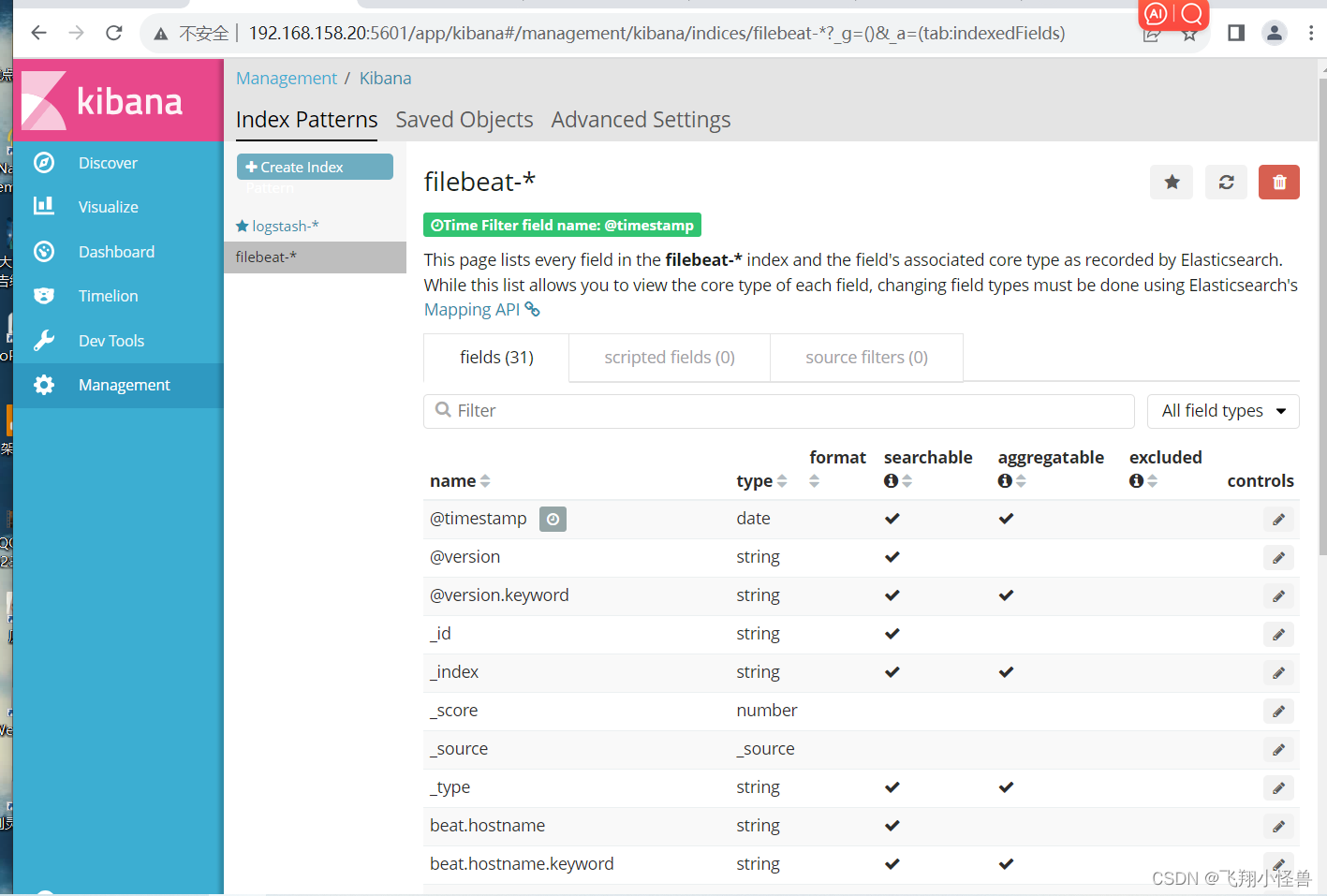

5.浏览器访问 http://192.168.10.13:5601 登录 Kibana,单击“Create Index Pattern”按钮添加索引“filebeat-*”,单击 “create” 按钮创建,单击 “Discover” 按钮可查看图表信息及日志信息。