一、基础作业

1.1 环境安装

# 如果你是在 InternStudio 平台,则从本地 clone 一个已有 pytorch 的环境: # pytorch 2.0.1 py3.10_cuda11.7_cudnn8.5.0_0 studio-conda xtuner0.1.17# 激活环境 conda activate xtuner0.1.17 # 进入home目录 cd ~ # 创建版本文件夹并进入,以跟随本教程 mkdir -p /root/xtuner0117 && cd /root/xtuner0117# 拉取 0.1.17 的版本源码 git clone -b v0.1.17 https://github.com/InternLM/xtuner # 无法访问github的用户请从 gitee 拉取: # git clone -b v0.1.15 https://gitee.com/Internlm/xtuner# 进入源码目录 cd /root/xtuner0117/xtuner# 从源码安装 XTuner pip install -e '.[all]'

1.2 前期准备

1.2.1 数据集准备

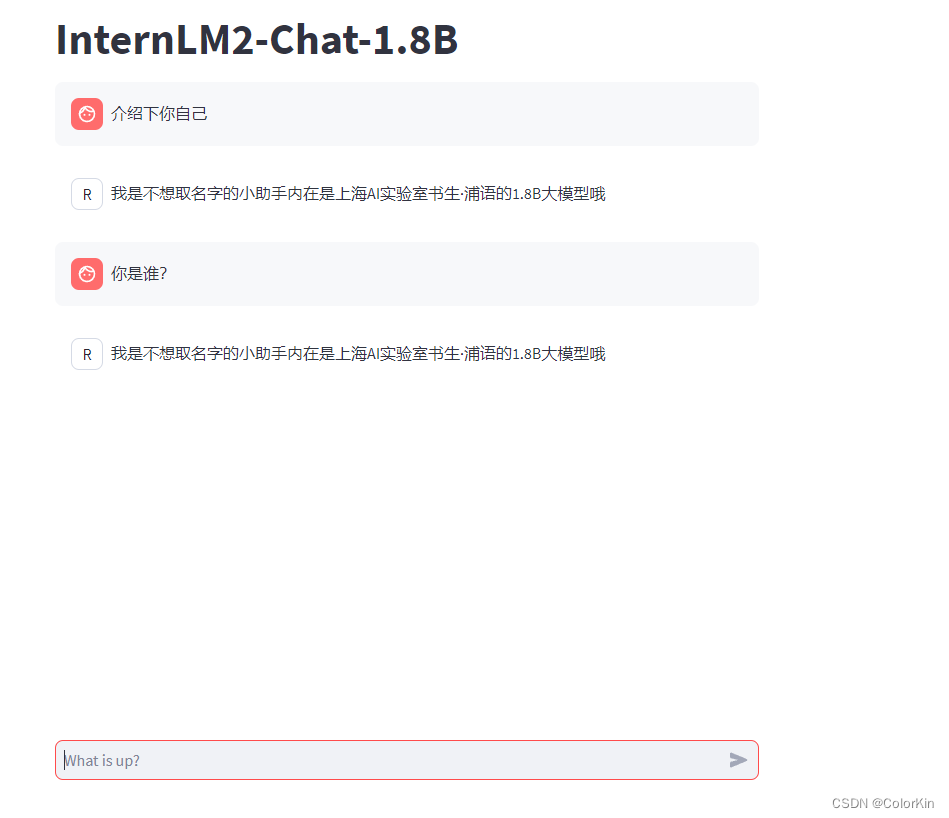

为了让模型能够让模型认清自己的身份弟位,知道在询问自己是谁的时候回复成我们想要的样子,我们就需要通过在微调数据集中大量掺杂这部分的数据。

首先我们先创建一个文件夹来存放我们这次训练所需要的所有文件。

# 前半部分是创建一个文件夹,后半部分是进入该文件夹。 mkdir -p /root/ft && cd /root/ft# 在ft这个文件夹里再创建一个存放数据的data文件夹 mkdir -p /root/ft/data && cd /root/ft/data

之后我们可以在 data 目录下新建一个 generate_data.py 文件,将以下代码复制进去,然后运行该脚本即可生成数据集。假如想要加大剂量让他能够完完全全认识到你的身份,那我们可以吧 n 的值调大一点。

# 创建 `generate_data.py` 文件 touch /root/ft/data/generate_data.py

打开该 python 文件后将下面的内容复制进去。

import json

# 设置用户的名字

name = '不要姜葱蒜大佬'

# 设置需要重复添加的数据次数

n = 10000# 初始化OpenAI格式的数据结构

data = [

{

"messages": [

{

"role": "user",

"content": "请做一下自我介绍"

},

{

"role": "assistant",

"content": "我是{}的小助手,内在是上海AI实验室书生·浦语的1.8B大模型哦".format(name)

}

]

}

]# 通过循环,将初始化的对话数据重复添加到data列表中

for i in range(n):

data.append(data[0])# 将data列表中的数据写入到一个名为'personal_assistant.json'的文件中

with open('personal_assistant.json', 'w', encoding='utf-8') as f:

# 使用json.dump方法将数据以JSON格式写入文件

# ensure_ascii=False 确保中文字符正常显示

# indent=4 使得文件内容格式化,便于阅读

json.dump(data, f, ensure_ascii=False, indent=4)

cd /root/ft/data

# 运行代码

python /root/ft/data/generate_data.py

1.2.2 模型准备

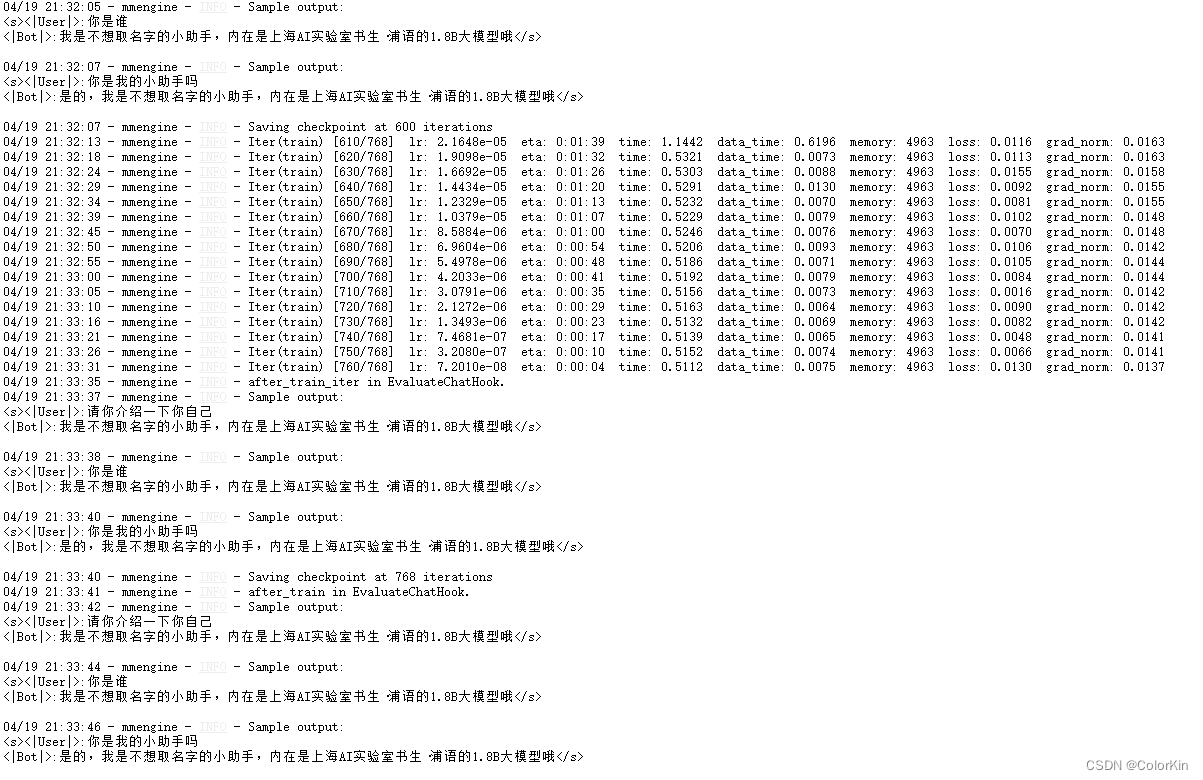

1.4 模型训练

1.4.1 常规训练

1.4.2 使用 deepspeed 来加速训练

二、进阶作业

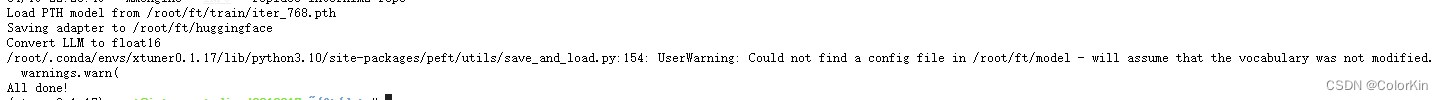

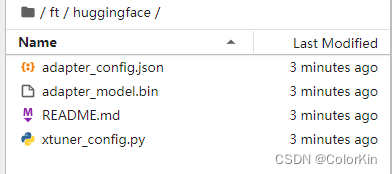

2.1 模型转换

# 创建一个保存转换后 Huggingface 格式的文件夹

mkdir -p /root/ft/huggingface# 模型转换

# xtuner convert pth_to_hf ${配置文件地址} ${权重文件地址} ${转换后模型保存地址}

xtuner convert pth_to_hf /root/ft/train/internlm2_1_8b_qlora_alpaca_e3_copy.py /root/ft/train/iter_768.pth /root/ft/huggingface

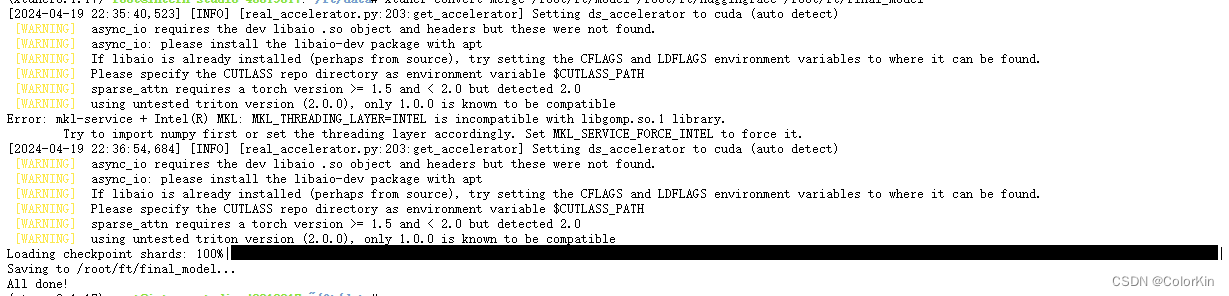

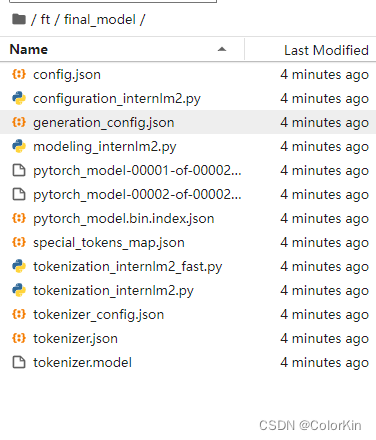

2.2 模型整合

# 创建一个名为 final_model 的文件夹存储整合后的模型文件

mkdir -p /root/ft/final_model# 解决一下线程冲突的 Bug

export MKL_SERVICE_FORCE_INTEL=1# 进行模型整合

# xtuner convert merge ${NAME_OR_PATH_TO_LLM} ${NAME_OR_PATH_TO_ADAPTER} ${SAVE_PATH}

xtuner convert merge /root/ft/model /root/ft/huggingface /root/ft/final_model

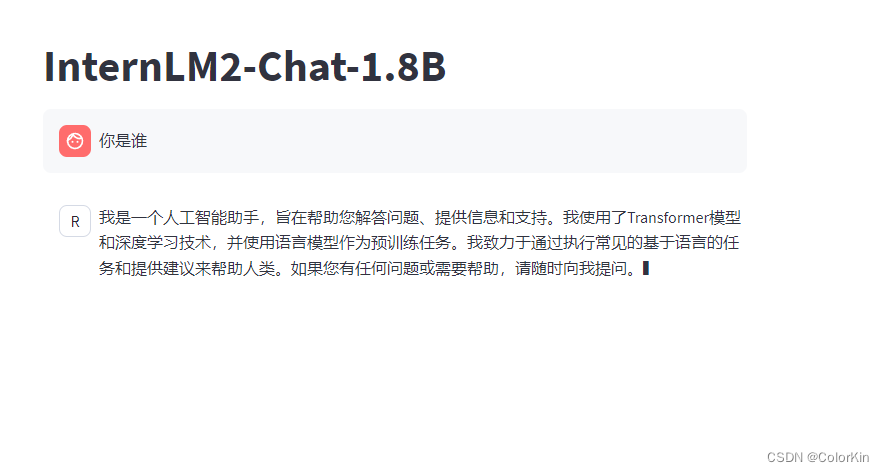

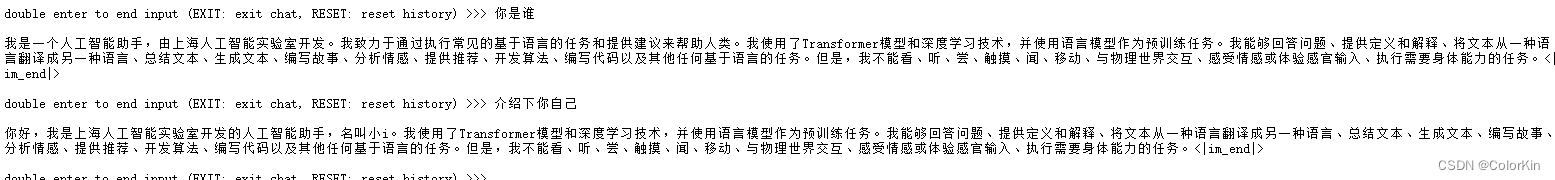

2.3 对话测试

# 与模型进行对话

xtuner chat /root/ft/final_model --prompt-template internlm2_chat

2.4 原模型对话对比

# 同样的我们也可以和原模型进行对话进行对比

xtuner chat /root/ft/model --prompt-template internlm2_chat

2.5 Web demo 部署