GPT-4o模型基于来自互联网的大量数据进行训练,更擅长处理文本和音频,并且支持50种语言。更值得一提的是,GPT-4o最快可以在232毫秒的时间内响应音频输入,几乎达到了人类的响应水平。

GPT-4o有多“炸裂”?核心能力有三

GPT-4o中的“o”代表“omni”,意为“全能”。OpenAI官网介绍称,GPT-4o向更自然的人机交互迈进了一步,因为它接受文本、音频和图像的任意组合作为输入内容,并生成文本、音频和图像的任意组合输出内容。

那GPT-4o到底有多强,有哪些核心能力呢?

能力一:“实时”互动,表达富有情感,视觉功能更强

OpenAI表示,GPT-4o显著提升了AI聊天机器人ChatGPT的使用体验。虽然ChatGPT长期支持语音模式,可将ChatGPT的文本转为语音,但GPT-4o在此基础上进行了优化,使用户能够像与助手互动一样自然地使用ChatGPT。

例如,用户现在可以在ChatGPT回答问题时中断它。而且,新模型能够提供“实时”响应,甚至能够捕捉到用户声音中的情感,并以不同的情感风格生成语音,如同真人一般。此外,GPT-4o还增强了ChatGPT的视觉功能。通过照片或屏幕截图,ChatGPT现在可以迅速回答相关问题,从“这段代码是做什么用的”到“这个人穿的是什么品牌的衬衫”。

美国科技媒体Quartz报道称,OpenAI新发布的ChatGPT-4o的技术让人印象深刻。OpenAI的演示表明,机器人现在可以与人类进行实时对话,与真人水平几乎没有区别。如果最终版本像OpenAI官方的演示一样,那么OpenAI似乎已经从某种程度上验证AI将在多大程度上改变我们的世界。

能力二:多语言表现出色,响应速度几乎与真人无异

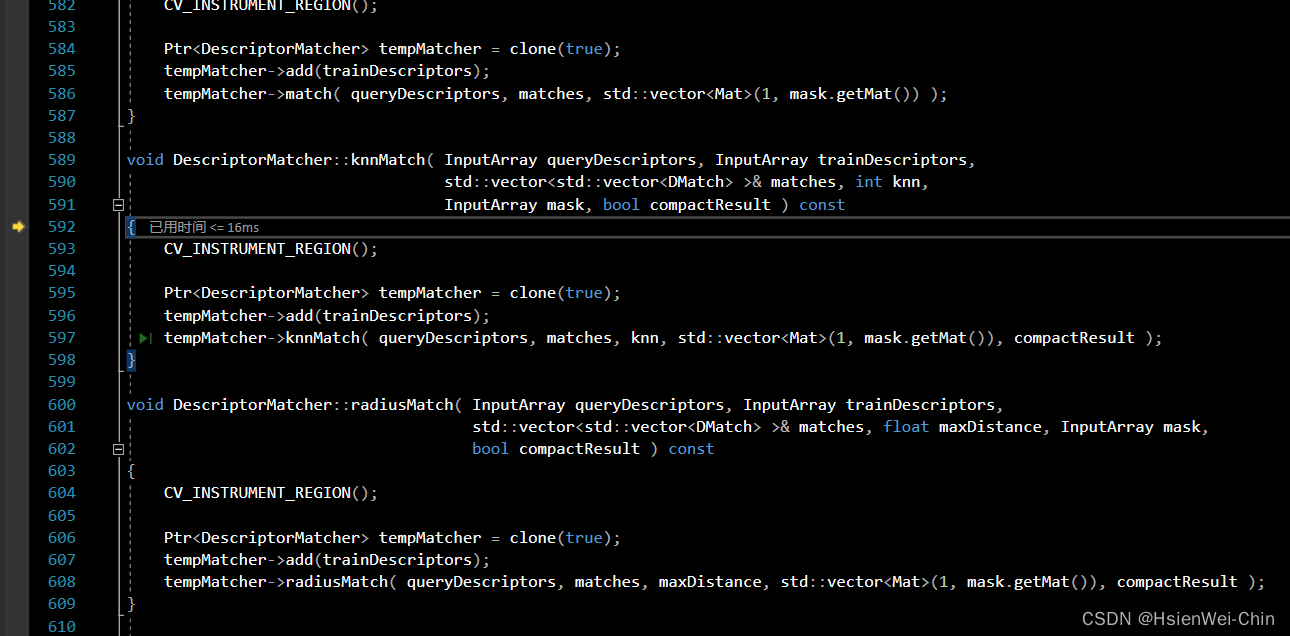

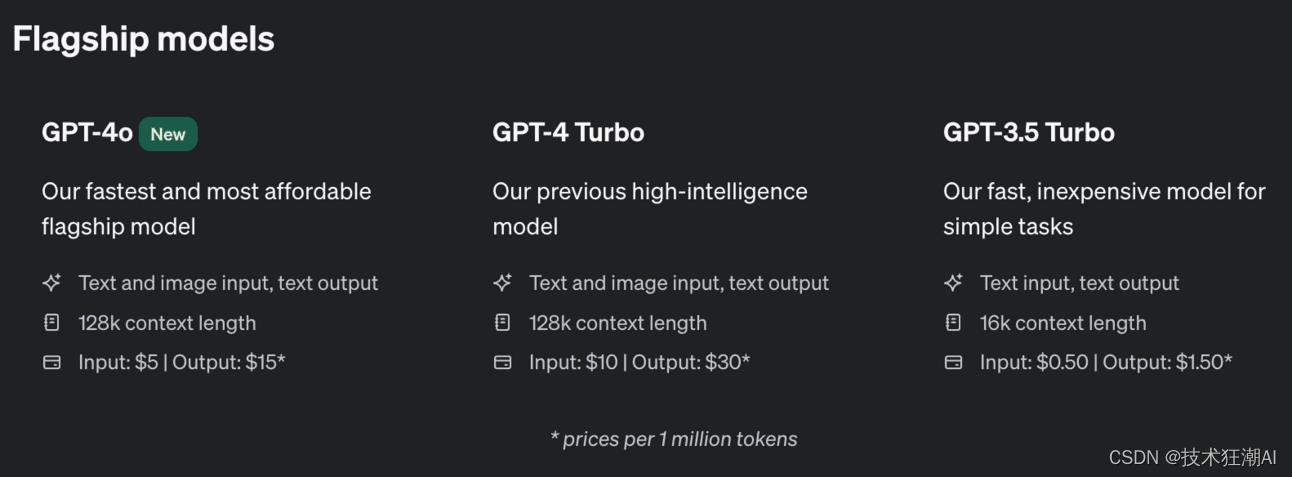

GPT-4o的多语言功能得到了增强,在50种不同的语言中表现更佳。在OpenAI的API中,GPT-4o的处理速度是GPT-4(特别是 GPT-4 Turbo)的两倍,价格则是GPT-4 Turbo的一半,同时拥有更高的速率限制。

OpenAI官网介绍称,GPT-4o最快可以在232毫秒的时间内响应音频输入,平均响应时间为320毫秒,这与人类在对话中的响应时间相似。它在英语文本和代码方面的性能与GPT-4 Turbo的性能一致,并且在非英语文本方面的性能有了显著提高。

用户只需发出简单的“嘿,ChatGPT”语音提示,即可获得代理的口语回应。然后,用户可以用口语提交查询,并在必要时附上文字、音频或视觉效果——后者可包括照片、手机摄像头的实时画面或代理能“看到”的任何其他内容。

2024年快速升级ChatGPTPLSU方法,开卡即可升级,支持微信支付宝

能力三:在推理及音频翻译方面树立新标杆

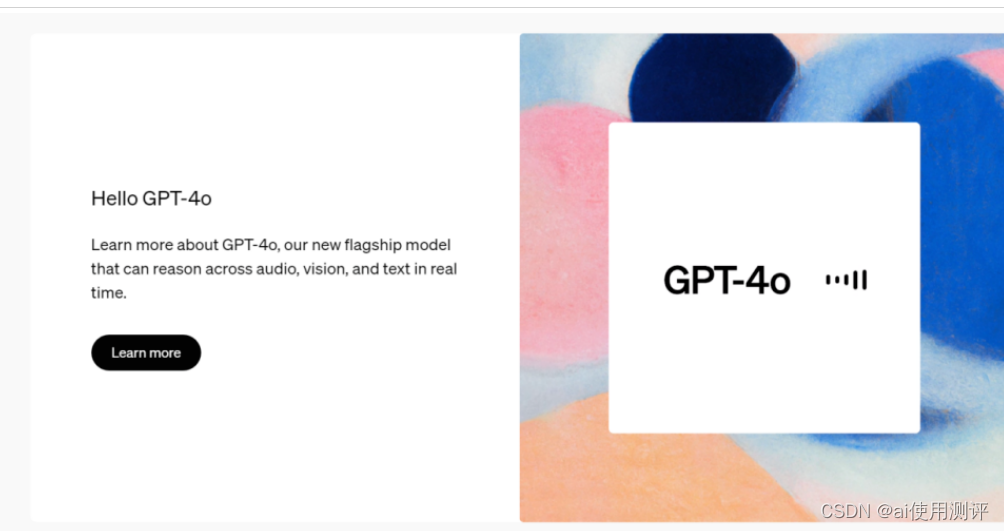

据OpenAI研究人员William Fedus透露,GPT-4o实际上就是上周在LMSYS模型竞技场上引起整个AI圈疯狂试用的GPT-2模型的另一版本,并附上了GPT-4o的基准测试评分对比图,相比GPT-4 Turbo提升了超过100个单位。

推理能力方面,GPT-4o在MMLU、GPQA、MATH、HumanEval等测试基准上均超越GPT-4 Turbo、Claude 3 Opusn、Gemini Pro 1.5等前沿模型,取得最高分。

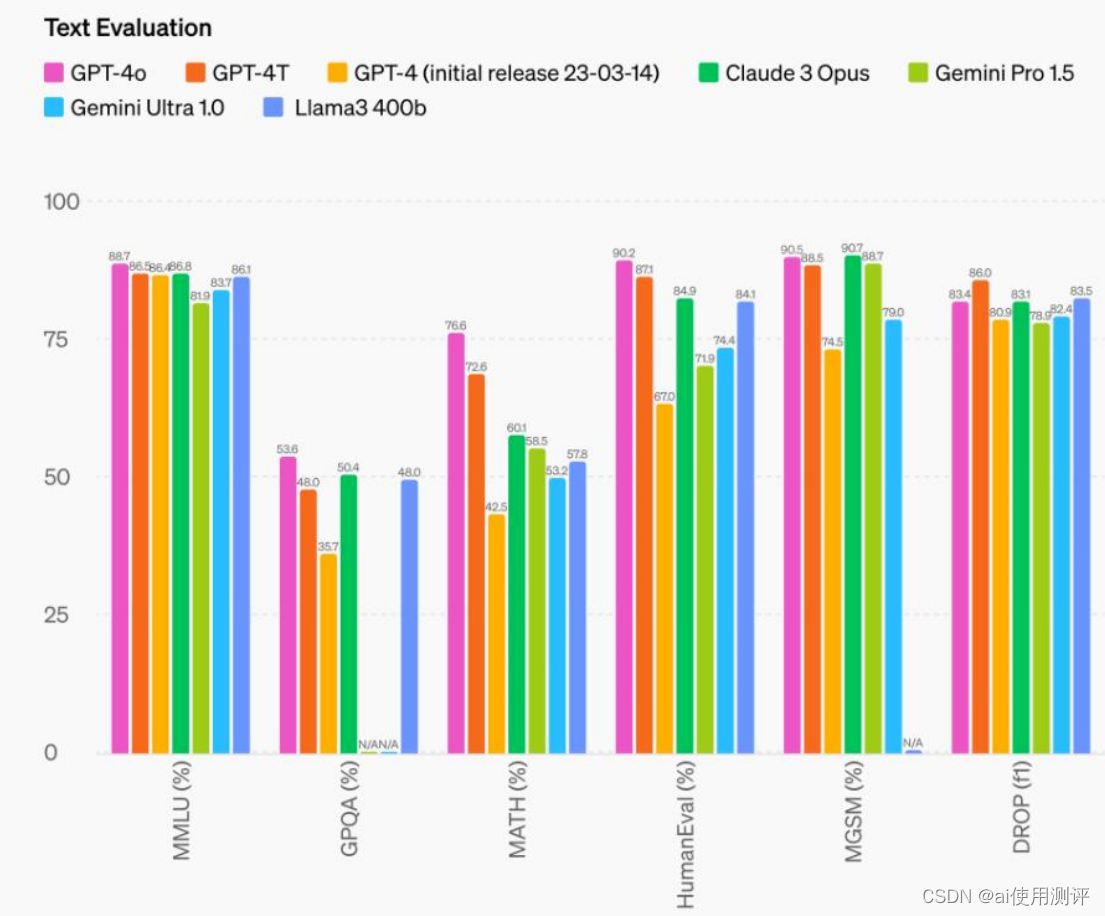

音频ASR(智能语音识别)性能方面,GPT-4o相比Whisper-v3,在所有语言的语音识别性能上均大幅提高,尤其是资源较少的语言。

音频翻译方面,GPT-4o也树立了新的标杆,在MLS基准测试中优于Whisper-v3以及Meta、谷歌的语音模型。

评价褒贬不一,有网友认为压力给到Siri了

虽然并未在OpenAI周一的重磅直播演示中现身,但OpenAI的CEO阿尔特曼对这次演示进行了重要的总结。阿尔特曼称,OpenAI在ChatGPT中免费提供了世界上最好的模型,新的语音和视频模式是他用过的最好的计算交互界面,感觉就像电影里的人工只能一样,达到与人类相似的响应速度和表达能力。

目前,GPT-4o的文本和图像功能开始在ChatGPT中免费推出,Plus用户可以享受到5倍的调用额度。在接下来的几周内,OpenAI将在ChatGPT Plus中推出Voice Mode新版本,该版本带有GPT-4o。