uCTRL: Unbiased Contrastive Representation Learning via Alignment and Uniformity for Collaborative Filtering论文阅读笔记

这篇文章应该是关于无偏推荐的

Abstract

由于协作过滤(CF)模型的隐式用户反馈偏向于流行的项目,CF模型倾向于产生带有流行偏差的推荐列表。先前的研究使用了逆倾向加权(IPW)或因果推理来缓解这一问题。然而,他们只使用点态或成对损失函数,而忽略了采用对比损失函数来学习有意义的用户和项表示。在本文中,我们提出了无偏压缩表示学习(uCTRL),优化了CF模型的InfoNCE损失函数的对齐和一致性函数。具体来说,我们制定了一个在uCTRL中使用的无偏对齐函数。我们还设计了一种新的IPW估计方法,消除了用户和项目的偏差。

Introduction

因为用户-项目交互通常偏向于流行的用户/项目,所以学习无偏见的用户/项目表示并非简单。用户-项目交互矩阵自然地遵循帕累托数据分布。虽然一些头部项目经常与用户互动,但许多尾部项目很少与用户互动。因此,CF模型很容易偏向于流行的用户/项目。因此,有偏差的用户/项目表示偏离了真正的用户偏好,导致较差的泛化性能。更糟糕的是,它们可以通过过度推荐流行商品而带来偏见放大。

现存方法的一些局限性有:

- (i)现有的关于在推荐系统中消除流行偏差的研究尚未积极地纳入对比损失函数,尽管它已被广泛地用于不同领域的更好的表示学习。

- (ii)现有的去偏策略在估计倾向权重时没有考虑用户和项目,即使推荐模型从用户/项目交互中学习潜在的嵌入向量。

本文提出了无偏压缩表示学习(uCTRL)。基于DirectAU ,对比表示学习被分解为两个损失函数:对齐和一致性。对齐函数表示正用户-项目交互的用户和项目向量之间的距离。一致性函数表示每个用户和项目分布的平均距离之和。虽然DirectAU 比现有的点级和成对损失函数显示出更好的性能,但可以观察到,对齐函数仍然偏向于用户/项目的流行程度。

为了解决这个问题,我们提出了一种无偏对齐函数,并设计了一种估算 IPW 的新方法,在对齐函数中去除了用户和项目流行度。

本文的贡献有:

- 我们引入了一种新的损失函数的无偏对比表示学习(uCTRL)通过对齐和一致性函数。

- 我们还开发了一种新的倾向加权估计方法来消除用户/项目的偏差,并将其纳入无偏对齐函数中。

Background

现有的研究将用户项目点击分解为两个组成部分:观察和相关性。如果用户知道该项目,并且她也对该项目感兴趣,那么用户就会点击一个项目。

\(P(y_{ui}=1)=P(o_{ui}=1)\cdot P(r_{ui}=1)=\omega_{ui}\cdot\rho_{ui}.\)

\(o_{ui}\)和\(r_{ui}\)它们分别代表了观察的伯努利随机变量和相关性的伯努利随机变量。为简单起见,让𝜔𝑢𝑖和𝜌𝑢𝑖分别表示𝑃(𝑜𝑢𝑖= 1)和𝑃(𝑟𝑢𝑖= 1)。

无偏推荐学习

无偏排名函数的目标是消除点击数据的偏差。有偏反馈的损失函数如下:

\(\mathcal{L}_{\mathrm{biased}}(\hat{\mathbf{R}})=\frac1{|\mathcal{D}|}\sum_{(u,i)\in\mathcal{D}}\left(y_{ui}\delta_{ui}^++(1-y_{ui})\delta_{ui}^-\right),\)

𝛿+𝑢𝑖和𝛿−𝑢𝑖分别是相关对和无关对的损失函数值。

我们通过用相关性变量𝜌𝑢𝑖替换点击变量𝑦𝑢𝑖来定义一个理想的损失函数。

\(\mathcal{L}_{\mathrm{ideal}}(\hat{\mathbf{R}})=\frac1{|\mathcal{D}|}\sum_{(u,i)\in\mathcal{D}}\left(\rho_{ui}\delta_{ui}^++(1-\rho_{ui})\delta_{ui}^-\right).\)

缩小偏置损失函数和理想损失函数之间的差距是至关重要的。最近,Saito等人采用了逆倾向加权(IPW)来消除对点击数据的偏差。

\(\mathcal{L}_{unbiased}(\hat{\mathbf{R}})=\frac1{|\mathcal{D}|}\sum_{(u,i)\in\mathcal{D}}\left(\frac{y_{ui}}{\omega_{ui}}\delta_{ui}^++\left(1-\frac{y_{ui}}{\omega_{ui}}\right)\delta_{ui}^-\right),\)

其中,𝜔𝑢𝑖是一个倾向得分,表示用户𝑢观察到项目𝑖的概率。关键问题是如何计算用户-项目交互对(𝑢,𝑖)的倾向得分。

对齐性和均匀性

对齐是有偏的。如果我们将用户和项目向量之间的距离视为局部损失,这就相当于用有偏的点击数据作为标签来训练局部损失

\(\begin{aligned} \mathcal{L}_{\mathrm{align}}(\hat{\mathbf{R}})& =\underset{(u,i)\sim p_{\mathrm{pos}}}{\operatorname*{\mathbb{E}}}\|f(u)-f(i)\|^2 \\ &=\frac1{|\mathcal{D}_{click}|}\sum_{(u,i)\in\mathcal{D}_{click}}y_{ui}\|\tilde{f(u)}-\tilde{f(i)}\|^2, \end{aligned}\)

其中,D𝑐𝑙𝑖𝑐𝑘是一组被单击的用户-项对。有必要通过消除点击偏差来优化对齐功能,使真正相关的用户-项目对在嵌入空间中更近。

Method

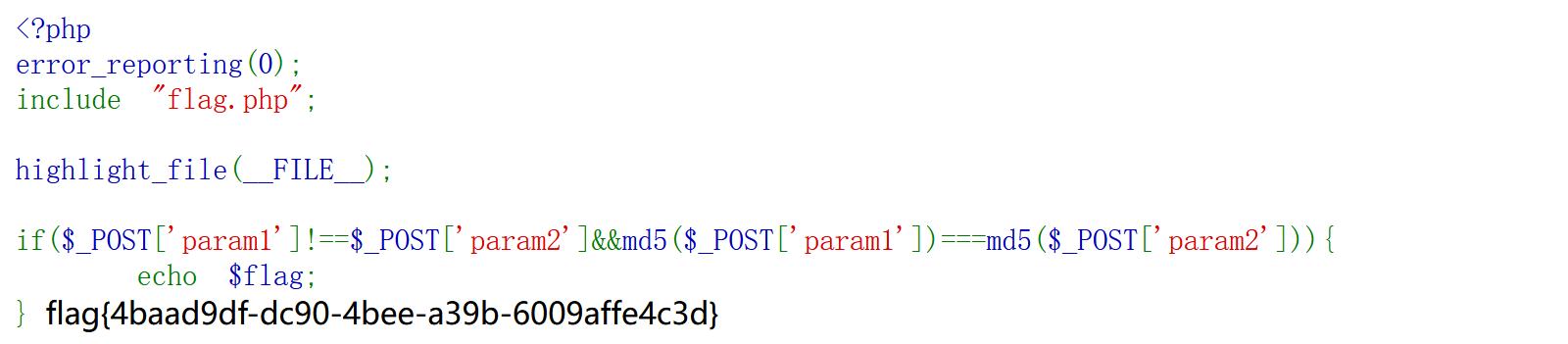

uCTRL的模型结构如下:

在本节中,我们将介绍无偏压缩表示学习(uCTRL),它消除了点击数据的偏差。首先,我们推导出一个无偏点击数据的无偏对齐损失。然后,我们提出了一种新的估计倾向权重𝜔𝑢𝑖的无偏对齐函数的方法。最后,我们共同学习了无偏DirectAU和倾向权重估计模型。

无偏的DirectAU

DirectAU 通过对比学习训练用户和项目表示是有效的;然而,我们观察到,对齐损失偏向于点击数据,这与通过真实的用户偏好实现的理想损失函数不同。给定一组被点击的用户-项目对D𝑐𝑙𝑖𝑐𝑘,相关性的理想对齐损失表述如下。

\(\mathcal{L}_{\mathrm{ideal_align}}(\hat{\mathbf{R}})=\frac1{|\mathcal{D}_{click}|}\sum_{(u,i)\in\mathcal{D}_{click}}\rho_{ui}\|\tilde{f(u)}-\tilde{f(i)}\|^2.\)

为了减少理想对齐损失函数和有偏对齐损失函数之间的差距,我们引入了现有研究中使用的IPW

\(\mathcal{L}_{\mathrm{unbiased_align}}(\hat{\mathbf{R}})=\frac{1}{|\mathcal{D}_{click}|}\sum_{(u,i)\in\mathcal{D}_{click}}\frac{y_{ui}}{\omega_{ui}}\|\tilde{f(u)}-\tilde{f(i)}\|^{2}.\)

尽管它很简单,但它被期望收敛到真正的用户偏好的理想对齐损失。证明见原文

与对齐损失不同,原始的均匀性损失利用采样的用户和项目对,而不考虑点击数据的偏差。它不需要用去偏置的方法来计算用户和项目的均匀性损失。最后,无偏DirectAU方法通过对正用户-项目对的无偏表示,使它们与真实偏好对齐,同时也促进了用户和项目的一致性

\(\mathcal{L}_{\mathrm{unbiased_DAU}}(\hat{\mathbf{R}})=\mathcal{L}_{\mathrm{unbiased_align}}(\hat{\mathbf{R}})+\gamma\mathcal{L}_{\mathrm{uniform}}(\hat{\mathbf{R}}).\)

计算倾向权重

计算无偏对齐损失的关键问题是估计点击数据的倾向权重。虽然用户-项目交互的倾向权重严重影响了用户和项目的受欢迎程度,但现有的方法主要关注于估计项目的受欢迎程度。为了解决这一限制,我们采用了一种新的方法,它结合了用户和项目向量来预测倾向权重。

具体来说,我们借用了TransR 的关键思想,它通过投影矩阵将实体空间上的不同实体投射到关系空间中。然后,它会计算出关系空间中的实体关系。虽然用户和项目向量是不同的信息,但它们是相关的。因此,我们首先将原始用户和项目向量转换为关系空间,以计算倾向权值。

\(f_r(u)=\tilde{f(u)}\mathbf{M}_u^\top,f_r(i)=\tilde{f(i)}\mathbf{M}_i^\top,\)

其中,M𝑢∈R𝑑×𝑑和M𝑖∈R𝑑×𝑑是反映用户和项目不同特征的投影矩阵。𝑓𝑟(𝑢)和𝑓𝑟(𝑖)是用户𝑢和条目𝑖的投影向量。

把\(\tilde{f(u)}\)和\(\tilde{f(i)}\)进行替换为\(\tilde{f_r(u)}\mathrm{~and~}\tilde{f_r(i)}\)来将对齐性和均匀性进行优化

因为用户和项目都在关系空间中表示出来了,所以我们通过取两个向量的点积来计算𝜔𝑢𝑖的倾向权重。

\(\hat{\omega}_{ui}=\sigma\left(f_{r}\tilde{(u)}\cdot\tilde{f_{r}(i)}^{\top}\right),\)

其中,ˆ𝜔𝑢𝑖为估计的倾向权值,𝜎(·)为s型函数,𝑓𝑟˜(·)为l2归一化投影向量。最后,倾向得分被估计,以消除用户和项目的偏见。

为了处理IPW的高方差问题,我们还采用了方差减少技术中常用的剪切方法。我们限制了ˆ𝜔𝑢𝑖的最小值。

\(\hat{\omega}_{ui}=\max\{\hat{\omega}_{ui},\mu\},\)

uCTRL损失函数

uCTRL的最终损失函数由两部分组成:学习真实偏好的无偏DirectAU损失和学习关系空间中用户和项目的投影向量的倾向权重估计损失。它联合学习了原始空间和关系空间的两个损失函数。

\(\mathcal{L}_{\mathrm{uCTRL}}(\hat{\mathbf{R}})=\mathcal{L}_{\mathrm{unbiased_DAU}}(\hat{\mathbf{R}})+\mathcal{L}_{\mathrm{relation_DAU}}(\hat{\mathbf{R}}).\)