AI不同技术方向杂谈

语言≠思维,大模型学不了推理:一篇Nature让AI社区炸锅了

https://mp.weixin.qq.com/s/BgMNITn5e1RGUOHQLKv7yg

大语言模型(LLM)为什么空间智能不足,GPT-4 为什么用语言以外的数据训练,就能变得更聪明?现在这些问题有 「标准答案」了。

近日,一篇麻省理工学院(MIT)等机构发表在顶级学术期刊《自然》杂志的文章观察到,人类大脑生成和解析语言的神经网络并不负责形式化推理,而且提出推理并不需要语言作为媒介。

这篇论文声称「语言主要是用于交流的工具,而不是思考的工具,对于任何经过测试的思维形式都不是必需的」,引发了科技领域社区的大讨论。

难道真的如语言学家乔姆斯基所言,追捧 ChatGPT 是浪费资源,大语言模型通向通用人工智能(AGI)的路线完全错了?

让我们看看这篇论文《Language is primarily a tool for

communication rather than thought》是怎么说的。

论文链接:https://www.nature.com/articles/s41586-024-07522-w

语言是人类智能的一个决定性特征,但它所起的作用或多或少一直存在争议。该研究提供了神经科学等相关学科角度的最新证据,以论证现代人类的语言是一种交流工具,这与我们使用语言进行思考的流行观点相反。

作者首先介绍了支持人类语言能力的大脑网络。随后回顾语言和思维双重分离的证据,并讨论语言的几种特性,这些特性表明语言是为交流而优化的。该研究得出结论认为,尽管语言的出现无疑改变了人类文化,但语言似乎并不是复杂思维(包括符号思维)的先决条件。相反,语言是传播文化知识的有力工具,它可能与我们的思维和推理能力共同进化,并且只反映了人类认知的标志性复杂性,而不是产生这种复杂性。

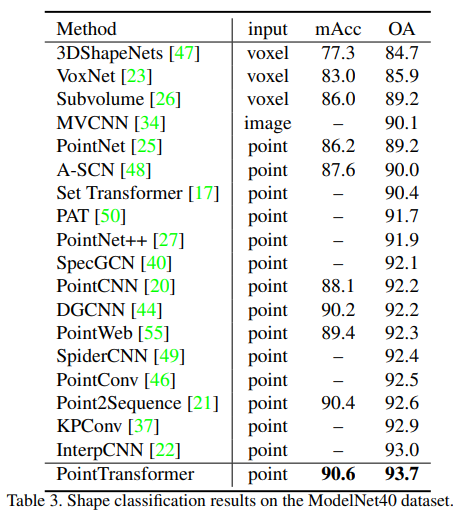

图 1

研究证据挑战了语言对于思维的重要性。如图 1 所示,使用

fMRI 等成像工具,我们可以识别完整、健康的大脑中的语言区域,然后检查在完成需要不同思维形式的任务时,语言区域的相关响应。

人类大脑中的语言网络

从人脑的生物学结构来看,语言生成和语言理解由左半球一组相互连接的大脑区域支持,通常称为语言网络(图 1a;Box 2 描述了它与语言神经生物学经典模型的关系)。

Box 2。许多教科书仍然使用 Wernicke 提出的语言神经基础模型,并由 Lichteim 和 Geschwind 进行了阐述和修订。该模型包括两个皮层区域:Broca 区位于下额叶皮层,Wernicke 区位于后上颞叶皮层。这两个区域分别支持语言产生和理解,并通过一条背侧纤维束(弓状束)连接。 语言网络有两个非常重要的特性:

首先,语言区域表现出输入和输出模态的独立性,这是表征抽象性的关键特征。主要表现为在理解过程中,这些大脑区域对跨模态(口头、书面或手语)的语言输入做出反应。同样,在语言生成过程中,无论我们是通过口语还是书面语来产生信息,这些区域都是活跃的。这些区域支持语言理解和生成(图 1a)这一事实表明,它们很可能存储了我们的语言知识,这对于编码和解码语言信息都是必需的。

其次,语言区还能对词义和句法结构进行表征和处理。特别是,关于脑磁图和颅内记录研究的证据表明,语言网络的所有区域都对词义以及词间句法和语义依赖性敏感(图 1a)。总之,语言网络中语言表征的抽象性以及网络对语言意义和结构的敏感性使其成为评估语言在思维和认知中的作用假设的明确目标((Box 3)。

我们对人类语言和认知能力,以及它们之间关系的理解仍然不完整,还有一些悬而未决的问题:

- 语言表征的本质是什么?

- 思维是否依赖于符号表征?

- 儿童学习语言时,语言网络是如何成长的?

语言对于任何经过检验的思维形式都不是必需的

经典的方法是通过研究大脑损伤或疾病的个体来推断大脑与行为之间的关联和分离。这种方法依赖于观察大脑某部分受损时个体行为的变化,从而推测不同大脑区域的功能和行为之间的联系。

有证据表明 —— 有许多个体在语言能力上有严重的障碍,影响到词汇和句法能力,但他们仍然表现出在许多思考形式上的完整能力:他们可以解决数学问题,进行执行规划和遵循非言语指令,参与多种形式的推理,包括形式逻辑推理、关于世界的因果推理和科学推理(见图 1b)。

研究表明,尽管失去了语言能力,一些患有严重失语症的人仍然能够进行所有测试形式的思考和推理,他们在各种认知任务中的完整表现就是明证。他们根本无法将这些想法映射到语言表达上,无论是在语言生成中(他们无法通过语言向他人传达自己的想法),还是在理解中(他们无法从他人的单词和句子中提取意义)(图 1b)。当然,在某些脑损伤病例中,语言能力和(某些)思维能力都可能受到影响,但考虑到语言系统与其他高级认知系统的接近性,这是可以预料的。

尤其是一些聋哑儿童,他们长大后很少或根本没有接触过语言,因为他们听不见说话,而他们的父母或看护人不懂手语。缺乏语言接触会对认知的许多方面产生有害影响,这是可以预料的,因为语言是了解世界的重要信息来源。尽管如此,语言剥夺的个体无疑表现出复杂的认知功能能力:他们仍然可以学习数学、进行关系推理、建立因果链,并获得丰富而复杂的世界知识。换句话说,缺乏语言表征并不会使人从根本上无法进行复杂的(包括符号的)思考,尽管推理的某些方面确实表现出延迟。因此,在典型的发展中,语言和推理是平行发展的。

完整的语言并不意味着完整的思维

以上证据表明,迄今为止测试的所有类型的思维都可以在没有语言的情况下实现。

接下来,论文讨论了语言和思维双重分离的另一面:与语言介导思维的观点相反,完整的语言系统似乎并不意味着完整的推理能力。

人类语言是由交流压力塑造的。

来自发育性和后天性脑部疾病的证据表明,即使语言能力基本完好,也可能存在智力障碍。

例如,有些遗传疾病导致智力受损程度不同,但患有这些疾病的人的语言能力似乎接近正常水平;还有一些精神层面有缺陷的人,会影响思考和推理能力,但同样不会影响语言。最后,许多获得性脑损伤的个体在推理和解决问题方面表现出困难,但他们的语言能力似乎完好无损。换句话说,拥有完整的语言系统并不意味着自动具备思考能力:即使语言能力完好无损,思考能力也可能受损。

总的来说,这篇论文回顾了过去二十年的相关工作。失语症研究的证据表明:所有经过检验的思维形式在没有语言的情况下都是可能的。fMRI 成像证据表明:参与多种形式的思考和推理并不需要语言网络。因此,语言不太可能成为任何形式思维的关键基础。

MIT 研究得出结论的同时,顶尖 AI 领域学者最近也发表了对大模型发展的担忧。上个星期四 Claude 3.5 的发布号称拥有研究生水平的推理能力,提升了行业的标准。不过也有人表示经过实测可见,它仍然具有 Transformer 架构的局限性。

对此,图灵奖获得者 Yann LeCun 表示,问题不在于

Transformer,而是因为 Claude 3.5 仍然是一个自回归大模型。无论架构细节如何,使用固定数量的计算步骤来计算每个 token 的自回归 LLM 都无法进行推理。

LeCun 也评论了这篇 Nature 论文,对思维不等于语言表示赞同。

对此,你怎么看?

参考内容:https://news.ycombinator.com/item?id=40756176https://x.com/ylecun/status/1804834054954459539

https://mp.weixin.qq.com/s/BgMNITn5e1RGUOHQLKv7yg

生成式AI赋能前端,未来已来

https://mp.weixin.qq.com/s/SWei5f8BlsE6xC-vr5hoDA

具有高AI性能和效率的最新SoC系统助力本地处理大型语言模型

随着 AI 技术的不断进步,十年前还只能在书本和科幻电影中看到的功能,如今随处可见。然而,迄今为止,对性能有着高要求的最新生成式 AI 技术应用通常只能运行在云端。

直到最近,生成式 AI 的主要应用还是倚靠耗电量巨大的服务器,这些服务器的任务本是开发和训练大型语言模型(LLM)。LLM 的出现本身就是一项突破,它只是迈出了一系列重要变革中的第一步。

目前,人们非常关注并推动着端侧大模型技术的广泛发展,因为该技术将使生成式 AI 能够部署到更多应用中,获益良多。具体来说,这些用例将大大增加生成式 AI 在智能城市、工业自动化、机器人和智能驾驶等市场的端侧设备中的广泛应用

生成式 AI 要在前端领域取得成功,需要注意四要素:AI 的隐私、性能,能效和高生产率,这些因素决定了市场转化的速度。

前端集成也有能源效率、设备微调和可靠性方面的技术挑战。这些问题本身就很棘手,因此向开发人员提供的解决方案须兼顾性能和成本,才能克服这些障碍。

为了应对这些相互冲突的挑战,定制化的芯片成为首选解决方案。

生成式AI的高能效SoC

安霸观察到前端应用对高能效 AI 处理器的需求,因此推出了一系列 AI SoC,适用于各种前端的生成式 AI 应用。

在大多数用于前端应用的高性能多模式分析用例中,第一步通常是在所有照明条件下捕获高质量视频。为此,需要一个即使在低光照条件下也能提供出色图像质量的图像信号处理器(ISP)。同样,高对比度场景的捕捉也必须使用具有先进的高动态范围(HDR)能力的处理器,这样才能捕捉到非常清晰的细节,为安防视频分析、自主移动机器人(AMR)和智能驾驶感知算法提供高品质的图像输入,从而得到通用的解决方案。此外,通过高效的视频编码技术,安霸的 SoC 还能以极低的码率传输高分辨率的视频流。

安霸 SoC 中的专有 CVflow AI 引擎,除了支持 LLM 处理外,还支持同时运行多个神经网络(NN),在运行各类计算机视觉算法时维持低功耗。安霸的 Cooper™ 开发者平台包含一套功能丰富的工具,使得客户很方便地把在PC上开发的神经网络移植到安霸芯片平台。

安霸的生成式 AI 芯片解决方案在模型的参数上具备高扩展性,从支持多达 340 亿个参数的多模态 LLM 的 N1 系列,到支持多达 30 亿个参数的较小视觉语言模型 (VLM) 的 CV7 系列。

如果你的应用需要超强的前端处理能力,那么安霸的旗舰款 N1 系列 SoC 是最佳选择之一。N1 可以接收多个高分辨率摄像头数据流输入,同时运行多达 340 亿个参数的多模态 LLM,并且支持连接更多的外围设备。N1 芯片集成了神经向量处理器 (NVP)、高级图像信号处理器(ISP)、16 个 Arm® Cortex®-A78AE CPU, 以及用于 3D 用户界面的 GPU,单颗芯片可提供高性能神经网络计算。不仅性能卓越,N1 芯片的每次推理功耗仅为业界领先 GPU 解决方案的一小部分。

N1 芯片非常适合为多种应用提供生成式 AI,包括工业机器人、智慧城市、智能医疗成像和诊断、多摄像头 AI 处理中心、运行多模态 LLM 的终端 AI 服务器以及智驾车队远程信息处理等。设备端通过运行多模态 LLM 促进了 生成式 AI 功能的实现,例如对视频和图像输入进行智能上下文搜索;使用自然语言命令控制机器人;以及多才多艺的 AI 助手,比如代码、文本和图像的生成等。

虽然这些系统多种多样,但它们在很大程度上都依赖于摄像头和自然语言理解的结合。在这种情况下,设备端的生成式 AI 处理可提高运行速度和增强隐私保护,同时降低总成本。本地处理也是特定应用大语言模型处理的理想选择,这些大语言模型通常在前端针对每个用例进行微调,而不是采用服务器方法,即使用更大、功耗更高的大语言模型来覆盖所有用例。

N1 系列芯片基于安霸功能强大的第三代 CVFlow 架构设计,因此具有出色的网络推理性能,广泛兼容各类神经网络,包括多模态大模型。例如,N1 SoC 在单流模式下以低于 50 瓦的功耗运行 Llama2-13B,每秒可推理 25 个 token。结合预移植模型的易集成性,这一新型解决方案可帮助设备制造商快速将生成式 AI 部署到任何对功耗敏感的应用中,如 AI 智能盒子、送货机器人等产品。

第四要素-生产率

Cooper 是安霸自研的开发者平台,提供灵活的模块化开发环境,可与安霸任何 AI SoC(包括 CV2,CV5, CV7 系列和 N1 系列)配合使用。它因强调合作而得名,适用于各种应用,包括机器人、AIoT、汽车和消费类视频设备。

是围绕一个名为 Cooper Foundry 的软件平台构建的,该开发平台由以下四个软件模块组成:

- Cooper Core 核心组件:包含基于 Linux 的操作系统、编译器和 SDK。

- Cooper Foundation AI 应用组件:用于在前端构建和部署 ML应用程序

- Cooper Vision 视觉感知组件:包含多模态传感器处理和融合的构建模块

- Cooper UX 应用交互组件:用于分析和开发

全面的 Cooper 开发平台加快了产品上市速度

该开发平台在 Cooper Metal 上运行。Cooper Metal 是一套硬件参考板,包括高能效 AI SoC、开发套件和模块,它还集成了常见的第三方开源软件工具。

为了展示这些功能,安霸利用其最新的 AI SoC 在 Cooper 上开发了一个演示系统。其中,安霸将业界领先的具有 AI 功能的 ISP 与多模态视觉语言模型相融合,后者还考虑到了视频帧中的图像数据。

作为向开发人员提供的单独演示的一部分,安霸使用 N1 SoC 建立了一个系统,支持处理多达 16 个视频流。它允许用户使用自然语言搜索任何异常或不寻常事件的上下文,甚至搜索特定的内容,如特定品牌或型号的汽车。

在 CV7 系列 SoC 的基础上,可以更低功耗构建具有 1-4 个视频流小型系统。这些系统可运行“CLIP”等视觉语言模型,整个系统的功耗低于 5W。

总结

生成式 AI 是一项变革性技术,由于其处理过程通常在 GPU 上,消耗大量电能,它曾一度局限于成本高昂的服务器中。基于安霸高效的 AI SoC 搭建的端侧 LLM 推理设备,其每次AI推理所需的功耗极低,领先行业。安霸 N1 SoC 将生成式 AI 引入终端设备和可内部部署的硬件,应用范围更加广泛,例如安防视频分析、机器人技术和众多工业自动化需求。此外,与 GPU 及其他 AI 加速器相比,安霸提供了完整的 SoC 和系统解决方案,每生成一个 token 的能效比大幅提升,可达 3 倍,并可快捷、低成本地部署。

参考文献链接

https://mp.weixin.qq.com/s/SWei5f8BlsE6xC-vr5hoDA

奕斯伟计算公司在最新的RISC-V边缘计算SoC中将SiFive CPU、Imagination GPU 和自有NPU 结合集成

https://mp.weixin.qq.com/s/NLv79OMnQQv22jZXreMnzQ

通过将两大RISC-V领导者的IP与奕斯伟计算公司自主研发的NPU等多项专业技术相结合,为奕斯伟计算的 EIC77系列SoC带来先进的AI加速和丰富的用户界面。2024年6月25日周二,德国慕尼黑——今天,北京奕斯伟计算技术股份有限公司(以下简称“奕斯伟计算”)与Imagination Technologies和SiFive联合宣布,奕斯伟EIC77系列SoC中的图形和计算加速功能由Imagination的GPU IP、SiFive的CPU IP,以及奕斯伟计算的专有神经网络单元NPU无缝集成而成。

“AI时代,面对千行百业被重塑的巨大机遇,奕斯伟计算正在构建基于RISC-V的智能计算未来,”奕斯伟计算副董事长王波表示,“算力是AI的核心驱动力,我们已推出EIC77系列SoC,以满足客户更多应用场景的不同算力需求。RISC-V的难点在于生态推广,我们很高兴与这些生态系统中富有经验且勇于创新的伙伴合作,为客户提供更好的解决方案。通过将来自SiFive的强大RISC-V处理器与Imagination专注于计算的GPU以及我们自有的高性能NPU等技术相结合,我们在边缘计算、AI PC、AI加速等领域打造了表现卓越的系列产品。”

EIC77系列于 2024 年早些时候首次发布,涵盖单Die RISC-V边缘计算芯片EIC7700及更高算力版本EIC7700X,双Die RISC-V AI PC芯片EIC7702及更高算力版本EIC7702X,可为从机器视觉应用(如行为识别和人脸识别)到大型语言模型等各种边缘计算应用提供出色的性能。EIC7700X将搭载于 2024 年 8 月上市的开发平台 SiFive 的HiFive Premier P550 开发板。

具体来说, 它具有以下特点:

- 基于RISC-V RV64GBC ISA的四核SiFive PerformanceP550核,运行频率为1.4GHz up to 1.8GHz,采用十三级、三发射、乱序流水线。

- 高效的IMG A系列GPU,在紧凑的硅面积内提供了最佳的填充率和计算能力。其128宽超标量算术逻辑单元(ALU)配备专用AI处理管道,提供高达0.25 TFLOPS、1 TOPS和8 Gpixels的性能。

- 由奕斯伟计算自主研发的深度神经网络加速器(NPU),提供19.95 TOPS INT8, 9.975 TOPSINT16, 9.975 FTOPS FP16计算性能。

- 高计算利用率用于DNN推理,resnet50网络下可跑到590fps(EIC7702X 1180fps), mobilev2网络下可跑到2600fps(EIC7702X达到5200fps)。

- 强大的视频编解码能力:高达8K@25fps的视频编码能力和高达8K@50fps的视频解码能力。

- 高DDR容量, 支持高达32GB(EIC7702X 达到64GB)的64-bit LPDDR4X或者LPDDR5@6400。

"很高兴看到我们最高性能的CPU内核与奕斯伟计算等合作伙伴一起在高端产品中推出,包括新的SiFive HiFive Premier P550开发平台。SiFive负责WW业务开发、销售和客户体验(CX)的高级副总裁剛誌堅表示:"RISC-V产品为现代工作负载提供了卓越的计算密度,正在改变人工智能领域。"与特定领域加速器(如 GPU 和 NPU)的紧密集成是实现SoC 性能最大化的关键。SiFive与Imagination等主要IP供应商建立了长期合作关系,确保我们的共同客户能够迅速将成功的产品推向市场"。Imagination 首席产品官 James Chapman 表示:"将 RISC-V CPU 与可用于计算的 GPU 和 NPU 相结合,可以创建一个非常灵活且功能强大的人工智能平台。"Imagination为系统设计人员提供了RISC-V就绪GPU IP的最佳选择,我们的工程团队在RISC-V系统设计方面拥有宝贵的经验,能够最大限度地降低客户在构建多供应商、异构SoC时的复杂性。"

关于奕斯伟计算

北京奕斯伟计算技术股份有限公司(简称“奕斯伟计算”)是一家以RISC-V为基础的新一代计算架构芯片与方案提供商,致力于RISC-V计算架构IP、芯片的自主研发及规模化应用,目前已形成软硬一体的全栈平台,为客户提供多媒体系统、显示交互、智慧连接、车载系统、智能计算、电源管理等芯片及解决方案。奕斯伟计算拥有全球半导体领域经验丰富的技术研发和经营管理团队。

关于ImaginationImagination 是一家总部位于英国的公司,致力于开发硅和软件 IP(知识产权),旨在为客户在竞争激烈的全球技术市场中赢得优势。其 GPU、CPU 和人工智能技术可实现出色的功耗、性能和面积 (PPA),快速上市,并降低总拥有成本。全球数十亿人的智能手机、汽车、家庭和工作场所都在使用基于 Imagination IP 的产品。

更多信息,请参阅 https://www.imaginationtech.com/。

关于SiFive作为将 RISC-V 引入全球的先驱,SiFive 将 RISC-V 的无限潜力带入全球最高性能和数据最密集的应用中,从而改变计算的未来。SiFive无与伦比的计算平台使全球领先的技术公司能够在芯片设计的各个细分市场进行创新、优化并提供未来最先进的解决方案,包括人工智能、机器学习、汽车、数据中心、移动和消费电子。有了 SiFive,RISC-V 的未来将无可限量。

参考文献链接

https://mp.weixin.qq.com/s/NLv79OMnQQv22jZXreMnzQ

![[C++ Primer] IO库](https://zzz-drawing-bed.oss-cn-nanjing.aliyuncs.com/img/image-20240627000317683.png)