Kettle 是一款国外开源的 ETL 工具,纯 Java 编写,绿色无需安装,数据抽取高效稳定 (数据迁移工具)。Kettle 中有两种脚本文件,transformation 和 job,transformation 完成针对数据的基础转换,job 则完成整个工作流的控制。

Kettle 中文名称叫水壶,该项目的主程序员 MATT 希望把各种数据放到一个壶里,然后以一种指定的格式流出。

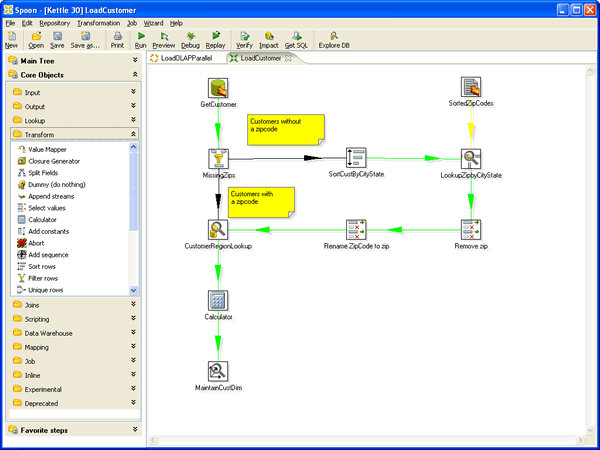

Kettle 这个 ETL 工具集,它允许你管理来自不同数据库的数据,通过提供一个图形化的用户环境来描述你想做什么,而不是你想怎么做。

Kettle 家族目前包括 4 个产品:Spoon、Pan、CHEF、Kitchen。

SPOON 允许你通过图形界面来设计 ETL 转换过程(Transformation)。

PAN 允许你批量运行由 Spoon 设计的 ETL 转换 (例如使用一个时间调度器)。Pan 是一个后台执行的程序,没有图形界面。

CHEF 允许你创建任务(Job)。 任务通过允许每个转换,任务,脚本等等,更有利于自动化更新数据仓库的复杂工作。任务通过允许每个转换,任务,脚本等等。任务将会被检查,看看是否正确地运行了。

KITCHEN 允许你批量使用由 Chef 设计的任务 (例如使用一个时间调度器)。KITCHEN 也是一个后台运行的程序。

Kettle 中文名称叫水壶,该项目的主程序员 MATT 希望把各种数据放到一个壶里,然后以一种指定的格式流出。Kettle 这个 ETL 工具集,它允许你管理来自不同数据库的数据,通过提供一个图形化的用户环境来描述你想做什么,而不是你想怎么做。

Kettle 中有两种脚本文件,transformation 和 job,transformation 完成针对数据的基础转换,job 则完成整个工作流的控制

目录

- Kettle 组件类型基本说明 tans/job

- Kettle 大数据组件的应用说明

- 基于表对表的同步

- 基于表到 hdfs 的同步

- 基于文件到 hdfs 的同步

- 基于表到 hive 的同步

- 基于表到 hbase 的同步

- 基于文件到 hbase 的同步

- 基于表到 phoenix 的同步

- Kettle 中 sqoop 的调用

- Kettle 中 JavaScript 的基本应用

- 作业调用作业及转换

- 如需运用大数据组件 需要将如下:

- core-site.xml

- hbase-site.xml

- hdfs-site.xml

- hive-site.xml

- mapred-site.xml

- yarn-site.xml

配置文件放入 $KETTLE_HOME/plugins/pentaho-big-data-plugin/hadoop configurations/hdp24

并在 $KETTLE_HOME/plugins/pentaho-big-data-plugin/plugin.properties 文件中添加 active.hadoop.configuration=hdp24