读人工智能全传09神经网络

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.hqwc.cn/news/742066.html

如若内容造成侵权/违法违规/事实不符,请联系编程知识网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

OpenVX一些技术杂谈

OpenVX一些技术杂谈OpenCV和OpenVX有什么联系和区别

联系和区别是:OpenCV是一个基于Apache2.0许可(开源)发行的跨平台计算机视觉和机器学习软件库。OpenVX 实现了跨平台加速处理,OpenVX在嵌入式和实时性系统中可以更好地发挥它的优势,在某些场合配合OpenCV的强大功能可以实…

Nginx中文URL请求404

这两天正在搞我的静态网站。方案是:从思源笔记Markdown笔记,用MkOcs build成静态网站,上传到到Nginx服务器。遇到一个问题:URL含有中文会404,全英文URL则正常访问。

比如:

设置了utf-8

http {charset utf-8;# 其他配置...

}中文URL依然404,英文URL则正常访问…

Easysearch 数据可视化和管理平台:INFINI Console 使用介绍

上次在《INFINI Easysearch 尝鲜 Hands on》中,我们部署了两个节点的 Easysearch,并设置了 Console 进行集群监控。今天,我们将介绍 INFINI Console 的使用。

Dashboard

INFINI Console 是一个功能强大的数据管理和分析平台,其仪表盘页面提供了直观简洁的界面,使用户能够快…

Quartus Ⅱ调用FIFO IP核方法实现求和(Mega Wizard)

本次实验学习记录主题为“FIFO_IP核实现算术求和”,主要内容是上位机通过串口向FPGA发送一定规格的数字矩阵,FPGA对矩阵处理,按规定逻辑实现求和运算,将结果返回串口转发至上位机。摘要:本次实验学习记录主题为“FIFO_IP核实现算术求和”,主要内容是上位机通过串口向FPGA…

INFINI Easysearch 尝鲜 Hands on

INFINI Easysearch 是一个分布式的近实时搜索与分析引擎,核心引擎基于开源的 Apache Lucene。Easysearch 的目标是提供一个自主可控的轻量级的 Elasticsearch 可替代版本,并继续完善和支持更多的企业级功能。与 Elasticsearch 相比,Easysearch 更关注在搜索业务场景的优化和…

全网最适合入门的面向对象编程教程:13 类和对象的Python实现-可视化阅读代码神器Sourcetrail的安装使用

本文主要介绍了可视化阅读代码神器Sourcetrail的安装与使用,包括软件简介和特性、下载地址、安装方式、新建工程和如何查看分析源码,同时简单介绍了PyCharm中Sourcetrail插件的使用。全网最适合入门的面向对象编程教程:13 类和对象的 Python 实现-可视化阅读代码神器 Source…

2024年7.4-7.8学习总结/暑假day7-11

2024年7.4-7.8学习总结/暑假day7-11

日记

上班有点小累,每天早上六点二十就得起床,每天偷摸着学java,回家了也学点,打算这段时间快速看完javaweb就开始做项目。

java

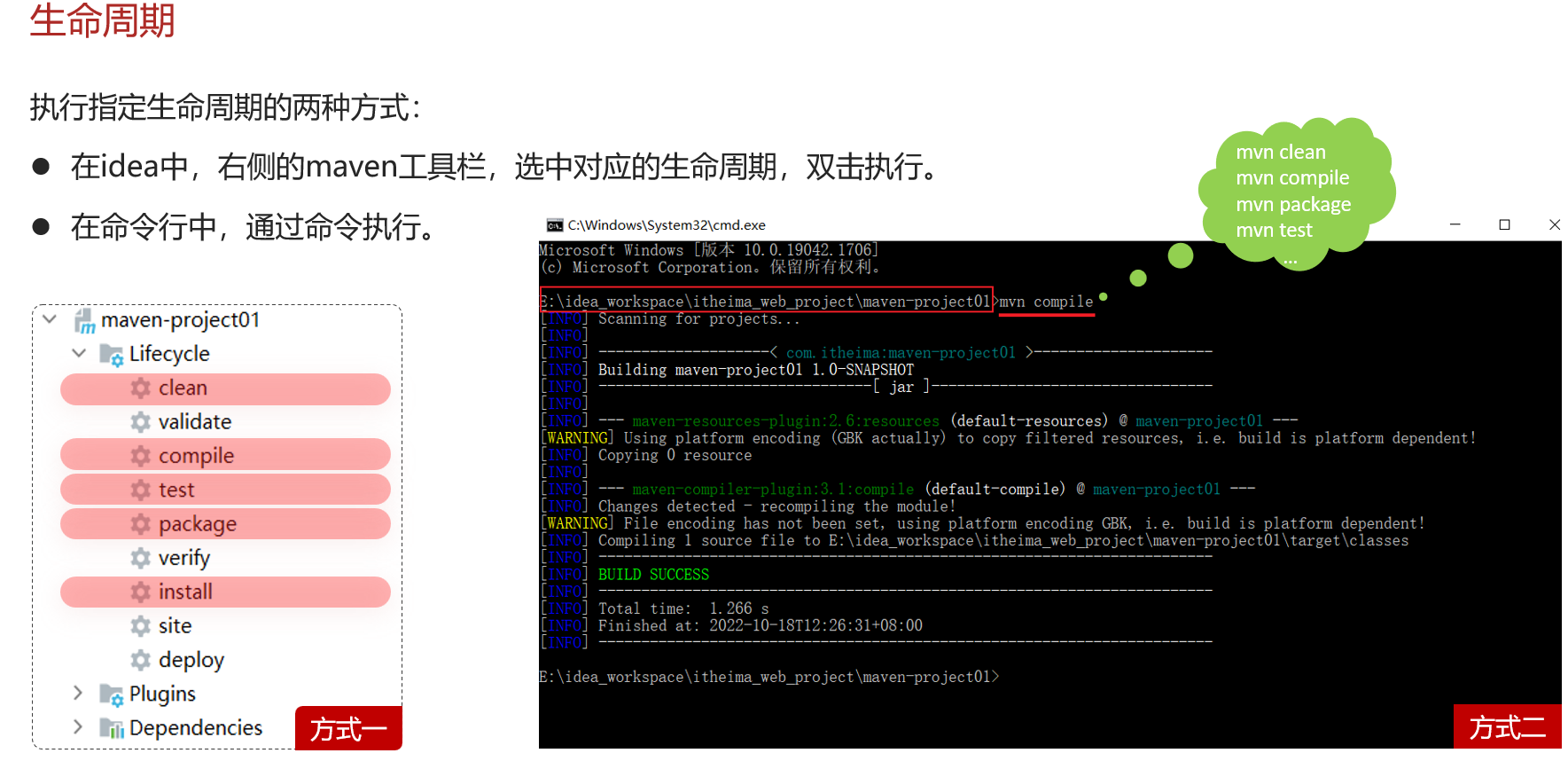

day02-10~04-08

JS对象

Array,String,JSON,BOM,DOM等

Bom

概念:Browser Object Model 浏览器对象模型,允…

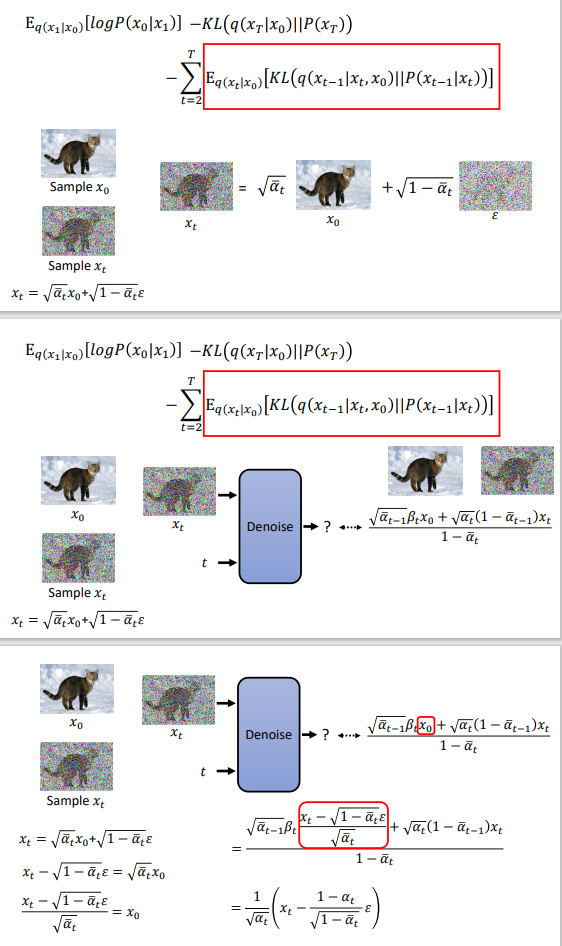

基于极大似然估计方法的diffusion

1、极大似然估计就是求概率的最大值2、VAE

(1)q(x|z)是编码器的隐向量,可以是任意分布,通过化简,得到了最低下界,最大化这个最低下界就行:(2)类比出DDPm的目标(3)DDPM的最终下界:(4)红色部分化简一波(5)红色部分化简一波(6)红色部分也是高斯分布,让两个高斯分布均值相近…

算法金 | DL 骚操作扫盲,神经网络设计与选择、参数初始化与优化、学习率调整与正则化、Loss Function、Bad Gradient

大侠幸会,在下全网同名「算法金」 0 基础转 AI 上岸,多个算法赛 Top 「日更万日,让更多人享受智能乐趣」今日 216/10000

抱个拳,送个礼神经网络设计与选择

参数初始化与优化

学习率调整与正则化

数据预处理与标准化

训练过程与监控

特定模型技巧

其他训练技巧1. 神经网络设…

k8s安装v1.30.2(contanerd容器运行时)实录

一、主机准备主机名

NAT IP

系统

配置k8s-master

192.168.1.201

ubuntu 18.04.6

2C2Gk8s-node01

192.168.1.202

ubuntu 18.04.6

2C2Gk8s-node02

192.168.1.203

ubuntu 18.04.6

2C2G 二、前提

主机配置好网络、ntp,关闭ufw,swap,安装好containerd,runc服务

三、安装步骤

mas…

Docker入门(三):nodejs后端服务部署

本文主要内容是通过dockerfile创建镜像,并通过kubernets(简称k8s)来启动集群服务。最后你会得到一个简单的nodejs提供的api服务。写在前面

需要安装的有node(如何安装?),kubectl(如何安装?)

一,创建nodejs应用

本文主要是用于实践k8s,所以nodejs项目写的非常简单,除了…