Vision Transformer (ViT) 位置编码

1. 生成位置编码

对于每个图像块(patch),根据其位置生成一个对应的编码向量。假设每个图像块的嵌入向量维度为 D,则位置编码的维度也是 D。

ViT 通常使用可学习的绝对位置编码,这意味着这些位置编码是在训练过程中学到的,并且每个图像块的位置编码在训练开始时是随机初始化的。

2. 位置编码矩阵

设有 N 个图像块(即 N 个输入向量),每个图像块对应一个位置编码向量。将这些编码向量组织成一个位置编码矩阵,维度为 N × D。

3. 向输入添加位置编码

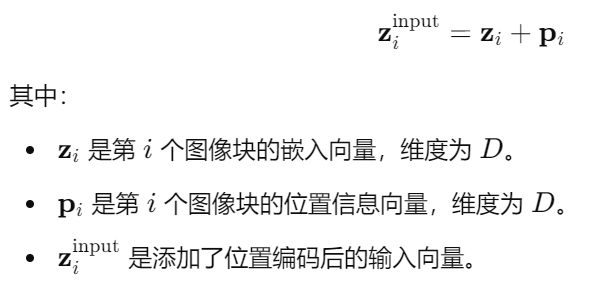

每个图像块的嵌入向量与其对应的位置信息相加:

4. 输入Transformer

这些添加了位置编码的向量将作为输入,传递给Transformer模型进行后续处理。

5. 位置编码的作用

通过将位置编码与图像块嵌入向量相加,Transformer能够区分不同图像块的位置信息,进而学习到输入序列的顺序依赖关系,这对于捕捉图像的空间结构信息至关重要。

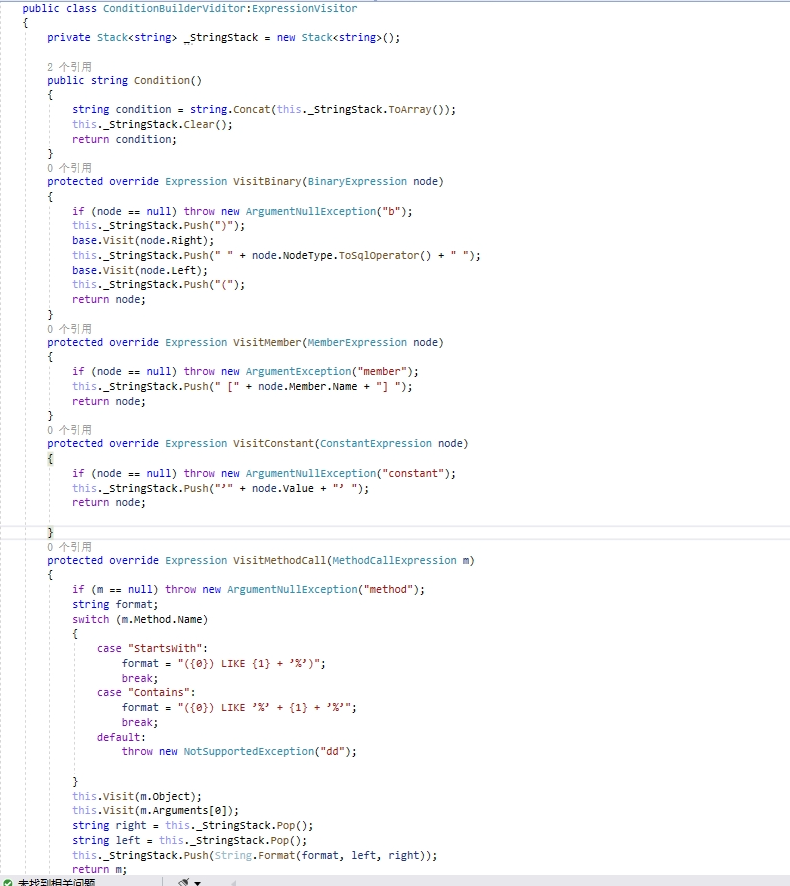

6. 代码示例(假设使用Python和PyTorch)

import torch

import torch.nn as nn

class VisionTransformer(nn.Module):

def __init__(self, num_patches, embed_dim):

super(VisionTransformer, self).__init__()

# 可学习的位置编码

self.position_embeddings = nn.Parameter(torch.zeros(1, num_patches, embed_dim))

def forward(self, x):

# x 的维度为 (batch_size, num_patches, embed_dim)

# 添加位置编码

x = x + self.position_embeddings

return x

在这个示例中,self.position_embeddings 是一个可学习的参数矩阵,其大小为 (1, num_patches, embed_dim)。在前向传播时,这个矩阵会与输入的嵌入向量相加,得到包含位置信息的输入。