Are GPT Embeddings Useful for Ads and Recommendation?论文阅读笔记

Abstract

现存的问题:

尽管 LLMs 潜力巨大,但关于其文本嵌入是否能帮助广告和推荐服务的讨论却十分有限。

提出方法:

为了探索 GPT 嵌入在广告和推荐中的应用,我们提出了三种策略,将 LLMs 的知识整合到基本 PLMs 中,并提高其性能。这些策略分别将 GPT 嵌入作为一种特征(EaaF)来丰富文本语义,作为一种正则化(EaaR)来指导文本标记嵌入聚合,以及作为一种预训练任务(EaaP)来复制 LLM 的能力。

Introduction

语义建模旨在从文本中提取有用的知识或特征。为了改进文本语义建模,许多研究都采用了基本 PLM 来学习文本表示,并取得了显著进展。然而,受限于模型规模和训练语料,基本的 PLM 无法完全捕捉文本特征,也无法对文本语义进行深度建模。

近年来大型语言模型(LLM)发展迅速。虽然 LLM 和基本 PLM 都是在无标记文本数据上进行预训练,但 LLM 通常包含更多参数和关注层,并使用更大的训练语料库进行训练。因此,GPT-3 和 LaMDA等 LLMs 当然可以对文本中丰富的语义特征进行建模,并学习词与词之间的关系,从而在文本理解方面具有更强大的能力。

但这也带来了一个严峻的问题,即如何更好地从 LLMs 的嵌入中提取语义知识,因为这些嵌入的训练目标并非针对广告或推荐任务,从而导致嵌入特征与下游任务所需的知识不一致。我们认为,在对基本 PLM 进行微调时,整合 LLM 的嵌入式知识并非难事。

在本文中,我们探讨了在语义建模中利用 LLM 功能的三种策略:作为特征的嵌入(EaaF)、作为正则化的嵌入(EaaR)和作为预训练任务的嵌入(EaaP)。这些策略可以大大提高广告和推荐任务的性能。

- EaaF 策略将 LLMs 嵌入作为全局特征,并将其与基本 PLMs 的每个标记嵌入串联起来,以丰富文本表示的语义知识。

- EaaR 策略旨在通过引入正则化项,引导基本 PLM 的文本编码器从 LLM 中学习常识,该正则化项包含均方损失,以最小化基本 PLM 的第一个标记嵌入与 LLM 嵌入之间的差异。

- EaaP 战略旨在通过复制 LLM 的嵌入,使基本 PLM 能够复制 LLM 的能力,并对 EaaP 模型进行微调,以适应下游任务。

Methods

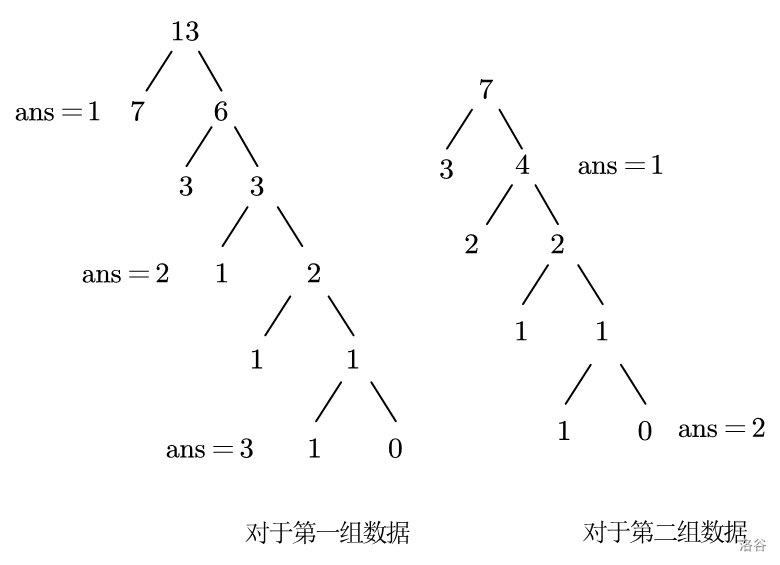

整体框架

我们设计了一个利用 GPT 嵌入帮助语义建模的框架,称为 GPT4SM。用于广告匹配的 GPT4SM 如图 1 所示,由一个基本 PLM、一个引导和汇集模块以及一个相关性预测模块组成。

给定一个查询文本 Dq = {wq1 , wq2 , --- , wqN } 和一个候选文本 Dc = {wc1 , wc2 , --- , wcM },基本 PLM 首先对 Dq 和 Dc 中的每个标记进行编码,得到它们的标记嵌入、 分别为 Eq 和 Ec 。

然后,通过所提出的三种策略,引导与池化模块将 GPT 嵌入知识集成到基本 PLM 中,并引导标记嵌入池化,从而得到查询和候选文本表示,分别为 hq = pool(Eq)、hc = pool(Ec)。池化操作可以是第一标记池化、均值池化或注意力池化。最后,查询表示 hq 和候选文本表示 hc 将被输入相关性预测模块,以计算它们的匹配得分\(\hat{y}\)。相关性预测模块可以通过多层感知器(MLP)、内积或余弦相似度来实现。

与广告匹配不同,推荐没有明确的查询文本。因此,按照文献,我们使用用户浏览文本作为查询语义。如图 2 所示,我们首先使用 GPT4SM 的 PLM 对用户浏览文本进行编码,得到它们的表示\(\mathbf{h}_{i,i=0,1,\cdots,k}.\)。然后,使用文本池方法汇总浏览文本表示法,得到查询表示 hq。候选文本编码和相关性预测与广告匹配是一致的。

为了简单起见,我们接下来解释一下我们的三种策略在广告匹配任务中是如何工作的。推荐任务与广告匹配类似,但它需要额外的步骤来计算浏览文本表示的加权求和。

嵌入作为功能(EaaF)

这种策略将 GPT 嵌入视为全局语义特征,以丰富 PLM 生成的每个标记嵌入的语义知识。如图 3a 所示,为了得到查询表示,我们首先将每个查询标记嵌入与 GPT 嵌入连接起来。然后,我们利用加法注意将这些连接嵌入聚合起来,得到 hq:

其中Eq 是查询标记嵌入的集合,uq ∈ Rd2 是查询的 GPT 嵌入。hq 是查询表示。获取候选文本表示 hc 的过程与上述步骤一致。

查询表示 hq 和候选文本表示 hc 被输入相关性预测模块,以计算它们的匹配得分 yˆ。我们使用交叉熵损失进行模型训练

嵌入作为正则化(EaaR)

这种策略将嵌入作为正则化条件,引导基本 PLM 从 LLM 中学习一般知识。如图 3b 所示,为了实现这一目标,我们首先对查询标记嵌入进行加法注意,得到池化嵌入 pq。然后对第一个标记嵌入进行变换,得到与 GPT 嵌入具有相同维度的正则化嵌入,从而计算两者之间的均方损失。最后,池化嵌入将与正则化嵌入连接,以加强其语义知识。获取 hq 的过程可以表示为:

\(\mathbf{c}_q=\mathbf{W}_c^T\mathbf{e}_\mathbf{qo},\\\mathbf{h}_q=concat(\mathbf{c}_q,\mathbf{p}_q),\)

其中,eq0∈Rd1 是 PLM 输出的第一个标记嵌入,pq∈Rd1 是汇集标记嵌入。获取候选文本表示法 hc 的过程与上述步骤一致。

为了将 LLM 的知识融入到基本 PLM 的训练中,我们在训练目标中使用了均方损失作为正则化项。最终的损失可以表示为:

\(\mathcal{L}=-\sum y\log\hat{y}+w_r*||\frac{\mathbf{c}_q}{||\mathbf{c}_q||_2}-\mathbf{u}_q||,\)

嵌入作为预训练任务(EaaP)

我们提出了 EaaP,将嵌入作为预训练任务,使基本 PLM 能够复制 LLM 的能力。EaaP 获取 hq 和 hc 的过程与 EaaR 一致。不过,EaaP 的训练过程分为两个部分。在最初的\(N_{ep}\) epoch中,模型模仿 LLM 的输出。我们使用转换后的第一个标记嵌入作为复制嵌入来学习 GPT 嵌入的知识。均方损失用于最小化 GPT 嵌入和复制嵌入之间的差异。在最后几个epoch中,我们会对模型进行微调,使其适应下游任务。我们使用交叉熵损失进行点击预测训练。

总结

这篇文章整体讲的比较清晰,这里就贴一下原文的conclusion

本文介绍了三种新策略,即 EaaF、EaaR 和 EaaP,旨在利用 LLM 嵌入提高基本 PLM 的语义挖掘能力。这些策略包括将 GPT 嵌入作为输入特征、正则化项和预训练任务,以便将 LLM 知识整合到基本 PLM 中,并指导标记嵌入聚合。这些方法有助于模型训练并提高性能。我们基于两个真实数据集的实验结果表明,无论 PLM 的骨干类型和规模如何,我们的策略都能有效提高基本 PLM 在广告匹配和新闻推荐等任务中的性能。