CoSeR桥接图像和语言以实现认知超分辨率

6.10.1 CoSeR桥接图像和语言以实现认知超分辨率概述

现有的超分辨率(SR)模型主要侧重于恢复局部纹理细节,往往忽略了场景中的全局语义信息。这种疏忽可能会导致在恢复过程中遗漏关键的语义细节或引入不准确的纹理。

引入了认知超分辨率(CoSeR)框架,赋予SR模型理解低分辨率图像的能力。通过将图像外观和语言理解结合起来生成认知嵌入来实现这一目标,该嵌入不仅激活了从大型文本到图像扩散模型的先验信息,还促进了高质量参考图像的生成,以优化SR过程。为了进一步提高图像的保真度,提出了一种新的条件注入方案,称为All in Attention,将所有条件信息整合到一个模块中。因此,方法成功地恢复了语义正确和逼真的细节,在多个基准测试中展示了最先进的性能。

6.10.2 CoSeR桥接图像和语言以实现认知超分辨率技术分析

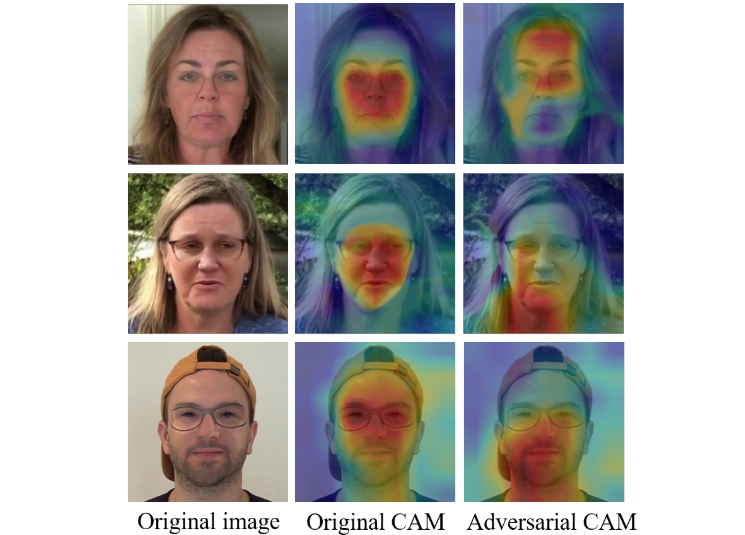

可视化显示由认知超分辨率(CoSeR)模型生成的4倍超分辨率结果如图6-17所示。

图6-17 可视化显示由认知超分辨率(CoSeR)模型生成的4倍超分辨率结果

在图6-17中,CoSeR熟练地从低分辨率(LR)图像中提取认知信息,并利用它生成高质量的参考图像。该参考图像在语义和纹理方面与LR图像紧密对齐,显著有利于超分辨率过程。

为了简明起见,将输入、生成的引用和恢复结果分别表示为LR、GR和SR。最佳视图放大。

认知超分辨率(CoSeR)网络框架如图6-18所示。

图6-18 认知超分辨率(CoSeR)网络框架

在图6-18中,给定低分辨率(LR)图像,采用认知编码器提取包含语义和纹理信息的认知嵌入,然后用于生成高质量的参考图像。使用全注意力(AiA)模块将LR输入、认知嵌入和参考图像集成到去噪U-Net中,分别由蓝色、金色和青色线条表示。认知编码器和AiA模块的结构详见(b)和(c)。可训练模块以红色突出显示,而冻结模块以蓝色显示。

BLIP2字幕和认知编码器生成的参考图像、认知适配器的结构,如图6-19所示。

图6-19 BLIP2字幕和认知编码器生成的参考图像、认知适配器的结构

在图6-19中,(左)通过BLIP2字幕和认知编码器生成的参考图像。第一行显示需要增加令牌号码。最后两行显示了直接使用字幕进行认知的缺点。(右)认知适配器的结构。

认知信息,采用不同的认知编码器,并结合生成的参考图像。

由具有不同监督方法的认知编码器生成的参考图像,如图6-20所示。

图6-20 由具有不同监督方法的认知编码器生成的参考图像

由认知编码器生成的参考图像,具有不同数量的可学习查询,如图6-21所示。

图6-21 由认知编码器生成的参考图像,具有不同数量的可学习查询

提出的CoSeR框架中去噪U-Net的网络结构如图6-22所示。

图6-22 提出的CoSeR框架中去噪U-Net的网络结构

CoSeR框架中ControlNet的网络结构如图6-23所示。

图6-23 CoSeR框架中ControlNet的网络结构

ImageNet Test2000数据集的定性比较(第1/4部分)如图6-24所示。

图6-24 ImageNet Test2000数据集的定性比较(第1/4部分)

ImageNet Test2000数据集的定性比较(第2/4部分)如图6-25所示。