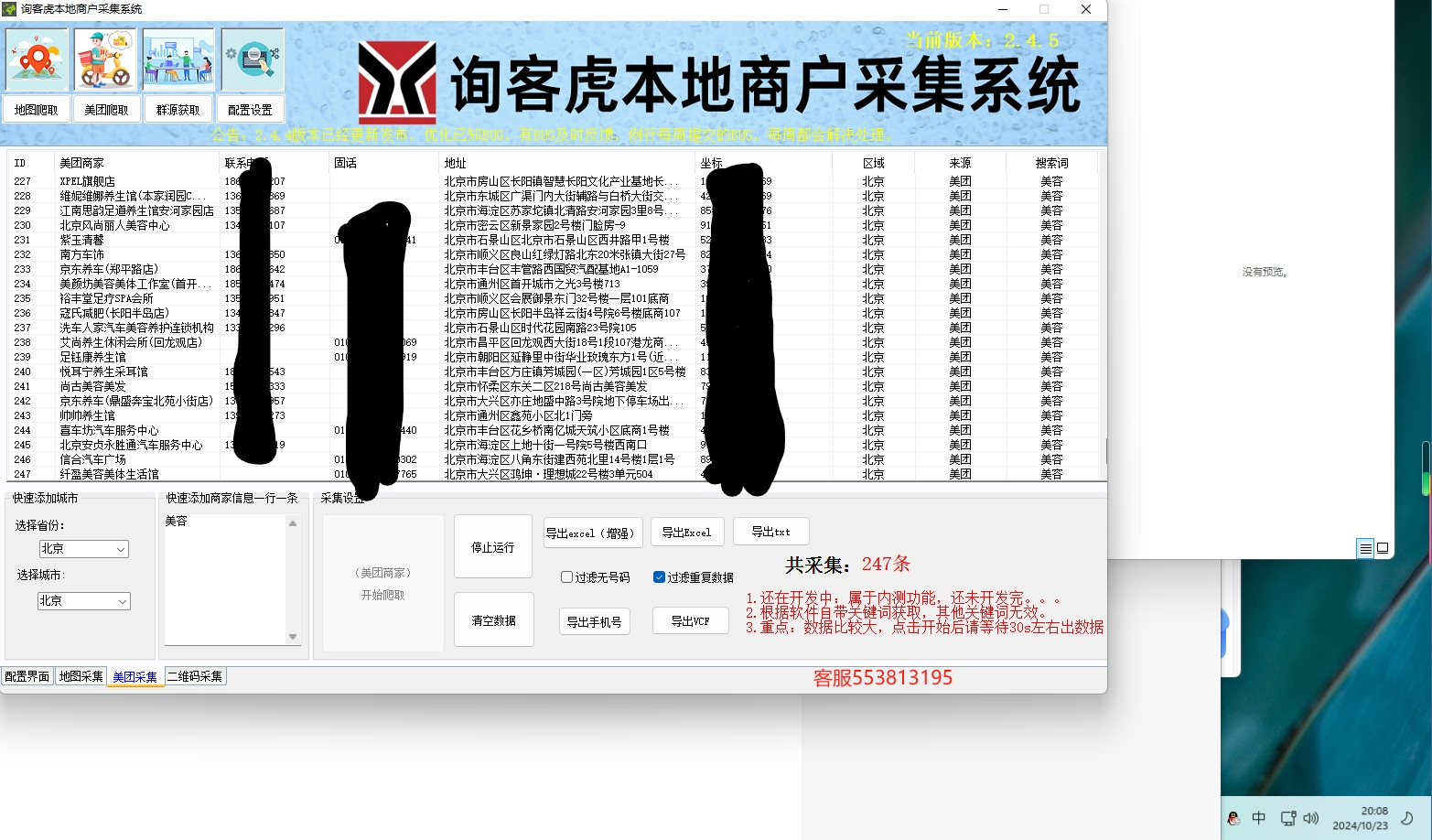

定义目标:明确需要采集的数据,如商家名称、地址、评分、销量等。

分析页面结构:通过浏览器的开发者工具,分析美团团购或外卖页面的HTML结构,找出包含所需数据的标签。

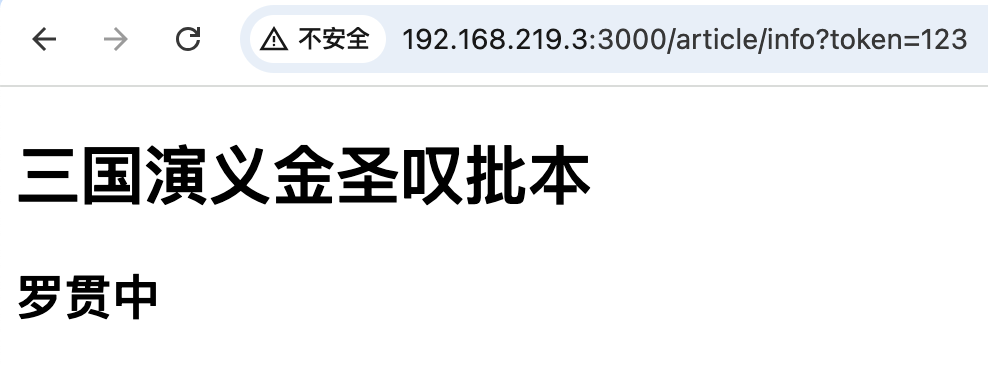

模拟用户请求:使用requests库模拟用户访问美团页面,可能需要处理登录、反爬虫机制(如Cookies、Headers、验证码等)。

解析HTML:使用BeautifulSoup或lxml解析HTML,提取所需数据。

数据存储:使用pandas将数据保存为CSV文件或其他格式,便于后续处理。

错误处理:处理网络请求错误、解析错误等。

批量采集:通过循环或多线程/异步IO处理多个页面。

代码思路

python

复制代码

import requests

from bs4 import BeautifulSoup

import pandas as pd

import time

import random

基础配置

HEADERS = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36',

可能需要添加更多Headers,如Cookies

}

BASE_URL = 'https://meituan.com' # 示例基础URL,实际应使用美团团购或外卖的具体页面URL

模拟登录(如果需要)

def login(session):

实现登录逻辑,可能涉及POST请求和Cookies处理

pass

采集单个页面数据

def collect_data(url, session):

try:

response = session.get(url, headers=HEADERS)

response.raise_for_status() # 检查请求是否成功

soup = BeautifulSoup(response.text, 'html.parser')

解析HTML,提取数据

例如:商家名称、地址、评分等

merchant_name = soup.select_one('...').text # 替换为实际的CSS选择器

address = soup.select_one('...').text

rating = soup.select_one('...').text

继续提取其他需要的数据...

return {

'merchant_name': merchant_name,

'address': address,

'rating': rating,

添加其他字段...

}

except Exception as e:

print(f"Error collecting data from {url}: {e}")

return None

批量采集数据

def batch_collect(start_urls, session):

all_data = []

for url in start_urls:

data = collect_data(url, session)

if data:

all_data.append(data)

添加延时以避免过快请求

time.sleep(random.uniform(1, 3))

return all_data

主函数

def main():

初始化session

session = requests.Session()

登录(如果需要)

login(session)

定义要采集的页面URL列表

start_urls = [

示例URL,实际应包含所有需要采集的页面URL

'https://meituan.com/page1',

'https://meituan.com/page2',

...

]

批量采集数据

data = batch_collect(start_urls, session)

存储数据到CSV文件

df = pd.DataFrame(data)

df.to_csv('merchants.csv', index=False, encoding='utf-8-sig')

if name == "main":

main()

注意事项

反爬虫机制:美团等网站可能有严格的反爬虫机制,包括验证码验证、IP封锁等。在实际操作中,可能需要使用代理IP、模拟用户行为(如随机延时、滚动页面等)、处理验证码等策略。

合法性和隐私:确保你的采集行为符合相关法律法规和网站的使用条款,尊重用户隐私。

动态内容:如果页面内容是通过JavaScript动态加载的,可能需要使用如Selenium这样的浏览器自动化工具。

这个代码思路提供了一个基本的框架,你可以根据实际需求进行扩展和优化