前提条件:已经本地安装好了Ollama。

如果没有安装Ollama或者想部署其他的模型或者不想使用docker,,可以参考之前的这篇文章:

https://www.cnblogs.com/Chenlead/p/18571005

安装过程参考:https://docs.openwebui.com/getting-started/quick-start/

1.docker拉取open-webui镜像

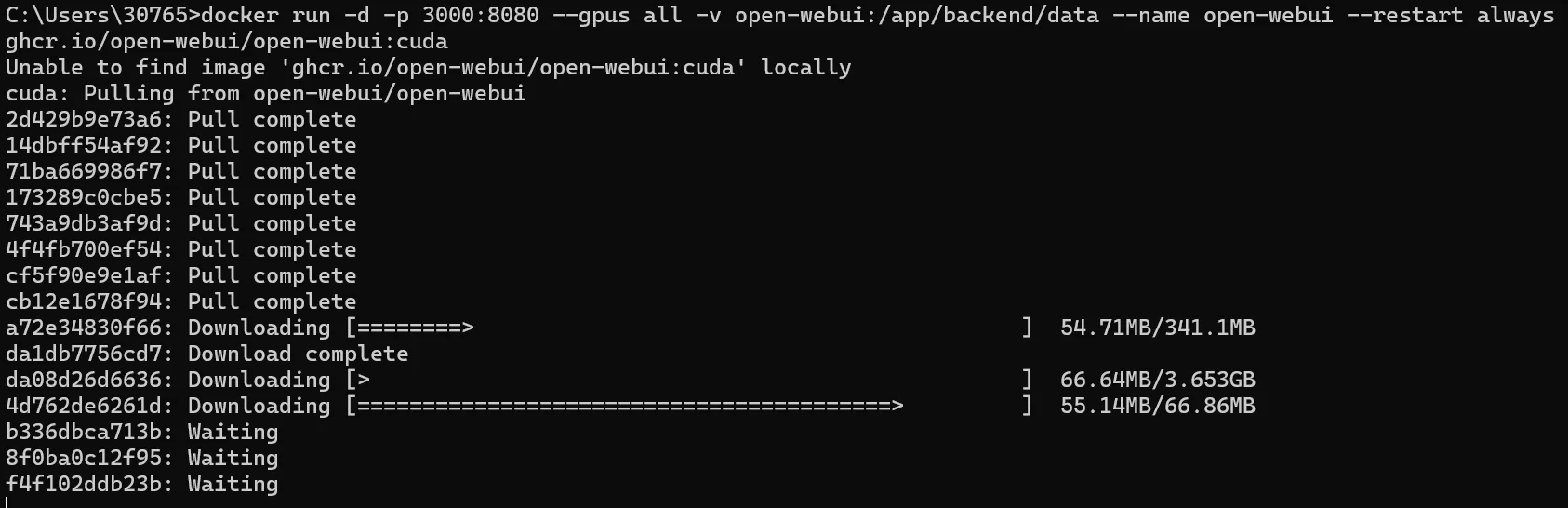

在命令行里用docker拉取含有NVIDIA GPU支持的Open WebUI:

docker run -d -p 3000:8080 --gpus all -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda

需要一个下载的过程。

2.运行容器

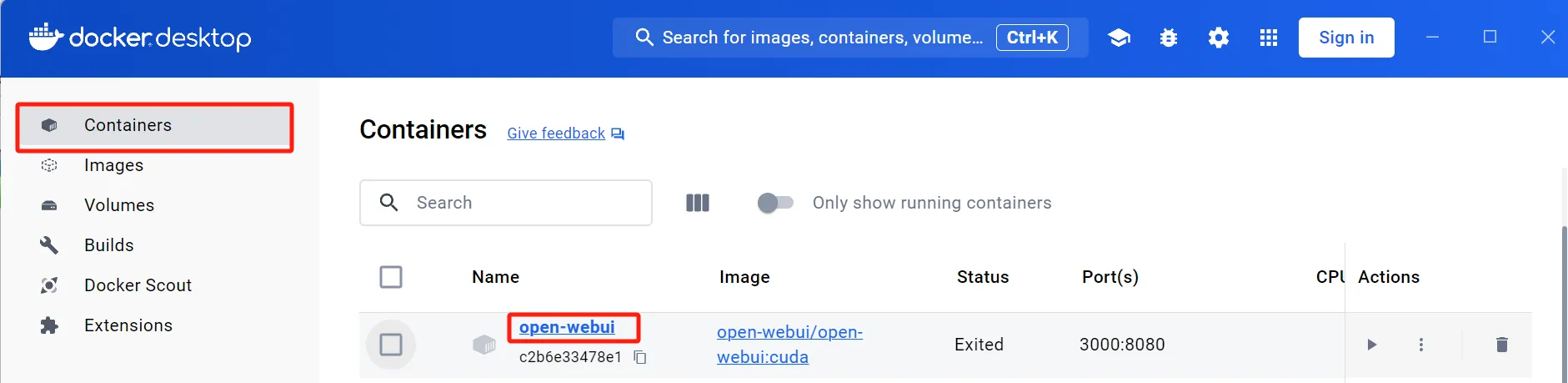

安装好之后打开docker desktop

在Containers 里就可以看到本地的名为open-webui 的容器

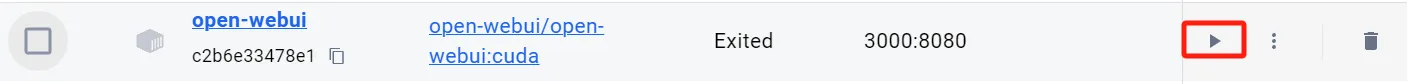

点击start 按钮

或者在cmd里输入docker start open-webui

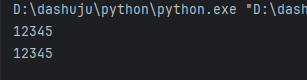

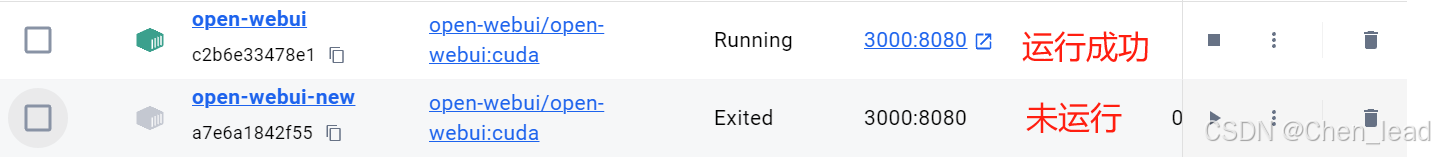

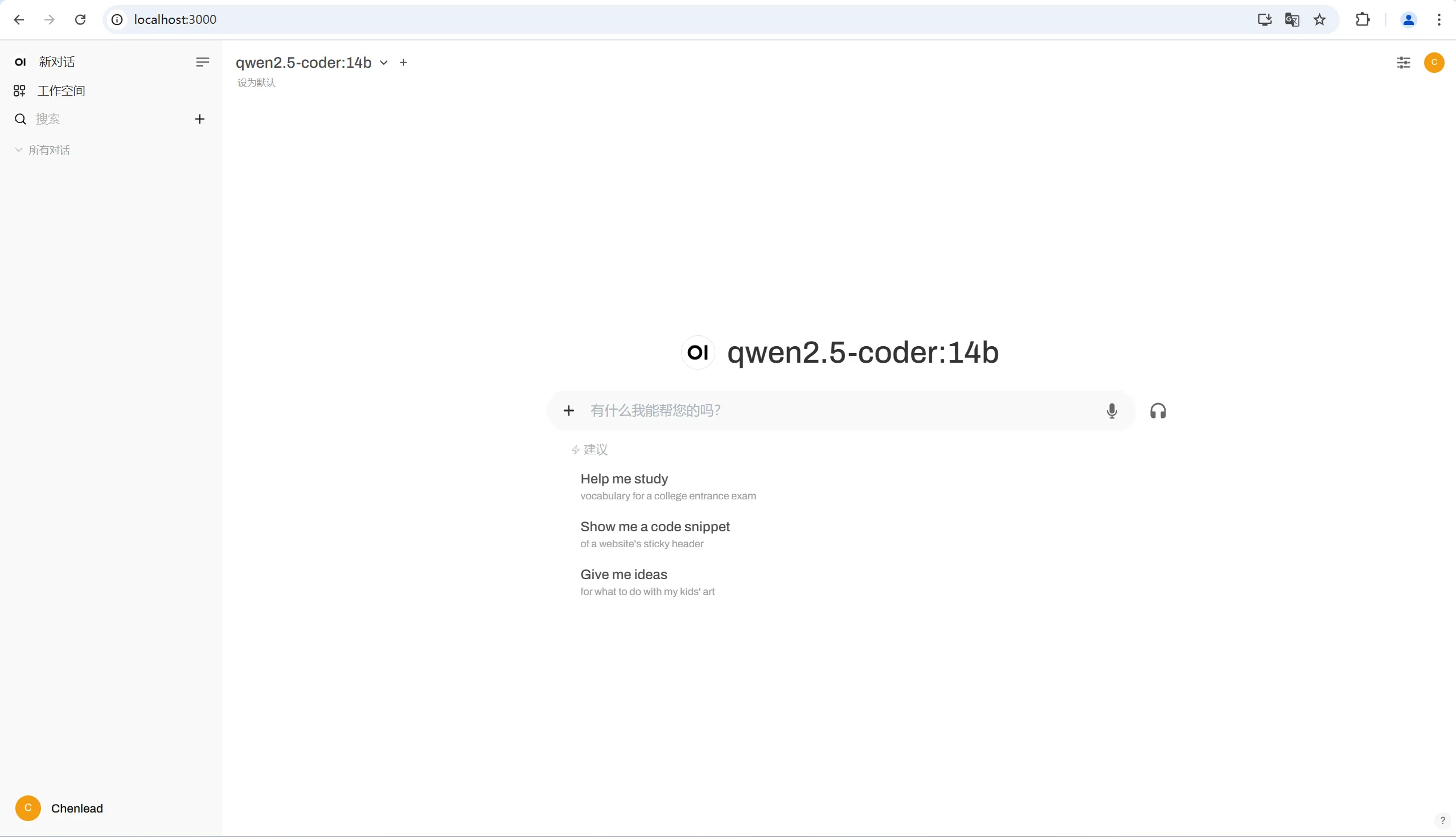

运行成功之后的效果如下图所示

3.本地访问

然后在本地访问3000端口即可:localhost:3000

通过docker部署支持Nvidia GPU加速的本地大模型

通过docker部署支持Nvidia GPU加速的本地大模型