一、HDFS集群的启动停止1.1 单服务启动停止方式1.1.1 单服务启动1.1.2 单服务停止1.2 多服务启动停止方式1.2.1 多服务启动1.2.2 多服务停止二、获取HDFS集群信息三、HDFS常用命令3.1 查看HDFS帮助命令3.1.1 查看hdfs命令使用提示3.1.2 查看特定指定的使用方法3.2 在HDFS上创建目录3.3 在HDFS上对目录赋予权限3.4 上传文件到HDFS目录3.4.1 在本地生成文件superman01.txt3.4.2 上传文件到HDFS3.5 查看HDFS上的文件及目录3.6 查看HDFS文件的内容3.7 在HDFS上移动文件3.7.1 移动文件3.7.2 查看文件是否移动成功3.8 在HDFS上拷贝文件3.8.1 拷贝文件3.8.2 查看文件是否拷贝成功3.9 在HDFS上删除文件3.9.1 删除文件3.9.2 检查文件是否删除成功3.10 从HDFS上下载文件3.10.1 下载文件并改名3.10.2 本地查看文件内容

一、HDFS集群的启动停止

1.1 单服务启动停止方式

1.1.1 单服务启动

1、 启动dfs

# start-dfs.sh

namenode上查看及启动

datanode1上查看

datanode2上查看

启动dfs,在namenode节点上会启动NameNode、SecondaryNameNode、DataNode,而在datanode节点启动DataNode。

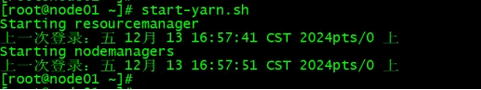

2、启动yarn

# start-yarn.sh

namenode上查看及启动

datanode1上查看

datanode2上查看

yarn启动后在nodename上启动了NodeManager和ResourceManager,而在datanode节点上只启动了NodeManager。

3、 启动JobHistory

# mr-jobhistory-daemon.sh start historyserver

namenode上查看及启动

datanode1上查看

datanode2上查看

JobHistory只在namenode上启动。

1.1.2 单服务停止

1、 停止dfs

# stop-dfs.sh

namenode上查看及停止

datanode1上查看

datanode2上查看

停止dfs,在namenode节点上会停止NameNode、SecondaryNameNode、DataNode,而在datanode节点停止DataNode。

2、 停止yarn

stop-yarn.sh

namenode上查看及停止

datanode1上查看

datanode2上查看

yarn停止后,在nodename上停止了NodeManager和ResourceManager,而在datanode节点上只停止了NodeManager。

3、 停止JobHistory

# mr-jobhistory-daemon.sh stop historyserver

namenode上查看及停止

datanode1上查看

datanode2上查看

JobHistory只在namenode上。

1.2 多服务启动停止方式

1.2.1 多服务启动

1、 启动dfs和yarn

# start-all.sh

namenode上查看及启动

datanode1上查看

datanode2上查看

2、 启动jobhistory

# mr-jobhistory-daemon.sh start historyserver

1.2.2 多服务停止

1、 停止dfs和yarn

# stop-all.sh

namenode上查看及停止

datanode1上查看

datanode2上查看

2、 停止jobhistory

# mr-jobhistory-daemon.sh stop historyserver

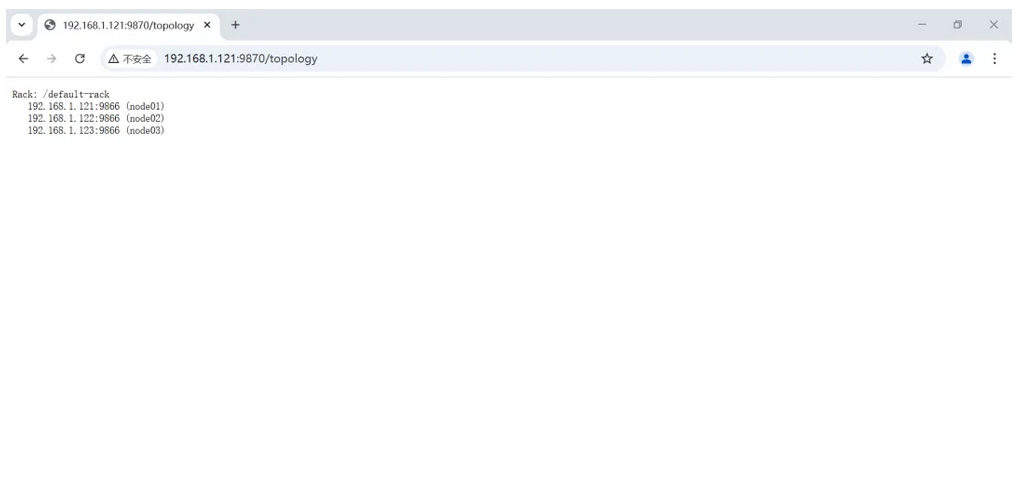

二、获取HDFS集群信息

# hdfs dfsadmin -report

三、HDFS常用命令

3.1 查看HDFS帮助命令

3.1.1 查看hdfs命令使用提示

查看hdfs dfs命令使用提示

# hdfs dfs

3.1.2 查看特定指定的使用方法

# hdfs dfs -help put

3.2 在HDFS上创建目录

在HDFS上创建目录/training/superman_hdfs_data。

# hdfs dfs -mkdir -p /training/superman_hdfs_data

3.3 在HDFS上对目录赋予权限

将HDFS目录“/training/superman_hdfs_data”的权限改为“rwxrwxrwx”,即777(7代表读、写、操作权限;3个7表示同时为当前用户、用户组、其它所有用户开放)权限。

# hadoop fs -chmod -R 777 /training/superman_hdfs_data

3.4 上传文件到HDFS目录

在本地准备测试文件superman01.txt,并上传到HDFS目录/training/superman_hdfs_data中。

3.4.1 在本地生成文件superman01.txt

# echo "Hello Hadoop File System" > superman01.txt

3.4.2 上传文件到HDFS

将文件上传到HDFS的/training/superman_hdfs_data目录中

# hdfs dfs -put superman01.txt /training/superman_hdfs_data

3.5 查看HDFS上的文件及目录

检查测试文件superman01.txt是否上传成功,查看HDFS目录“/training/superman_hdfs_data”的内容,检查测试文件superman01.txt是否上传成功。

# hdfs dfs -ls /training/superman_hdfs_data

3.6 查看HDFS文件的内容

查看HDFS文件/training/superman_hdfs_data/superman01.txt的内容。

# hdfs dfs -cat /training/superman_hdfs_data/superman01.txt

3.7 在HDFS上移动文件

3.7.1 移动文件

将HDFS中的/training/superman_hdfs_data/superman01.txt文件移动到/training目录。

# hdfs dfs -mv /training/superman_hdfs_data/superman01.txt /training/

3.7.2 查看文件是否移动成功

# hdfs dfs -ls /training/

3.8 在HDFS上拷贝文件

3.8.1 拷贝文件

将/training/superman01.txt拷贝一份到/training/superman_hdfs_data目录中。

# hdfs dfs -cp /training/superman01.txt /training/superman_hdfs_data/

3.8.2 查看文件是否拷贝成功

# hdfs dfs -ls /training/superman_hdfs_data/

3.9 在HDFS上删除文件

3.9.1 删除文件

删除/training/目录下的superman01.txt文件。

# hdfs dfs -rm /training/superman01.txt

3.9.2 检查文件是否删除成功

# hdfs dfs -ls /training

3.10 从HDFS上下载文件

3.10.1 下载文件并改名

下载HDFS中的/training/superman_hdfs_data/superman01.txt文件到本地,并改名为superman02.txt(避免名称冲突)。

# hdfs dfs -get /training/superman_hdfs_data/superman01.txt superman02.txt

3.10.2 本地查看文件内容

# cat superman02.txt

原创 超哥的IT私房菜