你描述的流程已经很接近了 SUMO 和深度强化学习(DQN)结合的一个典型工作流程。我可以详细解释一下 SUMO 在仿真优化 DQN 模型时的具体步骤,以及一个 Epoch 是如何设置的。

SUMO仿真与DQN模型结合流程

-

初始化:

- 你首先需要定义一个交通环境,通常使用 SUMO 来仿真。这个环境包括交通信号灯的位置、道路、车辆流量等信息。

- 你需要在仿真中定义状态空间和动作空间。例如,状态空间可以包括交通灯的状态、当前时间的交通状况、车辆排队长度等;动作空间则包括可以对交通灯执行的操作(例如,改变信号灯的红绿灯周期)。

- 然后,需要初始化 DQN 模型,DQN 本质上是一个深度 Q 网络,用来预测每个状态下采取某个动作的价值(Q值)。

-

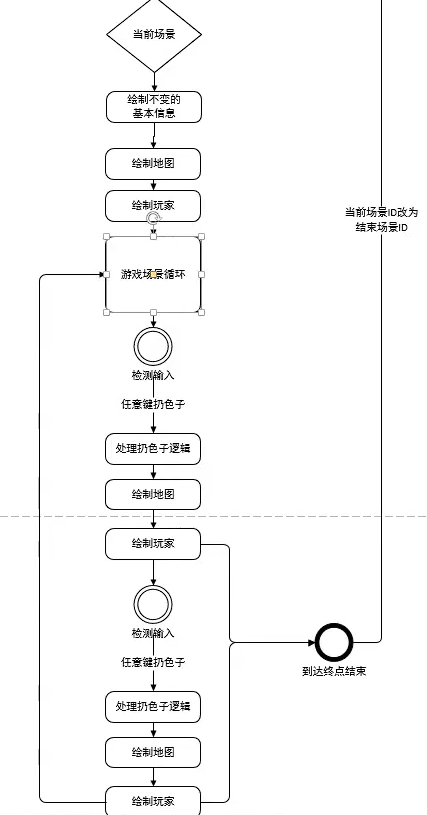

仿真与DQN模型的交互:

- 每个Epoch的设置:

- 在一个 Epoch 中,仿真和 DQN 模型的交互通常是按时间步进行的。每个时间步都代表仿真中一个具体的时刻(通常是仿真的某个离散时间单位,比如1秒或者更短)。

- 一个 epoch 可以包含多个时间步,也就是说,仿真和 DQN 更新模型的过程是逐步进行的,直到完成一个完整的仿真周期。

- 每个Epoch的设置:

-

仿真中的时间步骤:

- 在每个时间步,SUMO 会模拟交通流和交通信号的变化,生成当前的交通状态。这个状态通常包括当前的交通灯状态、车辆的位置、队列长度、交通密度等信息。

- 时间间隔的拆分: 在 SUMO 中,仿真时间是离散化的,通常会按秒进行仿真(但你也可以设置更细粒度的时间间隔)。每个时间段对应着一个仿真步长,仿真会根据这一时间步长进行更新。每个时间步都可以理解为一个 Epoch 中的子步骤。

-

状态与奖励:

- 在每个仿真时间步(或者每个小的 Epoch 中),你都会计算当前的状态,然后使用 DQN 模型来预测该状态下采取某个动作的 Q值。

- 对于交通灯控制来说,当前状态可以是信号灯状态、车辆数、队列长度等,动作则是改变交通灯的状态(例如,绿灯持续时间等)。

- 奖励函数的计算: 计算奖励通常基于某些性能指标,例如通过减少车辆的等待时间、减少交通拥堵、增加通过量等方式来定义奖励。每次仿真结束后,你都会计算当前动作带来的奖励,并将奖励反馈给 DQN 模型。

- 奖励定义的方式:

- 例如,如果车辆通行顺畅,奖励可能是正数;如果出现拥堵,可能是负数。

- 奖励的具体定义依据任务和目标而定,可能涉及多个因素(如交通流量、平均延迟、交通灯周期等)。

- 奖励定义的方式:

-

DQN模型更新:

- 使用 DQN 模型时,你会将当前的状态、所采取的动作、获得的奖励、下一个状态(通常是一个时刻后的状态)等信息存储到一个经验回放池(Replay Buffer)中。

- DQN 会定期从这个回放池中采样一个批次的经验,计算 Q值的损失(Loss),然后通过反向传播来更新 Q 网络的参数。

- Q学习更新公式:

\( Q(s_t, a_t) \leftarrow Q(s_t, a_t) + \alpha \left( r_t + \gamma \max_{a'} Q(s_{t+1}, a') - Q(s_t, a_t) \right) \)- 其中,\(s_t\) 是当前状态,\(a_t\) 是当前动作,\(r_t\) 是当前奖励,\(\gamma\) 是折扣因子,\(\alpha\) 是学习率。

- Q学习更新公式:

-

交通灯控制与仿真迭代:

- 在每一个仿真时间步,DQN 会给出一个最优的动作(即交通灯的变化),仿真会基于这个动作更新交通灯状态,模拟车辆流动。

- 仿真会继续推进,直到完成当前的 Epoch。一个 Epoch 通常代表从仿真开始到结束的一段时间(比如一天或几小时)。

- 在完成一个 Epoch 后,仿真将返回新的状态,DQN 模型则根据更新的参数继续做出决策。

-

结束与评估:

- 完成一个 Epoch 后,通常会对模型的表现进行评估,查看交通流量、拥堵情况、等待时间等指标是否有改善。

- 根据评估结果,调整奖励函数、状态空间、动作空间等,然后重新进行仿真与训练,直到模型收敛或达到期望的效果。

总结:

- 一个 Epoch 代表的是一轮完整的仿真周期(通常包括多个时间步)。每个时间步就是仿真中的一个离散时间单位(例如1秒)。

- 在每个时间步中,SUMO 进行仿真,输出当前状态,计算奖励,然后将奖励反馈给 DQN 模型。

- DQN 模型使用状态、动作和奖励来更新其参数,通过 Q-learning 算法来优化决策策略。

- 每个仿真步(或者说小的 Epoch)都通过 SUMO 更新交通流,交通灯状态,根据 DQN 给出的策略来调整交通灯的行为。

这个过程是一个循环的过程,每个 Epoch 会通过仿真、DQN 更新模型的步骤,逐渐优化交通灯的控制策略,直到找到最优的控制方式。

希望这些说明有助于你更好地理解 SUMO 和 DQN 模型在交通优化中的结合方式。如果有更多细节问题,欢迎继续提问!