1. 什么是残差网络?

残差网络(ResNet)是一种特别的神经网络结构,它解决了一个非常重要的问题:当我们把网络变得越来越深时,性能不升反降的问题。

打个比方:

你让一个学生做很简单的数学题,他可能做得很好;但你让他做一百道题,他可能会累到答错很多,结果总分变低。这种情况在深度学习里就叫梯度消失或梯度爆炸,网络太深了,信息没法有效传递。

残差网络的设计目标就是:让深层网络“轻松”学会该学的东西,避免因为“网络太深”导致性能下降。

2. 核心概念:残差连接(Skip Connection)

残差网络最重要的点就是加入了残差连接。简单来说:

- 它让网络直接跳过一些层,把输入直接加到输出上。

- 这样网络的每一层只需要学习“输入和输出之间的差距”(差距用英文说就是 residual,也就是“残差”)。

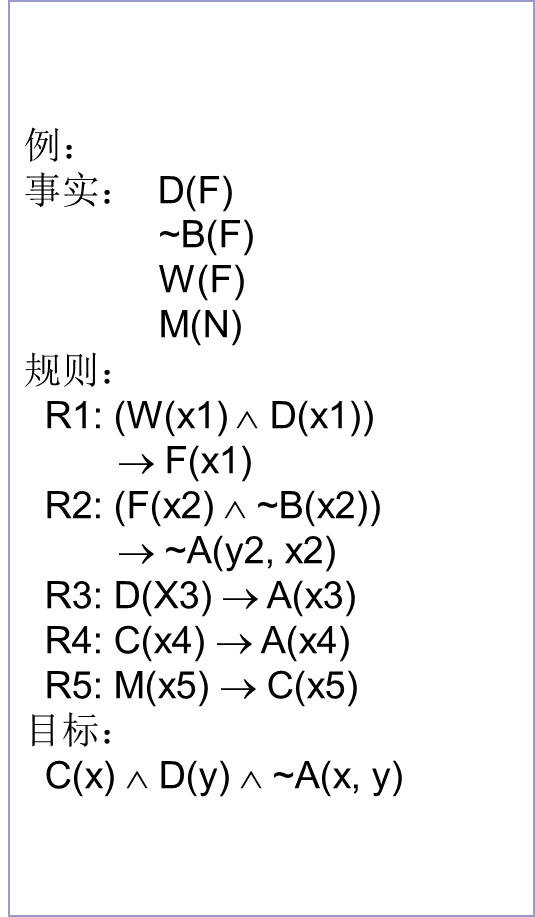

我们用个简单的公式和例子解释:

假设有一个普通的深度学习层: y=F(x)

其中 F(x) 是网络这一层的计算结果,x 是输入。

而在残差网络里,它变成了: y=F(x)+x

也就是说,网络的输出是这一层的计算结果 F(x) 加上输入 x。

这条直接把 x 加到输出上的路径就叫残差连接。

3. 残差网络怎么帮助深度学习?

举个简单的例子来说明:

情况 1:普通的网络(没有残差连接)

假如你想教一个孩子认识数字“7”,你可能直接说:

“从空白纸上画一个7的样子。”

但对于网络来说,越复杂的任务,它“从零开始学习”的难度就越高。

情况 2:有残差连接的网络

换个思路,你对孩子说:

“先画一个‘7’的轮廓,然后把轮廓修得更精确一点。”

这样他只需要“微调”已有的东西,而不是从头开始。这种方法就像残差网络的思想。

因此,残差连接让网络的每一层只需要做很小的调整,而不需要重新学习所有的东西,这大大降低了深层网络训练的难度。

4. 一个简单的类比

想象你要爬一座很高的山:

- 普通的网络:需要一步一步爬山,而且不能回头。爬到后面时,可能累得不行,还容易迷路(梯度消失)。

- 残差网络:给你修了一条“索道”,如果你觉得这一步不好爬,你可以直接坐索道上去。这样,即使你不太会爬山,最起码能到山顶。

这个“索道”就是残差连接,网络会把前面的结果直接传到后面的层,帮助你顺利训练深层网络。

5. 残差网络长什么样?

一个最简单的残差块(Residual Block)的结构大概是这样:

- 输入经过几层计算(比如卷积、归一化、激活函数),得到 F(x)。

- 输入 x 直接跳过这些计算,加到 F(x) 上。

- 输出就是 F(x)+x。

图形化来看,大致是这样的:

输入 (x) → [卷积 + 激活] → F(x) → ↘ ↗→ 残差连接 →这种结构可以反复堆叠很多层,从而形成一个非常深的网络。

6. 为什么残差网络重要?

-

解决梯度消失问题:

深度网络很难训练,但残差网络让深层网络也能正常训练,推动了更深更强模型的发展。 -

性能好:

比如 ResNet 在图像分类任务(如 ImageNet 数据集)上取得了非常好的成绩,后来也被广泛应用到语音识别、自然语言处理等领域。 -

模块化:

残差块设计简单,易于堆叠和扩展,可以灵活组合到不同类型的模型中。

7. 适合小白的代码示例

一个简单的 PyTorch 实现的残差块可以写成:

import torch

import torch.nn as nnclass ResBlock(nn.Module):def __init__(self, in_channels, out_channels):super().__init__()self.conv1 = nn.Conv2d(in_channels, out_channels, kernel_size=3, padding=1)self.conv2 = nn.Conv2d(out_channels, out_channels, kernel_size=3, padding=1)self.relu = nn.ReLU()self.shortcut = nn.Conv2d(in_channels, out_channels, kernel_size=1) if in_channels != out_channels else nn.Identity()def forward(self, x):shortcut = self.shortcut(x) # 残差连接x = self.conv1(x)x = self.relu(x)x = self.conv2(x)return self.relu(x + shortcut) # 残差连接相加使用这个残差块,你可以构建一个简单的网络:

res_block = ResBlock(64, 64)

x = torch.randn(1, 64, 32, 32) # 输入 1张图片,64通道,32x32大小

output = res_block(x)

print(output.shape) # 输出仍然是 (1, 64, 32, 32)

总结

- 残差网络通过引入残差连接,帮助深层网络更快、更容易地学到有效特征。

- 它的关键就是把“学习差距”的思想用到深度学习中。

- ResNet 是深度学习里非常重要的一个里程碑,有着广泛的应用。