前言

近几年这个话题很火,但是我一直没得去尝试一下,今天突然来兴趣想试试,然后就出来了这一篇文档。

环境准备

- docker

安装管理工具

Ollama是一款开源的大模型管理工具,它允许用户在本地便捷地运行多种大型开源模型,包括清华大学的ChatGLM、阿里的千问以及Meta的llama等。目前,Ollama兼容macOS、Linux和Windows三大主流操作系统。

官网:https://ollama.com/

这里我们直接使用docker部署的Ollama,我直接放我的docker-compose文件配置

services:ollama: container_name: ollamaimage: registry.cn-hangzhou.aliyuncs.com/zrng/ollama:0.4.6 # docker.io/ollama/ollama:latestports:- 11434:11434 # 对外端口restart: alwaysenvironment:- OLLAMA_PROXY_URL=http://host.docker.internal:11434/v1 # web ui使用的时候地址填写:http://host.docker.internal:11434volumes:- E:\Data\ollama:/root/.ollama # 挂载数据

- 访问地址为:http://IP:11434

- image地址配置的是阿里云镜像仓库地址,防止拉取失败

- OLLAMA_PROXY_URL:这个是后面填写API 域名的时候要用的

- volumes这个挂载了我的容器数据

执行docker-compose命令后,在容器启动正常后访问Ollama地址判断启动是否正常,比如我这里直接访问:http://localhost:11434/

通过命令进入Ollama容器中,查看是否存在默认的模型

# 查询模型列表

ollama list

现在来安装一个开源模型,我找了一个小一点的模型llama3.2进行测试,也可以去模型仓库中寻找合适的模型:https://ollama.com/library

# 安装大模型

ollama run llama3.2

安装完成可以通过命令行查看模型是否安装成功

现在模型已经安装成功,可以在容器内使用命令行使用模型,也可以使用其他UI服务进行使用

MaxKB

MaxKB = Max Knowledge Base,是一款基于大语言模型和 RAG 的开源知识库问答系统,广泛应用于智能客服、企业内部知识库、学术研究与教育等场景。

官网:https://maxkb.cn/

部署

这个工具我还通过docker工具来创建,还直接放我的docker-compose文件配置

services:maxkb:container_name: maxkb # http://localhost:28080 admin/MaxKB@123..image: registry.cn-hangzhou.aliyuncs.com/zrng/maxkb:1.8.0 # 1panel/maxkbports:- 28080:8080 # 对外端口restart: always

- 访问地址为:IP+28080

- image地址配置的是阿里云镜像仓库的地址,防止拉取失败

现在我访问地址:http://localhost:28080

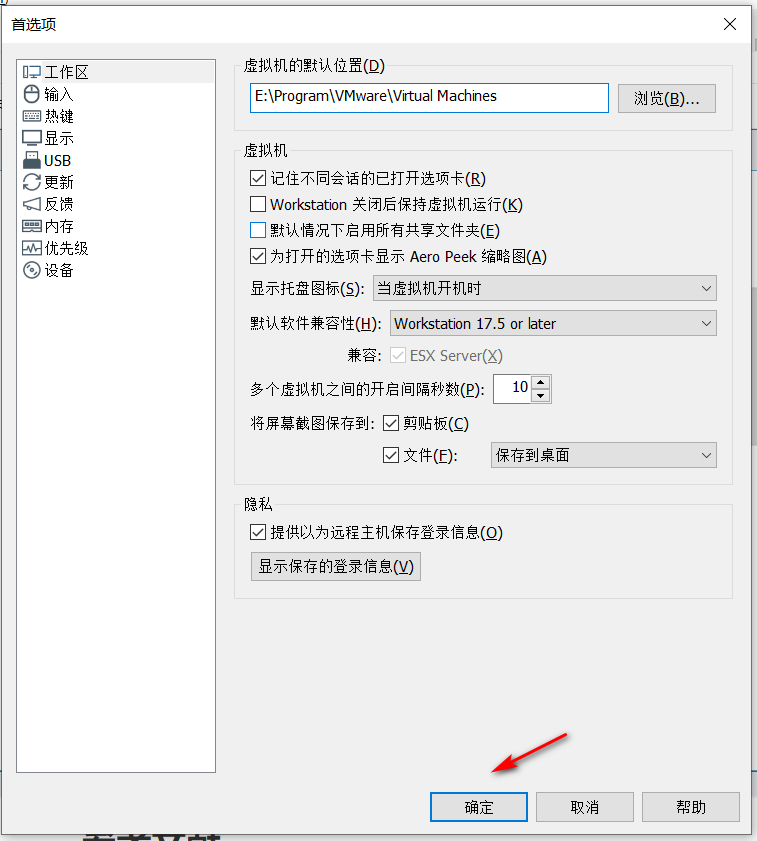

默认用户名/密码:admin/MaxKB@123.. 官方文档地址为:https://maxkb.cn/docs/installation/online_installtion/ ,登录成功后可以按照弹框提示修改默认的密码,然后去系统管理添加模型

添加模型

这里我们可以看到支持很多的大模型

因为我的模型是Ollama,可以选择该私有模型,然后添加模型

添加应用

现在可以添加应用了,到应用界面添加新应用

下面的内容我使用默认的配置,然后点击右上角的保存并发布,然后点击左侧的概览,可以看到应用信息以及访问地址等

直接访问地址:http://localhost:28080/ui/chat/d0a18a63b48e8b94

这里可以就可以输入我们要咨询的内容了,根据电脑配置好坏响应内容的速度也有不同。

嵌入第三方

通过简单的配置可以将该应用嵌入到第三方系统中

知识库

在知识库选项卡,可以新建知识库并导入文本或Web站点等,然后将我们需要支持咨询的内容上传并向量化

然后在应用界面可以关联新建的知识库,以便返回我们更想要的内容。

总结

第一次尝试本地大模型到这暂时结束,后续再去发现更棒的功能。

![折腾笔记[4]-cuda的hello-world](https://img2024.cnblogs.com/blog/1048201/202501/1048201-20250101185632118-953333443.png)