在机器学习领域存在一个普遍的认知误区,即可解释性与准确性存在对立关系。这种观点认为可解释模型在复杂度上存在固有限制,因此无法达到最优性能水平,神经网络之所以能够在各个领域占据主导地位,正是因为其超越了人类可理解的范畴。

其实这种观点存在根本性的谬误。研究表明,黑盒模型在高风险决策场景中往往表现出准确性不足的问题[1],[2],[3]。因此模型的不可解释性应被视为一个需要克服的缺陷,而非获得高准确性的必要条件。这种缺陷既非必然,也非不可避免,在构建可靠的决策系统时必须得到妥善解决。

解决此问题的关键在于可解释性。可解释性是指模型具备向人类展示其决策过程的能力[4]。模型需要能够清晰地展示哪些输入数据、特征或参数对其预测结果产生了影响,从而实现决策过程的透明化。

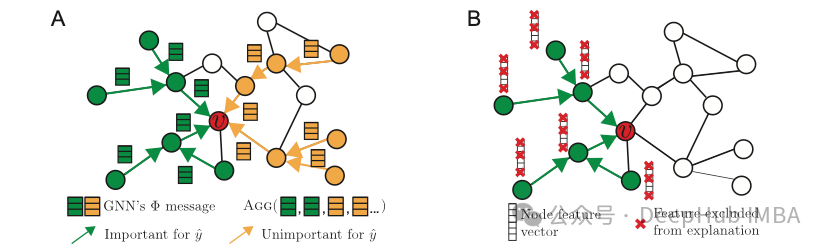

PyTorch Geometric的可解释性模块为图机器学习模型提供了一套完整的可解释性工具[5]。该模块具有以下核心功能:

- 关键图特性识别 — 能够识别并突出显示对模型预测具有重要影响的节点、边和特征。

- 图结构定制与隔离 — 通过特定图组件的掩码操作或关注区域的界定,实现针对性的解释生成。

- 图特性可视化 — 提供多种可视化方法,包括带有边权重透明度的子图展示和top-k特征重要性条形图等。

- 评估指标体系 — 提供多维度的定量评估方法,用于衡量解释的质量。

https://avoid.overfit.cn/post/5c548769e84c4bb598f9617de675be8d