概述

Ollama 是一款旨在简化大语言模型(LLM)本地部署的工具,支持 Windows、Linux 和 MacOS 系统。它提供了一个用户友好的环境,让开发者可以轻松地运行和调优如 Qwen、Llama 等超过1700种的大语言模型。

核心优势

- 多平台兼容性:无缝适配主流操作系统。

- 丰富的模型库:内置了大量预训练模型,直接从官网下载即可使用。

- 个性化配置:通过 modelfile 文件调整模型参数,实现对生成内容的精细控制。

- 自定义模型支持:允许导入第三方 ggml 格式的模型,或转换其他格式的模型至 ggml。

- 高性能推理:优化了多GPU环境下的并行处理能力,提升推理速度。

Ollama 的设计降低了大语言模型的使用门槛,特别适合希望快速构建 AI 应用或针对特定任务进行模型优化的开发者。

官方资源

- 下载页面:Ollama 下载

- 官方网站:Ollama 官方主页

- 源代码仓库:Ollama GitHub

快速安装指南

对于 Linux 用户,Ollama 提供了一键安装脚本,使得安装过程变得极为简便。以下是详细的安装步骤:

-

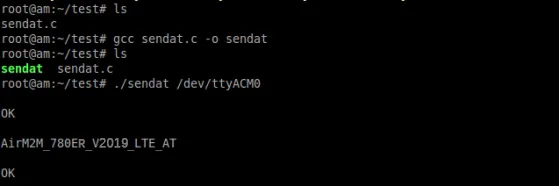

执行一键安装:

curl -fsSL https://ollama.com/install.sh | sh -

启动 Ollama 服务:

ollama serve

如果遇到权限问题(例如提示需要 sudo 权限),建议下载离线安装包以避免权限限制。可以从 GitHub 发布页 获取对应系统的安装包,并按照以下步骤操作:

-

下载离线安装包:

访问发布页,选择适用于您系统的版本下载。 -

解压文件:

tar -xzvf ./ollama-linux-amd64.tgz -

启动 Ollama 服务:

./bin/ollama serve &

为了确保 ollama 命令可以在任何位置被调用,需要将其路径添加到系统的 PATH 环境变量中。这可以通过编辑您的 shell 配置文件(如 .bashrc 或 .zshrc)来完成。

echo 'export PATH=$PATH:/home/ollama/bin' >> ~/.bashrc

echo 'export OLLAMA_KEEP_ALIVE=12h' >> ~/.bashrc

echo 'export OLLAMA_HOST=0.0.0.0:11434' >> ~/.bashrc

echo 'export OLLAMA_MODELS=/data/ollama/models' >> ~/.bashrc

source ~/.bashrc

现在,您可以直接在终端中使用 ollama 命令来管理和运行模型,例如:

ollama run llama3.1:8b

以上步骤将帮助您顺利完成 Ollama 的安装与配置,开始探索大语言模型的世界。