- 1 信息熵

- 1.1 信息

- 1.2 信息熵(entropy)

- 1.3 条件概率

- 1.4 条件熵(Conditional entropy)

- 1.5 联合熵(Joint entropy)

- 1.6 离散随机向量的熵

- 2 信息

1 信息熵

1.1 信息

一个随机事件 \(X\) 发生的概率为 \(p\),那么他的自信息(信息量)为

\[I=-\log p

\]

如果 \(X\) 为多个随机事件的集合,则信息量为

\[I=-\sum_{x\in X}\log p(x)

\]

上述内容表达的为离散的随机变量的计算方法,如果为连续的随机变量,则 \(P(x)\) 表示为概率密度

从上述公式可以看出,信息与事件出现的概率密切相关.

1.2 信息熵(entropy)

信息熵描述了信源整体的不确定程度,又称为平均信息量

\[ H(X)=-\sum_{x\in X}p(x) \log p(x)=-E_{X}[\log p(X)]

\]

Remark: 信息的熵仅仅与其分布有关,而与随机变量 X 的取值无关

显然的,我们可以观察到下面这个关系:

\[ H(X)\leq \log|X|

\]

等号成立的条件为 \(X\) 的分布均匀,任意事件的 \(p\) 相等

1.3 条件概率

在事件 \(B\) 已经发生的条件下,事件 \(A\) 发生的概率,称为条件概率 \(P(A|B)\),记作:

\[ P(A|B)=\frac{P(AB)}{P(B)}

\]

当满足下列任一条件时,可以称事件 \(A\) 与事件 \(B\) 独立,反之认为事件 \(A\) 与事件 \(B\) 相关.

\[ P(A|B)=P(A),\qquad P(AB)=P(A)P(B)

\]

1.4 条件熵(Conditional entropy)

条件熵描述的是以某个时间为前提时,随机变量 \(X\) 的不确定度.

\[ H(X|Y=y)=-\sum_{x\in X}p(x|y)\log p(x|y)

\]

显然的,也可以发现:

\[ H(X|Y)\leq H(X)

\]

等号成立的条件为 \(X,\ Y\) 相互独立

对于多个变量的情况,例如三个变量,如果已知 \(p(y)>0\):

\[p(x,y,z)=\frac{p(x, y)p(y,z)}{p(y)}=p(x,y)p(z|y)=p(x)p(y|x)p(z|y)

\]

注意到,\(p(x,y)=p(x)p(y|x)\).

另外,对于条件概率分布的情况,我们有:

\[\begin{aligned}

H(Y|X)&=-\sum_{x\in X,y\in Y} p(x,y)\log p(y|x)=-E[\log p(Y|X)]\\

&=-\sum_{x\in X}p(x)H(Y|X=x)

\end{aligned}

\]

1.5 联合熵(Joint entropy)

联合熵的可以理解为对于 \((X,\ Y)\) 联合信源的不确定度

\[ H(X,Y)=-\sum_{x\in X, y\in Y}p(x, y)\log p(x, y)=-E[\log p(X,Y)]

\]

注意到:

\[ H(X,Y)=H(X)+H(Y|X)=H(Y)+H(X|Y)

\]

且根据之前的不等式,我们可以观察得到:

\[ H(X,Y)\leq H(X)+H(Y)

\]

1.6 离散随机向量的熵

可以视作条件概率嵌套进行理解和计算:

\[\begin{aligned}

H(x^n)&=H(X_{1})+H(X_{2}|X_{1})+\dots+H(X_{n}|x_{1},\dots X_{n-1}) \\&=\sum^n_{i=1}H(X_{i}|x_{1},\dots,X_{i-1}) \\&=\sum^n_{i=1}H(X_{i}|x^{i-1}) \\

\end{aligned}

\]

2 信息

2.1 互信息

对于随机变量 \(X,\ Y\),二者的互信息定义为:

\[I(X;Y)=\sum_{x,y}p(x,y)\log \frac{p(x,y)}{p(x)p(y)}=E\left[ \log \frac{p(X,Y)}{p(X)p(Y)} \right]

\]

上述定义中的 \(X,\ Y\) 可以互相调换位置

注意到: \(\frac{p(x,y)}{p(y)}=p(x|y)\),则有:

\[I(X;Y)=\sum_{x,y}p(x,y)\log \frac{p(x|y)}{p(x)}=E\left[ \log \frac{p(X|Y)}{p(X)} \right]

\]

Tip 1: 随机变量 X 与其自身的互信息等于 X 的熵

\[I(X;X)=H(X)

\]

Proof:

\[\begin{aligned}

I(X;X)&=E\left[ \log \frac{p(X,X)}{p(X)p(X)} \right]\\

&=E\left[ \log \frac{p(X)}{p(X)p(X)} \right]\\

&=E\left[ \log \frac{1}{p(X)} \right]\\

&=-E\left[ \log p(X) \right]=H(X)

\end{aligned}

\]

Tip 2: 互信息与信息熵的关系

\[\begin{aligned}

I(X;Y)&=H(X)-H(X|Y),\\

I(X;Y)&=H(Y)-H(Y|X),\\

I(X;Y)&=H(X)+H(Y)-H(X,Y)

\end{aligned}

\]

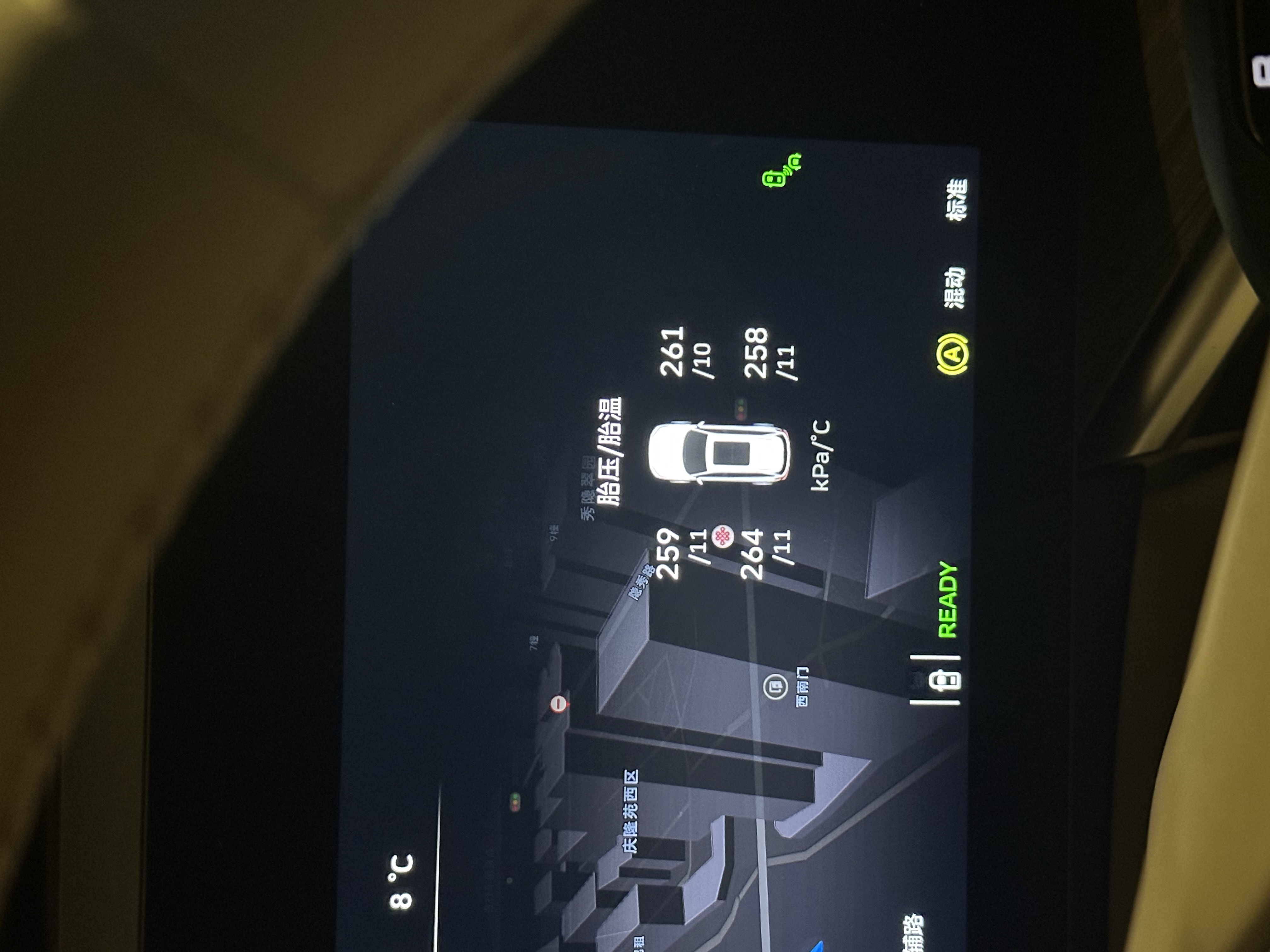

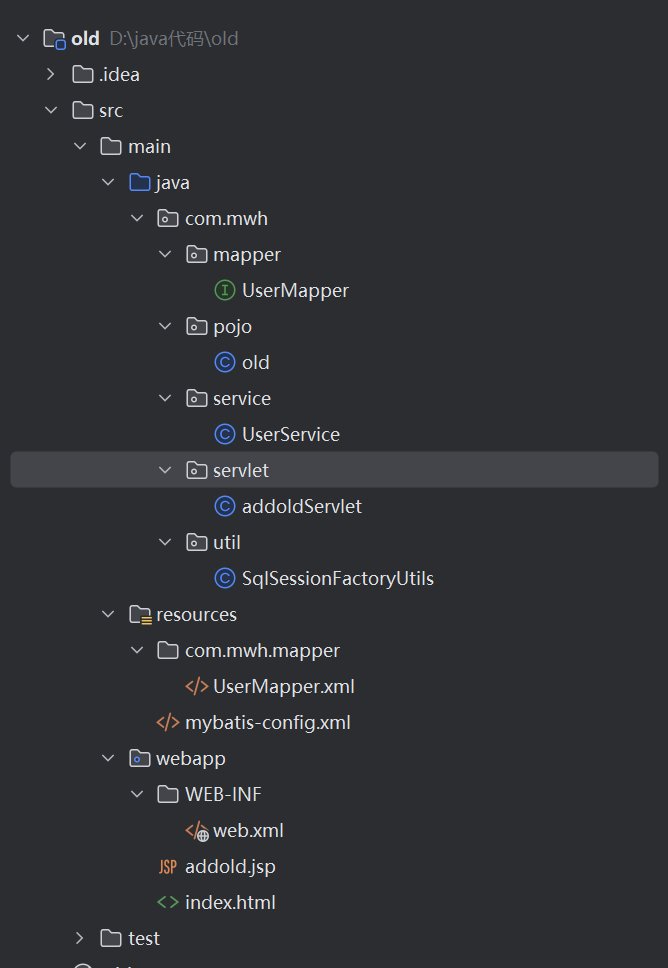

即互信息可以理解为 \(X,\ Y\) 的信息熵的相同部分

![[Pasted image 20250117212850.png]]

上图中,\(H(X,Y)\) 为两个圆之和,而对应随机变量的熵代表着对应的圆

2.2 条件互信息

对于随机变量 \(X\),\(Y\) 和 \(Z\),当给定 \(Z\) 的时候,三者的互信息定义为:

\[I(X,Y|Z)=\sum_{x,y,z}p(x,y,z)\log \frac{p(x,y|z)}{p(x|z)p(y|z)}=E\left[ \log \frac{p(X,Y|Z)}{p(X|Z)P(Y|Z)} \right]

\]

Tip 1: 条件互信息与互信息的关系

\[\begin{aligned}

I(X;Y|Z)=\sum_{z}&p(z)I(X;Y|Z=z)\\

where\quad I(X;Y|Z=z)&=\sum_{x,y}p(x,y|z)\log \frac{p(x,y|z)}{p(x|z)p(y|z)}

\end{aligned}

\]

Tip 2: 随机变量 Z 为条件下,随机变量 X 与其自身的条件互信息等于给定条件 Z 情况下的 X 的条件熵

\[I(X;X|Z)=H(X|Z)

\]

Tip 3: 基于 2.1 tip 2,我们可以容易进行推广

\[\begin{aligned}

I(X;Y|Z)&=H(X|Z)-H(X|Y,Z),\\

I(X;Y|Z)&=H(Y|Z)-H(Y|X,Z),\\

I(X;Y|Z)&=H(X|Z)+H(Y|Z)-H(X,Y|Z)

\end{aligned}

\]

还没学完,边学边写/(ㄒoㄒ)/~~

1 Network Information Theory, Abbas El Gamal, Young-Han Kim

2 Information Theory and Network Coding, Raymond W. Yeung