模型的命名方式:模型名称_用户名称_仓库名称.gguf

DeepSeek-R1-Distill-Llama-8B-Q2_K_L_unsloth_DeepSeek-R1-Distill-Llama-8B-GGUF.gguf

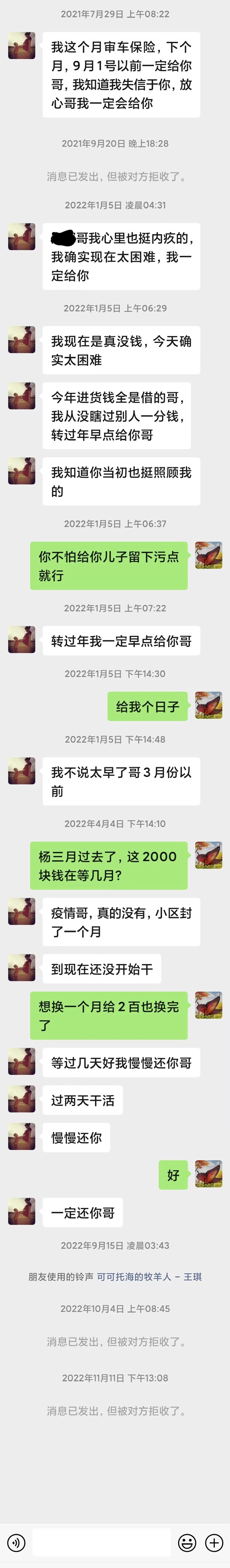

问他问题,他一直回复:“请告诉我问题和需求,请给我细节”,教我怎么使用,却不告诉我答案,不知道该如何使用它

shuttle-jaguar-Q4_K_S_shuttleai_shuttle-jaguar.gguf

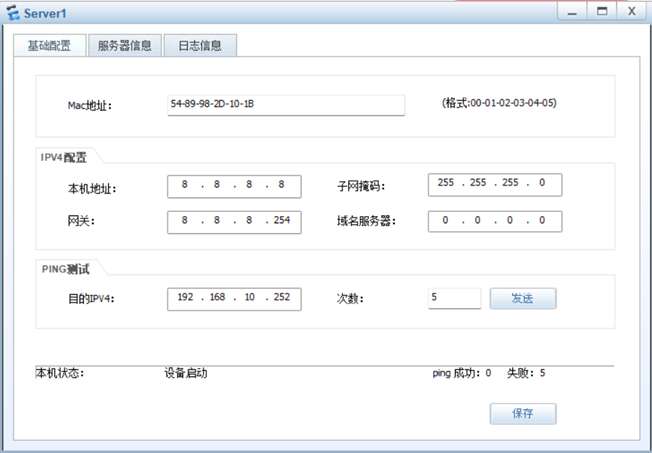

无法起服务,因为不知道名为flux的模型架构

Model-7.6B-Q4_0_openbmb_MiniCPM-o-2_6-gguf.gguf

中文版chatgpt,差不多能用。还有翻译功能,中英日均可

Violet_Twilight-v0.2.IQ1_S_Epiculous_Violet_Twilight-v0.2-GGUF_en.gguf

英文版chatgpt,只会说英文。

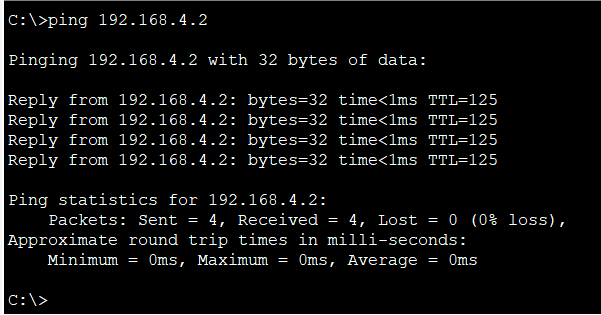

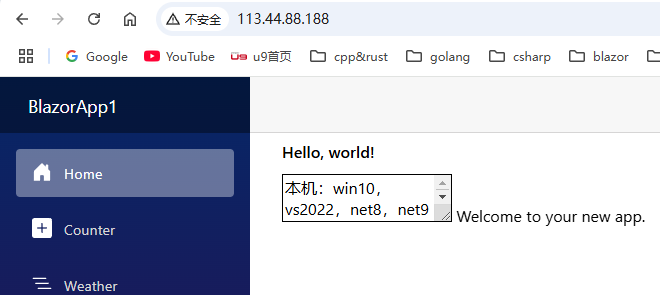

import subprocessos.chdir('llama-server/s/directory')

os.environ['CUDA_VISIBLE_DEVICES']='-1'

# subprocess.run('llama-server.exe --model "C:/Users/tellw/Downloads/Violet_Twilight-v0.2.IQ1_S_Epiculous_Violet_Twilight-v0.2-GGUF_en.gguf" -c 2048 -ngl 200 -a Violet_Twilight-v0.2.IQ1_S_Epiculous_Violet_Twilight-v0.2-GGUF_en.gguf" --host 127.0.0.1 --port 8080 -np 1 --metrics --slots -fa --no-mmap',shell=True)

subprocess.run('llama-server.exe --model "C:/Users/tellw/Downloads/Model-7.6B-Q4_0_openbmb_MiniCPM-o-2_6-gguf.gguf" -c 2048 -ngl 200 -a Model-7.6B-Q4_0_openbmb_MiniCPM-o-2_6-gguf.gguf" --host 127.0.0.1 --port 8080 -np 1 --metrics --slots -fa --no-mmap',shell=True)

创建于2501312314,修改于2501312314

![[Tools] 发布代码](https://resource.duyiedu.com/xiejie/2023-06-07-075420.png)