在本教程中,我们将使用 PyTorch 实现一个验证码识别系统。验证码通常由随机生成的字符组成,我们可以通过训练一个卷积神经网络(CNN)来识别这些字符。本文将介绍如何使用 PyTorch 构建一个简单的 CNN 模型来识别验证码图像,并通过数据预处理和模型训练来提高识别精度。

- 环境准备

首先,确保你已经安装了 PyTorch 和其他必要的库。可以使用以下命令安装所需的依赖:

bash

更多内容访问ttocr.com或联系1436423940

pip install torch torchvision opencv-python numpy matplotlib pillow

在本教程中,我们将使用 PyTorch 和 OpenCV 来处理图像数据,并使用 CNN 模型进行验证码识别。

- 构建卷积神经网络(CNN)

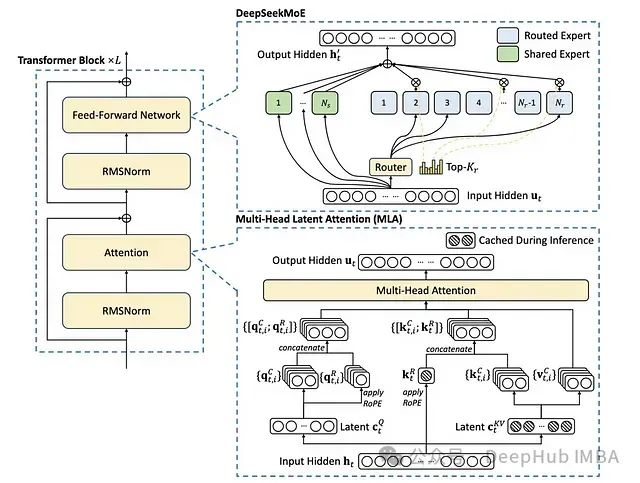

在本部分,我们将构建一个基本的 CNN,用于验证码识别。该网络包含多个卷积层(Convolutional Layers)、池化层(Pooling Layers)和全连接层(Fully Connected Layers)。

(1) 定义 CNN 模型

python

import torch

import torch.nn as nn

import torch.optim as optim

class CaptchaCNN(nn.Module):

def init(self, num_classes):

super(CaptchaCNN, self).init()

self.conv1 = nn.Conv2d(1, 32, kernel_size=3, padding=1)

self.conv2 = nn.Conv2d(32, 64, kernel_size=3, padding=1)

self.conv3 = nn.Conv2d(64, 128, kernel_size=3, padding=1)

self.pool = nn.MaxPool2d(2, 2)self.fc1 = nn.Linear(128 * 8 * 8, 512)self.fc2 = nn.Linear(512, num_classes)def forward(self, x):x = self.pool(torch.relu(self.conv1(x)))x = self.pool(torch.relu(self.conv2(x)))x = self.pool(torch.relu(self.conv3(x)))x = x.view(-1, 128 * 8 * 8) # Flatten the tensorx = torch.relu(self.fc1(x))x = self.fc2(x)return x

(2) 模型解释

卷积层(Conv2d):用于提取图像的局部特征,如字符的边缘和轮廓。

池化层(MaxPool2d):通过对图像进行池化,减小特征图的尺寸,减少计算量。

全连接层(Linear):将卷积层提取的特征映射到最终的分类空间。

激活函数(ReLU):引入非线性,以提高模型的表现力。

3. 数据预处理

为了使用 CNN 进行验证码识别,我们需要对图像进行预处理。我们将使用 OpenCV 来读取和处理图像,然后将其转换为适合模型输入的格式。

(1) 读取并处理图像

python

import cv2

import numpy as np

import os

from PIL import Image

图像预处理:读取图像,转换为灰度图,归一化,调整尺寸

def preprocess_image(image_path):

# 读取图像并转换为灰度

img = cv2.imread(image_path, cv2.IMREAD_GRAYSCALE)

# 调整图像大小

img = cv2.resize(img, (128, 64)) # 将图像调整为 128x64 尺寸# 归一化:将像素值缩放到 [0, 1]

img = img / 255.0

img = np.expand_dims(img, axis=-1) # 增加颜色通道维度# 转换为 Tensor

img_tensor = torch.tensor(img, dtype=torch.float32)

img_tensor = img_tensor.unsqueeze(0) # 增加批次维度

return img_tensor

(2) 加载数据集

我们假设数据集包含图像文件和相应的标签。每个图像文件名中包含标签(例如 "A12B.png"),我们将从文件名中提取标签并进行编码。

python

def load_data(data_dir):

images = []

labels = []

char_set = 'ABCDEFGHIJKLMNOPQRSTUVWXYZ0123456789' # 字符集

for filename in os.listdir(data_dir):if filename.endswith(".png"):img_path = os.path.join(data_dir, filename)img = preprocess_image(img_path)images.append(img)# 从文件名提取标签(假设文件名为字符序列:A12B.png)label = filename.split(".")[0]label_encoded = [char_set.index(c) for c in label]labels.append(label_encoded)images = np.array(images)

return images, labels

- 模型训练

训练模型时,我们需要将标签进行适当的处理,并使用 交叉熵损失(Cross-Entropy Loss)来优化模型。

(1) 准备训练数据

将标签转换为 Tensor,并且创建数据加载器(DataLoader)来批量处理数据。

python

from torch.utils.data import Dataset, DataLoader

class CaptchaDataset(Dataset):

def init(self, image_paths, labels, char_set):

self.image_paths = image_paths

self.labels = labels

self.char_set = char_set

def __len__(self):return len(self.image_paths)def __getitem__(self, idx):image = preprocess_image(self.image_paths[idx])label = self.labels[idx]return image, torch.tensor(label)

准备数据集

image_paths = ['captcha_images/' + filename for filename in os.listdir('captcha_images')]

dataset = CaptchaDataset(image_paths, labels, char_set)

dataloader = DataLoader(dataset, batch_size=32, shuffle=True)

(2) 训练模型

python

初始化模型、损失函数和优化器

num_classes = len(char_set)

model = CaptchaCNN(num_classes=num_classes)

criterion = nn.CrossEntropyLoss() # 交叉熵损失

optimizer = optim.Adam(model.parameters(), lr=0.001)

训练模型

num_epochs = 10

for epoch in range(num_epochs):

model.train()

running_loss = 0.0

for i, (inputs, labels) in enumerate(dataloader):

optimizer.zero_grad()

# 前向传播outputs = model(inputs)# 计算损失loss = criterion(outputs, labels)# 反向传播loss.backward()optimizer.step()running_loss += loss.item()print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {running_loss/len(dataloader):.4f}')

(3) 模型评估

评估模型时,可以使用测试集进行验证,并计算模型的准确性。

python

在测试集上评估

model.eval()

test_images, test_labels = load_data('captcha_test_images')

with torch.no_grad():

correct = 0

total = 0

for i, (inputs, labels) in enumerate(test_images):

outputs = model(inputs)

_, predicted = torch.max(outputs, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

accuracy = 100 * correct / total

print(f'Test Accuracy: {accuracy:.2f}%')