Ollama是一个功能强大的本地大语言模型的运行框架,用户可以非常简单地运行使用各种LLM。最最主要的是它完全免费,本地可以离线运行;

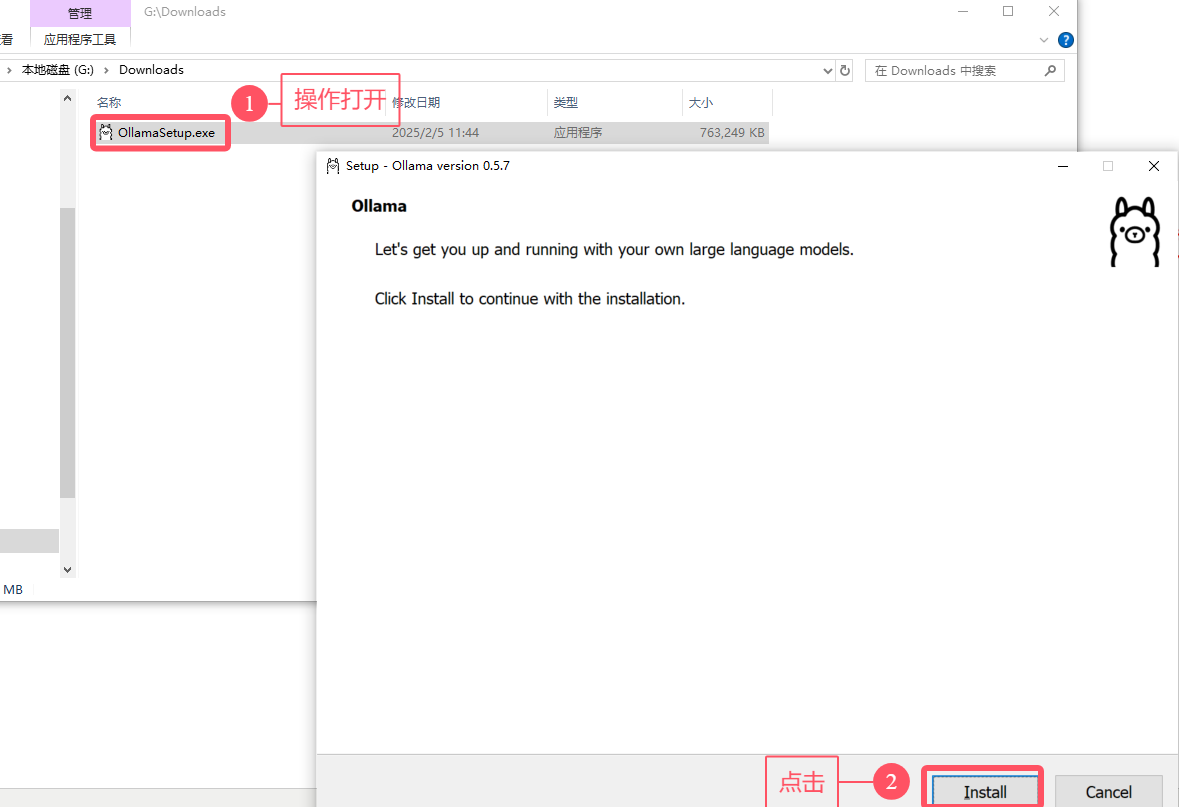

1. 最简单的安装:

curl https://ollama.ai/install.sh | sh

2.也可以访问ollam.com直接点击下载安装

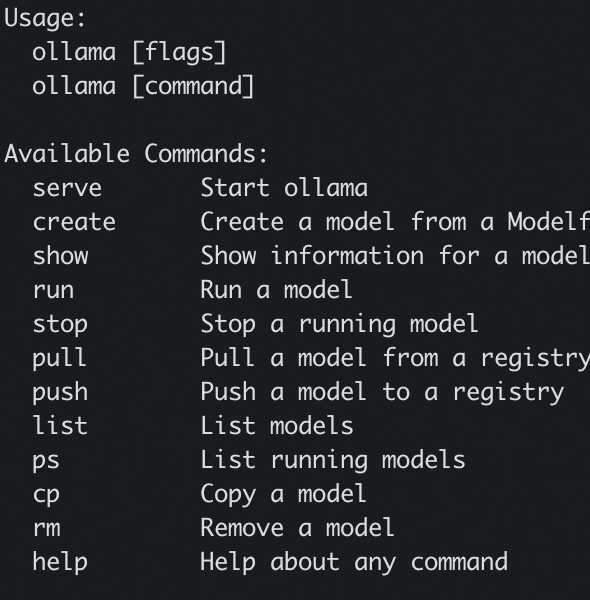

3. 安装完成之后,ollama list一下可以看到本地已经有的LLM情况;

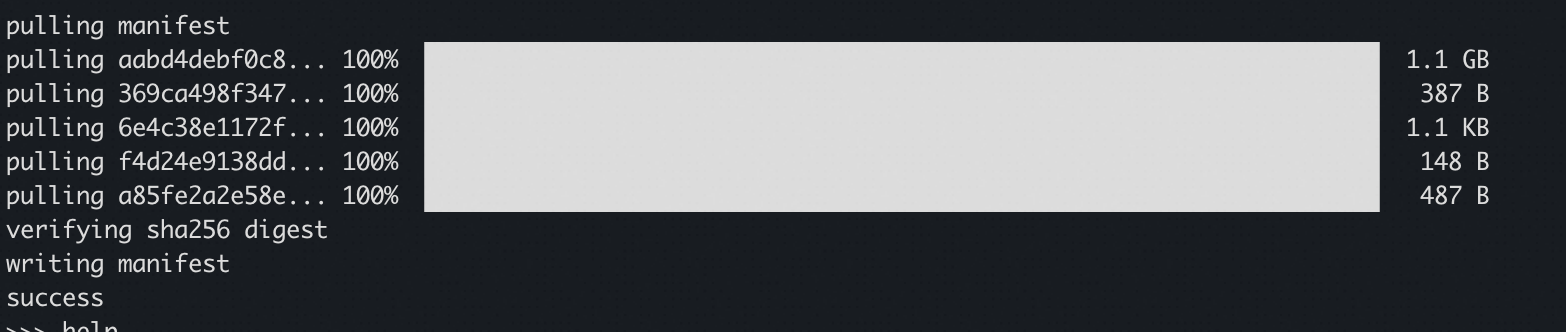

使用最基本的命令运行:ollama run deepseek-r1:1.5b

如何运行deepseek?运行模型很简单,确定好想要的模型后,复制对应的命令到你的终端并执行。

上面的命令运行之后就直接可以和deepseek-r1:1.5b大语言模型做交互;

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70b

顺便附上不同的deepseek的模型可以做的事情以及对系统配置的依赖情况:

1. DeepSeek-R1-1.5B

- CPU: 最低 4 核(推荐 Intel/AMD 多核处理器)

- 内存: 8GB+

- 硬盘: 3GB+ 存储空间(模型文件约 1.5-2GB)

- 显卡: 非必需(纯 CPU 推理),若 GPU 加速可选 4GB+ 显存(如 GTX 1650)

- 场景:

- 低资源设备部署(如树莓派、旧款笔记本)

- 实时文本生成(聊天机器人、简单问答)

- 嵌入式系统或物联网设备

2. DeepSeek-R1-7B

- CPU: 8 核以上(推荐现代多核 CPU)

- 内存: 16GB+

- 硬盘: 8GB+(模型文件约 4-5GB)

- 显卡: 推荐 8GB+ 显存(如 RTX 3070/4060)

- 场景:

- 本地开发测试(中小型企业)

- 中等复杂度 NLP 任务(文本摘要、翻译)

- 轻量级多轮对话系统

3. DeepSeek-R1-8B

- 硬件需求: 与 7B 相近,略高 10-20%

- 场景:

- 需更高精度的轻量级任务(如代码生成、逻辑推理)

4. DeepSeek-R1-14B

- CPU: 12 核以上

- 内存: 32GB+

- 硬盘: 15GB+

- 显卡: 16GB+ 显存(如 RTX 4090 或 A5000)

- 场景:

- 企业级复杂任务(合同分析、报告生成)

- 长文本理解与生成(书籍/论文辅助写作)

5. DeepSeek-R1-32B

- CPU: 16 核以上(如 AMD Ryzen 9 或 Intel i9)

- 内存: 64GB+

- 硬盘: 30GB+

- 显卡: 24GB+ 显存(如 A100 40GB 或双卡 RTX 3090)

- 场景:

- 高精度专业领域任务(医疗/法律咨询)

- 多模态任务预处理(需结合其他框架)

6. DeepSeek-R1-70B

- CPU: 32 核以上(服务器级 CPU)

- 内存: 128GB+

- 硬盘: 70GB+

- 显卡: 多卡并行(如 2x A100 80GB 或 4x RTX 4090)

- 场景:

- 科研机构/大型企业(金融预测、大规模数据分析)

- 高复杂度生成任务(创意写作、算法设计)

7. DeepSeek-R1-671B

- CPU: 64 核以上(服务器集群)

- 内存: 512GB+

- 硬盘: 300GB+

- 显卡: 多节点分布式训练(如 8x A100/H100)

- 场景:

- 国家级/超大规模 AI 研究(如气候建模、基因组分析)

- 通用人工智能(AGI)探索

-

Reference:

https://www.53ai.com/news/finetuning/2025020418637.html