摘要:2025 年 1 月,DeepSeek 的 R1 模型发布一周之后,DeepSeek 刷屏主流媒体和社交网站。但由于一些原因,DeepSeek 的网页和 API 多次提示服务器繁忙。本文基于一开源 LLM 服务工具 Ollama 对本地部署 DeepSeek-R1 蒸馏小模型提供了一种方法。

关键词:DeepSeek,Ollama,部署

一、Ollama 的安装

用户可以访问 Ollama 官网或其 GitHub 仓库进行下载。

二、DeepSeek 的部署和使用

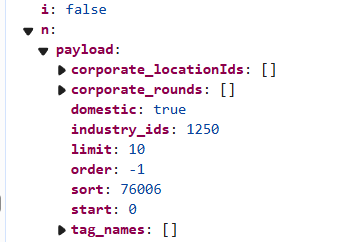

用户可以打开命令行程序,输入命令 ollama run <模型名> 来进行模型的部署和使用。

如果用户未曾安装过对应的模型,则 Ollama 会在联网的条件下自动下载模型;反之则会打开模型的会话。

想要查询对应的模型名称,可以在 Ollama 官网 Models 选项中进行搜索,找到适合自己设备的版本。