L0G2-Python 前置基础

1. 任务一 Leetcode 383

通过的截图

通过的代码

class Solution(object):def canConstruct(self, ransomNote, magazine):""":type ransomNote: str:type magazine: str:rtype: bool"""# 只使用 defaultdict(int) 避免 if 语句(默认值是 0,不用手动检查 key)。ransomNotedict = defaultdict(int)for i in ransomNote:ransomNotedict[i] += 1magazinedict = defaultdict(int)for i in magazine:magazinedict[i] += 1for k, v in ransomNotedict.items():if k not in magazinedict or magazinedict[k] < v:return Falsereturn True2. 任务二 Vscode连接InternStudio debug

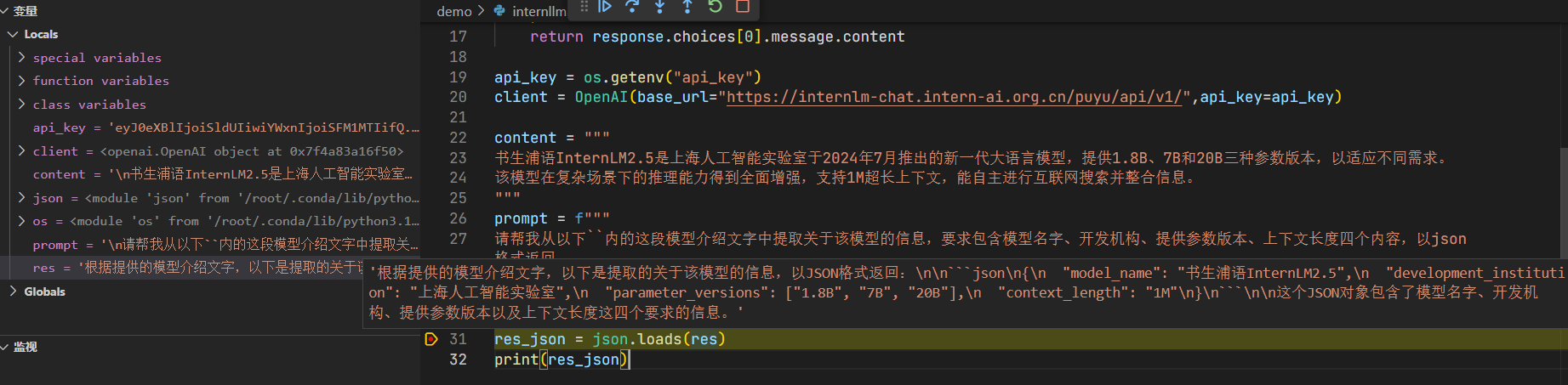

2.1 用获取环境变量的方式导入api_key

from openai import OpenAI

import json

import os

def internlm_gen(prompt,client):'''LLM生成函数Param prompt: prompt stringParam client: OpenAI client '''response = client.chat.completions.create(model="internlm2.5-latest",messages=[{"role": "user", "content": prompt},],stream=False)return response.choices[0].message.contentapi_key = os.getenv("api_key")

client = OpenAI(base_url="https://internlm-chat.intern-ai.org.cn/puyu/api/v1/",api_key=api_key)content = """

书生浦语InternLM2.5是上海人工智能实验室于2024年7月推出的新一代大语言模型,提供1.8B、7B和20B三种参数版本,以适应不同需求。

该模型在复杂场景下的推理能力得到全面增强,支持1M超长上下文,能自主进行互联网搜索并整合信息。

"""

prompt = f"""

请帮我从以下``内的这段模型介绍文字中提取关于该模型的信息,要求包含模型名字、开发机构、提供参数版本、上下文长度四个内容,以json格式返回。

`{content}`

"""

res = internlm_gen(prompt,client)

res_json = json.loads(res)

print(res_json)

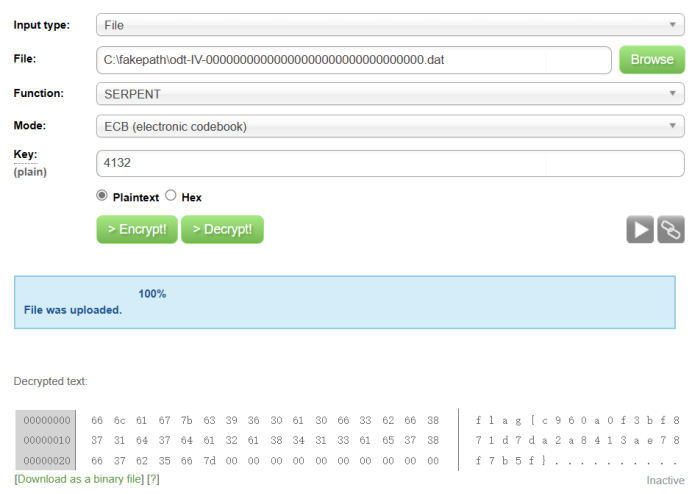

2.2 运行代码,查看控制台错误输出并启动debug

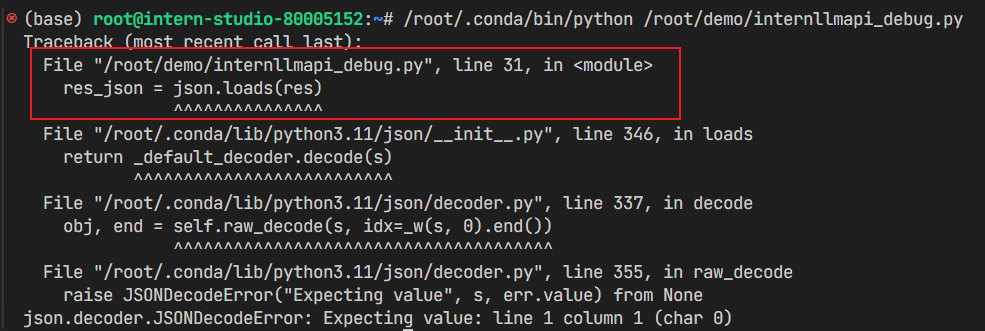

可以发现是31行报错,json.loads()函数的作用是将JSON 格式的字符串解析为Python 中的字典、列表等数据类型,以便在代码中进行处理和操作。它报错,猜测可能的原因是res不能正确解析,我们通过vscode的debug功能查看一下res的值如下:

'根据提供的模型介绍文字,以下是提取的关于该模型的信息,以JSON格式返回:\n\n```json\n{\n "model_name": "书生浦语InternLM2.5",\n "development_institution": "上海人工智能实验室",\n "parameter_versions": ["1.8B", "7B", "20B"],\n "context_length": "1M"\n}\n```\n\n这个JSON对象包含了模型名字、开发机构、提供参数版本以及上下文长度这四个要求的信息。'

可以发现这不是纯粹的json格式,所以json.loads()不能成功解析。

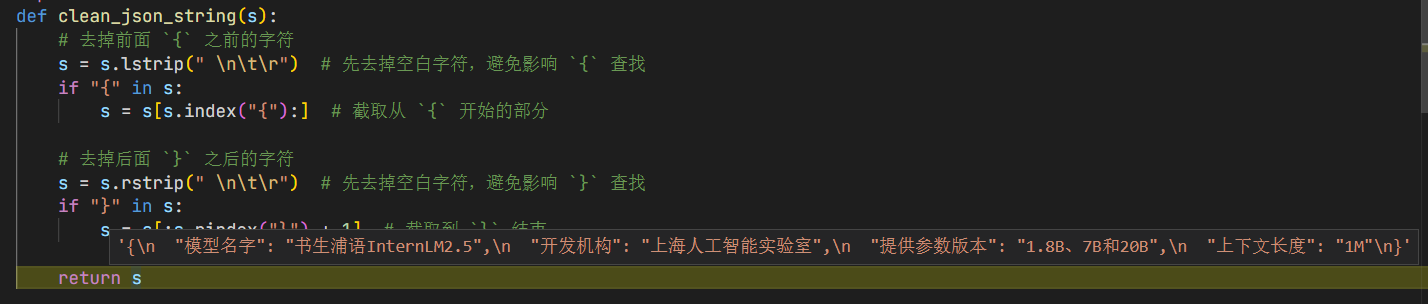

2.3 修复bug

把字符串当前前后多余字符去掉,前面必须以{开头,后面必须以}结尾。

增加clean_json_string函数,修改后的正确代码如下:

from openai import OpenAI

import json

import os

def clean_json_string(s):# 去掉前面 `{` 之前的字符s = s.lstrip(" \n\t\r") # 先去掉空白字符,避免影响 `{` 查找if "{" in s:s = s[s.index("{"):] # 截取从 `{` 开始的部分# 去掉后面 `}` 之后的字符s = s.rstrip(" \n\t\r") # 先去掉空白字符,避免影响 `}` 查找if "}" in s:s = s[:s.rindex("}") + 1] # 截取到 `}` 结束return sdef internlm_gen(prompt,client):'''LLM生成函数Param prompt: prompt stringParam client: OpenAI client '''response = client.chat.completions.create(model="internlm2.5-latest",messages=[{"role": "user", "content": prompt},],stream=False)return response.choices[0].message.contentapi_key = os.getenv("api_key")

client = OpenAI(base_url="https://internlm-chat.intern-ai.org.cn/puyu/api/v1/",api_key=api_key)content = """

书生浦语InternLM2.5是上海人工智能实验室于2024年7月推出的新一代大语言模型,提供1.8B、7B和20B三种参数版本,以适应不同需求。

该模型在复杂场景下的推理能力得到全面增强,支持1M超长上下文,能自主进行互联网搜索并整合信息。

"""

prompt = f"""

请帮我从以下``内的这段模型介绍文字中提取关于该模型的信息,要求包含模型名字、开发机构、提供参数版本、上下文长度四个内容,以json格式返回。

`{content}`

"""

res = internlm_gen(prompt,client)

res_json = json.loads(clean_json_string(res))

print(res_json)

去除了无关字符后得到的Json字符串如下:

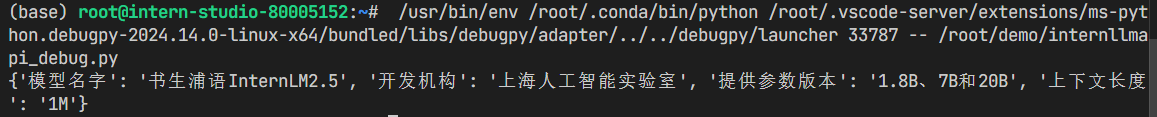

正确的输出结果如下:

3. 知识积累

vscode的条件断点

在调试(Debug)过程中,断点(Breakpoint)允许程序员在程序的执行流程中设置暂停点。当程序运行到这些断点时,执行会暂时中断,使得我们可以检查此时程序的状态,包括变量的值、内存的内容等。断点为我们提供了一个观察程序运行细节的机会,从而帮助我们定位和解决程序中的错误或问题。在VSCode中,我们还可以设置条件断点,这样断点只有在满足特定条件时才会触发。

- 普通断点:在代码行号左侧点击,添加断点。

- 条件断点:在断点标记上右键,选择条件断点(conditional breakpoint)。VSCode 中常用的条件断点主要有三种类型:

- 表达式(Expression):输入一个 Python 表达式,每次触发断点时运行该表达式,当表达式的值为 True 时 VS Code 会暂停执行。例如:x == 10

- 触发计数(Hit Count):断点触发计数达到输入值时才会暂停运行。

记录日志(Log Message):触发该断点时在 Debug Console 中输出指定信息,实际上就是 - logpoint。需要输入要输出的信息,如果要用到表达式,可以使用 {} 将表达式括起来。例如,每次记录变量 i 的值可以写 x={i}。

条件断点中,表达式断点和触发计数断点是“或”的关系,即满足一个条件程序就会暂停。

当一个断点被设置为logpoint断点时,它不会暂停程序。如果这个断点同时还添加了表达式条件或者计数条件,则只在满足条件时才会输出日志信息到调试控制台。

带参数调试

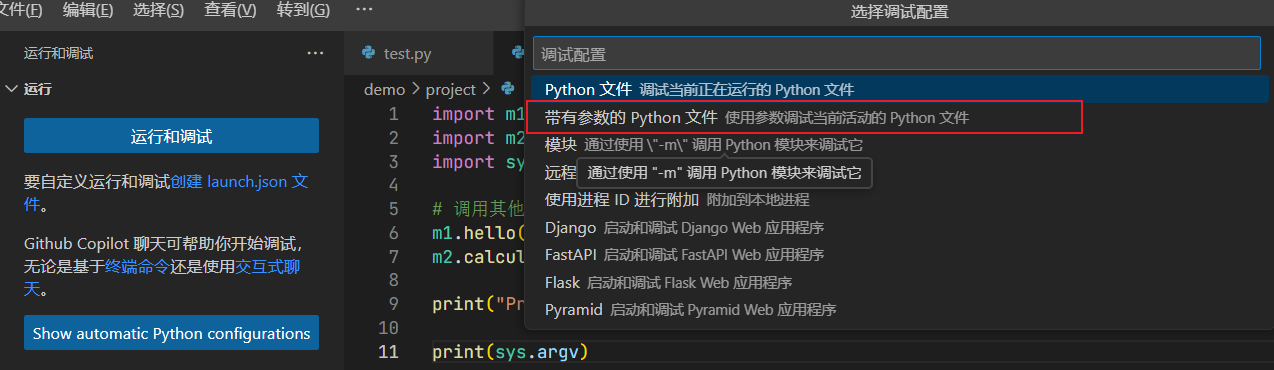

1. 配置调试

- 打开你的Python文件,点击左侧活动栏的“运行和调试”图标。

- 首次debug需要配置以下,点击“创建launch.json file”,选择python debugger后选择“带有参数的Python文件” config。

得到的launch.json如下:

{// 使用 IntelliSense 了解相关属性。 // 悬停以查看现有属性的描述。// 欲了解更多信息,请访问: https://go.microsoft.com/fwlink/?linkid=830387"version": "0.2.0","configurations": [{"name": "Python 调试程序: 包含参数的当前文件","type": "debugpy","request": "launch","program": "${file}","console": "integratedTerminal","args": ["${command:pickArgs}"]}]

}

修改args属性的值为我们需要传入的参数:

{// 使用 IntelliSense 了解相关属性。 // 悬停以查看现有属性的描述。// 欲了解更多信息,请访问: https://go.microsoft.com/fwlink/?linkid=830387"version": "0.2.0","configurations": [{"name": "Python 调试程序: 包含参数的当前文件","type": "debugpy","request": "launch","program": "${file}","console": "integratedTerminal","args": ["-a","-b","-c"]}]

}

2. 简单的demo

import sysprint(sys.argv)

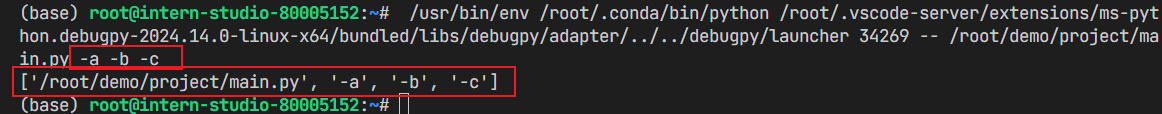

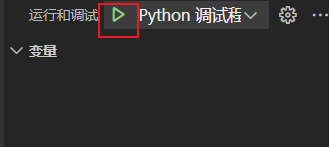

3. 点击绿色箭头,以刚刚的配置启动调试

在终端中可以看到我们配置的参数已经传入到python文件中了。同时,程序运行的结果也说明python文件可以获取到我们传入的参数。