本地部署大模型的工具

| 工具 | 优缺点 |

|---|---|

| LM Studio | 图形界面友好,支持API访问,参数配置灵活 |

| Ollama | GPU优化不足,CPU占用率高 |

| Chatbox | 易出现输入卡顿,交互体验待优化 |

Ollama 和 Chatbox 需要配合使用。

综合看更推荐使用 LM Studio 。

自定义模型

LM Studio 和 Ollama 除了使用默认的模型,还可以使用 HuggingFace 上的模型。

LM Studio 可以直接下载 gguf 格式的模型到模型文件夹。

Ollama 则可以通过如下步骤将 gguf 格式的模型导入到 Ollama 模型库中。

基本步骤如下:

- 准备GGUF模型文件

- 从 HuggingFace 下载目标模型

- 创建ModelFile

FROM ./mistral-7b-instruct-v0.1.Q4_K_M.gguf PARAMETER num_ctx 4096 - 构建&运行模型

ollama create example -f Modelfile ollama run example

模型大小选取公式

可以根据一下公式简单评估自己的电脑能够运行多大的模型。

快速响应条件:模型大小 < (VRAM - 2GB)

最佳表现条件:模型大小 ≈ (VRAM + 空闲RAM - 2GB)

注意实际电脑正常运行时可能就会占用部分内存,所以最佳表现条件值可能需要更小。

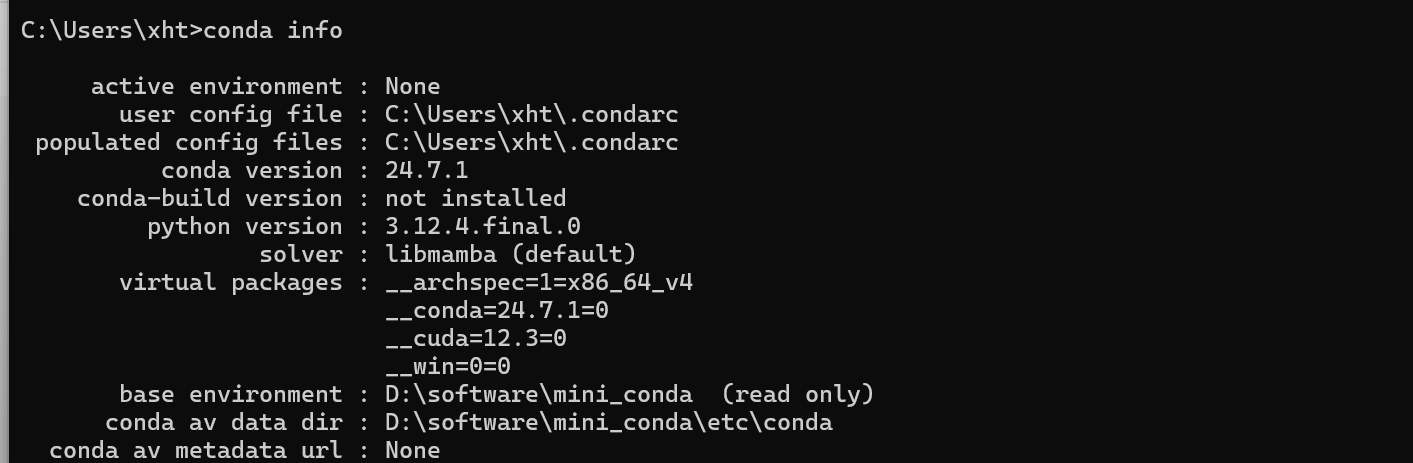

本地硬件配置

- RAM:32GB

- VRAM:12GB(RTX 3060)

运行情况

- LM Studio 可运行 14B 模型,基本只有 GPU 负载;运行 32B 模型时,CPU和内存均满载(电脑正常运行本身就占用了20GB左右的内存)

- Ollama 运行 14B 模型就会把 CPU 和内存占满,而 GPU 只利用到很小一部分

模型表现对比

根据提问 “狸花猫的品种有哪些”,对几个不同版本进行测试,发现

- deepseek-r1 线上版本:回答逻辑性强,内容准确但略显干瘪

- deepseek-r1-7b 本地部署:回答不够清晰,似是而非

- kimi-联网:内容丰富,分类多样,但缺乏逻辑性

总的来说,本地部署的模型还是差点意思,有可能的话,还是使用线上模型更好。

参考链接

HuggingFace 各种模型都可以下载(下载速度可达 80MB/s)

OpenRouter 支持多模型同时提问

ChatGPT - Genie AI gpt前端,配置 API-KEY 后即可使用