本地部署 DeepSeek-R1-内部知识库环境准备1. 确认系统要求2. 安装 Homebrew一. 安装ollama和启动服务1.1 安装 ollama1.2 启动服务1.3 拉取模型并运行二.运行DeepSeek-R1-集成web页面2.1 运行模型2.2 安装Openweb-UI 界面

环境准备

1. 确认系统要求

-

操作系统:macOS(推荐 macOS 12 及以上)

-

处理器:Apple Silicon(M3 Pro )

-

内存: 36GB

-

Python 版本:3.11

-

DeepSeek-R1-1.5b/14b/32b 模型

确保您的系统已经安装了以下工具和软件:

2. 安装 Homebrew

如果您尚未安装 Homebrew,可以通过以下命令安装:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

完成后,验证是否安装成功:

brew --version

一. 安装ollama和启动服务

ollama 是一个 AI 模型运行环境,安装步骤如下:

1.1 安装 ollama

在终端运行以下命令:

#ollama官网地址

https://ollama.com/library/deepseek-r1

brew install --cask ollama # 安装 ollama GUI 应用

如果不需要 GUI,可以使用以下命令:

brew install ollama # 不带 GUI 安装

1.2 启动服务

安装完成后,您可以通过以下命令启动 ollama 服务:

brew services start ollama # 后台启动服务

确认 ollama 是否正常安装并显示版本号:

ollama --version

# 输出类似:ollama version is 0.5.7

1.3 拉取模型并运行

拉取您需要的 DeepSeek-R1 模型:

ollama pull deepseek-r1:32b # 拉取 32b 模型

ollama pull deepseek-r1:7b # 拉取 7b 模型

ollama pull deepseek-r1:1.5b # 拉取 1.5b 模型

运行所需的模型文件:

ollama run deepseek-r1:1.5b # 启动指定的 DeepSeek-R1 模型

查看已安装的模型:

#01 查看已下载的模型

ollama list

#02 ollama默认存储路径

~/.ollama/models/*

#03 命令

ollama pull models_file #拉取模型文件

ollama run models_file #运行模型文件

二.运行DeepSeek-R1-集成web页面

2.1 运行模型

#01 下载 DeepSeek-R1 模型

ollama run deepseek-r1:32b

ollama run deepseek-r1:7b

ollama run deepseek-r1:1.5b #选择一个

#02 本地运行 DeepSeek-R1

ollama list

ollama run deepseek-r1:1.5b

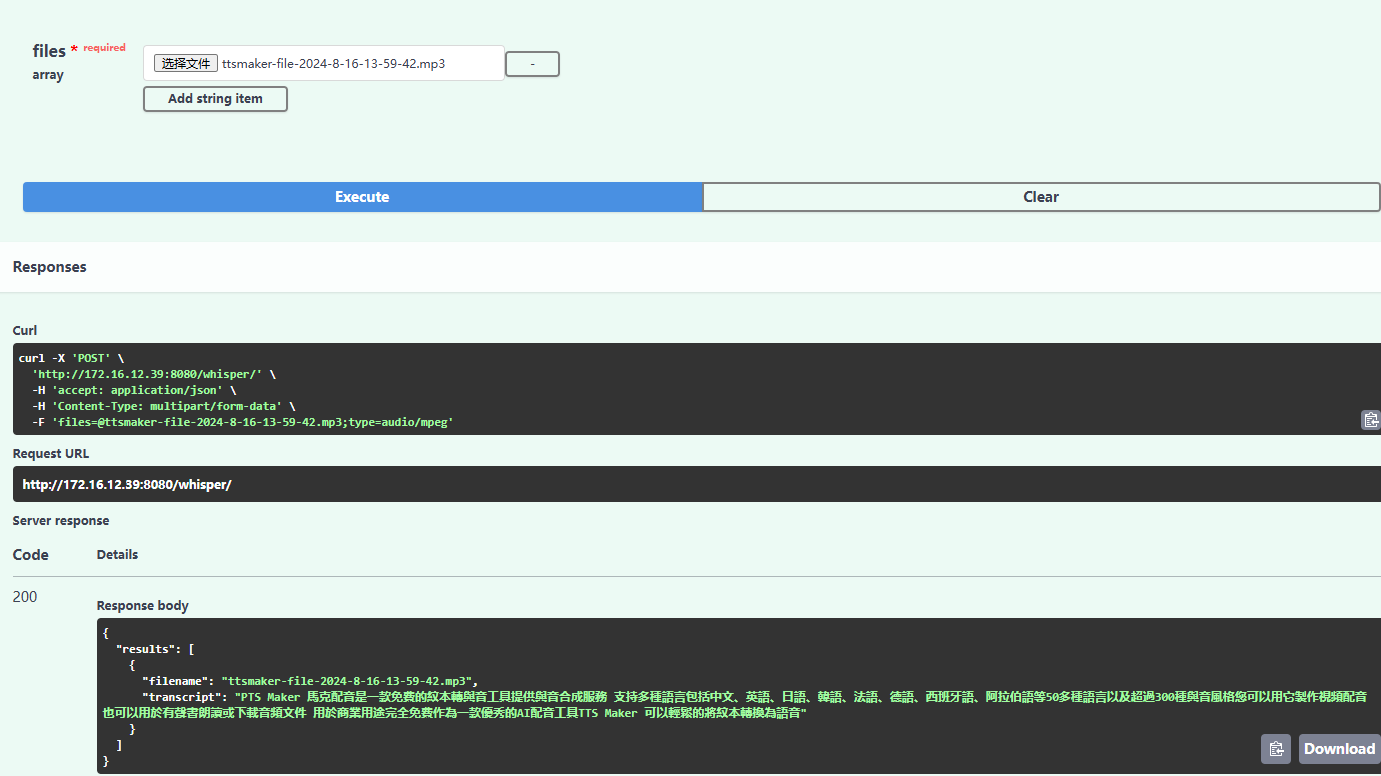

2.2 安装Openweb-UI 界面

#06 通过 Open-WebUI运行

git clone https://github.com/open-webui/open-webui.git

"""

由于镜像在国外下载太慢,使用国内镜像

docker pull --platform linux/arm64 swr.cn-north-4.myhuaweicloud.com/ddn-k8s/ghcr.io/open-webui/open-webui:main

docker run -d \

-p 3000:8080 \

--add-host=host.docker.internal:host-gateway \

-v /Users/ningcaichen/company/01-AI系列/open-webui:/app/backend/data \

--name open-webui \

--restart always \

swr.cn-north-4.myhuaweicloud.com/ddn-k8s/ghcr.io/open-webui/open-webui:main

Mac M系列芯片 是arm的,暂时不可用于下载

"""

#08 使用python安装(python版本3.11)

pip install open-webui

open-webui serve --port 8081

页面访问:127.0.0.1:8081

-

页面