deepseek本地部署

下载并部署大模型(这里使用Ollama)

-

下载并安装Ollama

- 打开浏览器搜索ollama,访问官网。

- 点击右上角Download按钮,选择对应系统版本的安装包下载。

- 双击安装包,按提示完成安装。

- 验证安装:在终端输入

ollama -v,出现版本号即表示安装成功。

-

指定模型下载位置

- 默认下载到C盘,这里通过创建环境变量的方式指定模型的下载位置。

- 创建环境变量

OLLAMA_MODELS,值设为E:\OLLAMA_MODELS(可根据需要更改路径)。OLLAMA_MODELS E:\OLLAMA_MODELS

-

下载并启动DeepSeek模型

- 访问ollama官网models页面,找到deepseek-r1模型。

- 根据硬件配置选择合适的模型大小。

- 复制对应的安装命令并在终端执行。

- 在终端输入

ollama run deepseek-r1下载并启动模型- 默认下载7B参数规格,如需其他参数规格

- 可在命令后添加

:参数量,如ollama run deepseek-r1:14b。

- 开启AI聊天

- 终端出现

>>>符号即可开始对话。

- 终端出现

可视化客户端

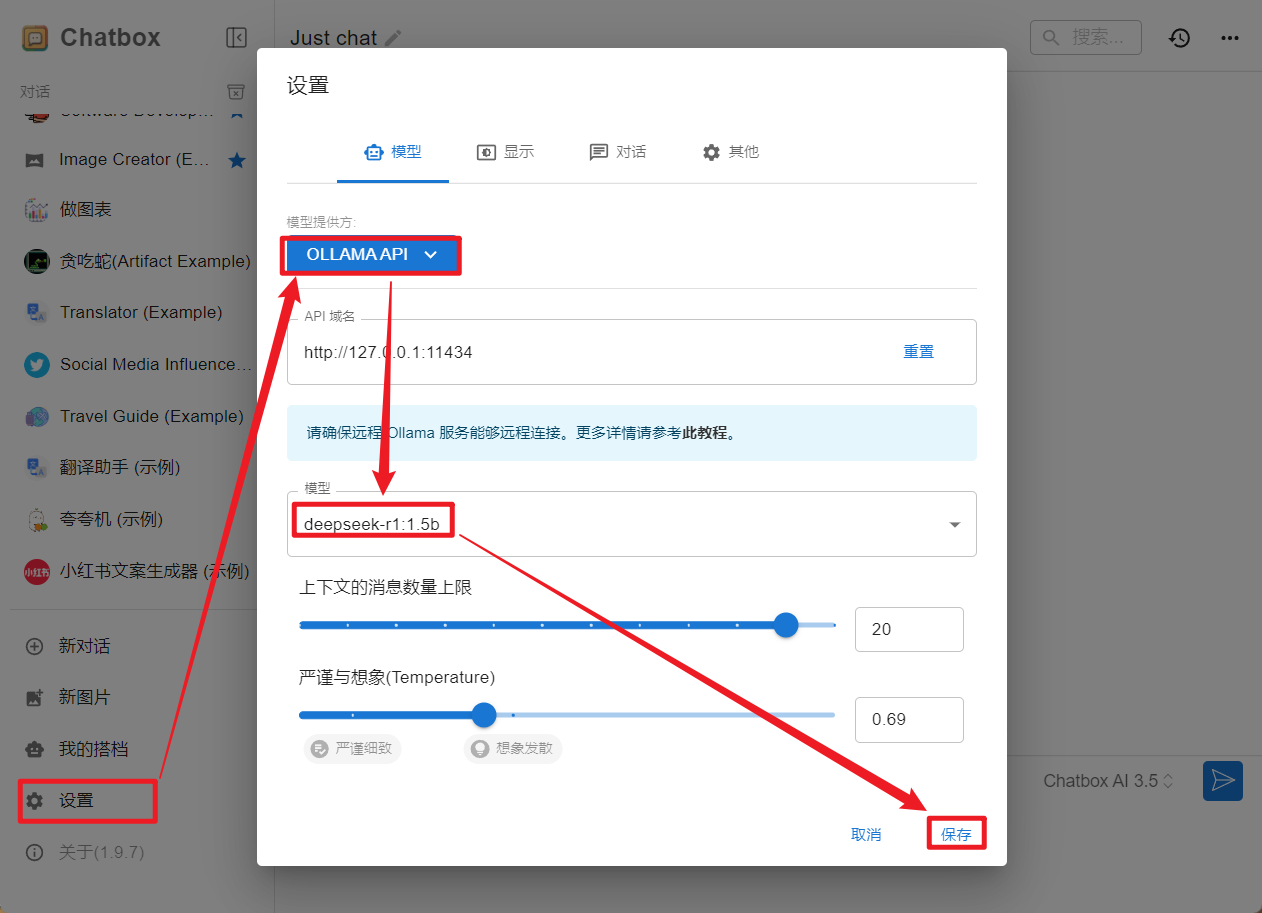

- ChatBox 桌面客户端

- 下载并安装ChatBox。

- 配置模型API参数

- 点击新对话开始使用。

- 下载并安装ChatBox。

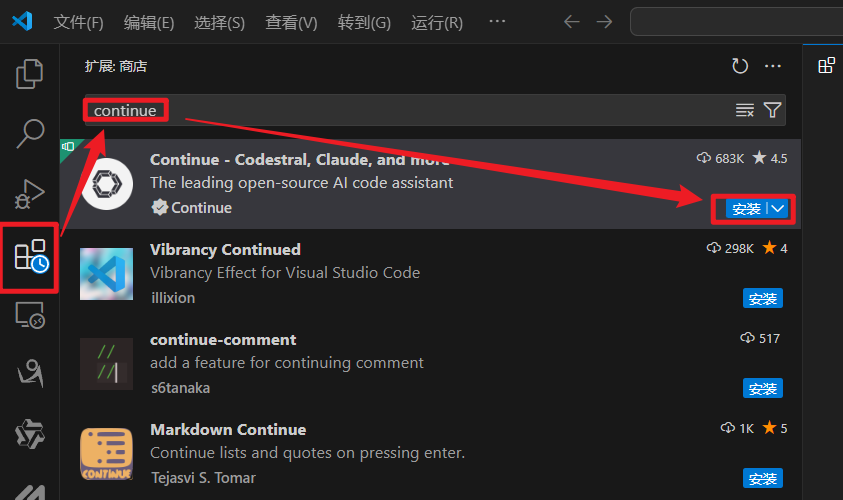

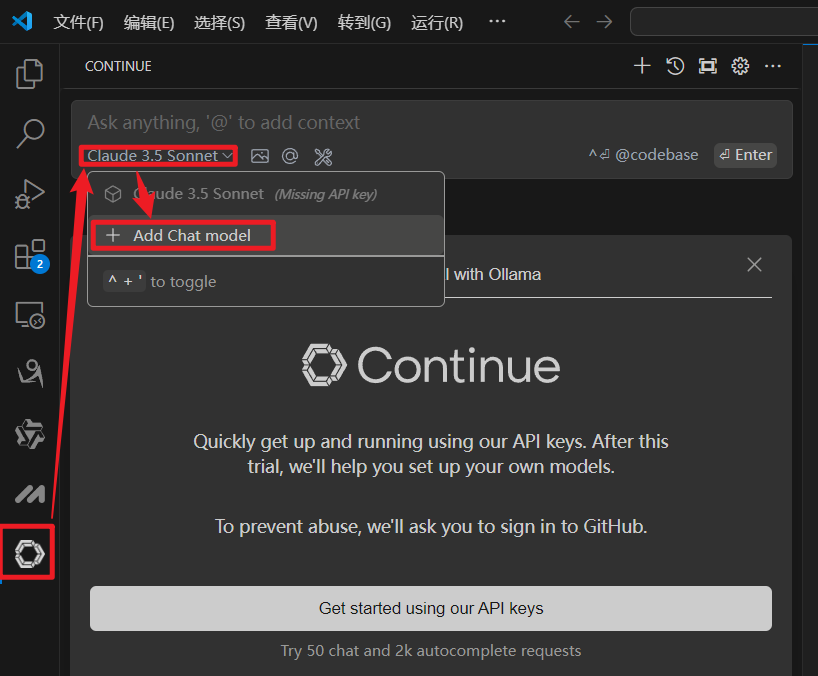

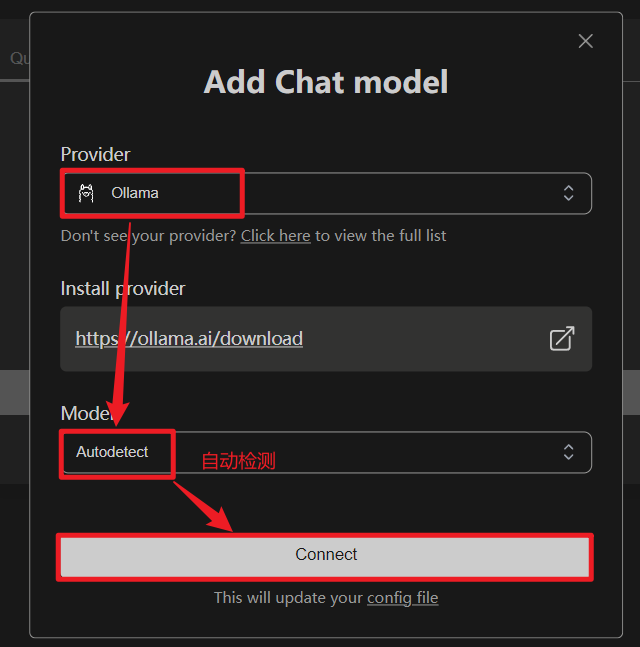

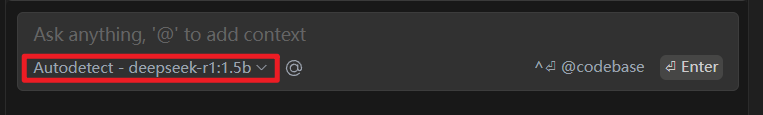

与VSCode集成实现AI代码辅助开发

- Continue插件

- 安装Continue插件。

- 配置一下模型的API参数

- 重新选择一下对话的模型。

- 安装Continue插件。

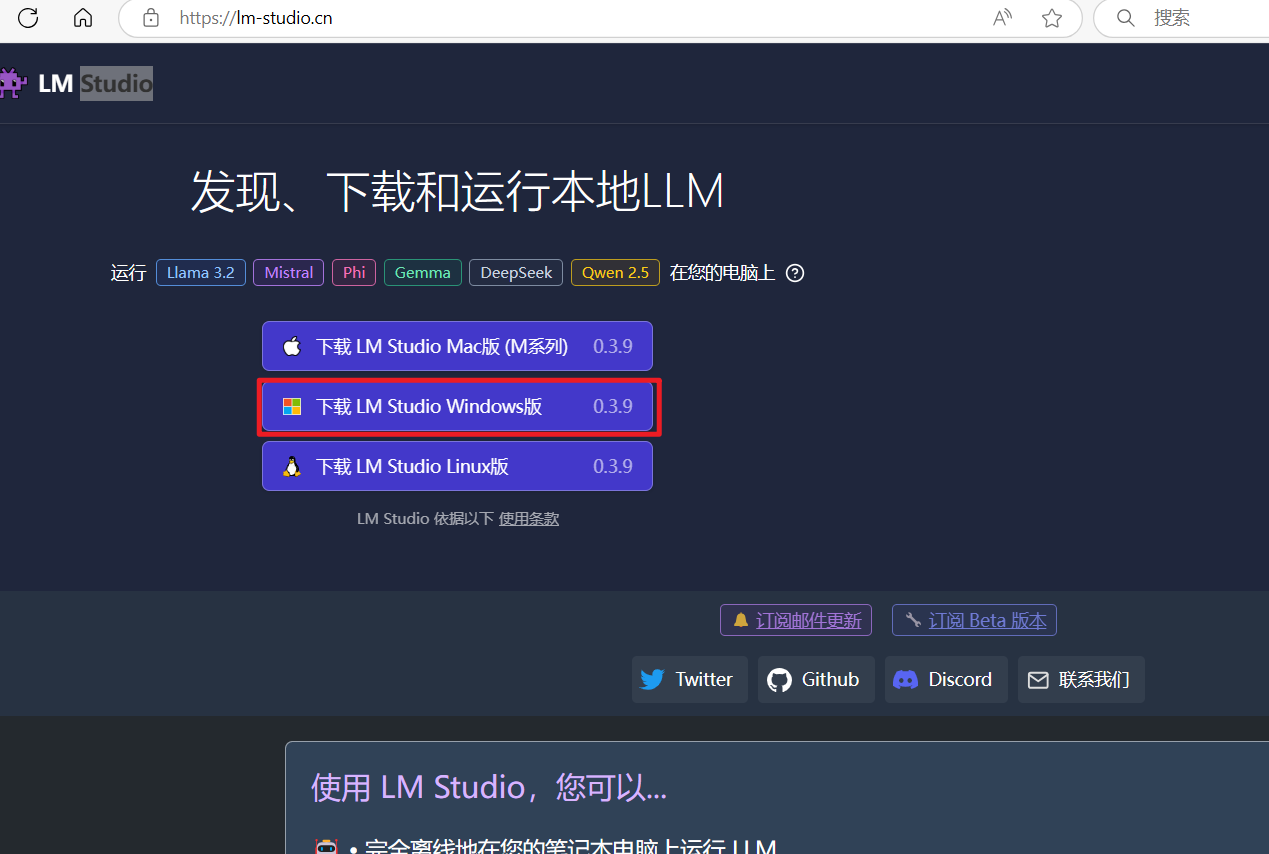

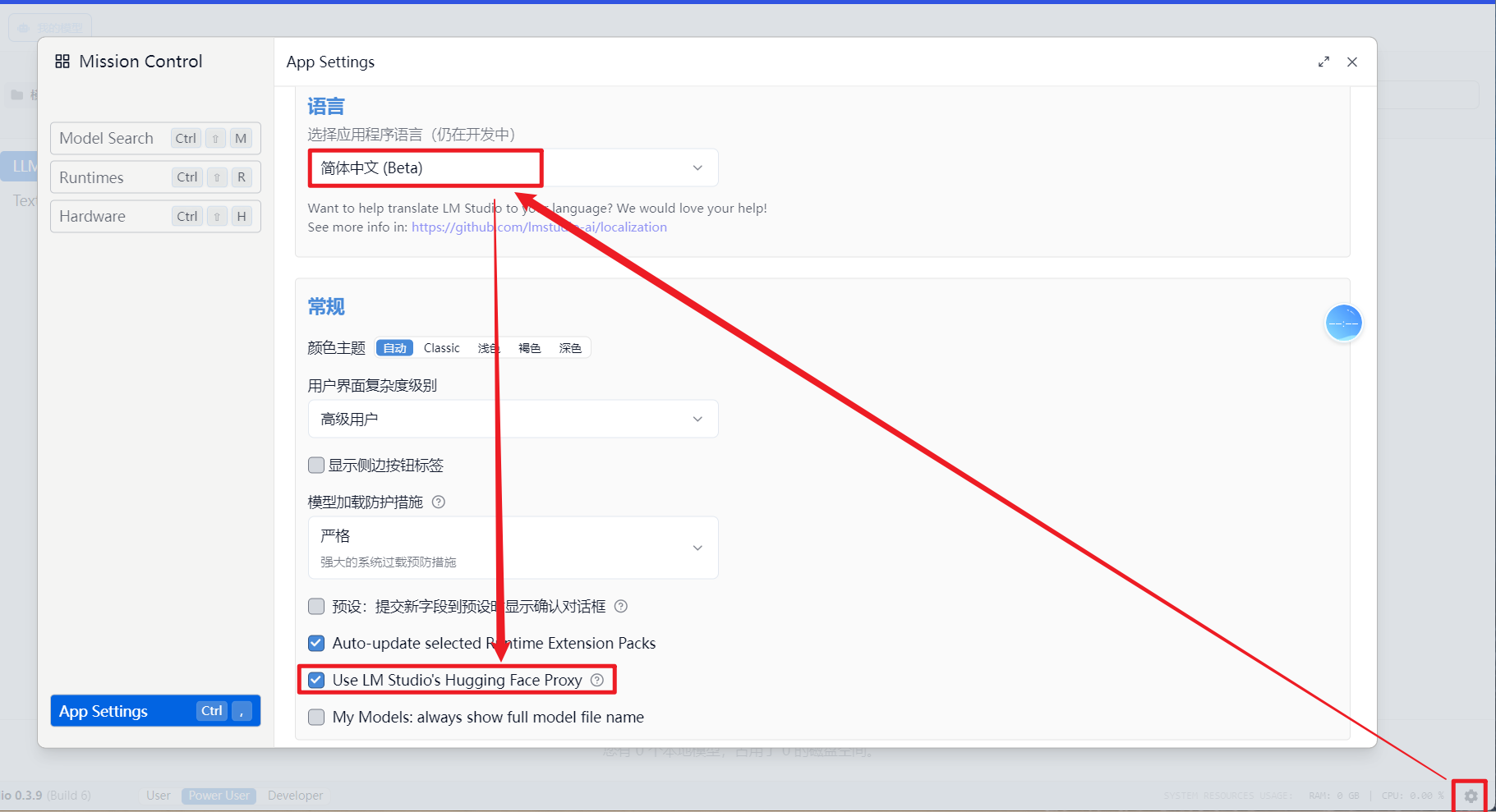

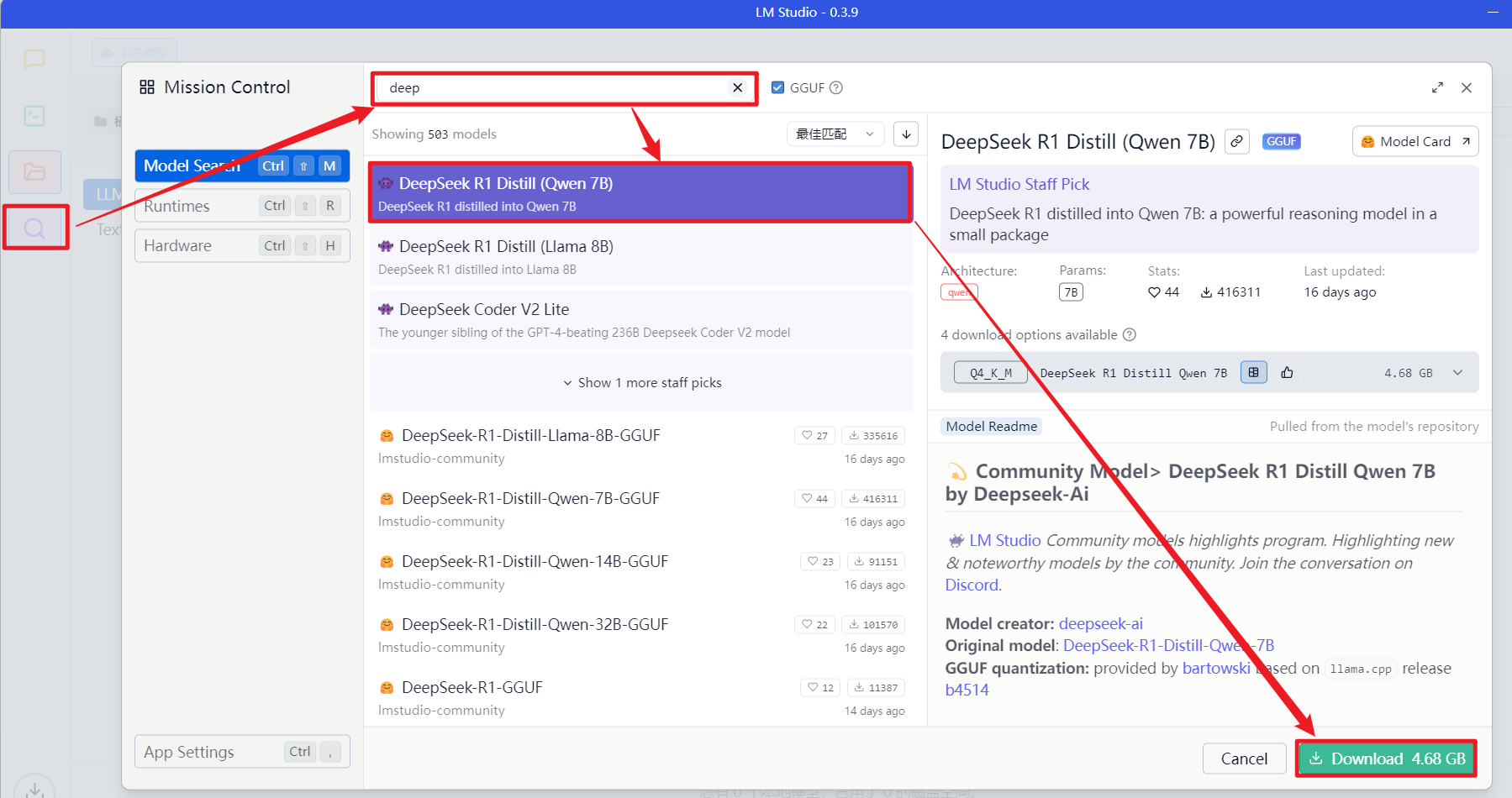

第二种方式

Ollama 也可以使用 LM Studio 代替,LM Studio还集成了 UI对话界面。

下载模型

vscode下载 cline插件,配置deepseek的api,实现ai代码辅助开发

其他软件

-

下载并部署deepseek的软件

- Ollama

- LM Studio

-

客户端软件

- ChatBox 桌面客户端

- Cherry Studio 桌面客户端

- OpenWebUI 一般需要docker部署

- page assist 浏览器插件:可以提供大模型的webUI界面。

- CloseChat和LobeChat:部分功能需收费,但有丰富的插件市场。

-

ChatBox和CherryStudio是免费开源项目

- ChatBox 功能相对单一,简单易用,适合快速上手。

- CherryStudio 功能丰富,支持多模型。

-

CloseChat和LobeChat部分功能需要收费,具有较为丰富的插件市场,而且可以进行联网查询。

-

vscode集成大模型的插件

- Continue插件

- cline插件 或者 Roo Code插件

- CodeGPT插件 --- csdn开发的

以上每种软件任选一种,实现功能就行。

其他获取deepseek的api key的途径

- groq

一家ai芯片的制造商,官网上部署了很多开源的大模型 https://groq.com/

-

openrouter 应该需要梯子

-

硅基流动 「硅基流动」,新用户会赠送 2000 万 Token 额度。

![题解 [ARC127C] Binary Strings](https://cdn.luogu.com.cn/upload/image_hosting/1bmpfrpo.png)