DeepSeek本地部署教程

deepseek本地部署

第一步:安装ollama

https://ollama.com/download

第二步:在ollama 官网搜索

https://ollama.com/

搜索 deepseek 选择第一项即可

模型大小与显卡需求

| 模型版本 | 参数规模 | 最低显存要求 | 推荐 GPU 型号 |

|---|---|---|---|

| DeepSeek-R1 | 70B | 40GB | NVIDIA RTX A6000(48GB) |

| DeepSeek-R1-Distill-32B | 32B | 24GB | NVIDIA RTX 3090(24GB) |

| DeepSeek-R1-Distill-14B | 14B | 16GB | NVIDIA RTX 4080(16GB) |

| DeepSeek-R1-Distill-8B | 8B | 12GB | NVIDIA RTX 3080 Ti(12GB) |

| DeepSeek-R1-Distill-7B | 7B | 10GB | NVIDIA RTX 3080(10GB) |

| DeepSeek-R1-Distill-1.5B | 1.5B | 8GB | NVIDIA RTX 3060(8GB) |

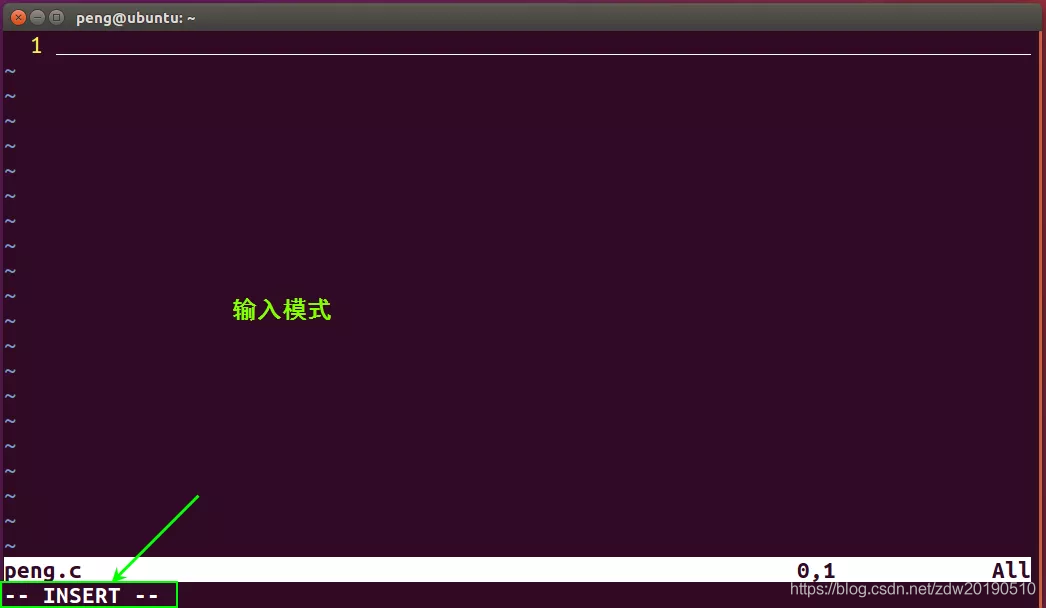

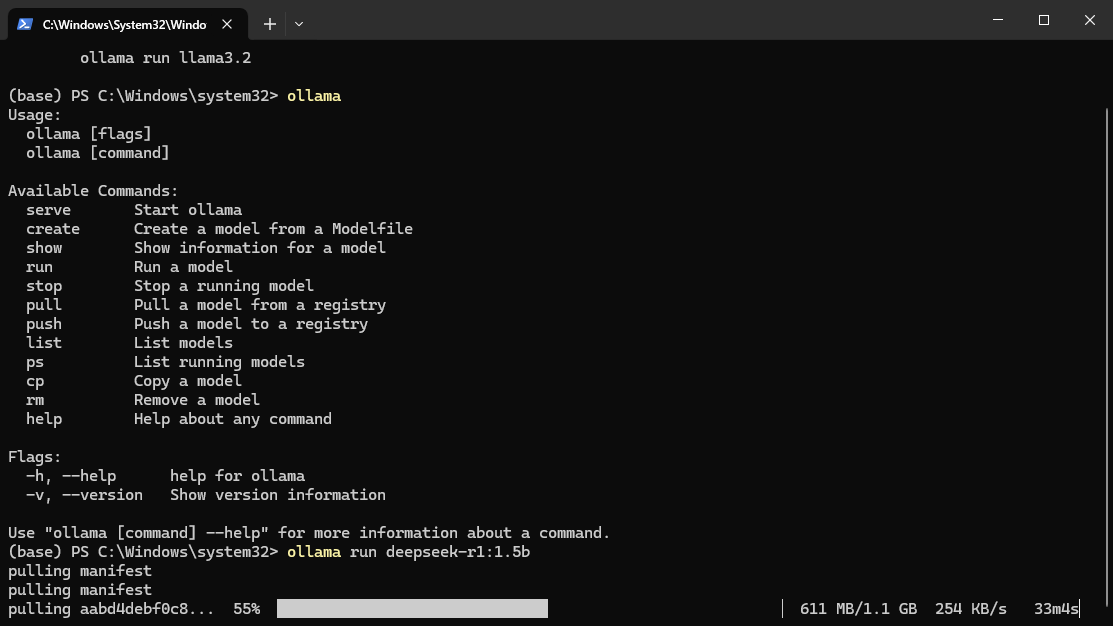

第三步:在终端执行 命令

ollama run deepseek-r1:1.5b

等待安装即可

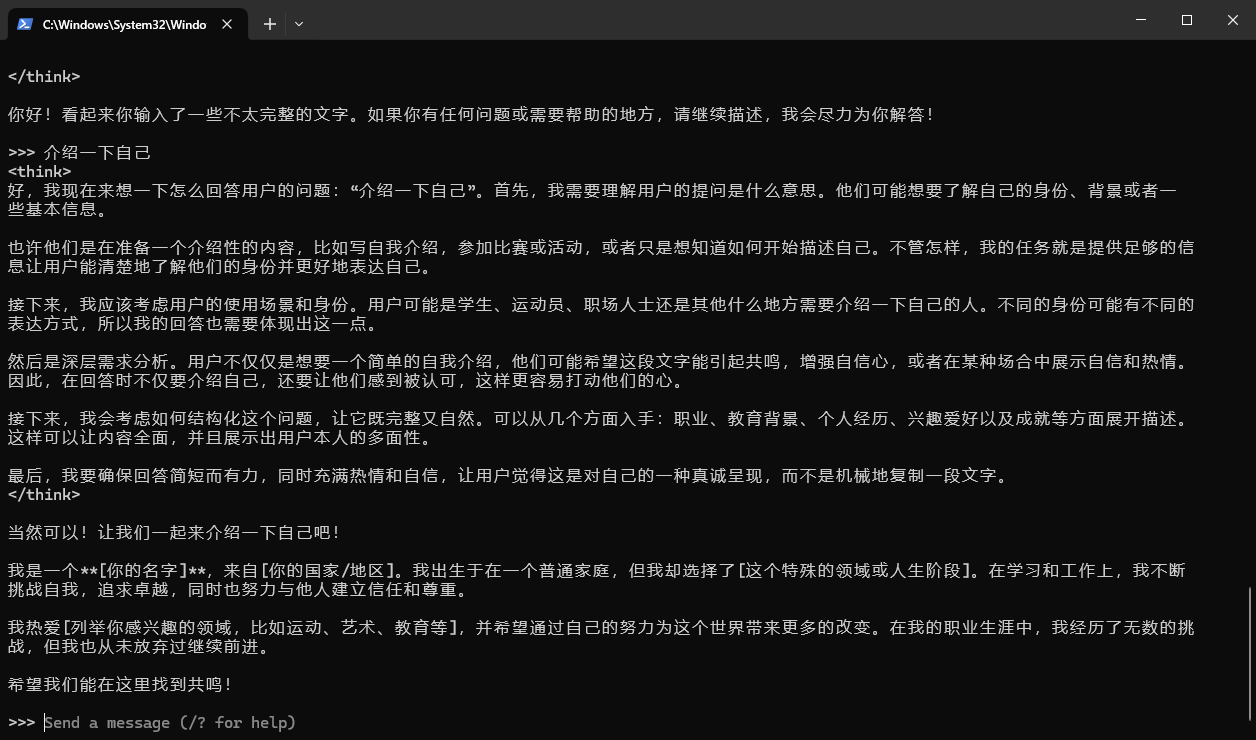

第四步:测试功能

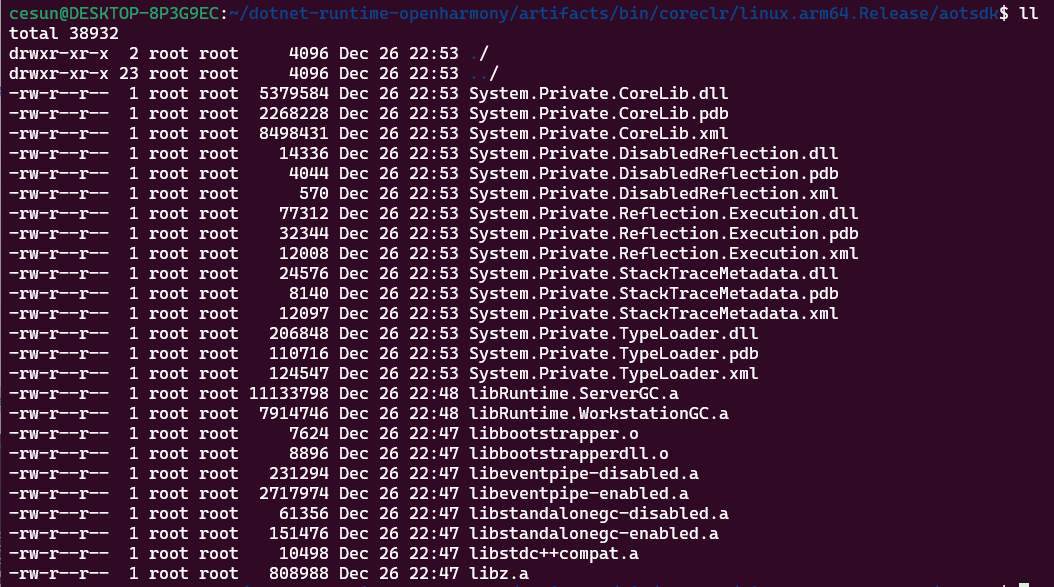

第五步:基本命令

#退出模型

>>> /bye#查看模型

C:\Users\chk>ollama list

NAME ID SIZE MODIFIED

deepseek-r1:1.5b a42b25d8c10a 1.1 GB 3 minutes ago#启动模型

ollama run deepseek-r1:1.5b

>>>#查看帮助

C:\Users\chk>ollama -h

可视化部署Web UI

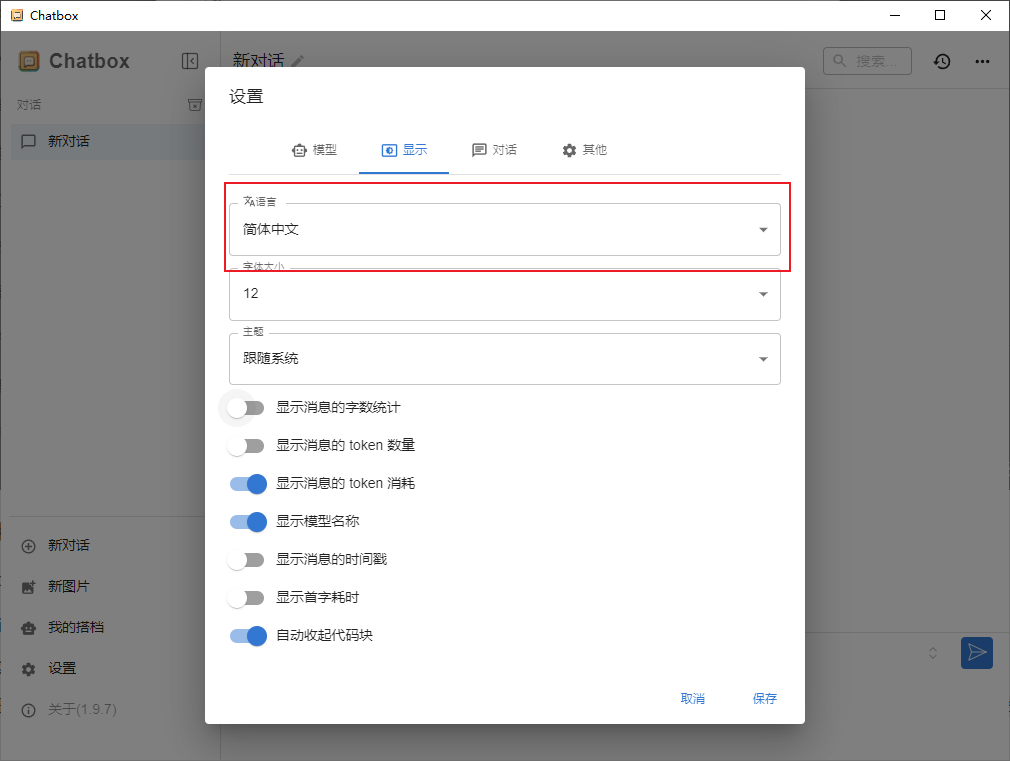

第一步:下载Chatbox AI

https://chatboxai.app/zh

设置中文

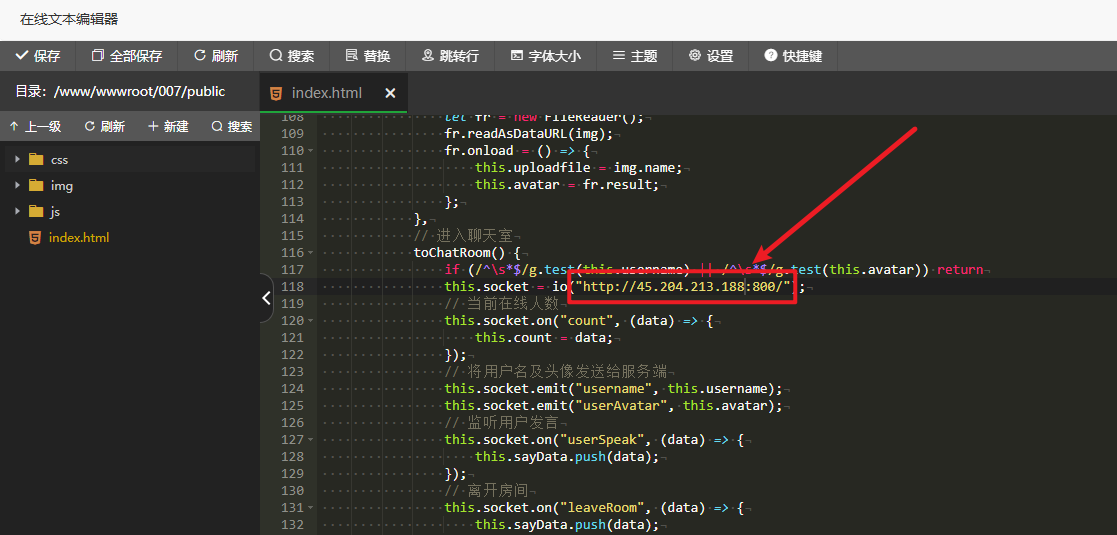

第二步:将 Chatbox 连接到远程 Ollama 服务

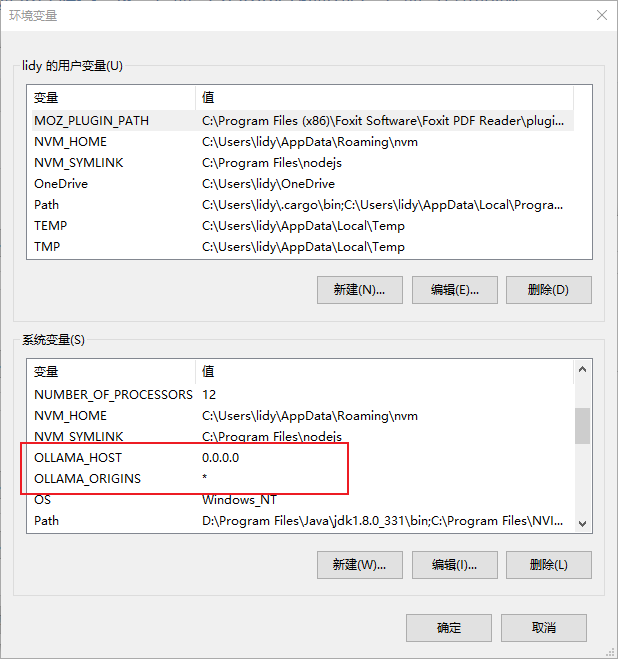

1.在 Windows 上配置环境变量

- 在 Windows 上,Ollama 会继承你的用户和系统环境变量。

- 打开设置(Windows 11)或控制面板(Windows 10),并搜索“环境变量”。点击编辑你账户的环境变量。

- 为你的用户账户编辑或创建新的变量

OLLAMA_HOST,值为0.0.0.0; 为你的用户账户编辑或创建新的变量OLLAMA_ORIGINS,值为*

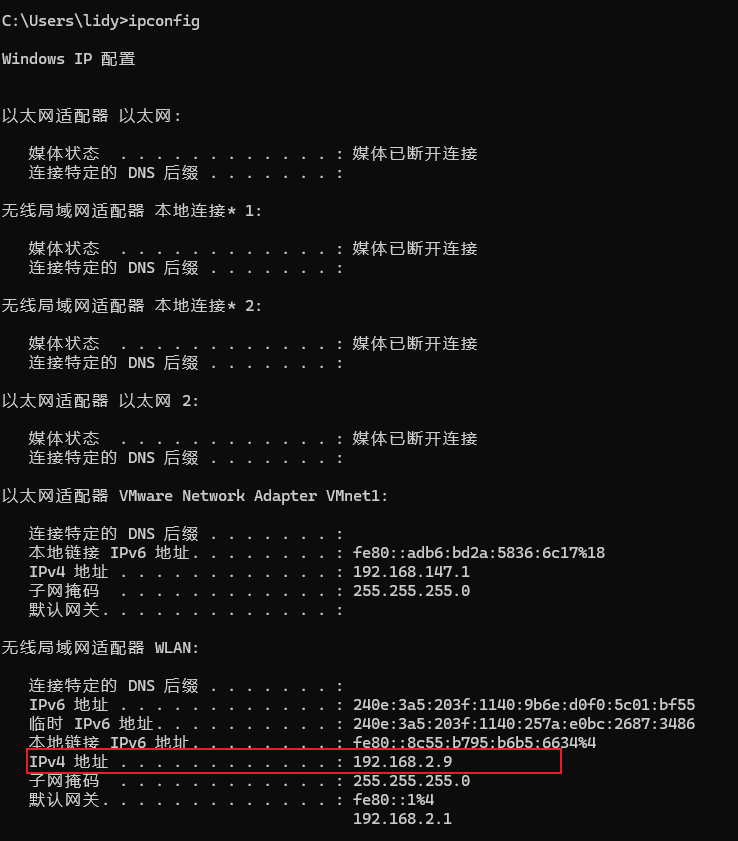

2.服务 IP 地址

配置后,Ollama 服务将能在当前网络中提供服务。你可以使用其他设备上的 Chatbox 客户端连接到此服务。

Ollama 服务的 IP 地址是你电脑在当前网络中的地址,通常形式如下

192.168.2.9

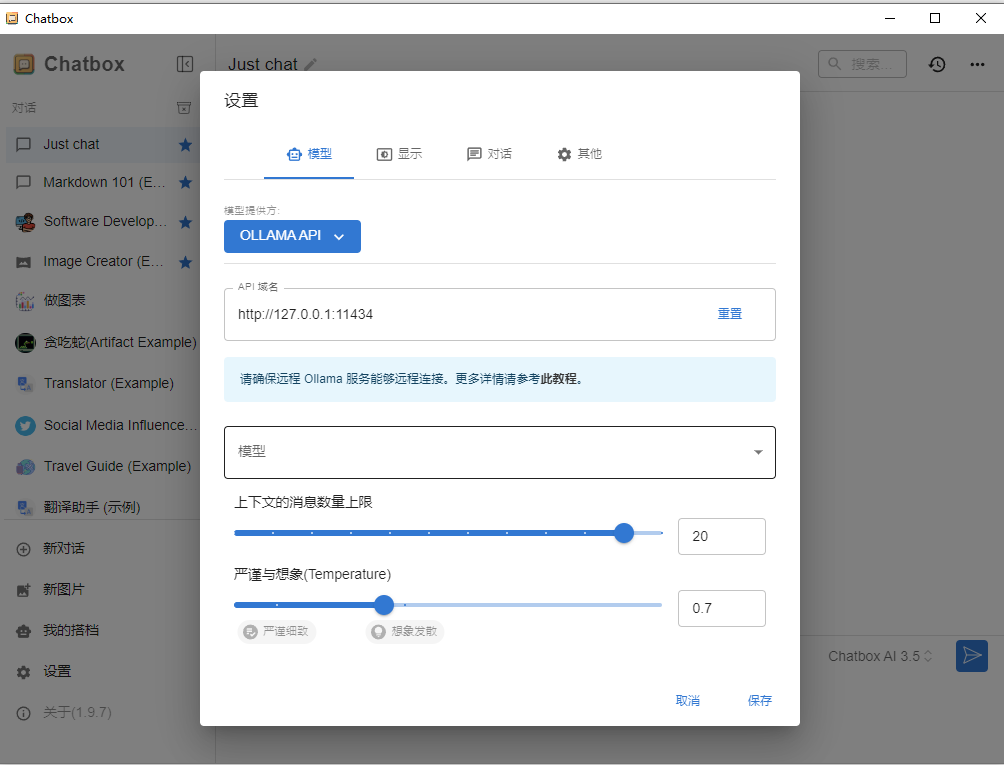

在 Chatbox 中,将 API Host 设置为:

http://192.168.2.9:11434

3.注意事项

-

可能需要在防火墙中允许 Ollama 服务的端口(默认为 11434),具体取决于你的操作系统和网络环境。

-

为避免安全风险,请不要将 Ollama 服务暴露在公共网络中。家庭 Wifi 网络是一个相对安全的环境。

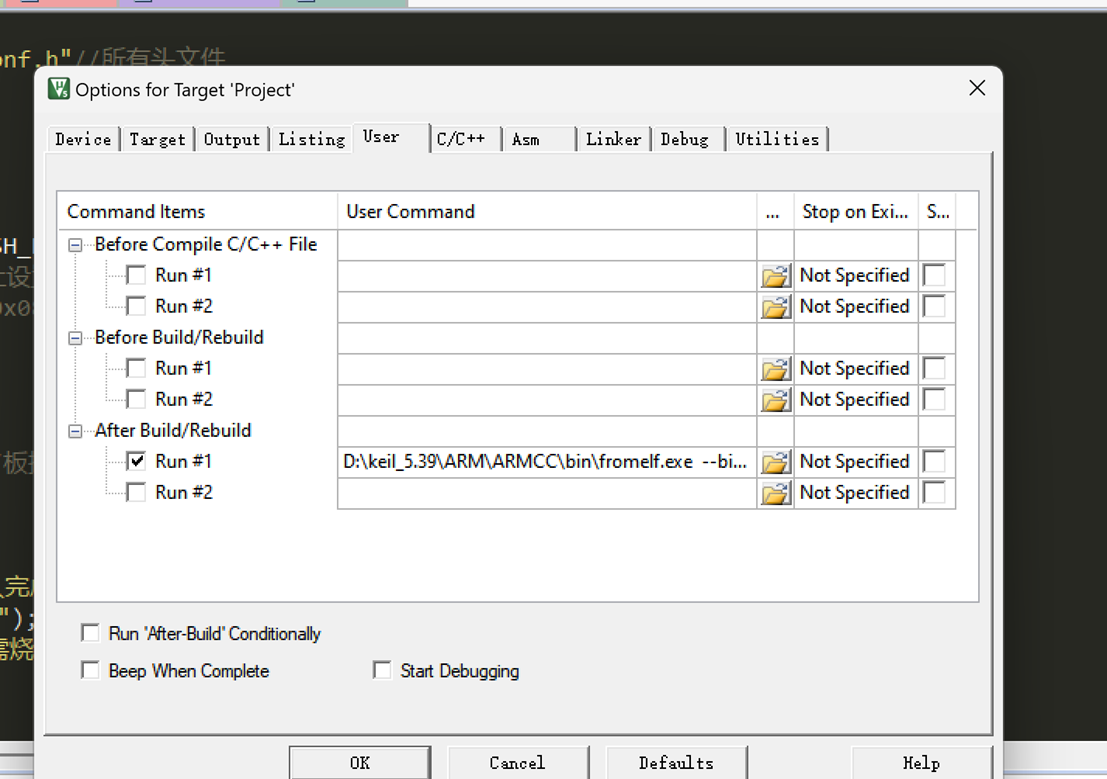

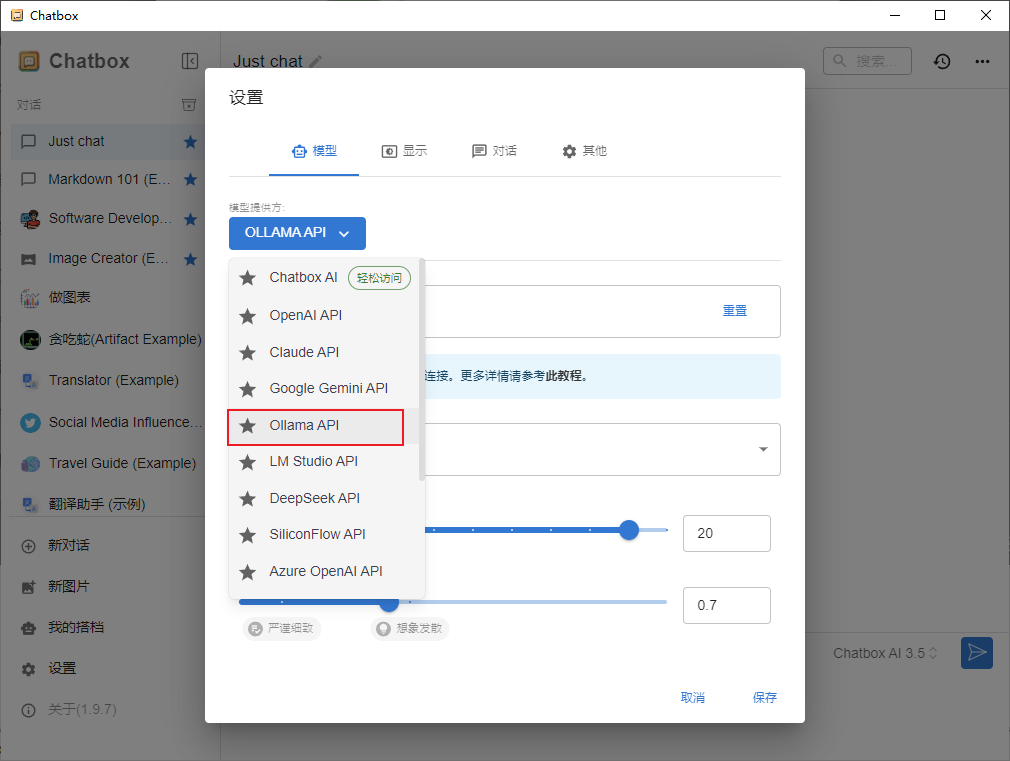

4.Chatbox配置模型

第三步:效果演示

本地部署完成!