🚀 个人主页 极客小俊

✍🏻 作者简介:web开发者、设计师、技术分享

🐋 希望大家多多支持, 我们一起学习和进步!

🏅 欢迎评论 ❤️点赞💬评论 📂收藏 📂加关注

什么是阿里云百炼?

阿里云的大模型服务平台百炼是一站式的大模型开发及应用构建平台。

不论是开发者还是业务人员,都能深入参与大模型应用的设计和构建。

可以通过简单的界面操作,在5分钟内开发出一款大模型应用,或在几小时内训练出一个专属模型,从而将更多精力专注于应用创新!

同时阿里云百炼平台提供了DeepSeek系列的免费服务。

具体来说,所有用户都可以享受DeepSeek-R1、DeepSeek-V3两款模型各100万的免费tokens!

此外,类似于DeepSeek-R1-Distill-Qwen-1.5B、deepseek-r1-distill-llama-70b也面向用户限时免费!

这些免费服务旨在让用户能够无门槛地体验DeepSeek系列大模型的强大功能,简直是福利满满啊!

尤其是阿里云百炼平台提供了满血版DeepSeek-R1模型

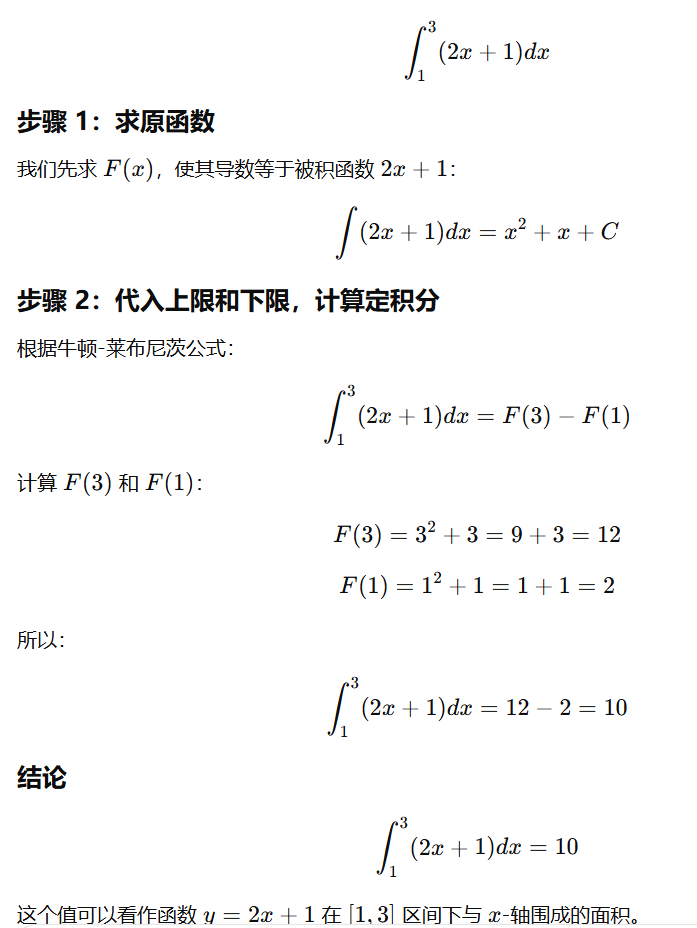

如图

我们可以在该平台上找到并部署DeepSeek-R1满血版模型,享受其强大的数学、代码、自然语言等推理能力, 还可以找到特定尺寸的DeepSeek-R1蒸馏版模型的限时免费服务。这些服务旨在降低用户的使用门槛,促进AI技术的普及和应用!

更多具体内容大家可以参考阿里云官网文档

https://help.aliyun.com/zh/model-studio/getting-started/what-is-model-studio

如图

阿里云账号注册

如果你还没有阿里云的账号,那你要先去注册一个阿里云的账号吧!

注册完成后才能使用账号登录百炼平台,否则你还怎么玩? 对吧!

阿里云首页官网注册地址

https://www.aliyun.com

这里大家直接用手机邮箱自行注册即可,就不过多赘述了!

注册完成直接登录!

然后在阿里云官网,搜索关键字百炼平台并进入!

如图

如图

开通模型100万免费tokens服务

首先我们点击管理控制台进入到阿里云百炼

登录阿里云百炼大模型服务平台后,如果页面顶部显示如下消息,那么我们需要开通百炼的模型服务,以获得免费额度。

开通百炼不会产生费用,仅调用、部署、调优模型会产生相应费用(超出免费额度后)!

如图

确认开通,领取一下!

如图

获取API Key

API Key是用于访问阿里云百炼平台上的DeepSeek-R1模型等服务的身份验证凭证,它允许我们的应用程序或客户端安全地与平台通信并执行请求的操作!

我们在阿里云百炼平台上鼠标悬停于页面右上角的用户图标,在下拉菜单中单击API-KEY

如图

然后点击创建我的API-KEY

如图

然后点击查看我们就可以获取到API KEY了!

如图

注意

不要将API Key以任何方式公开,避免因未经授权的使用造成安全风险或资金损失。

API Key是我们的重要资产,请务必妥善保管。如果你单击操作列的删除将已有API Key删除,将无法继续通过该Key访问百炼大模型提供的各项服务,如果之前在某些应用程序或服务中集成了这个API Keys,那么这些应用将会因为认证失败而无法正常工作!

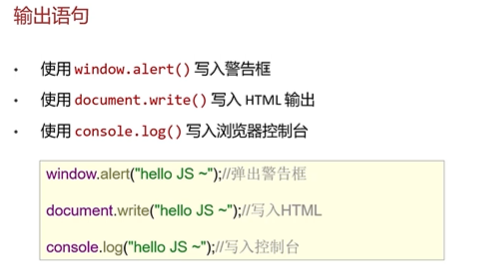

安装 OpenAI SDK

那么接下来,我们就可以使用获取到的API Key在阿里云百炼平台或相应的客户端中配置账户,以便开始调用DeepSeek-R1模型并消耗的免费tokens

那么这里我们通过SDK调用大模型,所需还需要再本地安装一下OpenAI

阿里云百炼官方提供了Python与Java编程语言的SDK,也提供了与OpenAI兼容的调用方式!

参考文档

https://help.aliyun.com/zh/model-studio/developer-reference/install-sdk

我们需要确保已安装Python3.8或以上版本, 如果你还没有安装Python建议去看看我前面的教程,都有介绍!

我这里安装的为Python 3.10.7

如图

然后开始安装或更新OpenAI,执行以下命令!

pip install -U openai

如图

等它安装完成..

将API Key配置到环境变量

然后建议你把API Key配置到环境变量,从而避免在代码里显式地配置API Key,降低泄漏风险!

这里我们以Windows系统为例,我们可以通过系统属性进行配置环境变量,具体步骤如下:

在Windows系统桌面中按Win+Q快捷键,在搜索框中搜索编辑系统环境变量关键字,单击打开系统属性界面

如图

在系统属性窗口,单击环境变量,然后在系统变量区域下单击新建,变量名填入DASHSCOPE_API_KEY,变量值填入我们的API Key

然后依次单击三个窗口的确定,关闭系统属性配置页面,完成环境变量配置!

把这个DASHSCOPE_API_KEY名字记住了!

最后我们可以测试一下,打开CMD(命令提示符)窗口执行如下命令检查环境变量是否生效

echo %DASHSCOPE_API_KEY%

如图

特别注意

我们配置环境变量后不会立即影响已经打开的命令窗口、IDE或其他正在运行的应用程序,所以需要重新启动这些程序或者打开新的命令行使环境变量生效!

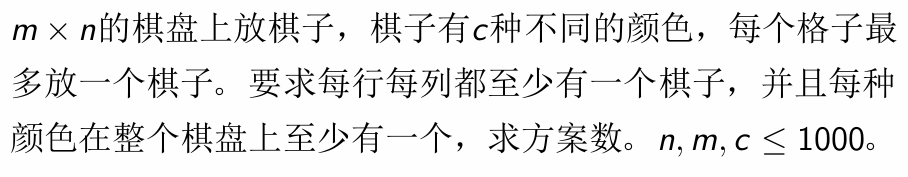

快速体验 本地API远程调用DeepSeek-R1满血版大模型

一切都做好了之后,现在我们可以先来体验一下DeepSeek-R1满血大模型了!

大家可以参考官网文档

https://bailian.console.aliyun.com

找到模型广场,然后筛选一下deepseek

如图

然后点击API调用案例进行使用!

这里我们使用Python去进行调用!

https://help.aliyun.com/zh/model-studio/developer-reference/deepseek

把代码复制到自己的编辑器中,这里我使用的是PyCharm

没有安装的朋友可以去jetbrains官网免费去下载一个PyCharm社区版

下载地址:

https://www.jetbrains.com.cn/pycharm/download/?section=windows

如图

安装过程就不过多赘述了,就和平常安装其他软件一样,无脑下一步

实在清楚的,去看看我前面的教程,都有讲解!

安装好之后,打开编辑器,新建一个Python文件,把官网给出的代码粘贴过来!

如图

把代码粘贴到PyCharm中

代码如下

import os

from openai import OpenAIclient = OpenAI(# 若没有配置环境变量,请用百炼API Key将下行替换为:api_key="sk-xxx",api_key=os.getenv("DASHSCOPE_API_KEY"), # 如何获取API Key:https://help.aliyun.com/zh/model-studio/developer-reference/get-api-keybase_url="https://dashscope.aliyuncs.com/compatible-mode/v1",

)completion = client.chat.completions.create(model="deepseek-r1", # 此处以 deepseek-r1 为例,可按需更换模型名称。messages=[{'role': 'user', 'content': '9.9和9.11谁大'}]

)# 通过reasoning_content字段打印思考过程

print("思考过程:")

print(completion.choices[0].message.reasoning_content)

# 通过content字段打印最终答案

print("最终答案:")

print(completion.choices[0].message.content)

如图

这里可能要等待一会..因为官网这里给出了DeepSeek-R1类模型的思考过程可能较长,可能导致响应慢或超时!

最后显示出结果

如图

但是这里官网文档告诉我们响应太慢了,建议我们优先使用流式输出方式调用DeepSeek-R1 模型

如图

复制官网给出的案例代码到编辑器执行即可!

代码如下

import os

from openai import OpenAIclient = OpenAI(# 若没有配置环境变量,请用百炼API Key将下行替换为:api_key="sk-xxx",api_key=os.getenv("DASHSCOPE_API_KEY"),base_url="https://dashscope.aliyuncs.com/compatible-mode/v1",

)

completion = client.chat.completions.create(model="deepseek-r1", # 此处以 deepseek-r1 为例,可按需更换模型名称。messages=[{'role': 'user', 'content': '9.9和9.11谁大'}],stream=True,# 解除以下注释会在最后一个chunk返回Token使用量# stream_options={# "include_usage": True# })# 定义完整思考过程

reasoning_content = ""

# 定义完整回复

answer_content = ""

# 判断是否结束思考过程并开始回复

is_answering = Falseprint("\n"+"="*20+"思考过程"+"="*20+"\n")

for chunk in completion:# include_usage 设置为 True 会使得最后一个chunk返回 Token 使用量,而choices为空列表,此处进行判断if chunk.choices == []:print("\n"+"="*20+"Token 使用情况"+"="*20+"\n")print(chunk.usage)# 以下为思考与回复的步骤else:# include_usage 设置为 True 时,倒数第二个chunk会不包含 reasoning_content 字段,因此需要进行判断if hasattr(chunk.choices[0].delta, 'reasoning_content') == False:passelse:# 有时可能会出现思考过程与回复皆为空的情况,此时忽略即可if chunk.choices[0].delta.reasoning_content == "" and chunk.choices[0].delta.content == "":passelse:# 如果思考结果为空,则开始打印完整回复if chunk.choices[0].delta.reasoning_content == "" and is_answering == False:print("\n"+"="*20+"完整回复"+"="*20+"\n")# 防止打印多个“完整回复”标记is_answering = True# 如果思考过程不为空,则打印思考过程if chunk.choices[0].delta.reasoning_content != "":print(chunk.choices[0].delta.reasoning_content,end="")reasoning_content += chunk.choices[0].delta.reasoning_content# 如果回复不为空,则打印回复。回复一般会在思考过程结束后返回elif chunk.choices[0].delta.content != "":print(chunk.choices[0].delta.content,end="")answer_content += chunk.choices[0].delta.content# 如果您需要打印完整思考过程与完整回复,请将以下代码解除注释后运行

# print("="*20+"完整思考过程"+"="*20+"\n")

# print(f"{reasoning_content}")

# print("="*20+"完整回复"+"="*20+"\n")

# print(f"{answer_content}")

如图

那么这就简单的实现了在本地PyCharm开发环境中,通过编程接口API对部署于云端服务的阿里云百炼平台的DeepSeek-R1大模型的远程程序化访问与调用!

以上代码中,我们都可以对有免费额度以及限时免费的模型名称进行调用

详情参考文档给出的代码案例和模型名称!

如图

这么多福利难道还不够你使用吗!

如图

查看token使用情况

那我们怎么知道现在使用了多少token呢

例如查看DeepSeek-R1的 token消耗 我们可以在阿里云百炼平台的控制台中,找到与DeepSeek-R1模型相关的token消耗信息!

定期检查token的消耗情况,以确保在免费tokens用完之前能够及时调整或续费!~

如图

最后

阿里云百炼平台震撼发布DeepSeek系列等大模型,并且慷慨赠送百万级免费tokens,满满诚意,点燃自然语言处理领域创新火花,所以大家还不赶紧来领取使用起来要是错过这波福利你肠子都要悔青 信不信~~🥵🥵

"👍点赞" "✍️评论" "收藏❤️"欢迎一起交流学习❤️❤️💛💛💚💚

好玩 好用 好看的干货教程可以点击下方关注❤️微信公众号❤️

说不定有意料之外的收获哦..🤗嘿嘿嘿、嘻嘻嘻🤗!

🌽🍓🍎🍍🍉🍇