背景

为了解决推荐中的物品冷启动问题,在召回阶段中往往会增加一路使用内容多模态表征的i2i召回,这路召回由于只使用了纯内容的特征,和老物品便可以公平比较,不会产生因为新物品后验行为少而导致无法被召回的问题。在现有的多模态i2i召回方法在文本侧一般都是用一个BERT经过预训练后生成embedding然后基于embedding的相似度来进行召回,但是这样可能也会存在一些问题:

1. BERT表征能力不足。相较于BERT,可以选用参数量更大的LLM模型来生成embedding

2. 直接用BERT/LLM模型生成embedding只表达了比较广泛的文本语义信息,和下游推荐系统的任务目标不一致

因此论文选用了LLaMA2作为backbone,并且使用了推荐系统中的协同过滤信号来微调,得到了符合该推荐场景需求的多模态item embedding表示

方法介绍

论文方法主要包含3个部分:

1. 笔记压缩prompt:如何构建prompt得到笔记的压缩表示、标签、类别

2. 生成式对比学习(GCL):利用协同信息微调模型

3. 协同监督微调(CSFT):利用标签和类别信息微调模型

笔记压缩prompt

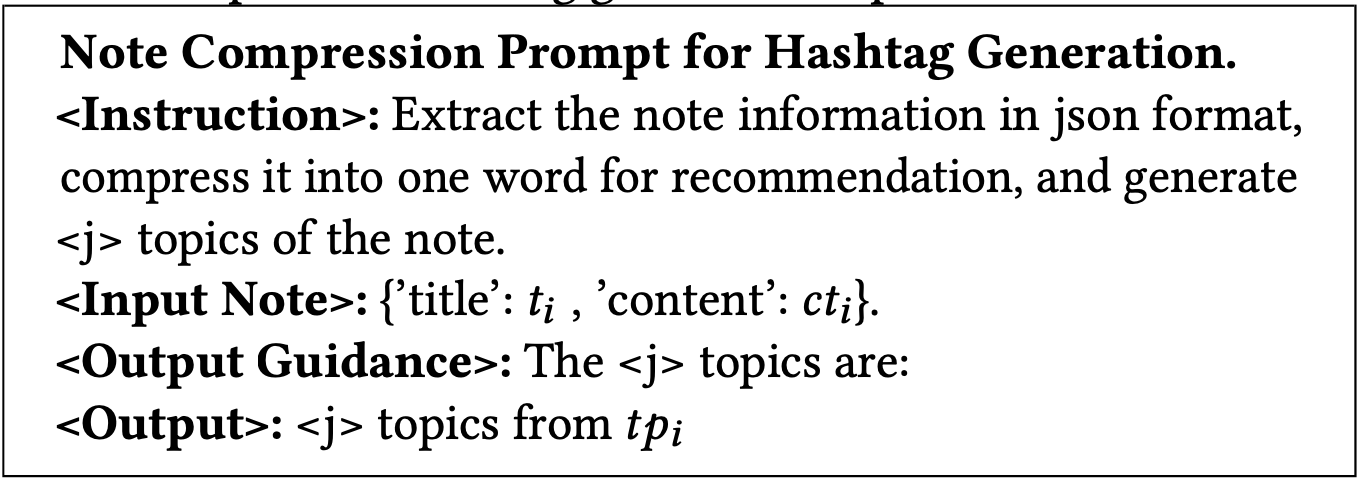

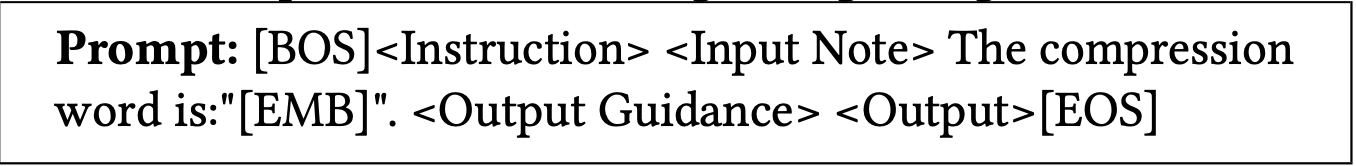

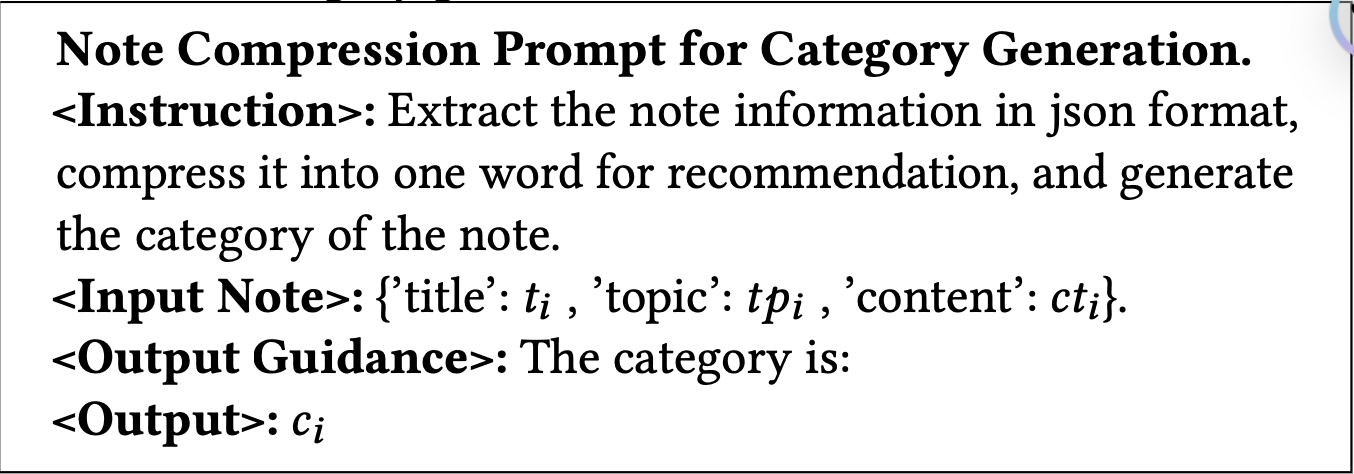

用于生成note的压缩表示、标签、类别的prompt模版如下所示:

其中, [BOS], [EMB]和[EOS]为特殊token, 而<Instruction>, <Input Note>, <Output Guidance>和<Output>为占位符, 对于不同的任务会使用不同特定的内容来替换。

类别生成任务的模版如下所示:

标签生成任务的模版如下所示: