苹果让皮克斯著名的开场灯具复活,发布了一项新的研究,其中描述它的形容词并不是你通常会在AI研究中使用的那些。

这与我们习惯的一切都不同。它在技术上并不更聪明、更强大,也不是那些害怕AI的人噩梦般的存在。

相反,它似乎是科技巨头首次尝试以不同的方向提升AI和机器人智能。苹果并没有试图让机器人变得更具功能性智能,而是把重点放在情感上。他们最新的技术——也很可能是他们的第一个机器人产品——将是一盏能够展示情感的灯。

但在你完全否定这个想法之前,请耐心看完。这里有一项美丽的研究,提供了一个令人耳目一新的视角,展示了AI机器人应该如何设计,并为苹果未来的计划提供了重要的见解。

这一次,优化的目标是避免过度优化,间接地呈现出机器人学作为一个领域已经过于专注于创造完美的机器人,而应该专注于创造那些人类真正愿意接触的机器人。

此外,本文还会给你直观的感受和证据,说明为什么,具有讽刺意味的是,机器人永远不会拥有真正的情感,然而你身边的许多人依然会完全被它们吸引。

让我们深入探讨。

从Luxo Jr.到皮克斯,再到ELEGNT

在继续阅读之前,请花两分钟——真的——观看一下这段1986年的皮克斯动画。它的精彩之处在于,两个灯具(Luxo和Luxo Jr)通过一系列模仿人类移动和手势的动作,能够表达出如此丰富的情感,甚至没有说出一个字。

过程很重要

嗯,这正是苹果所提议的,我们不应该仅仅优化机器人以提高功能性。相反,为了使它们真正吸引人类,我们还应该训练它们展示情感。

看看下面这个短视频,苹果的灯具正在检查一个物体。如果你观察灯具的动作,大多数都是与回答问题无关的功能性动作。然而,这些动作也帮助你猜测灯具在做什么(检查物体),以及它是否理解任务。

换句话说,它正在使用非语言线索来传达更多关于它行为的信息。

ELEGNT灯具还可以执行许多其他任务,比如跟随用户的书本,进行创意投影,或与用户玩耍。

它还能说话,将图像投射到书本和墙壁上。

还不相信为什么我们应该这样做吗?看一下下面的视频,这是一个富有表现力的机器人灯与纯粹功能性灯具的对比。

如你所见,这个富有表现力的机器人在执行过程中做了几种功能上不相关但极具情感表达的动作。

首先,它回头看用户,表示它在听。 接着,它看向目标,传达它理解任务。 它尝试伸展自己几次,表示它在努力够到目标,但做不到。 最后,它摇摇头,表示失败。 哪个机器人更好地传达了它的想法和行动?

当然,有些人可能会觉得这完全没有必要,想要机器人只完成它被指派的任务。(别担心,表现力可以根据需要调整,稍后我们会看到。)但我认为,富有表现力的机器人更容易被理解,而纯粹功能性的机器人,即使失败了,也很难找出失败的原因(理解它为什么没完成任务)。

这是一个简单的例子,但我希望它能够传达一个观点:创造一盏情感丰富的灯具并不是为了“仅仅让皮克斯的灯具复活”,而是为了构建那些人类更愿意与之互动的机器人。此外,考虑到它们是AI,它们的动作或许还能为它们的内部过程提供更多透明度,尽管这些过程仍然大多是黑箱。

但人类真的喜欢这种新方式吗?

反响不错,但需要适应性。

不过,这款新型机器人灯的接待反响并非全都积极。

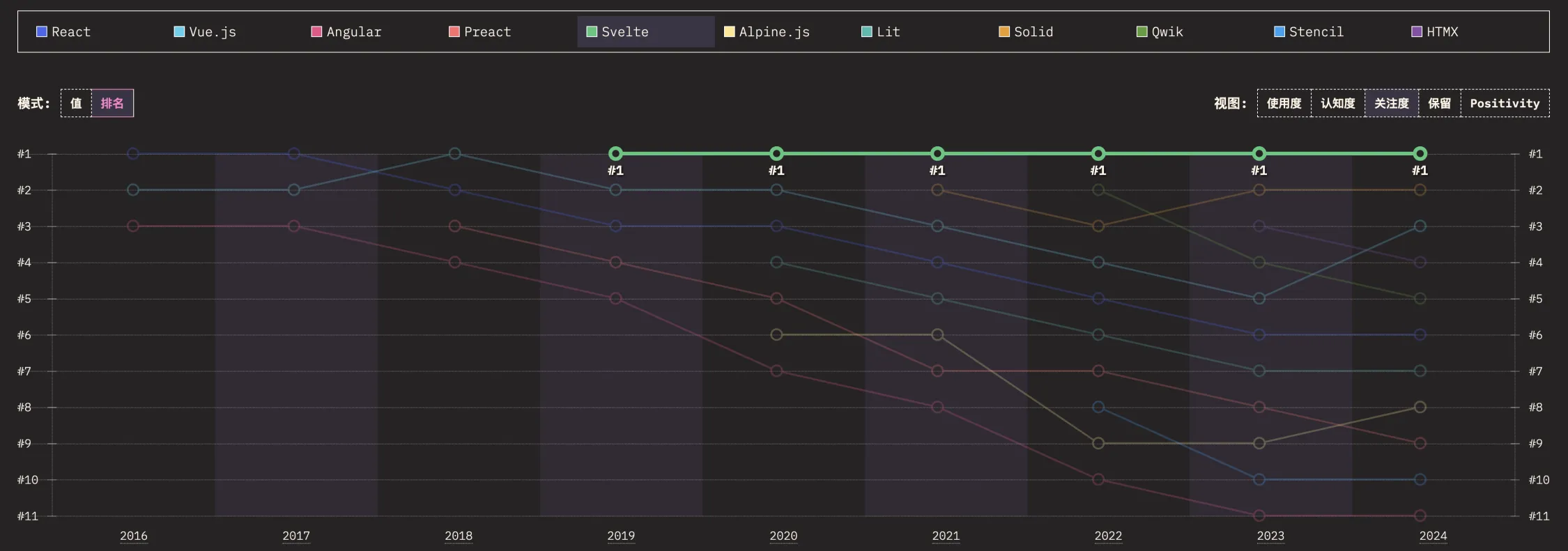

虽然研究发现情感丰富的机器人通常受到欢迎,尤其是在社交任务中,用户在参与度、智能和互动意愿方面给予它们的评价显著高于纯粹功能性的机器人,但一些用户认为过于丰富的表现力显得低效,更倾向于任务导向场景中直截了当的行动,表示这些机器人的“无情感本性”应该是可以定制的。

例如:

年轻人和非机器人学者更喜欢富有表现力的机器人, 而年长用户和具有艺术背景的人则有更高的期望。 总体而言,富有表现力的机器人增强了人类与机器人的互动,但它们需要在情感和效率之间找到平衡,尤其是在实际应用中,因此应该允许用户管理机器人的表现力。

但怎么做呢?我们该如何训练这种情感表达?

优化……不是为了过度优化

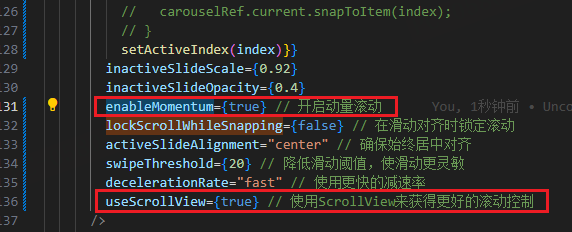

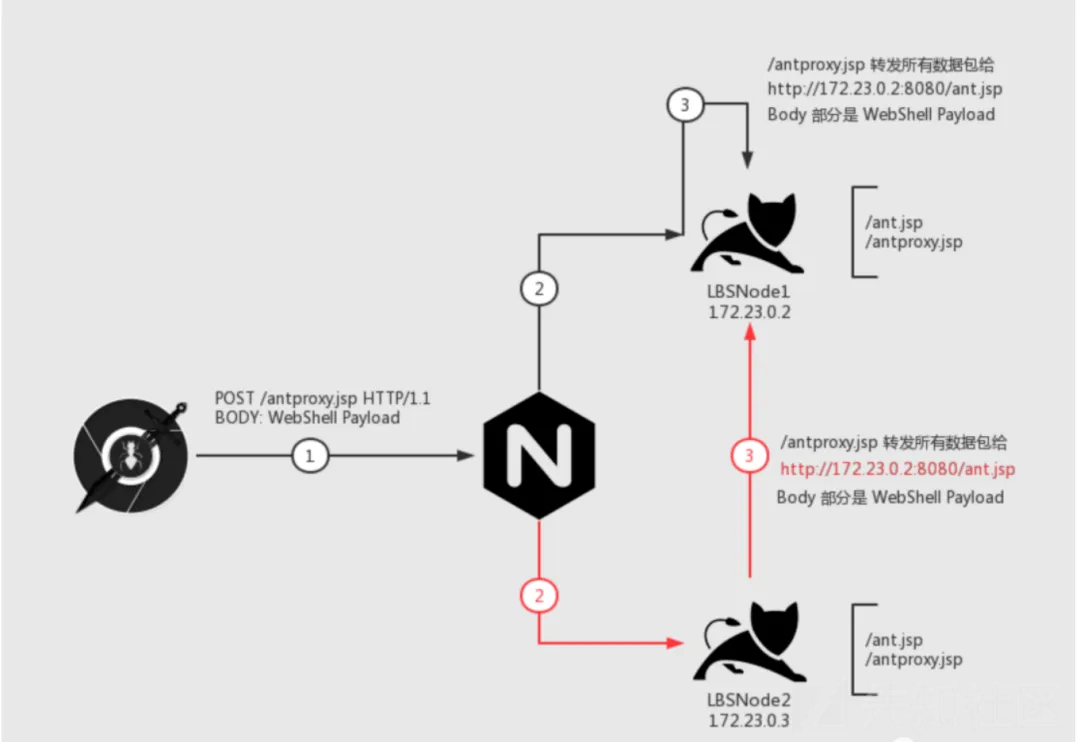

解释ELEGNT是如何被训练的最好方式是看下面的图片:

但这是什么意思呢?

理解AI学到什么

当努力理解一个AI是如何训练时,你必须始终理解训练的目标。

通常,机器人被训练来最小化自由能,也就是说,它们被训练以最有效的方式解决问题,尽可能减少移动,只要达成目标。

然而,在这个案例中,机器人并不是通过最佳和最优化的路径来完成任务,而是通过一种更加情感驱动的方式,展示它感知到的东西以及它将要做的事情,同时也达成目标。

虽然大多数AI旨在通过尽量少的动作来实现理想的结果(最具功能性的路径),但ELEGNT涉及了“额外的步骤”,丰富了整个体验。换句话说,你不仅是为了功能目的在训练它,而是还在训练它在动作中表达情感。

从数学上来说,这可以转化为下面的方程,其中机器人的行为质量、它的最大效用,不仅仅以功能性的术语来衡量,而是作为功能性和情感性行为的加权和。

‘𝞃’(tau)符号代表机器人采取的轨迹,而‘Ɣ’(gamma)是一个平衡的超参数,允许你平衡情感行为的“权重”;这个可调节的参数越小,机器人越优化功能性,反之亦然。

因此,为了让模型达到最大效用,单纯的功能最大化是不够的,因为总体效用会下降,它还必须最大化情感的展示。

对于那些更熟悉AI训练原理的人,你可以把方程的第二部分,即情感部分,视作一个正则化项。然而,这个正则化项并不是用来帮助模型更好地泛化到更多任务,而是用来“放松”机器人在当前任务上的目标,以避免过度强调功能性最大化,反而强迫它寻找更多普适性和情感驱动的解决任务的方式。

对于我读者中的那些仍然不感兴趣的人,gamma符号会允许你压制表现力,如果你不愿意接受一盏似乎理解情感的灯具。

但问题是。

看起来,似乎我们在权衡功能性,好像我们在为表现力牺牲效用。但实际上,或许我们一直在以不最优的方式训练机器人,真正的效用可能来自于机器人既具功能性又富有情感驱动?

想想我们人类。如果最大化功能性是最好的选择,为什么我们人类不是这样呢?

我们难道不应该只展示零情感,做出更具功能性的正确选择吗?

如果人类进化出展示情感作为“优化智能”的一部分,我当然认为AI也应该如此。

关于训练过程,没什么惊讶的。

一样的,但有些不同

像今天大多数机器人一样,它们把这盏灯当作一个马尔可夫决策过程(MDP),其中每个动作基于当前状态,而不是先前的状态。

MDP在计算上更可行,因为否则机器人就需要记录所有先前的动作和状态,这样在长时间的任务中可能会导致组合爆炸,令机器人变得过于昂贵。

但是,ELEGNT是深度学习,也就是神经网络吗?

苹果并没有明确说明,但由于机器人能够处于的动作和状态相对较少,它可能是通过Q学习训练的,这是一种机器人学习动作-状态奖励表的方法(在状态‘y’下执行动作‘x’会得到奖励‘z’),机器人只需实时查找表格来执行下一个动作(与深度学习不同,这是一种基于规则的方法,所以这里没有神经网络)。

但这告诉我们关于苹果未来……以及我们未来什么呢?

带有“扭曲”的机器人学

虽然大多数科技巨头是基于软件的,但苹果拥有无与伦比的硬件分发优势;它的产品和品牌几乎出现在每一个知名家庭中。然而,苹果无可否认缺乏微软或谷歌在AI软件方面的专业知识,所以它需要变得更有创意。

一段时间以来,苹果越来越关注与智能家居相关的所有事物。除了Apple Homepod,苹果据说很快会发布一款智能家居平板电脑,并且根据苹果内部人士如郭明錤的消息,他们正在考虑在2028年发布人形机器人和非人形机器人(如这盏灯)。

换句话说,苹果正在认真考虑成为一家机器人公司。

因此,如果家居软件和机器人学真的是苹果的目标,那么这盏灯对他们来说就有意义。想想看:这可能只是他们借机让AI时刻待在你家,随时准备帮助你(当然,也会顺便卖点东西)。

如果你的家变成了苹果主导,那么苹果将成为解决大部分日常问题的“门”——比如购买杂货、智能使用照明来省些钱、播放你喜欢的播客或艺术家……所有的路都会指向它们,让它们在你生活中无处不在,而这正是亚马逊和谷歌拼命想要实现的。对于那些最具远见的人,你甚至可以把这盏灯视为苹果的下一个开发者平台,用户可以付费使用新应用程序,创造新的收入来源。

毫不奇怪,所有拥有硬件存在的科技巨头都在试图侵入你的家,因为谁拥有了你的智能家居设备,谁就拥有了通向互联网的“门”。

但人类准备好了吗?

作为最后的思考,这项研究是一个很好的方式,展示人类在将物体拟人化方面的绝望。

几乎就像我们想让这盏灯活过来,理解我们,感受我们。我可以保证,你与它互动几分钟后,会忘记它其实只是在模仿模式,而底下并没有一点情感的感觉。

我喜欢这项研究的地方是,它让我们异常清晰地看到了:机器人执行的情感性行为与功能性行为并没有什么不同。

这一切都是模式模仿。

它们只是学会了,对于人类来说,点头意味着“好”(在大多数文化中),而低下透明的头是失败的标志。但这并不意味着这盏灯感到悲伤或觉得失败;它只是模仿人类行为来传达人类的情感,因为经验和奖励训练教会了它们这样做。

考虑到这一切,虽然我全心全意欢迎“人性化”的机器人进入我们的生活,但我不能不担心那些会误以为灯具有情感的人。它没有,也永远不会有,尽管我觉得,早晚会有人爱上这些东西。

AI不会杀死我们,但它可能会让一些人爱上它们。但你知道吗?我会买这盏灯。

你呢?