DeepSeek 如何在 AI 去中心化方面迈出了巨大的一步,以及为什么这比你想象的更重要

Nadia Piet + AIxDESIGN & Archival Images of AI / Better Images of AI / AI Am Over It / CC-BY 4.0

2025 年 1 月 27 日星期一,DeepSeek —— 一家几乎凭空冒出来的中国初创公司 —— 发布了他们的新 AI 模型,DeepSeek V3。与其他 AI 模型不同,DeepSeek V3 是开源的,成本大幅降低,而且它根本不需要什么最先进的 Nvidia GPU,但它的性能居然和其他最先进的 AI 模型差不多。于是,所有人都疯了,Nvidia 的股价暴跌超过 15%,纽约州一时没绷住,直接把 DeepSeek 禁止在政府设备上使用。而地球另一边,DeepSeek 的成功让中国科技股迎来了大涨行情,恒生科技指数 —— 中国科技股指数 —— 上涨了超过 25%。

DeepSeek 是谁?

DeepSeek 是一家中国 AI 公司,成立于 2023 年,由梁文峰创建,短短几年内就迅速成长为 AI 领域的重要玩家。DeepSeek 的 AI 模型迅速吸引了行业和公众的目光,因为它和现有行业标准相比有一些关键区别。举几个例子:

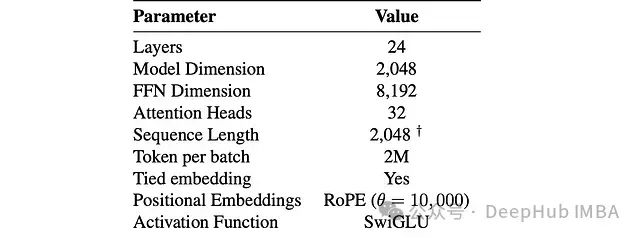

• 计算资源需求极低 —— 远远少于现有模型,也不依赖昂贵的高端 GPU。

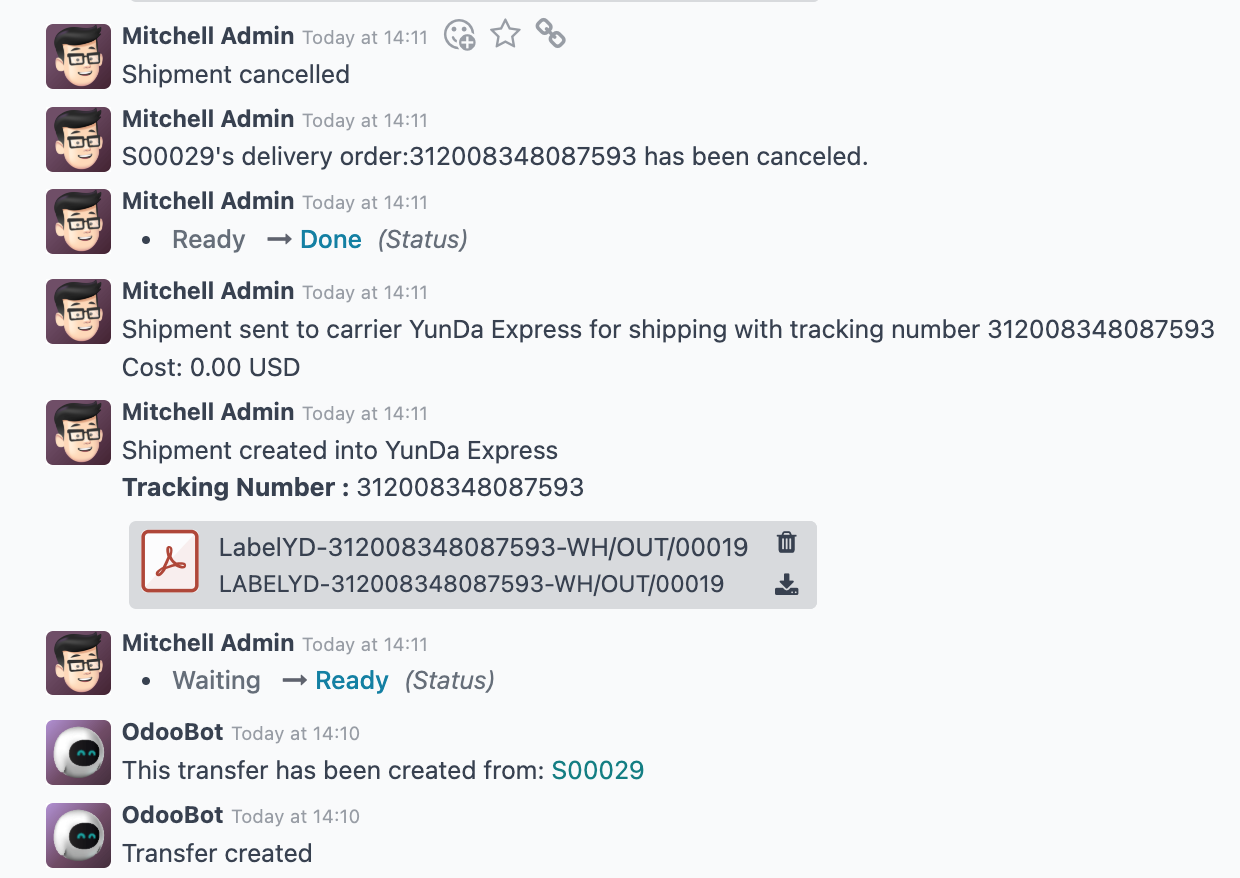

• 开源 —— 他们已经向开源社区发布了多个模型,包括 DeepSeek-R1 和 DeepSeek-V3。DeepSeek-V3 采用 Mixture-of-Experts(MoE)架构。不仅开源,还采用 MIT 许可证,允许商业用途(!)。

• 疯一样的增长 —— 仅用了 2 年时间,他们的估值就达到了数十亿美元。

简而言之,DeepSeek V3 不是又一个普通的 AI 模型,而是一个彻底的概念验证,证明了最先进的 AI 也可以是开源的、低成本的,而且能在老旧硬件上运行。这无疑是对当前昂贵、封闭的 AI 生态的重大颠覆。

但这为什么重要?

但为什么重要呢 —— AI 模型那么多,多一个少一个有什么区别?

目前 AI 领域其实只有少数几家公司和他们的模型,每一个都需要烧掉一大笔钱才能运作。比如,仅 ChatGPT 的训练成本就高达 1 亿美元,并且用了 10 万块 GPU,更别提它每天运行的成本,至少也是几十万美金起步的。不可否认,这些年 ChatGPT、Llama 或 Claude 这样的最先进 AI 模型的性能提升令人惊叹,未来只会变得更加复杂、更加“智能”。但问题是,运行这些模型的成本和资源需求,使它们不得不集中在少数几个大公司手里。

不仅仅是钱的问题,让 Meta、OpenAI 或 Google 这样的科技巨头掌控 AI 模型,还会带来一系列严重的问题,比如数据隐私、审查和垄断等等。众所周知,个人数据和注意力是 21 世纪最值钱的资源,而现在,我们基本上是心甘情愿地把这些资源拱手让给少数几家公司,让他们来决定我们的未来。这些公司掌握了海量的个人数据,不可避免地会引发伦理和隐私问题,同时也让用户暴露在隐私侵犯、黑客攻击或监控的风险之下,无论这些公司多么守法、多么“心怀善意”,这一点都无法改变。

更重要的是,控制 AI 模型的公司可以在很大程度上影响什么内容被推广,什么内容被封杀。如果 AI 模型本身存在偏见,或者受到企业利益的影响,那么它就可能在无形中操纵我们的认知。试想一下,如果只有几家公司控制了 AI 的基础设施和应用 —— 控制了我们看到的、听到的、相信的和购买的东西 —— 这种权力的集中必然会导致社会的不平衡和不公平。

从政治角度来看,DeepSeek V3 的发布在中国的 AI 自主战略中也至关重要。它有助于减少对西方芯片制造商的依赖,不再需要花大价钱去买上一代的 Nvidia GPU,同时推动本土创新的加速发展。

Anyway!

想当年,IBM 的大型主机计算机大到能占满整个房间,没人能想象有一天能拥有一台个人电脑。70 年代计算机界的领军人物 Ken Olsen 甚至说过:“根本没有人会想要一台放在家里的计算机。” 这句话现在听起来简直像个笑话,因为随着晶体管和集成电路的发展,计算机变得越来越小、越来越快、越来越高效。到了 90 年代和 2000 年代,个人电脑进入千家万户,带来了博客、电商、社交媒体,甚至是暗网。

所以,真正的突破可能并不是在于让 AI 变得“更智能” —— 现有的 AI 已经足够聪明,可以帮助普通人处理日常任务 —— 而是在于创造更简单、更便宜,并且具备去中心化潜力的 AI。而这正是 DeepSeek 的成就。

DeepSeek V3 号称和 ChatGPT、Llama、Claude 等最先进的 AI 模型性能相当,但训练成本仅为 560 万美元,相当于 ChatGPT 训练成本的 5.6% —— 便宜了 94.4%!

然后,就是关键点!

一个更简单、更便宜的 AI 模型意味着它可以被大规模、去中心化地分发,而不是被集中运行。这才是 AI 的终极目标!去中心化运行 AI 模型不仅能释放巨大的潜力,还能带来更好的隐私、安全性和自主权。

DIY 现实

真正的问题是,如果你有一个私人的 ChatGPT 运行在家里,你会用它来做什么?如果“妈妈” OpenAI 不再盯着我们,我们还会继续做“好孩子”吗?嗯……

• 也许你会用它在 Reddit 上疯狂发帖,制造无休止的讨论,让所有人都相信我们活在一个模拟世界里。

• 创建一支 AI 生成的“Karen 大军”,不断打电话给客服要求“让我和经理谈谈!”

• 写一堆假论文,引用假的来源,证明世界领导人其实是会变形的蜥蜴人?🦎

• 建立一个邪教,忽悠所有人相信你是“天选之人”。

在社交媒体上洗脑大家“鸟类根本不存在”;用 AI 生成的悖论灌满学术界;用虚假内幕消息淹没股市 —— 可能性无穷无尽。啊,我已经迫不及待了!我的意思是,如果每个人都能运行自己的 AI,那制造信息混乱就太简单了。

实际上,我们似乎已经默认这种混乱迟早会发生 —— Meta 放弃事实核查就是个信号。2025 年 1 月,这个全球最大社交媒体平台基本上告诉我们:“呃,祝你好运吧” 🤷♀️ —— 现在的现实,是一个需要自己拼凑的拼图!

所以,最终的结局是什么?

AI 的去中心化,会带来自由、隐私和自主权,还是会带来一场彻底的混乱?毫无疑问,AI 去中心化是不可避免的,就像当年大型主机被个人电脑取代一样。但问题是,一个去中心化的 AI 体系真的能运行顺畅吗?还是说,我们最终还是需要“大公司爸爸妈妈”来掌舵?