本文将从基础硬件购置开始讲起,真正意义上从零开始,最终通过Ollama、LangChain、DeepSeek的一系列交互,输出本地大模型的第一声啼鸣,带你走进另一片广阔的世界。update:2025-02-23

硬件方面

主板选型:

主机组装:

P40显卡拆解,改散热:

kali显卡驱动安装

软件方面

ollama服务端配置

ollama安装没什么难度,建议直接参考官网https://ollama.com,根据安装提示一直按下一步即可,安装模型命令是ollama pull 模型名称。

ollama服务端执行export OLLAMA_HOST=0.0.0.0:11434;ollama serve ;开启外部网络访问支持。启动后可执行ollam list查看本地已部署模型信息,以下是我之前安装过的。

conda虚拟环境部署

软件环境部署:

conda create -n LangChainP312 python==3.12conda activate LangChainP312pip install --upgrade langchainpip install --upgrade langchain-ollama

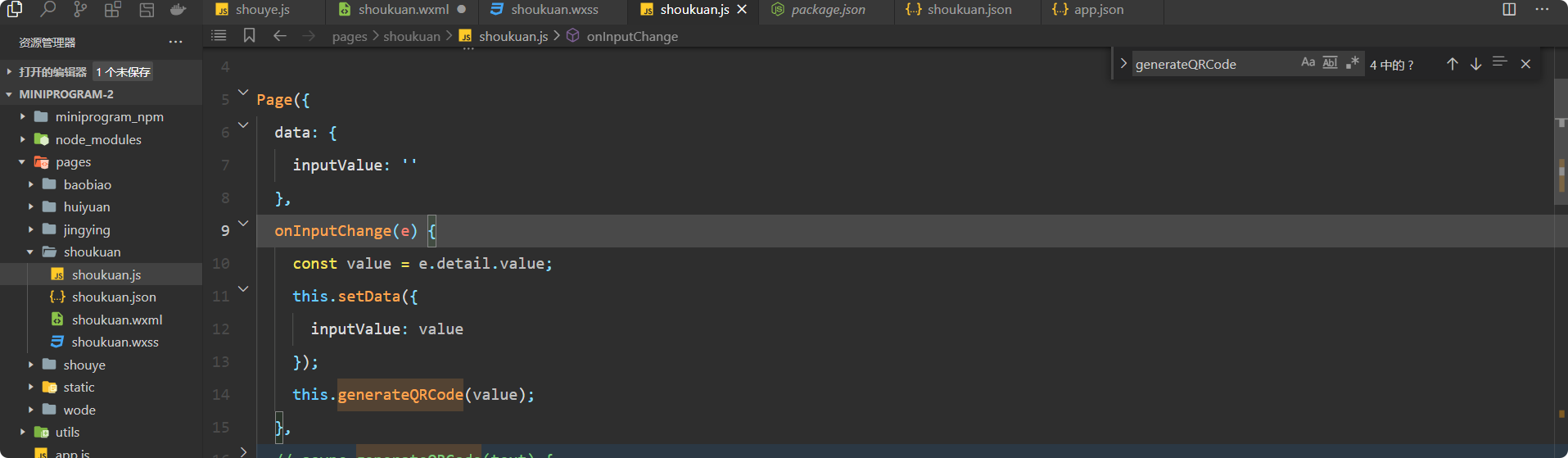

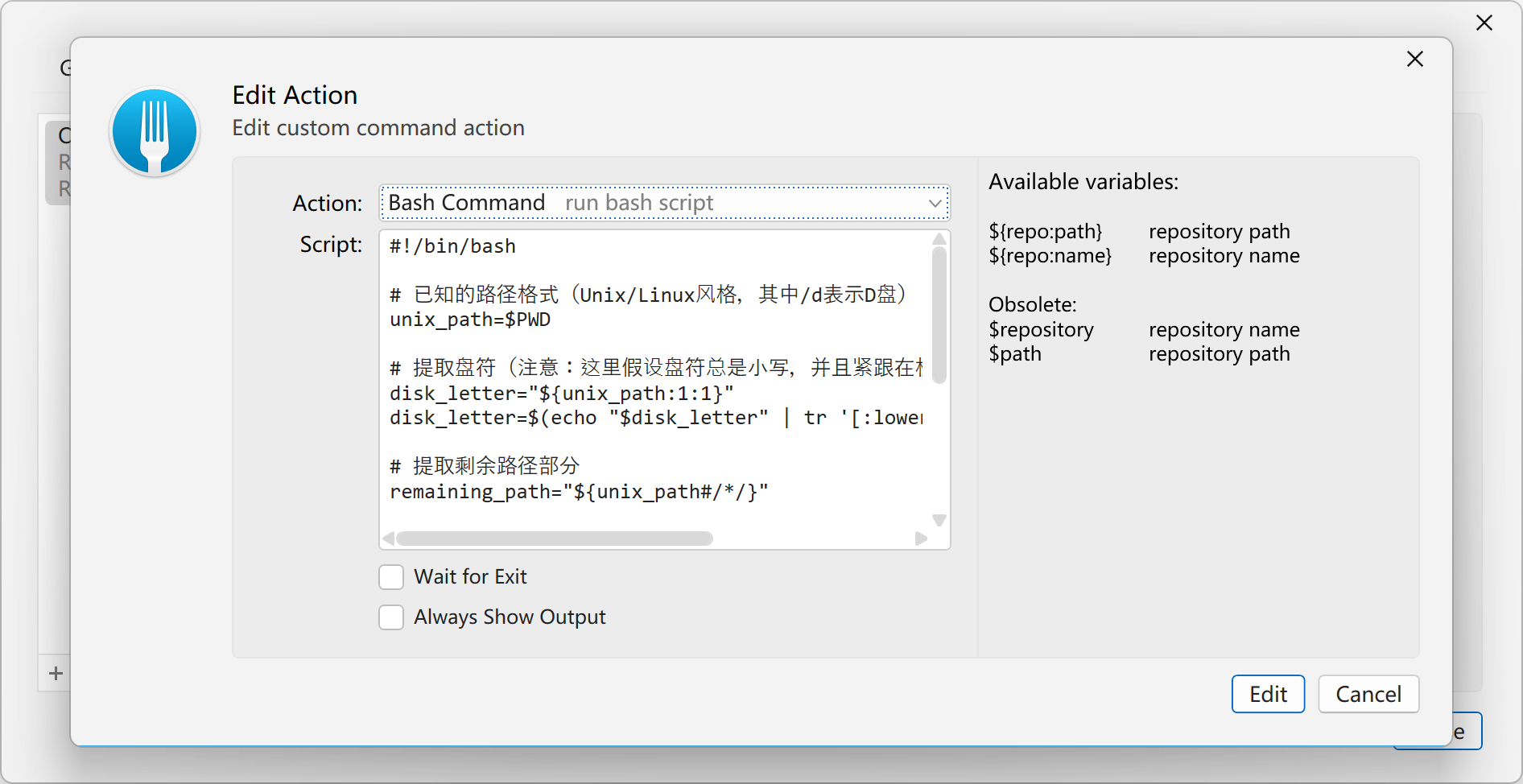

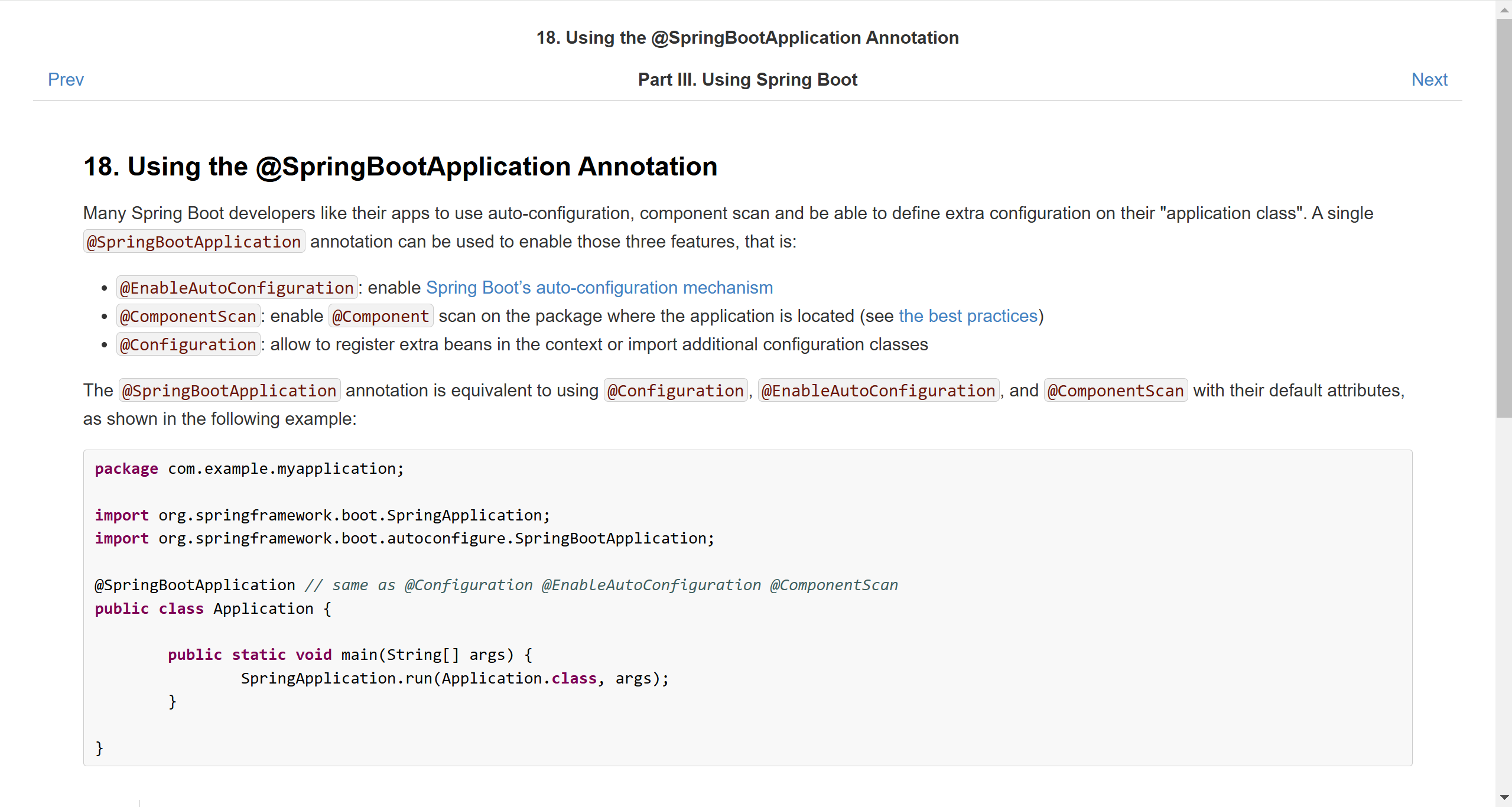

开发工具vs code,官网是https://code.visualstudio.com/Download,ubuntu系列linux执行sudo dpkg -i xxx.deb即可,windows安装步骤仍是各种下一步下一步,最后左侧安装一下python代码支持。

然后新建一个py文档开始写代码,注意和conda环境关联方法: 快捷键CTRL SHIFT P选择interpreter,指定conda环境LangChainP312。

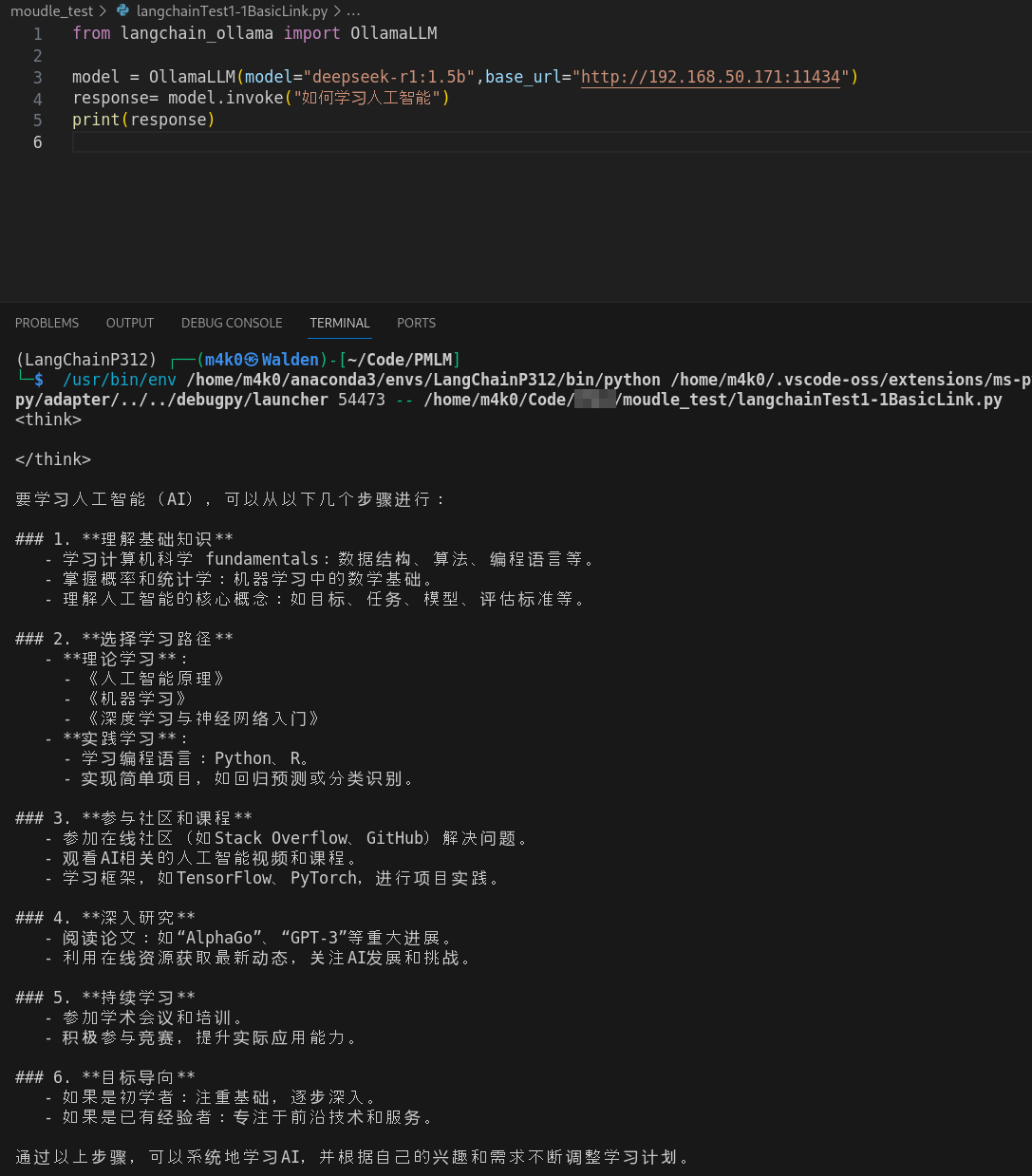

客户端langchain代码编写

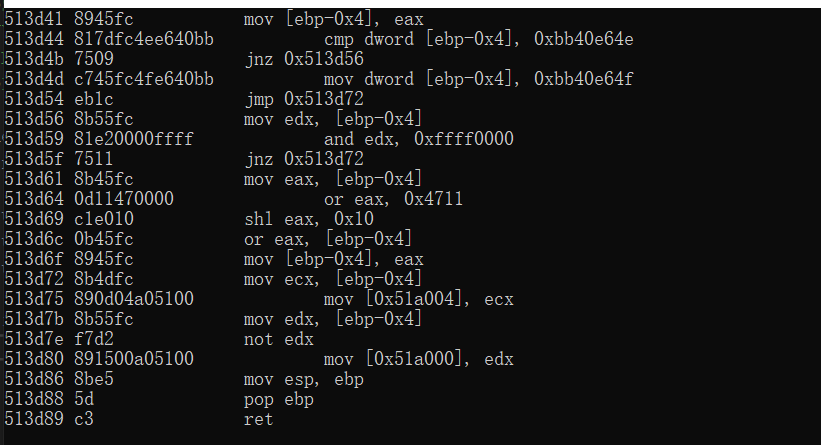

from langchain_ollama import OllamaLLM#更多参数配置,可以在OllamaLLM函数名位置右键或者F12跳转到源码位置

model = OllamaLLM(model="deepseek-r1:1.5b",base_url="http://192.168.50.171:11434")response= model.invoke("如何学习人工智能")print(response)

然后CTRL+F5就可以运行代码了,运行效果如下: