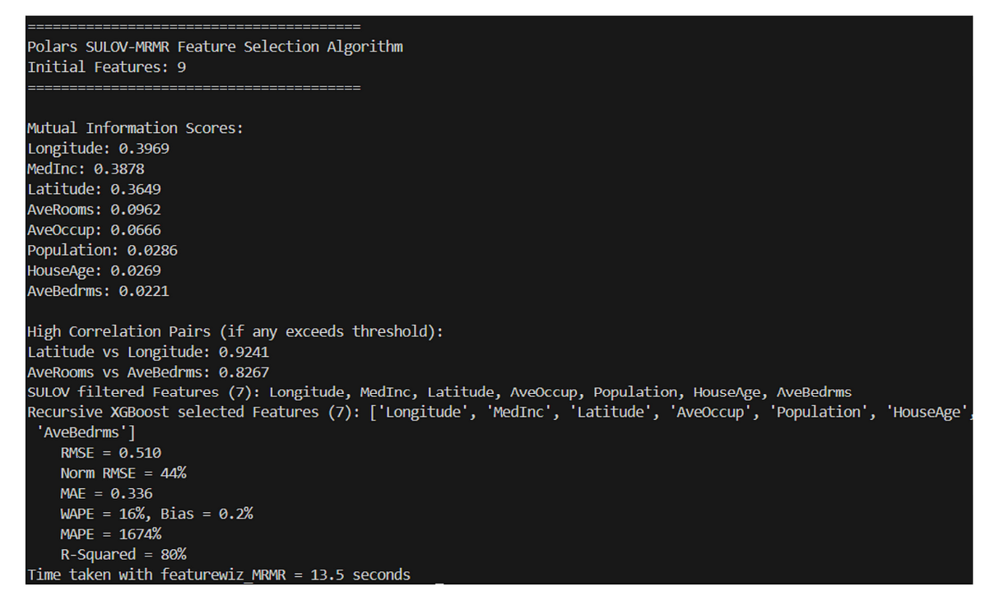

一、Hive中 join操作是如何完成的?

在Hive中,Join操作是通过MapReduce框架来实现的。假设现在users表与orders表用user_id字段进行连接操作,SQL语句如下:

SELECT u.user_id, u.username, o.order_id, o.amount

FROM users u

JOIN orders o ON u.user_id = o.user_id;

Map阶段

users表的Map输出

- 键(Key):

user_id - 值(Value):

<username, registration_date>(假设users表中有username和registration_date字段)

例如:

(user_1, ("Alice", "2020-01-01"))(user_2, ("Bob", "2020-02-01"))(user_3, ("Charlie", "2020-03-01"))

orders表的Map输出

- 键(Key):

user_id - 值(Value):

<order_id, amount>(假设orders表中有order_id和amount字段)

例如:

(user_1, (order_1, 100))(user_1, (order_2, 200))(user_2, (order_3, 150))(user_3, (order_4, 300))

Shuffle和Sort阶段

在Shuffle和Sort阶段,中间键值对会根据user_id进行分区和排序。例如:

-

user_1的所有记录会被发送到同一个Reducer节点:(user_1, ("Alice", "2020-01-01"))(user_1, (order_1, 100))(user_1, (order_2, 200))

-

user_2的所有记录会被发送到另一个Reducer节点:(user_2, ("Bob", "2020-02-01"))(user_2, (order_3, 150))

-

user_3的所有记录会被发送到另一个Reducer节点:(user_3, ("Charlie", "2020-03-01"))(user_3, (order_4, 300))

Reduce阶段

在Reduce阶段,Reducer任务会处理具有相同user_id的记录,并执行Join操作。例如:

-

对于

user_1:- 输入:

(user_1, ("Alice", "2020-01-01"))(user_1, (order_1, 100))(user_1, (order_2, 200))

- 输出:

(user_1, "Alice", "2020-01-01", order_1, 100)(user_1, "Alice", "2020-01-01", order_2, 200)

- 输入:

-

对于

user_2:- 输入:

(user_2, ("Bob", "2020-02-01"))(user_2, (order_3, 150))

- 输出:

(user_2, "Bob", "2020-02-01", order_3, 150)

- 输入:

-

对于

user_3:- 输入:

(user_3, ("Charlie", "2020-03-01"))(user_3, (order_4, 300))

- 输出:

(user_3, "Charlie", "2020-03-01", order_4, 300)

- 输入:

二、问题是如何产生的?

上述执行join操作的过程中,如果某些用户的订单记录非常多,那么处理这些用户的Reducer节点负载会非常高,而处理其他用户的Reducer节点负载则很低。这种数据分布不均的情况就是Hive中join操作的数据倾斜问题。产生数据倾斜问题的原因如下:

- 数据分布不均:某些Key在业务场景中天然存在大量数据(如热门商品、活跃用户)。

- 数据质量问题:存在大量空值或默认值(如

NULL或0),导致这些Key被集中处理。 - 业务逻辑特性:例如,测试用户(如

user_A)的订单数据被高频插入,形成大Key。

三、如何解决?

- 数据预处理

- 过滤异常值:提前过滤掉空值或异常值。

- 拆分大key:将大key拆分为多个小key。

- 优化SQL

- Map Join:对小表使用Map Join,避免Shuffle阶段。

- 倾斜key单独处理:将倾斜key单独处理后再合并结果。

- 调整参数

- 增加Reducer数量:通过

hive.exec.reducers.bytes.per.reducer调整。 - 启用倾斜优化:设置

hive.optimize.skewjoin为true。

- 增加Reducer数量:通过

- 使用随机数

- 添加随机前缀:对大key添加随机前缀,分散数据。

四、案例分析

问题产生

假设有两张表:

- 用户表(users):100万用户,用户ID均匀分布。

- 订单表(orders):1亿条订单,其中用户A(测试用户)有5000万条,用户B有3000万条,其余用户订单较少。

执行以下Join操作时,用户A和B的订单集中在少数Reducer,导致任务卡顿。

解决方案

(1) 过滤异常用户

直接消除倾斜源,但会丢失用户A和B的数据。

-- 直接过滤测试用户A和B的订单

WITH filtered_orders AS (SELECT * FROM orders WHERE user_id NOT IN ('user_A', 'user_B')

)

SELECT u.user_id, u.username, o.order_id, o.amount

FROM users u

JOIN filtered_orders o ON u.user_id = o.user_id;

(2) 拆分大用户

将用户A和B的订单分散到10个子Key(user_A_0到user_A_9),每个Reducer处理约500万条用户A数据和300万条用户B数据,负载均衡。

-- 为用户A和B的订单添加随机后缀(如user_A_0, user_A_1)

WITH split_orders AS (SELECT user_id,order_id,amount,CASE WHEN user_id IN ('user_A', 'user_B') THEN CONCAT(user_id, '_', CAST(FLOOR(RAND() * 10) AS STRING))ELSE user_idEND AS new_user_idFROM orders

)

SELECT u.user_id, u.username, o.order_id, o.amount

FROM users u

JOIN split_orders o ON u.user_id = o.new_user_id;

(3) 使用map join

在Map阶段直接处理大表(如订单表)的每个分片,本地匹配内存中的小表数据,无需按Key分发数据。

-- 启用MapJoin并调整小表阈值

SET hive.auto.convert.join=true; -- 自动转换MapJoin

SET hive.mapjoin.smalltable.filesize=250000000; -- 设置小表阈值(例如250MB)-- 强制使用MapJoin关联用户表和订单表

SELECT /*+ MAPJOIN(u) */ u.user_id, u.username, o.order_id, o.amount

FROM users u

JOIN orders o ON u.user_id = o.user_id;

(4) 参数调优(辅助手段)

通过调整参数,Hive自动对倾斜Key进行优化处理。

-- 增加Reducer数量并启用倾斜优化

SET hive.exec.reducers.bytes.per.reducer=256000000; -- 每个Reducer处理256MB数据

SET hive.optimize.skewjoin=true; -- 启用倾斜优化

![[c++算法] 树的直径,包教包会!](https://cdn.luogu.com.cn/upload/image_hosting/9pp20ekl.png)