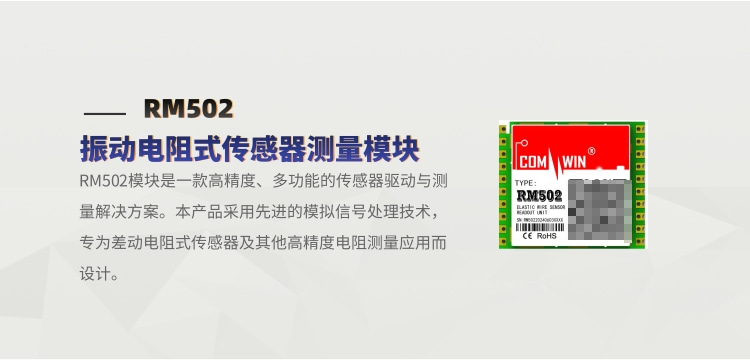

ReAct:结合推理(COT)和行动(动作生成)。

ReAct

主要内容

- 将COT方法与ACT方法结合起来,引入了 ReAct,这是一种新的基于提示的范式,旨在将推理和行动在语言模型中协同起来,以解决通用任务。

- 展示了在少样本学习设置中,ReAct 相较于仅进行推理或动作生成的先前方法的优势。

- 系统的消融实验和分析,以理解在推理任务中行动的重要性,以及在交互任务中推理的重要性

- 分析了 ReAct 在提示设置下的局限性(即推理和行动行为的支持有限),并进行了初步的微调实验,展示了 ReAct 通过额外训练数据改进的潜力。将 ReAct 扩展到更多任务的训练和操作,并将其与强化学习等互补范式结合,可以进一步释放大型语言模型的潜力。

动机和方法

改进COT方法的幻觉

对于 HotpotQA 和 FEVER,我们从训练集中随机选择了 6 个和 3 个案例,并手动编写了 ReAct 格式的轨迹,用作提示中的少样本示例。类似于图 1(d),每个轨迹包含多个思考-行动-观察步骤(即密集思考),其中自由形式的思考用于各种目的。

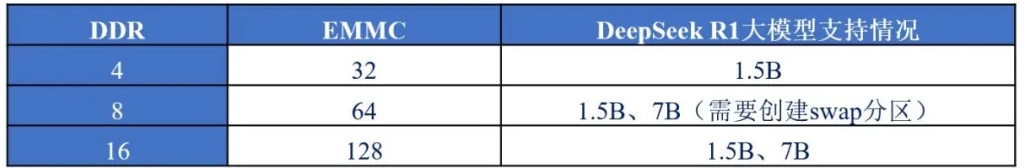

由于大规模手动标注推理轨迹和行动的挑战,我们考虑了一种类似于 Zelikman 等人(2022)的引导方法,使用由 ReAct 生成的 3,000 个正确答案的轨迹(也用于其他基线)来微调较小的语言模型(如 PaLM-8/62B),以根据输入的问题/声明解码轨迹(包括所有的思考、行动和观察)。这种方法可以帮助模型在少量标注数据的基础上学习生成高质量的推理轨迹,从而提高在复杂任务中的表现。

实验分析

数据集

我们考虑了两个具有挑战性的知识检索和推理的数据集:(1) HotPotQA(Yang et al., 2018),一个多跳问答基准,要求在两个或多个维基百科段落上进行推理;(2) FEVER(Thorne et al., 2018),一个事实验证基准,每个声明根据是否存在维基百科段落来验证其真实性,被标注为 SUPPORTS(支持)、REFUTES(驳斥)或 NOT ENOUGH INFO(信息不足)。

动作空间

设计了一个简单的维基百科web API,包含3个动作:搜索、查找(Ctrl+F)和结束

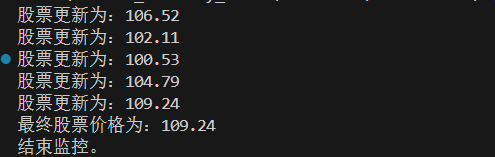

实验结果

![LGP8125 [BalticOI 2021] The short shank 学习笔记](https://s21.ax1x.com/2025/02/26/pE1b27j.md.png)