GPT 4.5 可能是戳破 AI 泡沫的模型

Andrew Zuo

本文点评:在AI技术狂飙突进的同时,也有许多声音包括本文的作者在内都认为AI行业正陷入巨大泡沫,技术突破逐渐停滞,高昂的硬件成本与资本退潮或将引爆寒冬。然而,这些观点大多忽视了技术的本质价值,真正值得关注的并非模型参数是否再翻百倍,而是现有AI技术已经实实在在推动各行业降本增效、提升生产力。AI的价值从来不只是技术炫技,而是作为工具深度嵌入社会生产,带来生产方式与商业模式的深刻变革。技术高原期,并非泡沫破裂的信号,而是AI赋能产业全面加速的起点。

AI 正处在一个泡沫里,而且已经在泡沫里待了挺长时间了。基本上每一家 AI 公司都在赔钱。微软每个 Copilot 用户都在亏钱,Anthropic 在亏钱,甚至 OpenAI 也在亏钱。是的,连他们那个每月 200 美金的专业版订阅:

离谱的事情:我们现在在 OpenAI 专业订阅上是亏钱的!

大家用得比我们预期的多得多。

你怎么能在一个每月 200 美金的订阅上亏钱啊!?

AI 明显是不可持续的。每家公司都只是在烧钱,拼命往下卷。

我其实已经想了很久,这个泡沫什么时候会破。唯一还没破的原因就是一堆蠢投资人还在妄想着赚大钱,不断砸钱进去。当他们意识到 AI 的进展已经停滞,他们就会停止这种荒唐的融资狂潮,AI 泡沫就会破。

而且我觉得我们离那个点已经不远了。我之前写过一篇文章,标题是《LLM 已经停滞的三个原因》,里面讲了 AI 产业面临的三个大问题:硬件问题、电力短缺、还有模型崩溃。

但即便这样,各家公司还是继续把模型做得越来越大、越来越强。但我觉得我们终于在刚发布的 GPT 4.5 上撞到天花板了。而且我觉得 GPT 4.5 可能就是那个戳破 AI 泡沫的模型。

首先让我们看看我们是怎么走到这一步的。目前的 AI 热潮其实就是靠把模型越做越大撑起来的。GPT-1 有 1.17 亿参数。GPT-2 有 15 亿参数。GPT-3 有 1750 亿参数。现在 OpenAI 并没有公开 GPT-4 有多少参数,但网上很多乱七八糟的人都很大胆地声称他们知道具体参数是多少。他们通常猜大概是 1.7 万亿参数左右。

那 GPT-5 会有多少参数呢?GPT-2 大概是 GPT-1 的 12.8 倍。然后 GPT-3 又比它大了大概 116.6 倍。再然后 GPT-4 又比 GPT-3 大了大概 9.7 倍。所以我们大概可以预计 GPT-5 会比 GPT-4 大个 10 到 100 倍。为了讨论方便,我们就假设它大概是 30 倍,大约是 51 万亿参数。30 倍大,也就意味着 30 倍贵。

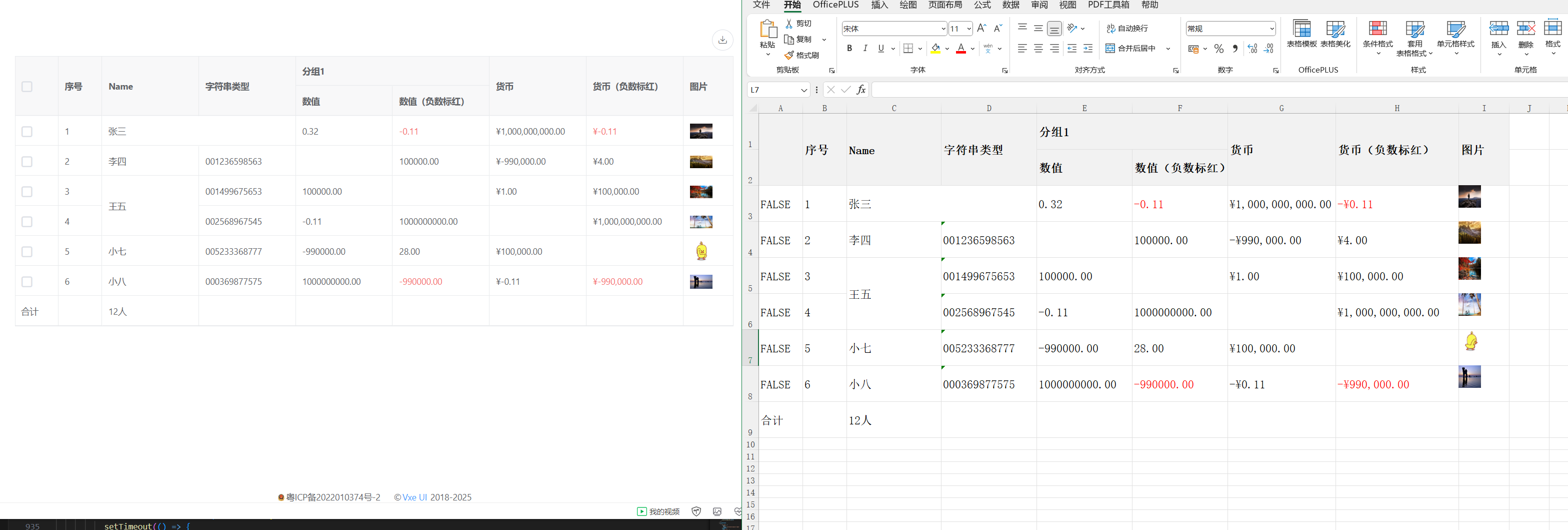

这个就很有意思了,因为 OpenAI 最近发布的这个 GPT-4.5,大概就是 GPT-4o 成本的 30 倍:

这让我怀疑 GPT-4.5 本来是要叫 GPT-5 的,但因为表现太让人失望了,他们才改名叫 GPT-4.5。其实我们之前都知道这个模型的代号:Orion。而且当时大家都说它会非常厉害。

结果呢?并不是!

实际上在发布公告里他们自己都说了:

GPT 4.5 是一个非常庞大且计算密集的模型,所以它比 GPT 4o 贵,而且不是 GPT 4o 的替代品。基于这个原因,我们正在评估是否要在 API 里长期提供它,因为我们需要在支持当前能力和构建未来模型之间做平衡。我们期待在真实场景里更多了解它的优点、能力和潜在应用。如果 GPT 4.5 对你的使用场景有独特价值,你的反馈会对我们决定方向起到重要作用。

“我们正在评估是否要在 API 里长期提供它” 这个话确实不太让人放心。

其他人也指出 GPT-4.5 的表现让人失望。ArsTechnica 直接称它是“柠檬货”,说“已经盖棺定论:OpenAI 最新、最强的传统 AI 模型 GPT-4.5 又大、又贵、又慢,比 GPT-4o 只强了一点点,成本却贵了 30 倍输入和 15 倍输出。”而且很多人都表达了类似的看法。

虽然我也不确定这些吐槽要不要全信。大家都很快指出它贵了 30 倍。但其实这个模型比 GPT-4 刚发布那会儿也没贵多少。

GPT-4 刚发布时,他们不是按百万 token 计费的,而是按千 token 计费。而且当时有两个版本:一个是 8K 上下文窗口的,一个是 32K 上下文窗口的。贵的那个每千输入 token 要 6 美分,每千输出 token 要 12 美分。也就是每百万输入 token 60 美金,每百万输出 token 高达 120 美金。对,GPT-4 刚出来的时候就是贵到离谱,所以我才不想在我的应用里用它。

如果 OpenAI 当初把 Orion 直接叫 GPT-5,我敢肯定成本最后也会慢慢降下来。他们可能后面还会出 GPT-5o 和 GPT-5o mini。那为什么没这样做?

因为 GPT-4 刚发布的时候,它确实比 GPT-3.5 好太多了。谁还记得这张图:

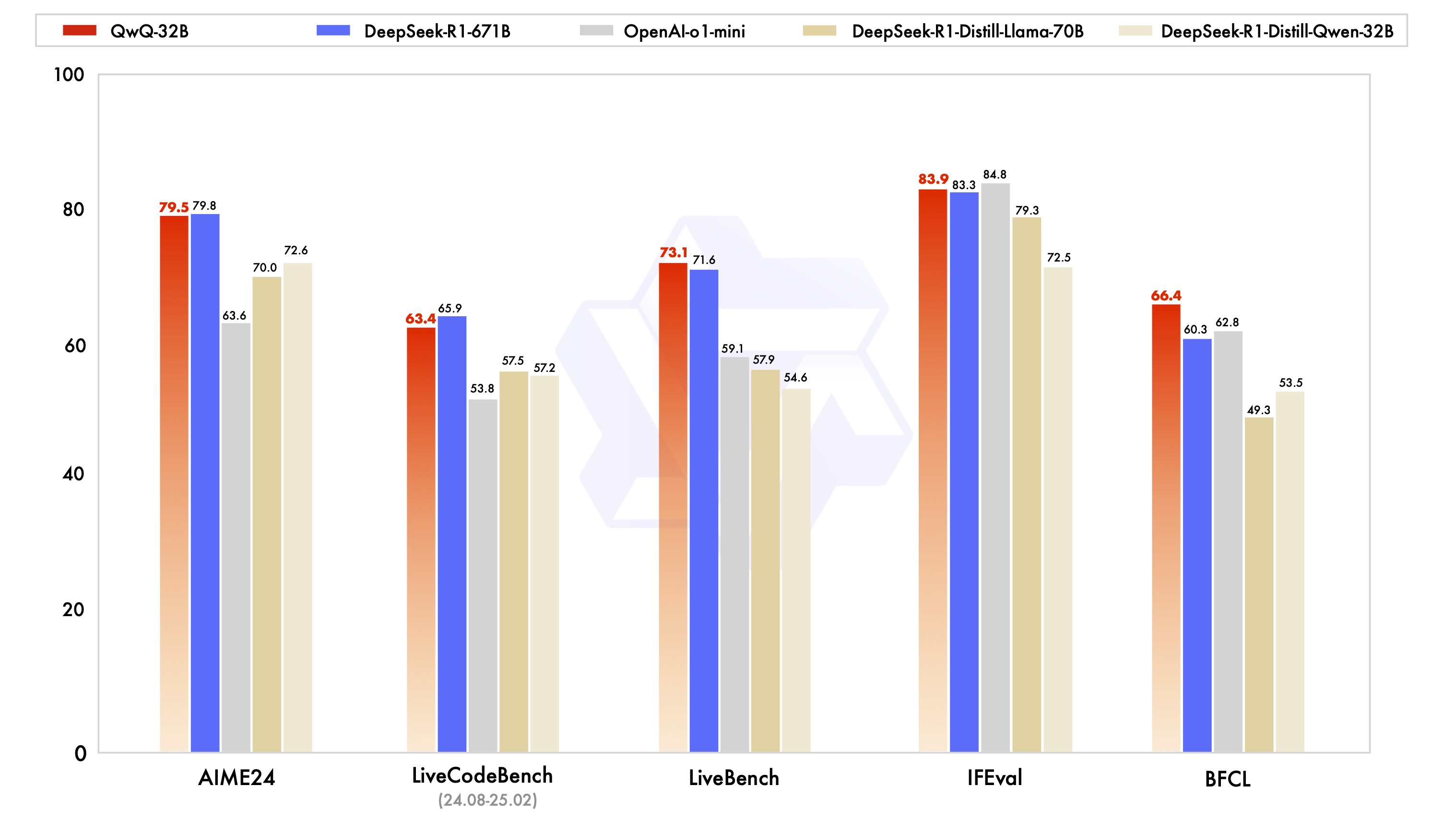

这跨度确实挺大的。是贵了很多,但跟 GPT-3.5 比确实提升很大。那 Orion 呢?嗯……

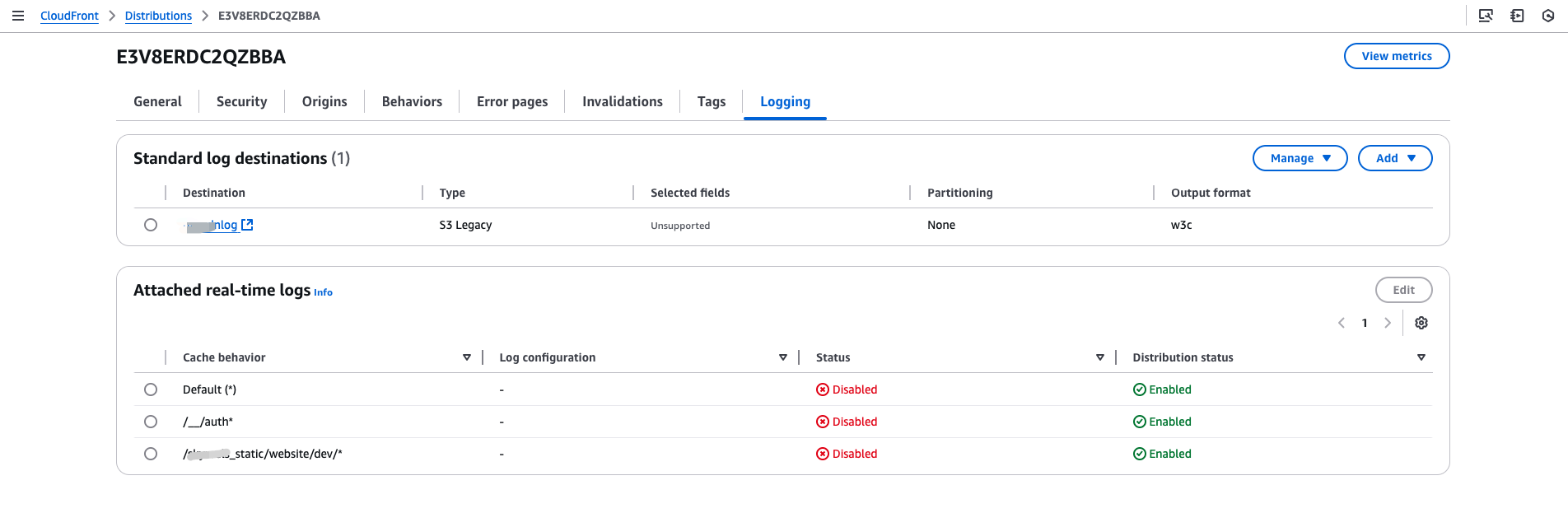

他们只展示了这些图,这让我怀疑 GPT-4.5 在很多方面其实打不过 GPT-4o。而且有意思的是,这些图里根本没包含 o3 reasoning 模型,只放了 o3-mini。

不过至少 OpenAI 说它有更多的情绪智能。这让我想起我之前文章里写的一句话:

这就是为什么我们要有情绪智能。这是个笑话,情绪智能根本就不存在。

而且对话感觉更自然的原因,就是你们特意微调成这样的。GPT-3.5 当初也是一样的。GPT-4o 的时候,他们加了一堆乱七八糟的微调,让它每个问题都必须详细解释,因为用户就喜欢那套。

当然,现在还是有可能会出个类似 o4 的模型,基于 Orion 搞的,能打过 o3。但问题是这种思考型模型都需要额外很多 token 去“思考”。如果用 Orion 来思考,那就会贵到离谱。而且还会把所有 GPU 都占满。

坏消息:它是个巨大、昂贵的模型。我们本来真的很想同时推给 plus 和 pro 用户,但最近用户增长太快,我们 GPU 都不够用了。我们下周会新增几万块 GPU,然后推给 plus 用户。(后面还会再加几十万块,我敢肯定你们会把我们能装上的每一块都用光。)

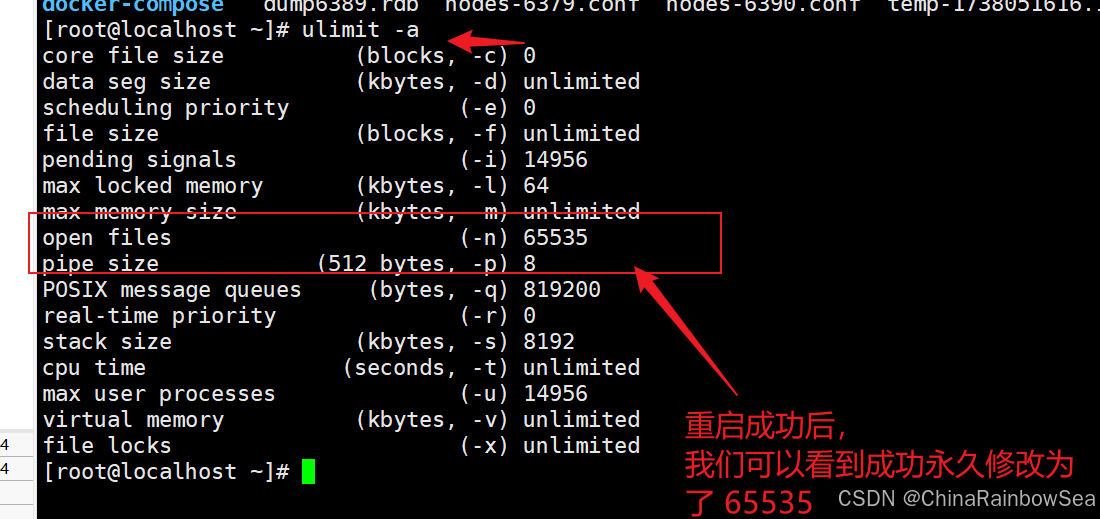

Orion 大概是 30 倍规模,所以也大概需要 30 倍的 GPU。GPT-4 推出来时还不是问题,但 Nvidia 这两年根本没跟上 AI 市场的扩张速度,所以现在 Orion 被 GPU 卡住了。

看来我得给 LLM 停滞的原因再加一条:硬件问题、电力短缺、模型崩溃,还有现在的 GPU 短缺。

所以我真看不出 AI 产业还能往哪走。OpenAI 已经证明了,单纯靠模型规模暴力堆上去,已经不再带来显著性能提升了。大语言模型这种“简单堆料”的时代要结束了。AI 泡沫破掉之后,可能我们会迎来下一个 AI 寒冬。而 GPT 4.5 可能就是那个引爆点。