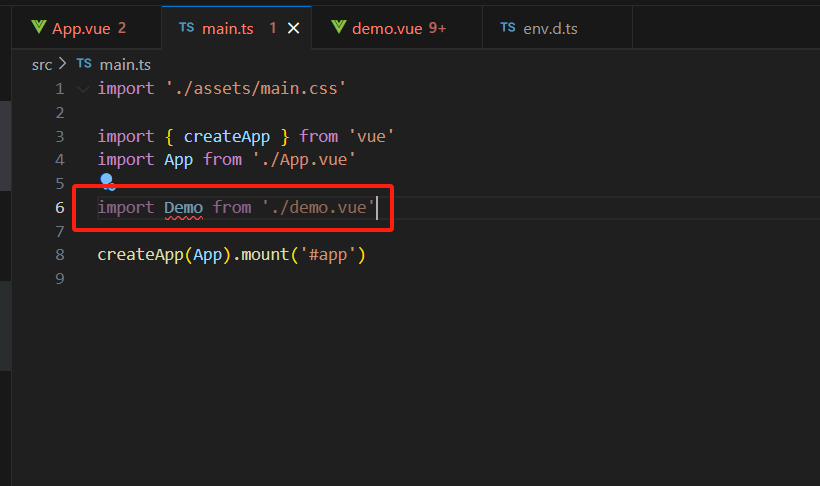

nn.Linear不是可以自动展平吗?为什么还要添加nn.Flatten()?实际上,这两者的展平是不同的,前者的展平主要用在Seq2Seq里面,是最后一维不同,前两维合并,而后者的展平是第一维不同,后两维合并。具体用法如下

在 PyTorch 中,nn.Flatten() 是一个用于将张量(Tensor)展平为一维向量的层。它的主要作用是将多维的张量转换为适合全连接层(Fully Connected Layer)处理的一维形式。以下是其详细说明:

作用

-

展平张量:

- 将输入张量的除 batch 维度外的其他维度合并为一个维度。

- 例如,输入形状为

(batch_size, C, H, W)的图像张量,经过Flatten()后会变成(batch_size, C*H*W)。

-

简化模型定义:

- 在神经网络中,通常在卷积层(Convolutional Layer)之后需要将特征图(feature maps)展平为一维向量,以便输入到全连接层(Dense Layer)。

Flatten()提供了一个简洁的方式实现这一操作。

- 在神经网络中,通常在卷积层(Convolutional Layer)之后需要将特征图(feature maps)展平为一维向量,以便输入到全连接层(Dense Layer)。

参数

nn.Flatten() 可以接受两个可选参数:

start_dim:从哪个维度开始展平(默认为1,即从 batch 维度之后的第一个维度开始)。end_dim:展平到哪个维度(默认为-1,即展平到最后一个维度)。

示例参数说明:

Flatten(start_dim=1, end_dim=-1):默认行为,展平所有维度(除 batch 维度外)。Flatten(start_dim=2):从第 2 维(假设输入是(B, C, H, W),则从H开始展平)。Flatten(start_dim=1, end_dim=2):展平C和H维度,保留W维度。

使用方法

1. 基本用法

import torch

import torch.nn as nn# 定义一个包含 Flatten 层的模型

model = nn.Sequential(nn.Conv2d(3, 16, kernel_size=3), # 卷积层nn.ReLU(),nn.MaxPool2d(2),nn.Flatten(), # 展平层nn.Linear(16 * 14 * 14, 10) # 全连接层

)# 输入示例:假设输入图像形状为 (batch_size=1, channels=3, height=28, width=28)

x = torch.randn(1, 3, 28, 28)

output = model(x)

print(output.shape) # 输出形状为 (1, 10)

2. 自定义展平范围

# 展平从第 2 维度开始到最后一个维度

flatten_layer = nn.Flatten(start_dim=2)

x = torch.randn(2, 3, 4, 5) # 输入形状为 (2, 3, 4, 5)

y = flatten_layer(x) # 输出形状为 (2, 3, 20)(4*5=20)

为什么需要 Flatten?

在神经网络中,常见的场景如下:

-

卷积层 → 全连接层:

- 卷积层的输出通常是

(batch_size, channels, height, width)的 4D 张量。 - 全连接层需要输入为

(batch_size, features)的 2D 张量,因此需要展平。

- 卷积层的输出通常是

-

避免手动计算维度:

- 手动计算展平后的维度(如

channels * height * width)容易出错,而Flatten()可自动处理。

- 手动计算展平后的维度(如

Flatten 与 Reshape 的区别

-

Flatten:

- 是一个 PyTorch 层(Layer),直接嵌入在模型中。

- 自动计算展平后的维度,无需手动指定目标形状。

- 适用于模型定义中的动态展平。

-

reshape:

- 是张量的 方法(如

tensor.reshape(-1)),需要手动指定目标形状。 - 需要明确知道展平后的维度,否则可能导致形状错误。

- 不属于模型的一部分,通常用于数据预处理。

- 是张量的 方法(如

示例对比:

# 使用 Flatten 层

x = torch.randn(1, 3, 28, 28)

model = nn.Sequential(nn.Flatten(),nn.Linear(3*28*28, 10)

)

output = model(x) # 自动计算展平后的维度# 使用 reshape

x_flattened = x.reshape(x.shape[0], -1) # 需要手动指定目标形状

linear = nn.Linear(3*28*28, 10)

output = linear(x_flattened) # 需要手动计算维度

常见问题

-

输入已经是 2D,展平后会怎样?

- 如果输入已经是 2D(如

(batch_size, features)),Flatten()不会改变其形状。

- 如果输入已经是 2D(如

-

如何处理动态输入形状?

Flatten()可以自动处理不同 batch_size 或动态输入形状,无需手动调整。

-

Flatten 是否影响梯度?

- 不影响。展平操作是线性变换,梯度会正确反向传播。

总结

- 作用:将多维张量展平为一维(保留 batch 维度)。

- 适用场景:卷积层与全连接层之间,简化模型定义。

- 参数:通过

start_dim和end_dim自定义展平范围。 - 优势:自动处理维度计算,避免手动 reshape 的繁琐。

通过 nn.Flatten(),你可以更高效、简洁地构建复杂的神经网络模型。