ReLU,全称为Rectified Linear Unit(线性修正单元),是一种在深度学习中广泛使用的激活函数。它的作用是向神经网络引入非线性因素,使网络能够学习和执行更复杂的任务。

ReLU函数的定义

ReLU函数的数学表达式非常简单:

f(x)=max(0,x)

这意味着,对于所有正数输入,ReLU函数直接返回该值;而对于所有负数输入,它返回0。换句话说,ReLU函数将所有负值截断为0,而保留正值不变。

ReLU的作用

-

引入非线性:

-

神经网络需要非线性激活函数来学习和执行非线性任务。如果没有激活函数,无论神经网络有多少层,其实都等同于一个线性模型,这将大大限制网络的表达能力。

- (

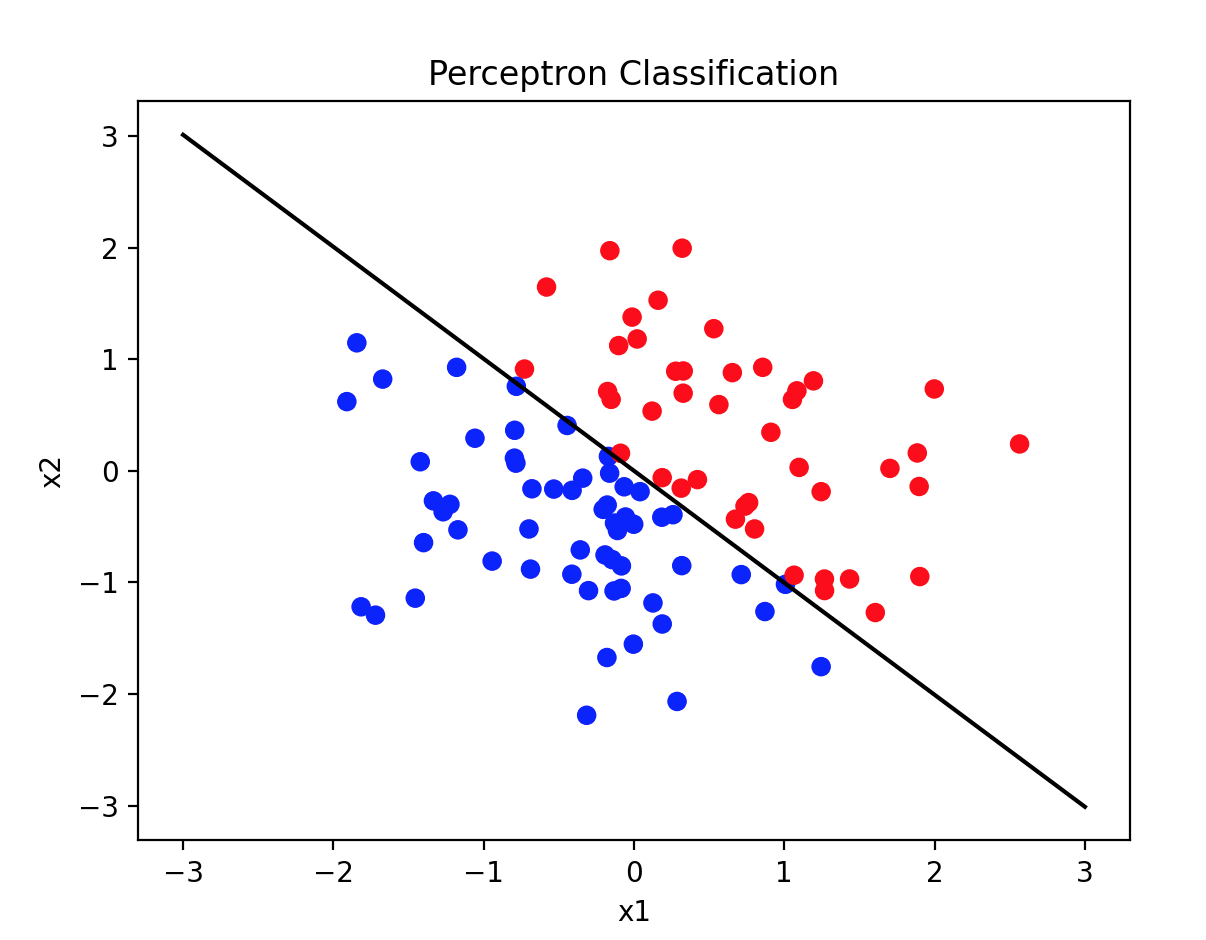

在神经网络中,"线性"和"非线性"这两个术语描述的是模型处理数据和关系的能力:

线性(Linear)

-

定义:线性模型指的是输出是输入的线性组合的模型。也就是说,如果你有两个变量,线性模型可以被表示为 y=mx+b 的形式,其中 m 是斜率,b 是截距。

-

特征:线性模型只能捕捉输入变量之间的直线关系,无论这些变量如何组合,输出总是输入的某种加权求和再加上一个偏置。

-

限制:线性模型无法捕捉变量之间的复杂关系,比如曲线关系或更复杂的非线性模式。

非线性(Non-linear)

-

定义:非线性模型是指输出不是输入的简单线性组合的模型。非线性模型可以捕捉输入变量之间的复杂关系。

-

特征:非线性模型能够学习和表示输入数据之间的复杂关系,比如多项式关系、指数关系或其他任何非直线的关系。

-

优势:非线性模型能够解决线性不可分的问题,即能够处理那些不能通过直线(或单一平面,对于更高维度)来分隔的数据点。

为什么需要非线性激活函数?

在神经网络中,如果每一层都是简单的线性变换,那么无论网络有多少层,最终的输出都只会是输入的线性组合。这是因为线性运算是可叠加的,即多个线性变换的组合仍然是线性变换。这就导致整个网络无法学习复杂的模式,只能解决线性可分的问题。非线性激活函数的作用是打破这种线性关系,使得每一层的输出都是前一层输出的非线性函数。这样,通过层叠多个非线性变换,神经网络就能够学习和表示非常复杂的函数映射,从而解决非线性问题。例如,一个简单的两层神经网络,如果使用ReLU激活函数,可以表示为:H=ReLU(W1X+b1) Y=W2H+b2其中,X 是输入,W1,W2 是权重矩阵,b1,b2 是偏置,H 是隐藏层的输出,Y 是最终输出。ReLU激活函数的引入使得隐藏层的输出成为输入的非线性函数,从而增加了网络的表达能力。总之,非线性激活函数是神经网络能够处理非线性问题的关键,它使得神经网络能够学习和表示复杂的数据模式。) -

-

-

加速训练:

-

ReLU函数的计算非常简单,这有助于加快网络的训练速度。相比于sigmoid或tanh等其他激活函数,ReLU的计算量更小。

-

-

缓解梯度消失问题:

-

在深度神经网络中,梯度消失问题是一个常见问题。ReLU函数在正区间内梯度恒定为1,这有助于缓解梯度消失问题,使得网络更容易训练。

-

-

稀疏激活:

-

由于ReLU函数会将负值截断为0,这导致网络中只有一部分神经元被激活。这种稀疏激活特性可能有助于提高模型的泛化能力。

-

-

生物学上的解释:

-

一些研究表明,ReLU函数与生物神经元的激活方式有一定的相似性,这为ReLU函数提供了生物学上的解释。

-

ReLU的缺点

尽管ReLU函数有很多优点,但它也有一些缺点:

-

死亡ReLU问题:

-

如果输入持续为负,ReLU的梯度将一直为0,导致这部分神经元“死亡”,即它们不再对任何输入有反应。

-

-

非零中心化输出:

-

由于ReLU在 x≤0 时输出为0,这导致其输出不是以0为中心的,这可能会影响梯度下降的效率。

-

尽管如此,ReLU仍然是深度学习中非常流行和有效的激活函数。为了解决ReLU的一些缺点,研究者提出了一些ReLU的变体,如Leaky ReLU、Parametric ReLU (PReLU)、Exponential Linear Unit (ELU)等。

![[AI/GPT/综述] AI Agent的设计模式综述](https://blog-static.cnblogs.com/files/johnnyzen/cnblogs-qq-group-qrcode.gif?t=1679679148)